- -> ķŚ«’╝ܵ£¼Õ£░ķā©ńĮ▓µłÉÕŖ¤õ║å’╝īõ╣¤ĶāĮķóäĶ¦łµĢłµ×£’╝īõĮåõĮ┐ńö© username.github.io Ķ«┐ķŚ«’╝ī`Õć║ńÄ░ 404 ` . -> ńŁö’╝Üķ”¢ÕģłńĪ«Ķ«ż hexo d ÕæĮõ╗żµē¦ĶĪīµś»ÕÉ”µŖźķöÖ’╝īÕ”éµ×£µ▓Īµ£ēµŖźķöÖ’╝īÕåŹµ¤źń£ŗõĖĆõĖŗõĮĀńÜä github ńÜä username.github.io õ╗ōÕ║ō’╝īõĮĀńÜäÕŹÜÕ«óµś»ÕÉ”ÕĘ▓ń╗ŵłÉÕŖ¤µÅÉõ║żõ║å’╝īõĮĀńÜä github ķé«ń«▒õ╣¤Ķ”üķĆÜĶ┐ćķ¬īĶ»üµēŹĶĪīŃĆé - -

- -ĶĮ¼ĶĮĮĶ»Ęµ│©µśÄÕĤգ░ÕØĆ’╝īµĮśµ¤Åõ┐ĪńÜäÕŹÜÕ«ó’╝Ü[http://leopardpan.github.io](http://leopardpan.github.io) Ķ░óĶ░ó’╝ü diff --git a/_posts/2016-06-12-HEXO_Advanced.md b/_posts/2016-06-12-HEXO_Advanced.md deleted file mode 100755 index 4cfd755714..0000000000 --- a/_posts/2016-06-12-HEXO_Advanced.md +++ /dev/null @@ -1,81 +0,0 @@ ---- -layout: post -title: HEXOĶ┐øķśČ -tag: hexo ---- - -HEXOµÄźĶ┐æµś»µ£ĆĶ┐æµ£ēõĖĆõ║øµ£ŗÕÅŗµÅÉÕć║ńÜäķŚ«ķóś’╝īńäČÕÉĵłæÕüÜõ║åµĆ╗ń╗ō’╝īÕ”éµ×£õĮĀõ╣¤Õ£©õĮ┐ńö©HEXO’╝īõĖŹÕ”©ń£ŗń£ŗ’╝īÕ║öĶ»źõ╝ܵ£ēõ║øÕĖ«ÕŖ®ŃĆé - -* 1ŃĆüÕŹÜÕ«óķā©ńĮ▓µĀĘÕ╝ÅÕć║ķŚ«ķóśõ║åµĆÄõ╣łÕŖ×’╝¤ -* 2ŃĆüńöĄĶäæķćŹĶŻģµł¢ĶĆģĶ»»ÕłĀõ║åµ£¼Õ£░ÕŹÜÕ«óµĆÄõ╣łÕŖ×’╝¤ -* 3ŃĆüµā│õĮ┐ńö©õĖżÕÅ░ńöĄĶäæÕåÖÕŹÜÕ«óµĆÄõ╣łÕŖ×’╝¤ -* 4ŃĆüõĖ║õĮĢõĮ┐ńö©ńÖŠÕ║”µÉ£õĖŹÕł░µłæńÜäÕŹÜÕ«ó’╝¤ - - -### õĮ┐ńö©JekyllĶ¦ŻÕå│ÕēŹõĖēõĖ¬ķŚ«ķóśŃĆé -õĖŹÕŠŚõĖŹĶ»┤ `Jekyll` ńĪ«Õ«×ÕÅ»õ╗źĶ¦ŻÕå│µłæõĖŖķØóõĖēõĖ¬ķŚ«ķóś, ÕøĀõĖ║ `Jekyll` µś»ńø┤µÄźµŖŖMarkdownµĀ╝Õ╝ÅńÜäµ¢ćń½Āńø┤µÄźµöŠÕ£©githubõ╗ōÕ║ōķćīńÜä, ńøĖÕĮōõ║Äńø┤µÄźńö©gitµØźń«ĪńÉåÕŹÜÕ«óõ║å, `Github` Õ«śµ¢╣õ╣¤ÕŠłµÄ©ĶŹÉ `Jekyll` ŃĆé õĮĀÕÅ»õ╗źÕģłń£ŗõĖŗ `Jekyll` µÉŁÕ╗║ÕŹÜÕ«óńÜä[voyagelab](voyagelab.github.io), [githubÕ£░ÕØĆ](https://github.com/voyagelab/voyagelab.github.io), ÕĮōńäČõ║åĶ┐ÖÕŬµś»ÕŠłµÖ«ķĆÜńÜä, Jekyll õ╣¤µ£ēÕŠłÕżÜõĖ╗ķóśÕÅ»õ╗źķĆēµŗ®ńÜä, µø┤Ķ»”ń╗åńÜäĶ»Ęń£ŗ[JekyllõĖŁµ¢ćµ¢ćµĪŻ](http://jekyll.bootcss.com/)ŃĆü[JekyllĶŗ▒µ¢ćµ¢ćµĪŻ](https://jekyllrb.com/)ŃĆü[JekyllõĖ╗ķóśÕłŚĶĪ©](http://jekyllthemes.org/)ŃĆé -Õ£© `Jekyll` õĖŖķĆøõ║åõĖĆõĖ¬µś¤µ£¤ńÜ䵳æÕÅłÕø×Õł░õ║å `Hexo` , ÕÅæńÄ░ ńø«ÕēŹ `Jekyll` Õ»╣õĖ╗ķóśÕÆīõĖĆõ║øµÅÆõ╗ČńÜäµö»µīüńøĖÕ»╣ `Hexo` µØźĶ»┤, µ▓ĪķéŻõ╣łÕÅŗÕźĮ, ÕÅ»ĶāĮµ£ēõĖĆõ║øÕģČÕ«āńÜäµ¢╣µ│ĢÕŬµś»µłæµ▓ĪµēŠÕł░ĶĆīÕĘ▓,Õģ│õ║Ä `Jekyll` µÉŁÕ╗║ÕŹÜÕ«óÕ░▒õ╗ŗń╗ŹÕł░Ķ┐Ö, Õ”éµ×£µ£ēķŚ«ķóśńÜäĶ»ØÕÅ»õ╗źĶ»äĶ«║, µł¢ĶĆģĶüöń│╗µłæŃĆé - -### õĮ┐ńö©HexoĶ¦ŻÕå│õĖŖķØóÕēŹõĖēõĖ¬ķŚ«ķóś -µś»ńÜä, µłæÕż¦`Hexo`ÕÉīµĀĘÕÅ»õ╗źĶ¦ŻÕå│õĖŖķØóõĖēõĖ¬ķŚ«ķóś, ķéŻÕ░▒µś»õĮ┐ńö©gitŃĆéÕģ│õ║ÄÕ”éõĮĢõĮ┐ńö© `Hexo` µÉŁÕ╗║ÕŹÜÕ«óĶ»Ęń£ŗµłæÕÅ”õĖĆń»ćµ¢ćń½Ā[HEXOµÉŁÕ╗║õĖ¬õ║║ÕŹÜÕ«ó](http://www.leopardpan.cn/2015/08/25/HEXO%E6%90%AD%E5%BB%BA%E4%B8%AA%E4%BA%BA%E5%8D%9A%E5%AE%A2/), Õ”éµ×£µÉŁÕ╗║ńÜäĶ┐ćń©ŗõĖŁÕć║ńÄ░õ║åķŚ«ķóś, µłæõ╗¼ÕÅ»õ╗źõ║żµĄüõ║żµĄüŃĆéńÄ░Õ£©µłæÕüćĶ«ŠõĮĀÕĘ▓ń╗ÅĶāĮÕ¤║µ£¼õĮ┐ńö© `Hexo` õ║å, µÄźõĖŗµØźÕ░▒ń£ŗń£ŗÕ”éõĮĢµØźń«ĪńÉåÕŹÜÕ«óŃĆé - -## õĮ┐ńö©gitń«ĪńÉåÕŹÜÕ«ó -[Blog-Growing](https://github.com/leopardpan/Blog-Growing)µś»µłæń«ĪńÉåÕŹÜÕ«óńÜäõ╗ōÕ║ōÕ£░ÕØĆŃĆéń╗ōµ×äÕż¦Ķć┤µś»: - -> -- Blog-Growing -> ŃĆĆŃĆĆ|-- .git -> ŃĆĆŃĆĆ|-- .gitignore -> ŃĆĆŃĆĆ|-- Hexo -> ŃĆĆŃĆĆŃĆĆŃĆĆ| .. -> ŃĆĆŃĆĆŃĆĆŃĆĆ| .. -> ŃĆĆŃĆĆŃĆĆŃĆĆ| µĢ┤õĖ¬ÕŹÜÕ«óńÜäķģŹńĮ«õ┐Īµü» - -õĮĀÕÅ»õ╗źµŖŖµłæńÜäńÜä[Blog-Growing](https://github.com/leopardpan/Blog-Growing) cloneõĖŗµØź, ń£ŗń£ŗõĖĆõ║øÕ¤║µ£¼ķģŹńĮ«µś»µĆÄõ╣łķģŹńĮ«ńÜäŃĆéķ£ĆĶ”üµÅÉķåÆńÜ䵜», `Ķ”üµŖŖõĖ╗ķóśõĖŗńÜä.gitń╗ÖÕłĀķÖżµÄē` , ÕĮōńäČõ║åõĮĀõ╣¤ÕÅ»õ╗źõĮ┐ńö© `git submodule` µØźń«ĪńÉå, ÕģĘõĮōńÜäń«ĪńÉåµ¢╣µ│ĢµłæĶ┐ÖķćīÕ░▒õĖŹÕüÜÕżÜńÜäõ╗ŗń╗Źõ║å, µā│õ║åĶ¦ŻńÜäĶ»ØÕÅ»õ╗źń¦üõ┐ĪµłæŃĆé -õĖŖķØóńÜäĶ┐ćń©ŗÕ¤║µ£¼ÕüÜÕ«īÕÉÄ, µĆÄõ╣łµØźĶ¦ŻÕå│µłæÕ╝Ćń»ćµÅÉńÜäÕēŹõĖēõĖ¬ķŚ«ķóśõ║åŃĆé - -### ÕģĘõĮōÕ«×ńÄ░: -**õĖĆ’╝ÜÕ«ČķćīńöĄĶäæõĮ┐ńö©ÕŹÜÕ«ó** -ŃĆĆŃĆĆÕ╗║ń½ŗgitĶ┐£ń½»õ╗ōÕ║ōń«ĪńÉåÕŹÜÕ«ó,Õ╣ČõĮ┐ńö©Õ«ČķćīńÜäńöĄĶäæµŖŖµ£¼Õ£░ÕŹÜÕ«óńÜäķģŹńĮ«µÄ©ķĆüÕł░Ķ┐£ń½»õ╗ōÕ║ōŃĆé -**õ║ī’╝ÜÕģ¼ÕÅĖńöĄĶäæõĮ┐ńö©ÕŹÜÕ«ó** -ŃĆĆŃĆĆÕł░õ║åÕģ¼ÕÅĖÕŬķ£ĆĶ”üµē¦ĶĪī`sudo npm install -g hexo`,ńäČÕÉÄcdÕł░õĮĀńÜäÕŹÜÕ«óńø«ÕĮĢõĖŗ,Õ”éµłæcd Õł░Hexońø«ÕĮĢõĖŗ, ńäČÕÉĵē¦ĶĪī `hexo server` Õ░▒ÕÅ»õ╗źÕ£©µ£¼Õ£░ķóäĶ¦łÕŹÜÕ«óõ║åŃĆé -**õĖē’╝ÜõĮ┐ńö©Gitõ┐ØÕŁś** -ŃĆĆŃĆĆõ┐«µö╣ÕźĮÕŹÜÕ«óÕÉÄĶ«░ÕŠŚÕģłõĮ┐ńö©gitµØźµÅÉõ║żõĖŗ, ÕŹ│õĮ┐õĖŗµ¼ĪµŖŖÕŹÜÕ«óńÜäµĀĘÕ╝Åõ┐«µö╣ÕØÅõ║å, õ╣¤ÕÅ»õ╗źõĮ┐ńö© `git reset --hard` µØźÕø×ķĆĆŃĆéÕ”é: µłæcd Õł░ `Blog-Growing` ńø«ÕĮĢõĖŗõĮ┐ńö©gitµÅÉõ║żŃĆé -**Õøø’╝ÜÕŹÜÕ«óµÅÉõ║ż** -ŃĆĆŃĆĆ1ŃĆüõ┐«µö╣ÕźĮńÜäÕŹÜÕ«óõĮ┐ńö© `hexo d` Õ▒Ģńż║Õł░ÕŹÜÕ«óķĪĄõĖŖŃĆé -ŃĆĆŃĆĆ2ŃĆügit push µĢ┤õĖ¬µ£¼Õ£░ÕŹÜÕ«óŃĆé - -**µÅÉńż║:** Õ£©Ķ┐Öķćī `git` õ╗ģõ╗ģÕŬµś»ńö©µłĘÕüÜÕŹÜÕ«óńÜäńēłµ£¼ń«ĪńÉåńÜä, ÕŹÜÕ«óńÜäµĀĘÕ╝Åõ┐«µö╣ŃĆüÕ¤║µ£¼ķā©ńĮ▓Ķ┐śµś»õĮ┐ńö© `hexo` µØźµōŹõĮ£ńÜäŃĆé - -## Ķ«®ńÖŠÕ║”ĶāĮµÉ£ń┤óÕł░õĮĀńÜäÕŹÜÕ«ó - -### õĖ║õ╗Ćõ╣łĶ”üõĮ┐ńö©ńÖŠÕ║”µÉ£ń┤ó’╝¤ - -ŃĆĆŃĆƵ£ēõ║║ÕÅ»ĶāĮõ╝ÜĶ»┤õĮ£õĖ║õĖĆõĖ¬Õ╝ĆÕÅæõ║║Õæś, õĮĀõĖŹõ╝Üńö© `Google` ÕĢŖŃĆé µś»ńÜä, Googleµś»ĶāĮµÉ£Õł░µłæõ╗¼µÉŁÕ╗║Õ£© `Github Page` ńÜäÕŹÜÕ«ó, õ╝Üńö©`Google` õ╣¤µś»õĖĆõĖ¬Õ╝ĆÕÅæõ║║ÕæśÕ┐ģÕżćµŖĆĶāĮõ╣ŗõĖĆŃĆéõĮåµś», µłæõ╗¼ńö¤µ┤╗Õ£©Õż®µ£Ø, µēĆõ╗źńÖŠÕ║”Ķ┐śµś»µĆ╗µ£ēõ╝Üńö©Õł░ńÜ䵌ČÕĆÖ, µł¢ĶĆģµś»õĮĀµā│Ķ«®µø┤ÕżÜńÜäÕż®µ£Øõ║║ĶāĮµÉ£Õł░õĮĀŃĆé - -### õĖ║õ╗Ćõ╣łõĮ┐ńö©ńÖŠÕ║”µÉ£ń┤óõĖŹÕł░ Github Page õĖŖńÜäÕŹÜÕ«ó’╝¤ - -µ£ēõ║║Ķüöń│╗Ķ┐ć Github Support ķā©ķŚ© , ń╗ÖÕć║Õż¦Ķć┤ńÜäµäŵĆØÕ░▒µś»: ńÖŠÕ║”ńł¼ĶÖ½ńł¼ÕŠŚÕż¬ńīøńāł’╝īÕĘ▓ń╗ÅÕ»╣ÕŠłÕżÜ Github ńö©µłĘķĆĀµłÉõ║åķŚ«ķóśŃĆéµēĆõ╗ź Github Õ░åń”üµŁóńÖŠÕ║”ńł¼ĶÖ½ńÜäńł¼ÕÅ¢ŃĆé - -### Õ”éõĮĢĶ«®ńÖŠÕ║”ĶāĮµÉ£ń┤óõĮĀńÜäÕŹÜÕ«ó? - -ŃĆĆŃĆƵĀ╣µŹ«õĖŖķØóĶ»┤ńÜä, ńø«ÕēŹÕÅæńÄ░ÕŬµś»Github Pageń”üµŁóõ║åńÖŠÕ║”µÉ£ń┤ó, µēĆõ╗źĶ«®ńÖŠÕ║”ĶāĮµÉ£ń┤óÕł░õĮĀńÜäÕŹÜÕ«óĶ┐śµś»µ£ēõĖĆõ║øµ¢╣µ│ĢńÜäŃĆéõŠŗÕ”é: -* Ķć¬ÕĘ▒µÉ×õĖ¬VPS,ÕŹÜÕ«óķā©ńĮ▓Õ£©VPSõĖŖŃĆé -* ÕŹÜÕ«óķā©ńĮ▓ `Coding.net` õĖŖ, `GitCafe`ÕĘ▓ń╗ÅÕÉłÕ╣ČÕł░ `Coding` ŃĆé -µłæõĮ┐ńö©ńÜ䵜»ń¼¼õ║īń¦Źµ¢╣µ│Ģ, ÕŹÜÕ«óķā©ńĮ▓Õ£© `Coding.net` õĖŖõ╣¤ńøĖÕ»╣ń«ĆÕŹĢõ║øŃĆé - -#### Õ£©CodingõĖŖķā©ńĮ▓õĮĀńÜäÕŹÜÕ«óŃĆé - -ŃĆĆŃĆĆCodingÕÉīµĀʵö»µīüHexoŃĆüJekyllńŁēÕŹÜÕ«óńÜäķā©ńĮ▓, Coding ĶʤGithubĶ┐śµś»µī║ÕāÅńÜä,ĶĆīõĖöµś»õĖŁµ¢ćŃĆé ÕÉīµĀĘńÜäÕ£©CodingķćīķØóÕ╗║õĖĆõĖ¬ķĪ╣ńø«,ķĪ╣ńø«ÕÉŹÕŁŚĶʤõĮĀńÜäńö©µłĘÕÉŹõĖƵĀĘ,Ķ┐ÖķćīµłæÕ░▒õĖŹÕĢ░ÕŚ”õ║å, Ķ»┤ÕćĀõĖ¬ķ£ĆĶ”üµ│©µäÅńÜäÕ£░µ¢╣: -**µ│©µäÅõĖĆ:** -ŃĆĆŃĆĆÕ£©`Coding Page` õĖŖķā©ńĮ▓ÕŹÜÕ«ó,ķ£ĆĶ”üµŖŖÕŹÜÕ«óµÄ©ķĆüÕł░`coding-pages ` Õłåµö»õĖŖ, Õłåµö»ÕÉŹÕŁŚµś»Õø║Õ«ÜńÜäŃĆé -**µ│©µäÅõ║ī:** -ŃĆĆŃĆĆ`Coding Page` õĖŹµö»µīüĶć¬Õ«Üõ╣ēCNAME, õĮĀķ£ĆĶ”üńé╣Õć╗Õł░Pageµ©ĪÕØŚ,ńäČÕÉĵĘ╗ÕŖĀõĖĆõĖ¬Õ¤¤ÕÉŹµØźń╗æÕ«ÜŃĆé - -µø┤Ķ»”ń╗åńÜäĶ»Ęń£ŗ[Coding Pages Õ«śńĮæõ╗ŗń╗Ź](https://coding.net/help/doc/pages/index.html). - -ÕÅéĶĆāµ¢ćń½Ā: -[Ķ¦ŻÕå│ Github Pages ń”üµŁóńÖŠÕ║”ńł¼ĶÖ½ńÜäµ¢╣µ│ĢõĖÄÕÅ»ĶĪīµĆ¦Õłåµ×É](http://jerryzou.com/posts/feasibility-of-allowing-baiduSpider-for-Github-Pages/) - -

- -ĶĮ¼ĶĮĮĶ»Ęµ│©µśÄ’╝Ü[µĮśµ¤Åõ┐ĪńÜäÕŹÜÕ«ó](http://leopardpan.cn) ┬╗ [ńé╣Õć╗ķśģĶ»╗ÕĤµ¢ć](http://leopardpan.cn/2016/06/HEXO_Advanced/) \ No newline at end of file diff --git a/_posts/2016-10-14-jekyll_tutorials1.md b/_posts/2016-10-14-jekyll_tutorials1.md deleted file mode 100755 index aa913b1545..0000000000 --- a/_posts/2016-10-14-jekyll_tutorials1.md +++ /dev/null @@ -1,291 +0,0 @@ ---- -layout: post -title: JekyllµÉŁÕ╗║õĖ¬õ║║ÕŹÜÕ«ó -date: 2016-10-14 -tags: jekyll ---- - -ŃĆĆõ╣ŗÕēŹÕåÖõ║åõĖĆń»ć[HEXOµÉŁÕ╗║õĖ¬õ║║ÕŹÜÕ«ó](http://leopardpan.cn/2015/08/HEXO%E6%90%AD%E5%BB%BA%E4%B8%AA%E4%BA%BA%E5%8D%9A%E5%AE%A2/)ńÜäµĢÖń©ŗĶÄĘÕŠŚõ║åÕŠłÕźĮĶ»ä’╝īÕ░żÕģȵś»Õ£©[ń«Ćõ╣”](http://www.jianshu.com/p/465830080ea9)õĖŖńø«ÕēŹÕĘ▓ń╗Åń┤»ń¦»õ║å10W+ńÜäķśģĶ»╗ķćÅõ║å’╝īõ╣¤µ£ēÕźĮÕ┐āńÜäĶ»╗ĶĆģõĖ╗ÕŖ©ń╗ÖµłæµēōĶĄÅ’╝īÕ£©µŁżµä¤Ķ░óŃĆé - -ŃĆĆÕ”éµ×£õĮĀń£ŗĶ┐浳æńÜäµ¢ćń½Āõ╝ÜÕÅæńÄ░µłæńÄ░Õ£©ńÜäÕŹÜÕ«óµĀĘÕ╝ÅĶʤõ╣ŗÕēŹµś»µ£ēÕŠłÕż¦ńÜäÕī║Õł½ńÜä’╝īõ╣ŗÕēŹµłæõ╣¤µś»õĮ┐ńö© HEXO µÉŁÕ╗║ńÜäÕŹÜÕ«ó’╝īÕÉÄµØźÕÅæńÄ░õĮ┐ńö© HEXO Õ£©ÕżÜÕÅ░ńöĄĶäæõĖŖÕÅæÕĖāÕŹÜÕ«ó’╝īµōŹõĮ£ĶĄĘµØźÕ╣ČõĖŹµś»ķéŻõ╣łµ¢╣õŠ┐’╝īµ×£µ¢ŁÕ░▒ĶĮ¼Õł░õ║å Jekyll õĖŖ’╝īµÄźõĖŗµØźµłæõ╝ÜĶ«▓Õ”éõĮĢõĮ┐ńö© Jekyll µÉŁÕ╗║ÕŹÜÕ«ó’╝ī[ÕŹÜÕ«óµ©ĪµØ┐µĢłµ×£](http://leopardpan.cn/#blog)ŃĆé - - -### õ╗ŗń╗Ź - - ŃĆĆJekyll µś»õĖĆõĖ¬ń«ĆÕŹĢńÜäÕŹÜÕ«óÕĮóµĆüńÜäķØÖµĆüń½Öńé╣ńö¤õ║¦µ£║ÕÖ©ŃĆéÕ«āµ£ēõĖĆõĖ¬µ©Īńēłńø«ÕĮĢ’╝īÕģČõĖŁÕīģÕɽÕĤզŗµ¢ćµ£¼µĀ╝Õ╝ÅńÜäµ¢ćµĪŻ’╝īķĆÜĶ┐ć Markdown ’╝łµł¢ĶĆģ Textile’╝ē õ╗źÕÅŖ Liquid ĶĮ¼Õī¢µłÉõĖĆõĖ¬Õ«īµĢ┤ńÜäÕÅ»ÕÅæÕĖāńÜäķØÖµĆüńĮæń½Ö’╝īõĮĀÕÅ»õ╗źÕÅæÕĖāÕ£©õ╗╗õĮĢõĮĀÕ¢£ńł▒ńÜäµ£ŹÕŖĪÕÖ©õĖŖŃĆéJekyll õ╣¤ÕÅ»õ╗źĶ┐ÉĶĪīÕ£© GitHub Page õĖŖ’╝īõ╣¤Õ░▒µś»Ķ»┤’╝īõĮĀÕÅ»õ╗źõĮ┐ńö© GitHub ńÜäµ£ŹÕŖĪµØźµÉŁÕ╗║õĮĀńÜäķĪ╣ńø«ķĪĄķØóŃĆüÕŹÜÕ«óµł¢ĶĆģńĮæń½Ö’╝īĶĆīõĖöµś»Õ«īÕģ©ÕģŹĶ┤╣ńÜä - -ŃĆĆõĮ┐ńö© Jekyll µÉŁÕ╗║ÕŹÜÕ«óõ╣ŗÕēŹĶ”üńĪ«Ķ«żõĖŗµ£¼µ£║ńÄ»Õóā’╝īGit ńÄ»Õóā’╝łńö©õ║Äķā©ńĮ▓Õł░Ķ┐£ń½»’╝ēŃĆü[Ruby](http://www.ruby-lang.org/en/downloads/) ńÄ»Õóā’╝łJekyll µś»Õ¤║õ║Ä Ruby Õ╝ĆÕÅæńÜä’╝ēŃĆüÕīģń«ĪńÉåÕÖ© [RubyGems](http://rubygems.org/pages/download) -ŃĆĆŃĆĆÕ”éµ×£õĮĀµś» Mac ńö©µłĘ’╝īõĮĀÕ░▒ķ£ĆĶ”üÕ«ēĶŻģ Xcode ÕÆī Command-Line Toolsõ║åŃĆéõĖŗĶĮĮµ¢╣Õ╝Å Preferences ŌåÆ Downloads ŌåÆ ComponentsŃĆé - -ŃĆĆŃĆĆJekyll µś»õĖĆõĖ¬ÕģŹĶ┤╣ńÜäń«ĆÕŹĢķØÖµĆüńĮæķĪĄńö¤µłÉÕĘźÕģĘ’╝īÕÅ»õ╗źķģŹÕÉłń¼¼õĖēµ¢╣µ£ŹÕŖĪõŠŗÕ”é’╝Ü Disqus’╝łĶ»äĶ«║’╝ēŃĆüÕżÜĶ»┤(Ķ»äĶ«║) õ╗źÕÅŖÕłåõ║½ ńŁēńŁēµē®Õ▒ĢÕŖ¤ĶāĮ’╝īJekyll ÕÅ»õ╗źńø┤µÄźķā©ńĮ▓Õ£© Github’╝łÕøĮÕż¢’╝ē µł¢ Coding’╝łÕøĮÕåģ’╝ē õĖŖ’╝īÕÅ»õ╗źń╗æÕ«ÜĶć¬ÕĘ▒ńÜäÕ¤¤ÕÉŹŃĆé[JekyllõĖŁµ¢ćµ¢ćµĪŻ](http://jekyll.bootcss.com/)ŃĆü[JekyllĶŗ▒µ¢ćµ¢ćµĪŻ](https://jekyllrb.com/)ŃĆü[JekyllõĖ╗ķóśÕłŚĶĪ©](http://jekyllthemes.org/)ŃĆé - - -### Jekyll ńÄ»ÕóāķģŹńĮ« - -Õ«ēĶŻģ jekyll - -``` -$ gem install jekyll -``` - -ÕłøÕ╗║ÕŹÜÕ«ó - -``` -$ jekyll new myBlog -``` - -Ķ┐øÕģźÕŹÜÕ«óńø«ÕĮĢ - -``` -$ cd myBlog -``` - -ÕÉ»ÕŖ©µ£¼Õ£░µ£ŹÕŖĪ - -``` -$ jekyll serve -``` - -Õ£©µĄÅĶ¦łÕÖ©ķćīĶŠōÕģź’╝Ü [http://localhost:4000](http://localhost:4000)’╝īÕ░▒ÕÅ»õ╗źń£ŗÕł░õĮĀńÜäÕŹÜÕ«óµĢłµ×£õ║åŃĆé - - - -so easy ! - -### ńø«ÕĮĢń╗ōµ×ä -ŃĆĆ -ŃĆĆJekyll ńÜäµĀĖÕ┐āÕģČÕ«×µś»õĖĆõĖ¬µ¢ćµ£¼ĶĮ¼µŹóÕ╝ĢµōÄŃĆéÕ«āńÜäµ”éÕ┐ĄÕģČÕ«×Õ░▒µś»’╝Ü õĮĀńö©õĮĀµ£ĆÕ¢£µ¼óńÜäµĀćĶ«░Ķ»ŁĶ©ĆµØźÕåÖµ¢ćń½Ā’╝īÕÅ»õ╗źµś» Markdown’╝īõ╣¤ÕÅ»õ╗źµś» Textile,µł¢ĶĆģÕ░▒µś»ń«ĆÕŹĢńÜä HTML, ńäČÕÉÄ Jekyll Õ░▒õ╝ÜÕĖ«õĮĀÕźŚÕģźõĖĆõĖ¬µł¢õĖĆń│╗ÕłŚńÜäÕĖāÕ▒ĆõĖŁŃĆéÕ£©µĢ┤õĖ¬Ķ┐ćń©ŗõĖŁõĮĀÕÅ»õ╗źĶ«ŠńĮ«URLĶĘ»ÕŠä, õĮĀńÜäµ¢ćµ£¼Õ£©ÕĖāÕ▒ĆõĖŁńÜ䵜Šńż║µĀĘÕ╝ÅńŁēńŁēŃĆéĶ┐Öõ║øķāĮÕÅ»õ╗źķĆÜĶ┐ćń║»µ¢ćµ£¼ń╝¢ĶŠæµØźÕ«×ńÄ░’╝īµ£Ćń╗łńö¤µłÉńÜäķØÖµĆüķĪĄķØóÕ░▒µś»õĮĀńÜ䵳ÉÕōüõ║åŃĆé - - õĖĆõĖ¬Õ¤║µ£¼ńÜä Jekyll ńĮæń½ÖńÜäńø«ÕĮĢń╗ōµ×äõĖĆĶł¼µś»ÕāÅĶ┐ÖµĀĘńÜä’╝Ü - -``` -. -Ōö£ŌöĆŌöĆ _config.yml -Ōö£ŌöĆŌöĆ _includes -| Ōö£ŌöĆŌöĆ footer.html -| ŌööŌöĆŌöĆ header.html -Ōö£ŌöĆŌöĆ _layouts -| Ōö£ŌöĆŌöĆ default.html -| Ōö£ŌöĆŌöĆ post.html -| ŌööŌöĆŌöĆ page.html -Ōö£ŌöĆŌöĆ _posts -| ŌööŌöĆŌöĆ 2016-10-08-welcome-to-jekyll.markdown -Ōö£ŌöĆŌöĆ _sass -| Ōö£ŌöĆŌöĆ _base.scss -| Ōö£ŌöĆŌöĆ _layout.scss -| ŌööŌöĆŌöĆ _syntax-highlighting.scss -Ōö£ŌöĆŌöĆ about.md -Ōö£ŌöĆŌöĆ css -| ŌööŌöĆŌöĆ main.scss -Ōö£ŌöĆŌöĆ feed.xml -ŌööŌöĆŌöĆ index.html - -``` - -Ķ┐Öõ║øńø«ÕĮĢń╗ōµ×äõ╗źÕÅŖÕģĘõĮōńÜäõĮ£ńö©ÕÅ»õ╗źÕÅéĶĆā [Õ«śńĮæµ¢ćµĪŻ](http://jekyll.com.cn/docs/structure/) - -Ķ┐øÕģź _config.yml ķćīķØó’╝īõ┐«µö╣µłÉõĮĀµā│ń£ŗÕł░ńÜäõ┐Īµü»’╝īķ揵¢░ jekyll server ’╝īÕłĘµ¢░µĄÅĶ¦łÕÖ©Õ░▒ÕÅ»õ╗źń£ŗÕł░õĮĀÕłÜÕłÜõ┐«µö╣ńÜäõ┐Īµü»õ║åŃĆé - -Õł░µŁż’╝īÕŹÜÕ«óÕłØµŁźµÉŁÕ╗║ń«Śµś»Õ«īµłÉõ║å’╝ī - -### ÕŹÜÕ«óķā©ńĮ▓Õł░Ķ┐£ń½» - -ŃĆƵłæĶ┐ÖķćīĶ«▓ńÜ䵜»ķā©ńĮ▓Õł░ Github Page ÕłøÕ╗║õĖĆõĖ¬ github Ķ┤”ÕÅĘ’╝īńäČÕÉÄÕłøÕ╗║õĖĆõĖ¬ĶʤõĮĀĶ┤”µłĘÕÉŹõĖƵĀĘńÜäõ╗ōÕ║ō’╝īÕ”éµłæńÜä github Ķ┤”µłĘÕÉŹÕŽ [leopardpan](https://github.com/leopardpan)’╝īµłæńÜä github õ╗ōÕ║ōÕÉŹÕ░▒ÕŽ [leopardpan.github.io](https://github.com/leopardpan/leopardpan.github.io)’╝īÕłøÕ╗║ÕźĮõ║åõ╣ŗÕÉÄ’╝īµŖŖÕłÜµēŹÕ╗║ń½ŗńÜä myBlog ķĪ╣ńø« push Õł░ username.github.ioõ╗ōÕ║ōķćīÕÄ╗’╝łusernameµīćńÜ䵜»õĮĀńÜägithubńö©µłĘÕÉŹ’╝ē’╝īµŻĆµ¤źõĮĀĶ┐£ń½»õ╗ōÕ║ōÕĘ▓ń╗ÅĶʤõĮĀµ£¼Õ£░ myBlog ÕÉīµŁźõ║å’╝īńäČÕÉÄõĮĀÕ£©µĄÅĶ¦łÕÖ©ķćīĶŠōÕģź username.github.io ’╝īÕ░▒ÕÅ»õ╗źĶ«┐ķŚ«õĮĀńÜäÕŹÜÕ«óõ║åŃĆé - - -### ń╝¢ÕåÖµ¢ćń½Ā - -ŃĆĆŃĆƵēƵ£ēńÜäµ¢ćń½ĀķāĮµś» _posts ńø«ÕĮĢõĖŗķØó’╝īµ¢ćń½ĀµĀ╝Õ╝ÅõĖ║ mardown µĀ╝Õ╝Å’╝īµ¢ćń½Āµ¢ćõ╗ČÕÉŹÕÅ»õ╗źµś» .mardown µł¢ĶĆģ .mdŃĆé - -ŃĆĆŃĆĆń╝¢ÕåÖõĖĆń»ćµ¢░µ¢ćń½ĀÕŠłń«ĆÕŹĢ’╝īõĮĀÕÅ»õ╗źńø┤µÄźõ╗Ä _posts/ ńø«ÕĮĢõĖŗÕżŹÕłČõĖĆõ╗ĮÕć║µØź `2016-10-16-welcome-to-jekyllÕē»µ£¼.markdown` ’╝īõ┐«µö╣ÕÉŹÕŁŚõĖ║ 2016-10-16-article1.markdown ’╝īµ│©µäÅ’╝ܵ¢ćń½ĀÕÉŹńÜäµĀ╝Õ╝ÅÕēŹķØóÕ┐ģķĪ╗õĖ║ 2016-10-16- ’╝īµŚźµ£¤ÕÅ»õ╗źõ┐«µö╣’╝īõĮåÕ┐ģķĪ╗õĖ║ Õ╣┤-µ£ł-µŚź- µĀ╝Õ╝Å’╝īÕÉÄķØóńÜä article1 µś»µĢ┤õĖ¬µ¢ćń½ĀńÜäĶ┐׵ğ URL’╝īÕ”éµ×£µ¢ćń½ĀÕÉŹõĖ║õĖŁµ¢ć’╝īķéŻõ╣łµ¢ćń½ĀńÜäĶ┐׵ğURLÕ░▒õ╝ÜÕÅśµłÉĶ┐ÖµĀĘńÜä’╝Ühttp://leopardpan.cn/2015/08/%E6%90%AD%E5/ ’╝ī µēĆõ╗źÕ╗║Ķ««µ¢ćń½ĀÕÉŹµ£ĆÕźĮµś»Ķŗ▒µ¢ćńÜ䵳¢ĶĆģķś┐µŗēõ╝»µĢ░ÕŁŚŃĆé ÕÅīÕć╗ 2016-10-16-article1.markdown µēōÕ╝Ć - -``` - ---- -layout: post -title: "Welcome to Jekyll!" -date: 2016-10-16 11:29:08 +0800 -categories: jekyll update ---- - -µŁŻµ¢ć... - -``` - - -title: µśŠńż║ńÜäµ¢ćń½ĀÕÉŹ’╝ī Õ”é’╝Ütitle: µłæńÜäń¼¼õĖĆń»ćµ¢ćń½Ā -date: µśŠńż║ńÜäµ¢ćń½ĀÕÅæÕĖāµŚźµ£¤’╝īÕ”é’╝Üdate: 2016-10-16 -categories: tagµĀćńŁŠńÜäÕłåń▒╗’╝īÕ”é’╝Ücategories: ķÜÅń¼ö - -µ│©µäÅ’╝ܵ¢ćń½ĀÕż┤ķā©µĀ╝Õ╝ÅÕ┐ģķĪ╗õĖ║õĖŖķØóńÜä’╝ī.... Õ░▒µś»µ¢ćń½ĀńÜ䵣Żµ¢ćÕåģÕ«╣ŃĆé - -µłæÕåÖµ¢ćń½ĀõĮ┐ńö©ńÜ䵜» Sublime Text2 ń╝¢ĶŠæÕÖ©’╝īÕ”éµ×£õĮĀÕ»╣ markdown Ķ»Łµ│ĢõĖŹń夵éēńÜäĶ»Ø’╝īÕÅ»õ╗źń£ŗń£ŗ[õĮ£õĖÜķā©ĶÉĮńÜäµĢÖń©ŗ](https://www.zybuluo.com/) - - -### õĮ┐ńö©µłæńÜäÕŹÜÕ«óµ©ĪµØ┐ - -ĶÖĮńäČÕŹÜÕ«óķā©ńĮ▓Õ«īµłÉõ║å’╝īõĮĀõ╝ÜÕÅæńÄ░ÕŹÜÕ«óÕż¬ń«ĆÕŹĢõĖŹµś»õĮĀµā│Ķ”üńÜä’╝īÕ”éµ×£õĮĀÕ¢£µ¼óµłæńÜ䵩ĪµØ┐ńÜäĶ»Ø’╝īÕÅ»õ╗źõĮ┐ńö©µłæńÜ䵩ĪµØ┐ŃĆé - -ķ”¢ÕģłõĮĀĶ”üĶÄĘÕÅ¢ńÜ䵳æÕŹÜÕ«ó’╝ī[GithubķĪ╣ńø«Õ£░ÕØĆ](https://github.com/leopardpan/leopardpan.github.io.git)’╝īõĮĀÕÅ»õ╗źńø┤µÄź[ńé╣Õć╗õĖŗĶĮĮÕŹÜÕ«ó](https://github.com/leopardpan/leopardpan.github.io/archive/master.zip)’╝īĶ┐øÕÄ╗leopardpan.github.io/ ńø«ÕĮĢõĖŗ’╝ī õĮ┐ńö©ÕæĮõ╗żķā©ńĮ▓µ£¼Õ£░µ£ŹÕŖĪ - -``` -$ jekyll server -``` - -### Õ”éµ×£õĮĀµ£¼µ£║µ▓ĪķģŹńĮ«Ķ┐ćõ╗╗õĮĢjekyllńÜäńÄ»Õóā’╝īÕÅ»ĶāĮõ╝ܵŖźķöÖ - -``` -/Users/xxxxxxxx/.rvm/rubies/ruby-2.2.2/lib/ruby/site_ruby/2.2.0/rubygems/core_ext/kernel_require.rb:54:in `require': cannot load such file -- bundler (LoadError) - from /Users/xxxxxxxx/.rvm/rubies/ruby-2.2.2/lib/ruby/site_ruby/2.2.0/rubygems/core_ext/kernel_require.rb:54:in `require' - from /Users/xxxxxxxx/.rvm/gems/ruby-2.2.2/gems/jekyll-3.3.0/lib/jekyll/plugin_manager.rb:34:in `require_from_bundler' - from /Users/xxxxxxxx/.rvm/gems/ruby-2.2.2/gems/jekyll-3.3.0/exe/jekyll:9:in `

+ Õ£©_layouts/post.htmlõĖŁ’╝īÕ£©headµĀćńŁŠõĖŁÕŖĀÕģźõ╗źõĖŗõ╗ŻńĀü’╝Ü + +``` + + + + + + + +``` + +ńäČÕÉÄÕ£©_config.ymlõĖŁÕŖĀÕģźõ╗źõĖŗõ╗ŻńĀü’╝Ü + +``` +markdown: kramdown +kramdown: + math_engine: mathjax + syntax_highlighter: rouge + input: GFM + hard_wrap: false + syntax_highlighter_opts: + disable: true +``` + + + + +#### ÕåÖÕ«īõ╣ŗÕÉÄÕ”éõĮĢÕÅæÕĖā + +ÕåÖÕ«īµēƵ£ēõ╗ŻńĀüÕ╣ČõĖöÕ£©µ£¼Õ£░µ¤źń£ŗõ║åµĢłµ×£õ╣ŗÕÉÄ’╝īÕ░▒ÕÅ»õ╗źµŖŖµ£¼Õ£░ķĪ╣ńø«µēĆÕüÜńÜäµø┤µö╣pushÕł░githubõĖŖõ║åŃĆéÕ£©µ£¼Õ£░ķĪ╣ńø«ńÜäµĀ╣ńø«ÕĮĢõĖŗ’╝īµēōÕ╝Ćgit bash’╝īĶŠōÕģźõ╗źõĖŗÕæĮõ╗ż’╝Ü + +``` +git add . +git commit -m "µÅÉõ║żõ┐Īµü»" +git push -u origin master + +``` + + +### ÕŠģĶ¦ŻÕå│ÕŖ¤ĶāĮ + +1. Ķ»äĶ«║ÕŖ¤ĶāĮ’╝īµłæõ╣ŗÕēŹµīēńģ¦µĢÖń©ŗÕÄ╗Õ╝ä’╝īõĮåµś»ÕźĮÕāŵś»õĖ¬ķ¤®ÕøĮńÜäńĮæń½Ö’╝īÕ«āń╗ÖµłæÕÅæõ║åµ│©Õåīõ┐Īµü»’╝īõĮåµś»ķāĮĶó½µłæķé«ń«▒Õ×āÕ£ŠµĪČńģ¦ÕŹĢÕģ©µöČõ║åŃĆéõĖżõĖ¬µ£łõ╣ŗÕÉÄ’╝īµłæµēŹÕ£©Õ×āÕ£Šń«▒ķćīķØóµēŠÕł░’╝īõĮåµś»ķéŻõĖ¬µŚČÕĆÖµłæÕĘ▓ń╗ÅõĖŹń¤źķüōµĆÄõ╣łµÉ×õ║å’╝īń£¤ńÜ䵜»ŌĆ£Õć║ÕĖłµ£¬µŹĘĶ║½ÕģłµŁ╗ŃĆéŌĆØ + +### ÕÅéĶĆāĶ┐׵ğ + +1. [JekyllµÉŁÕ╗║õĖ¬õ║║ÕŹÜÕ«ó](http://leopardpan.github.io/2016/10/jekyll_tutorials1/) (õĮåµś»Ķ┐ÖõĖ¬Õż¦õĮ¼ÕźĮÕāÅõ╗źÕÅŖõĖŹµø┤µ¢░õ║å) +2. [ńö© Hugo ķ揵¢░µÉŁÕ╗║ÕŹÜÕ«ó](https://zhajiman.github.io/post/rebuild_blog/) +3. \ No newline at end of file diff --git "a/_posts/2022-12-14-\346\234\272\345\231\250\345\255\246\344\271\240\345\205\245\351\227\2501_\347\272\277\346\200\247\344\273\243\346\225\260.md" "b/_posts/2022-12-14-\346\234\272\345\231\250\345\255\246\344\271\240\345\205\245\351\227\2501_\347\272\277\346\200\247\344\273\243\346\225\260.md" new file mode 100644 index 0000000000..b5707e22fd --- /dev/null +++ "b/_posts/2022-12-14-\346\234\272\345\231\250\345\255\246\344\271\240\345\205\245\351\227\2501_\347\272\277\346\200\247\344\273\243\346\225\260.md" @@ -0,0 +1,491 @@ +--- +layout: post +title: "µ£║ÕÖ©ÕŁ”õ╣ĀÕģźķŚ©1_ń║┐µĆ¦õ╗ŻµĢ░" +date: 2022-12-14 +description: "õ╗ŗń╗Źµ£║ÕÖ©ÕŁ”õ╣ĀÕģźķŚ©ķ£ĆĶ”üńÜäń║┐µĆ¦õ╗ŻµĢ░ń¤źĶ»å’╝īÕ”éń¤®ķśĄĶĮ¼ńĮ«ŃĆüĶīāµĢ░ńŁēńŁē" +tag: µ£║ÕÖ©ÕŁ”õ╣Ā +--- + +# 00 ÕåÖÕ£©ÕēŹķØó +Õ”éõĮĢÕ░åipynbµ¢ćõ╗ČĶĮ¼õĖ║markdownµ¢ćõ╗Č’╝¤ +```shell +jupyter nbconvert --to markdown note.ipynb +``` + +# chapter 01 + + +```python +import numpy as np +# ÕÉæķćÅ +v = np.array([1,2,3]) +# ń¤®ķśĄ +m = np.array([[1,2,3],[4,5,6],[7,8,9]]) +# Õ╝ĀķćÅ +t = np.array([ + [[1,2,3],[4,5,6],[7,8,9]], + [[11,12,13],[14,15,16],[17,18,19]], + [[21,22,23],[24,25,26],[27,28,29]], +]) +print("ÕÉæķćÅ’╝Ü"+str(v)) +print("ń¤®ķśĄ’╝Ü"+str(m)) +print("Õ╝ĀķćÅ’╝Ü"+str(t)) +``` + + ÕÉæķćÅ’╝Ü[1 2 3] + ń¤®ķśĄ’╝Ü[[1 2 3] + [4 5 6] + [7 8 9]] + Õ╝ĀķćÅ’╝Ü[[[ 1 2 3] + [ 4 5 6] + [ 7 8 9]] + + [[11 12 13] + [14 15 16] + [17 18 19]] + + [[21 22 23] + [24 25 26] + [27 28 29]]] + + +## 1.2 ń¤®ķśĄĶĮ¼ńĮ« + + + +```python +a = np.array([[1,2,3],[4,5,6],[7,8,9],[10,11,12]]) +a_t = a.transpose() +print(a) +# print one line to separate the two outputs +print('-'*30) +print(a_t) +``` + + [[ 1 2 3] + [ 4 5 6] + [ 7 8 9] + [10 11 12]] + ------------------------------ + [[ 1 4 7 10] + [ 2 5 8 11] + [ 3 6 9 12]] + + +## 1.3 ń¤®ķśĄÕŖĀµ│Ģ +µ£ēµŚČÕĆÖÕģüĶ«Ėń¤®ķśĄÕÆīÕÉæķćÅńøĖÕŖĀ’╝īÕŠŚÕł░õĖĆõĖ¬ń¤®ķśĄ’╝īµ£¼Ķ┤©õĖŖµś»µ×äķĆĀõ║åõĖĆõĖ¬Õ░åbµīēĶĪīÕżŹÕłČńÜäõĖĆõĖ¬µ¢░ń¤®ķśĄ’╝īĶ┐Öń¦ŹµōŹõĮ£ÕŽÕüÜÕ╣┐µÆŁ’╝łbroadcasting’╝ēŃĆé + + +## 1.4 ń¤®ķśĄõ╣śµ│Ģ +ń¤®ķśĄõ╣śµ│ĢńÜäń╗ōµ×£µś»õĖĆõĖ¬ń¤®ķśĄ’╝īÕģČń¼¼iĶĪīń¼¼jÕłŚńÜäÕģāń┤Āµś»ń¤®ķśĄAńÜäń¼¼iĶĪīõĖÄń¤®ķśĄBńÜäń¼¼jÕłŚńÜäÕåģń¦»ŃĆéAńÜäÕĮóńŖČõĖ║m├Śn’╝īBńÜäÕĮóńŖČõĖ║n├Śp’╝īķéŻõ╣łA├ŚBńÜäÕĮóńŖČõĖ║m├ŚpŃĆéń¤®ķśĄõ╣śµ│ĢńÜäĶ«Īń«ŚÕÅ»õ╗źńö©õĖŗķØóńÜäÕģ¼Õ╝ÅĶĪ©ńż║’╝Ü + $$c[i,j] = a[i,:] * b[:,j]$$ + + +```python +m1 = np.array([[1.0,3.0],[1.0,0.0]]) +m2 = np.array([[1.0,2.0],[3.0,5.0]]) +print(m1) +print(m2) +# ń¤®ķśĄõ╣śµ│Ģ +m3 = np.dot(m1,m2) +print(m3) +# ń¤®ķśĄµīēÕģāń┤ĀńøĖõ╣ś +m4 = np.multiply(m1,m2) +# ń¤®ķśĄµīēÕģāń┤ĀńøĖõ╣ś +m5 = m1*m2 +print(m4) +print(m5) +``` + + [[1. 3.] + [1. 0.]] + [[1. 2.] + [3. 5.]] + [[10. 17.] + [ 1. 2.]] + [[1. 6.] + [3. 0.]] + [[1. 6.] + [3. 0.]] + + +## 1.5 ÕŹĢõĮŹń¤®ķśĄ +ÕŹĢõĮŹń¤®ķśĄµś»õĖĆõĖ¬µ¢╣ķśĄ’╝īÕ»╣Ķ¦Æń║┐õĖŖńÜäÕģāń┤ĀõĖ║1’╝īÕģČõĮÖÕģāń┤ĀõĖ║0ŃĆéÕŹĢõĮŹń¤®ķśĄńÜäõĮ£ńö©µś»õĖŹµö╣ÕÅśń¤®ķśĄńÜäÕĆ╝’╝īÕ«āõ╣śõ╗źõ╗╗õĮĢń¤®ķśĄķāĮńŁēõ║ÄÕĤń¤®ķśĄŃĆé + + +```python +np.identity(3) +``` + array([[1., 0., 0.], + [0., 1., 0.], + [0., 0., 1.]]) + + + +## 1.6 ń¤®ķśĄńÜäķĆå +ń¤®ķśĄAńÜäķĆå’╝łinverse’╝ēµś»õĖĆõĖ¬ń¤®ķśĄB’╝īõĮ┐ÕŠŚA├ŚB=I’╝īÕģČõĖŁIµś»ÕŹĢõĮŹń¤®ķśĄŃĆéń¤®ķśĄAńÜäķĆåĶ«░õĖ║$A^{ŌłÆ1}$ŃĆéÕ”éµ×£Aµś»õĖĆõĖ¬µ¢╣ķśĄ’╝īķéŻõ╣łAńÜäķĆåõ╣¤µś»õĖĆõĖ¬µ¢╣ķśĄŃĆéÕ”éµ×£AńÜäķĆåÕŁśÕ£©’╝īķéŻõ╣łAńÜäķĆåõ╣¤ÕŽÕüÜAńÜäõ╝¬ķĆå’╝łpseudo-inverse’╝ēŃĆé + + +```python +A = [[1,2],[4,5]] +A_inv = np.linalg.inv(A) +print(A_inv) +``` + [[-1.66666667 0.66666667] + [ 1.33333333 -0.33333333]] + + +## 1.7ĶīāµĢ░ norm +ÕÉæķćÅ$L^P$ĶīāµĢ░Õ«Üõ╣ēõĖ║’╝Ü

+$$||x||_p = (\sum_{i=1}^n |x_i|^p)^{1/p},p\geq 1,p\in\mathbb{R}$$ + +L1ĶīāµĢ░’╝ÜÕÉæķćÅõĖŁÕÉäõĖ¬Õģāń┤Āń╗ØÕ»╣ÕĆ╝õ╣ŗÕÆī

+$$||x||_1 = \sum_{i=1}^n |x_i|$$ + +L0ĶīāµĢ░’╝ÜÕÉæķćÅõĖŁķØ×ķøČÕģāń┤ĀńÜäõĖ¬µĢ░

+$$||x||_0 = \sum_{i=1}^n \mathbb{1}(x_i\neq 0)$$ + +L2ĶīāµĢ░’╝ÜÕÉæķćÅõĖŁÕÉäõĖ¬Õģāń┤ĀÕ╣│µ¢╣ÕÆīńÜäÕ╣│µ¢╣µĀ╣,õ╣¤ÕŽµ¼¦Õ╝ÅĶīāµĢ░,µś»ÕÉæķćÅxÕł░ÕĤńé╣ńÜäµ¼¦ÕćĀķćīÕŠŚĶĘØń”╗’╝īµ£ēµŚČÕĆÖõ╣¤ńö©L2ĶīāµĢ░ńÜäµØźĶĪĪķćÅÕÉæķćÅ’╝Ü$x^Tx$.

+$$||x||_2 = \sqrt{\sum_{i=1}^n x_i^2}$$ + +LŌł×ĶīāµĢ░’╝ÜÕÉæķćÅõĖŁÕÉäõĖ¬Õģāń┤Āń╗ØÕ»╣ÕĆ╝ńÜäµ£ĆÕż¦ÕĆ╝

+$$||x||_\infty = \max_{i=1,\cdots,n}|x_i|$$ + +µ£║ÕÖ©ÕŁ”õ╣ĀõĖŁÕĖĖńö©ńÜäĶīāµĢ░µ£ēL1ĶīāµĢ░ÕÆīL2ĶīāµĢ░’╝īL1ĶīāµĢ░ńö©õ║Äń©Ćń¢ÅµĆ¦ńÜäõ╝śÕī¢’╝īL2ĶīāµĢ░ńö©õ║ÄÕćĖõ╝śÕī¢ŃĆé + +```python +import numpy as np +a = np.array([1.0,3.0,5.0]) +print("ÕÉæķćÅńÜä2ĶīāµĢ░’╝Ü"+str(np.linalg.norm(a,ord=2))) +print("ÕÉæķćÅńÜä1ĶīāµĢ░’╝Ü"+str(np.linalg.norm(a,ord=1))) +print("ÕÉæķćÅńÜ䵌Āń®ĘĶīāµĢ░’╝Ü"+str(np.linalg.norm(a,ord=np.inf))) +# ń¤®ķśĄµēŹµ£ēFrobeniusĶīāµĢ░ +b = np.array([[1.0,3.0,5.0],[2.0,4.0,6.0]]) +print('ÕÉæķćÅńÜäFrobeniusĶīāµĢ░’╝Ü'+str(np.linalg.norm(b,ord='fro'))) +``` + + ÕÉæķćÅńÜä2ĶīāµĢ░’╝Ü5.916079783099616 + ÕÉæķćÅńÜä1ĶīāµĢ░’╝Ü9.0 + ÕÉæķćÅńÜ䵌Āń®ĘĶīāµĢ░’╝Ü5.0 + ÕÉæķćÅńÜäFrobeniusĶīāµĢ░’╝Ü9.539392014169456 + + +## 1.8 ńē╣ÕŠüÕĆ╝ÕłåĶ¦Ż +Õ”éµ×£õĖĆõĖ¬n├ŚnńÜäń¤®ķśĄAµ£ēnń╗äń║┐µĆ¦µŚĀÕģ│ńÜäÕŹĢõĮŹńē╣ÕŠüÕÉæķćÅ{$v^1$, $v^2$, $\cdots$, $v^n$}’╝īÕ╣ČõĖöÕ»╣Õ║öńÜäńē╣ÕŠüÕĆ╝õĖ║{$\lambda_1$, $\lambda_2$, $\cdots$, $\lambda_n$}’╝īķéŻõ╣łń¤®ķśĄAÕÅ»õ╗źĶó½ÕłåĶ¦ŻõĖ║’╝Ü

+ $$A = V diag(\lambda) V^{-1}$$ + +õĖŹµś»µēƵ£ēńÜäń¤®ķśĄķāĮµ£ēńē╣ÕŠüÕĆ╝ÕłåĶ¦Ż’╝īÕ”éµ×£Aµś»õĖĆõĖ¬n├ŚnńÜäń¤®ķśĄ’╝īķéŻõ╣łAńÜäńē╣ÕŠüÕĆ╝ÕłåĶ¦ŻÕŁśÕ£©ÕĮōõĖöõ╗ģÕĮōAµś»ÕÅ»ķĆåńÜäõĖöAńÜäĶĪīÕłŚÕ╝ÅõĖŹõĖ║0ŃĆéÕ”éµ×£AńÜäńē╣ÕŠüÕĆ╝ÕłåĶ¦ŻÕŁśÕ£©’╝īķéŻõ╣łAńÜäńē╣ÕŠüÕĆ╝ÕłåĶ¦Żµś»Õö»õĖĆńÜäŃĆé + + +```python +A = np.array([[1,2,3],[4,5,6],[7,8,9]]) +# Ķ«Īń«Śńē╣ÕŠüÕĆ╝ +eig_value,eig_vector = np.linalg.eig(A) +print("ńē╣ÕŠüÕĆ╝’╝Ü"+str(eig_value)) +print("ńē╣ÕŠüÕÉæķćÅ’╝Ü"+str(eig_vector)) +``` + + ńē╣ÕŠüÕĆ╝’╝Ü[ 1.61168440e+01 -1.11684397e+00 -1.30367773e-15] + ńē╣ÕŠüÕÉæķćÅ’╝Ü[[-0.23197069 -0.78583024 0.40824829] + [-0.52532209 -0.08675134 -0.81649658] + [-0.8186735 0.61232756 0.40824829]] + + +## 1.9 ÕźćÕ╝éÕĆ╝ÕłåĶ¦Ż +ÕźćÕ╝éÕĆ╝ÕłåĶ¦Ż’╝łSingular Value Decomposition’╝īSVD’╝ēµś»õĖĆń¦Źń¤®ķśĄÕłåĶ¦Żµ¢╣µ│Ģ’╝īÕ«āÕ░åõĖĆõĖ¬ń¤®ķśĄÕłåĶ¦ŻõĖ║ÕźćÕ╝éÕÉæķćÅÕÆīÕźćÕ╝éÕĆ╝’╝īÕ«āńÜäÕłåĶ¦ŻÕĮóÕ╝ÅÕ”éõĖŗ’╝Ü

+ $$A = U\Sigma V^T$$ + +ĶŗźAµś»m├ŚnńÜäń¤®ķśĄ’╝īķéŻõ╣łUµś»m├ŚmńÜ䵣Żõ║żń¤®ķśĄ’╝łÕģČÕłŚÕÉæķćÅń¦░õĖ║ÕĘ”ÕźćÕ╝éÕÉæķćÅ’╝ē’╝īVµś»n├ŚnńÜ䵣Żõ║żń¤®ķśĄ’╝łÕģČÕłŚÕÉæķćÅń¦░õĖ║ÕÅ│ÕźćÕ╝éÕÉæķćÅ’╝ē’╝ī$\Sigma$µś»m├ŚnńÜäÕ»╣Ķ¦Æń¤®ķśĄ’╝łÕ»╣Ķ¦Æń║┐õĖŖńÜäÕģāń┤Āń¦░õĖ║ÕźćÕ╝éÕĆ╝’╝ēŃĆéÕźćÕ╝éÕĆ╝ÕłåĶ¦ŻńÜäõĮ£ńö©µś»Õ░åõĖĆõĖ¬ń¤®ķśĄÕłåĶ¦ŻõĖ║õĖēõĖ¬ń¤®ķśĄńÜäõ╣śń¦»’╝īĶ┐ÖõĖēõĖ¬ń¤®ķśĄÕłåÕł½µś»µŁŻõ║żń¤®ķśĄÕÆīÕ»╣Ķ¦Æń¤®ķśĄ’╝īĶ┐ÖµĀĘÕ░▒ÕÅ»õ╗źÕ░åń¤®ķśĄńÜäń¦®ķÖŹõĮÄ’╝īõ╗ÄĶĆīĶŠŠÕł░ķÖŹń╗┤ńÜäńø«ńÜäŃĆé + +õ║ŗÕ«×õĖŖ’╝īÕĘ”ÕźćÕ╝éÕÉæķćÅÕ╝Å$AA^T$ńÜäńē╣ÕŠüÕÉæķćÅ’╝īÕÅ│ÕźćÕ╝éÕÉæķćŵś»$A^TA$ńÜäńē╣ÕŠüÕÉæķćÅ’╝īÕźćÕ╝éÕĆ╝µś»$AA^T$ńē╣ÕŠüÕĆ╝ńÜäÕ╣│µ¢╣µĀ╣ŃĆé + + +```python +A = np.array([[1,2,3],[4,5,6],[7,8,9]]) +U,D,V= np.linalg.svd(A) +print("U’╝Ü"+str(U)) +print("D’╝Ü"+str(D)) +print("V’╝Ü"+str(V)) +``` + + U’╝Ü[[-0.21483724 0.88723069 0.40824829] + [-0.52058739 0.24964395 -0.81649658] + [-0.82633754 -0.38794278 0.40824829]] + D’╝Ü[1.68481034e+01 1.06836951e+00 4.41842475e-16] + V’╝Ü[[-0.47967118 -0.57236779 -0.66506441] + [-0.77669099 -0.07568647 0.62531805] + [-0.40824829 0.81649658 -0.40824829]] + + +## 1.10 PCAÕłåĶ¦Ż +ÕüćĶ«Šµłæõ╗¼µ£ēmõĖ¬µĢ░µŹ«ńé╣$x^1,x^2,\cdot,x^m \in \mathbb{R}^n$,µ»ÅõĖ¬µĢ░µŹ«ńé╣µś»õĖĆõĖ¬nń╗┤ńÜäÕÉæķćÅ’╝īµłæõ╗¼ÕĖīµ£øÕ░åĶ┐Öõ║øµĢ░µŹ«ńé╣µŖĢÕĮ▒Õł░õĖĆõĖ¬lń╗┤ńÜäń®║ķŚ┤õĖŁ(ķÖŹń║¼õ╣ŗÕÉÄńÜ䵏¤Õż▒õ┐Īµü»Õ░ĮÕÅ»ĶāĮÕ£░Õ░æ’╝ē’╝īõĮ┐ÕŠŚµŖĢÕĮ▒ÕÉÄńÜäµĢ░µŹ«ńé╣õ╣ŗķŚ┤ńÜäĶĘØń”╗Õ░ĮÕÅ»ĶāĮńÜäÕż¦’╝īĶĆīµŖĢÕĮ▒ÕÉÄńÜäµĢ░µŹ«ńé╣õĖÄÕĤզŗµĢ░µŹ«ńé╣õ╣ŗķŚ┤ńÜäĶĘØń”╗Õ░ĮÕÅ»ĶāĮńÜäÕ░ÅŃĆéĶ┐ÖÕ░▒µś»PCAÕłåĶ¦ŻŃĆé +PCAÕłåĶ¦Żµś»ń║┐µĆ¦ÕÅśÕī¢’╝īÕüćĶ«Š$x^i$ÕłåĶ¦Żõ╣ŗÕÉÄńÜäÕ»╣Õ║öńé╣õĖ║$c^i$’╝īķéŻõ╣łµ£ē’╝Ü

+ $$f(x) =c $$

+ $$c \approx =g(f(x))$$

+ $$g(c)=Dc,D \in \mathbb{R}^{n\times l}$$

+õĖ║õ║åĶ«Īń«Śµ¢╣õŠ┐’╝īµłæõ╗¼Õ░åĶ┐ÖõĖ¬ń¤®ķśĄńÜäÕłŚÕÉæķćÅń║”µØ¤õĖ║ńøĖõ║ƵŁŻõ║żńÜä’╝øĶĆīõĖö’╝īĶĆāĶÖæÕł░Õ░║Õ║”ń╝®µöŠńÜäķŚ«ķóś’╝īµłæõ╗¼Õ░åĶ┐ÖõĖ¬ń¤®ķśĄńÜäÕłŚÕÉæķćÅń║”µØ¤õĖ║Õģʵ£ēÕŹĢõĮŹĶīāµĢ░µØźĶÄĘÕŠŚÕö»Ō╝ĆĶ¦ŻŃĆé +Õ»╣õ║Äń╗ÖÕ«ÜńÜäx’╝īµłæõ╗¼ķ£ĆĶ”üµēŠÕł░õ┐Īµü»µŹ¤Õż▒µ£ĆÕ░ÅńÜä$\boldsymbol{c}^{\star}$:

+$$\boldsymbol{c}^{\star}=\arg \min _{\boldsymbol{c}}\|\boldsymbol{x}-g(\boldsymbol{c})\|_2=\arg \min _{\boldsymbol{c}}\|\boldsymbol{x}-g(\boldsymbol{c})\|_2^2$$ + +Ķ┐Öķćīµłæõ╗¼ńö©õ║īĶīāµĢ░µØźĶĪĪķćÅõ┐Īµü»ńÜ䵏¤Õż▒ŃĆéÕ▒ĢÕ╝Ćõ╣ŗÕÉĵłæõ╗¼µ£ē:

+$$ +\|\boldsymbol{x}-g(\boldsymbol{c})\|_2^2=(\boldsymbol{x}-g(\boldsymbol{c}))^{\top}(\boldsymbol{x}-g(\boldsymbol{c}))=\boldsymbol{x}^{\top} \boldsymbol{x}-2 \boldsymbol{x}^{\top} g(\boldsymbol{c})+g(\boldsymbol{c})^{\top} g(\boldsymbol{c}) +$$ + +ń╗ōÕÉł $g(\boldsymbol{c})$ ńÜäĶĪ©ĶŠŠÕ╝Å, Õ┐ĮńĢźõĖŹõŠØĶĄ¢ $\boldsymbol{c}$ ńÜä $\boldsymbol{x}^{\top} \boldsymbol{x}$ ķĪ╣, µłæõ╗¼µ£ē:

+$$ +\begin{aligned} +\boldsymbol{c}^{\star} & =\arg \min _{\boldsymbol{c}}-2 \boldsymbol{x}^{\top} \boldsymbol{D} \boldsymbol{c}+\boldsymbol{c}^{\top} \boldsymbol{D}^{\top} \boldsymbol{D} \boldsymbol{c} \\ +& =\arg \min _{\boldsymbol{c}}-2 \boldsymbol{x}^{\top} \boldsymbol{D} \boldsymbol{c}+\boldsymbol{c}^{\top} \boldsymbol{I}_l \boldsymbol{c} \\ +& =\arg \min _{\boldsymbol{c}}-2 \boldsymbol{x}^{\top} \boldsymbol{D} \boldsymbol{c}+\boldsymbol{c}^{\top} \boldsymbol{c} +\end{aligned} +$$ + + +Ķ┐Öķćī $\boldsymbol{D}$ Õģʵ£ēÕŹĢõĮŹµŁŻõ║żµĆ¦ŃĆé +Õ»╣ $\boldsymbol{c}$ µ▒éµó»Õ║”, Õ╣Čõ╗żÕģČõĖ║ķøČ, µłæõ╗¼µ£ē:

+ + +$$ +\begin{aligned} +\nabla_{\boldsymbol{c}}\left(-2 \boldsymbol{x}^{\top} \boldsymbol{D} \boldsymbol{c}+\boldsymbol{c}^{\top} \boldsymbol{c}\right) & =\mathbf{0} \\ +-2 \boldsymbol{D}^{\top} \boldsymbol{x}+2 \boldsymbol{c} & =\mathbf{0} \\ +\boldsymbol{c} & =\boldsymbol{D}^{\top} \boldsymbol{x} +\end{aligned} +$$ + +ÕøĀµŁż, µłæõ╗¼ńÜäń╝¢ńĀüÕćĮµĢ░õĖ║:

+$$ +f(x)=D^{\top} \boldsymbol{x} +$$ + +µŁżµŚČķĆÜĶ┐ćń╝¢ńĀüĶ¦ŻńĀüÕŠŚÕł░ńÜä $ķ揵×ä\boldsymbol{x}$ õĖ║:

+$$r(x)=g(f(x))=DD^{\top}x$$ + +µÄźõĖŗµØźµ▒éĶ¦Żµ£Ćõ╝śńÜäÕÅśµŹó $\boldsymbol{D}$ ŃĆéńö▒õ║ĵłæõ╗¼ķ£ĆĶ”üÕ░å $\boldsymbol{D}$ Õ║öńö©Õł░µēƵ£ēńÜä $\boldsymbol{x}_i$ õĖŖ’╝īµēĆõ╗źµłæõ╗¼ķ£ĆĶ”üµ£Ćõ╝śÕī¢: +$$ +\begin{array}{l} +\boldsymbol{D}^{\star}=\arg \min _{\boldsymbol{D}} \sqrt{\sum_{i, j}\left(\boldsymbol{x}_j^{(i)}-r\left(\boldsymbol{x}^{(i)}\right)_j\right)^2} \\ +\text { s.t. } \boldsymbol{D}^{\top} \boldsymbol{D}=\boldsymbol{I}_l +\end{array} +$$ +

+õĖ║õ║åµ¢╣õŠ┐, µłæõ╗¼ĶĆāĶÖæ $l=1$ ńÜäµāģÕåĄ, µŁżµŚČķŚ«ķóśń«ĆÕī¢õĖ║: +$$ +\begin{array}{l} +\left.\boldsymbol{d}^{\star}=\arg \min _{\boldsymbol{d}} \sum_i\left(\boldsymbol{x}_j^{(i)}-\boldsymbol{d} \boldsymbol{d}^{\top} \boldsymbol{x}^{(i)}\right)\right)^2 \\ +\text { s.t. } \boldsymbol{d}^{\top} \boldsymbol{d}=1 +\end{array} +$$ +

+ĶĆāĶÖæ $\mathrm{F}$ ĶīāµĢ░, Õ╣ČĶ┐øõĖƵŁźńÜäµÄ©Õ»╝:

+$$ +\begin{array}{l} +\boldsymbol{d}^{\star}=\arg \max _{\boldsymbol{d}} \operatorname{Tr}\left(\boldsymbol{d}^{\top} \boldsymbol{X}^{\top} \boldsymbol{X} \boldsymbol{d}\right) \\ +\text { s.t. } \boldsymbol{d}^{\top} \boldsymbol{d}=1 +\end{array} +$$ + +õ╝śÕī¢ķŚ«ķóśÕÅ»õ╗źńö©ńē╣ÕŠüÕĆ╝ÕłåĶ¦ŻµØźµ▒éĶ¦ŻŃĆé + +Õ«×ķÖģĶ«Īń«ŚõĖŁ,PCAÕłåĶ¦ŻńÜäÕ«×ńÄ░µś»Õ¤║õ║ÄSVDÕłåĶ¦ŻńÜä,ÕŹ│ÕüćĶ«Šµ£ēõĖĆõĖ¬ $m \times n$ ńÜäń¤®ķśĄ $\boldsymbol{X}$, µĢ░µŹ«ńÜäÕØćÕĆ╝õĖ║ķøČ, ÕŹ│ $\mathbb{E}[\boldsymbol{x}]=0, \boldsymbol{X}$ Õ»╣Õ║öńÜ䵌ĀÕüŵĀʵ£¼ÕŹÅµ¢╣ÕĘ«ń¤®ķśĄ: $\operatorname{Var}[\boldsymbol{x}]=\frac{1}{m-1} \boldsymbol{X}^{\top} \boldsymbol{X}^{\mathrm{d}}$ + + +PCA µś»ķĆÜĶ┐ćń║┐µĆ¦ÕÅśµŹóµēŠÕł░õĖĆõĖ¬ $\operatorname{Var}[c]$ µś»Õ»╣Ķ¦Æń¤®ķśĄńÜäĶĪ©ńż║ $\boldsymbol{c}=\boldsymbol{V}^{\top} \boldsymbol{x}$, ń¤®ķśĄ $\boldsymbol{X}$ ńÜäõĖ╗µłÉÕłåÕÅ»õ╗źķĆÜĶ┐ćÕźćÕ╝éÕĆ╝ÕłåĶ¦Ż (SVD) ÕŠŚÕł░, õ╣¤Õ░▒µś»Ķ»┤õĖ╗µłÉÕłåµś» $\boldsymbol{X}$ ńÜäÕÅ│ÕźćÕ╝éÕÉæķćÅŃĆéÕüćĶ«Š $\boldsymbol{V}$ µś» $\boldsymbol{X}=\boldsymbol{U} \boldsymbol{\Sigma} \boldsymbol{V}^{\top}$ ÕźćÕ╝éÕĆ╝ÕłåĶ¦ŻńÜäÕÅ│ÕźćÕ╝éÕÉæķćÅ, µłæõ╗¼ÕŠŚÕł░ÕĤµØźńÜäńē╣ÕŠüÕÉæķćŵ¢╣ń©ŗ: +$$ +\boldsymbol{X}^{\top} \boldsymbol{X}=\left(\boldsymbol{U} \boldsymbol{\Sigma} \boldsymbol{V}^{\top}\right)^{\top} \boldsymbol{U} \boldsymbol{\Sigma} \boldsymbol{V}^{\top}=\boldsymbol{V} \boldsymbol{\Sigma}^{\top} \boldsymbol{U}^{\top} \boldsymbol{U} \boldsymbol{\Sigma} \boldsymbol{V}^{\top}=\boldsymbol{V} \boldsymbol{\Sigma}^2 \boldsymbol{V}^{\top} +$$ +ÕøĀõĖ║µĀ╣µŹ«ÕźćÕ╝éÕĆ╝ńÜäÕ«Üõ╣ē $\boldsymbol{U}^{\top} \boldsymbol{U}=\boldsymbol{I}$ ŃĆéÕøĀµŁż $\boldsymbol{X}$ ńÜäµ¢╣ÕĘ«ÕÅ»õ╗źĶĪ©ńż║õĖ║’╝Ü $\operatorname{Var}[\boldsymbol{x}]=\frac{1}{m-1} \boldsymbol{X}^{\top} \boldsymbol{X}=\frac{1}{m-1} \boldsymbol{V} \boldsymbol{\Sigma}^2 \boldsymbol{V}^{\top}$ ŃĆé +µēĆõ╗ź $\boldsymbol{c}$ ńÜäÕŹÅµ¢╣ÕĘ«µ╗ĪĶČ│’╝Ü $\operatorname{Var}[\boldsymbol{c}]=\frac{1}{m-1} \boldsymbol{C}^{\top} \boldsymbol{C}=\frac{1}{m-1} \boldsymbol{V}^{\top} \boldsymbol{X}^{\top} \boldsymbol{X} \boldsymbol{V}=\frac{1}{m-1} \boldsymbol{V}^{\top} \boldsymbol{V} \boldsymbol{\Sigma}^2 \boldsymbol{V}^{\top} \boldsymbol{V}=\frac{1}{m-1} \boldsymbol{\Sigma}^2$, ÕøĀõĖ║µĀ╣µŹ«ÕźćÕ╝éÕĆ╝Õ«Üõ╣ē $\boldsymbol{V}^{\top} \boldsymbol{V}=\boldsymbol{I}$ ŃĆé $\boldsymbol{c}$ ńÜäÕŹÅµ¢╣ÕĘ«µś»Õ»╣ Ķ¦ÆńÜä, $c$ õĖŁńÜäÕģāń┤Āµś»ÕĮ╝µŁżµŚĀÕģ│ńÜäŃĆé + + + + + + +```python +# õ╗ź iris µĢ░µŹ«õĖ║õŠŗ’╝īÕ▒ĢŌĮ░ PCA ńÜäõĮ┐ŌĮżŃĆé +import pandas as pd +import numpy as np +from sklearn.datasets import load_iris +import matplotlib.pyplot as plt +from sklearn.preprocessing import StandardScaler +%matplotlib inline + + # ĶĮĮÕģźµĢ░µŹ« +iris = load_iris() +df = pd.DataFrame(iris.data, columns=iris.feature_names) +df['label'] = iris.target +df.columns = ['sepal length', 'sepal width', 'petal length', 'petal width', 'label'] +# µ¤źń£ŗµĢ░µŹ« +df.tail() +``` + + + + +

| + | sepal length | +sepal width | +petal length | +petal width | +label | +

|---|---|---|---|---|---|

| 145 | +6.7 | +3.0 | +5.2 | +2.3 | +2 | +

| 146 | +6.3 | +2.5 | +5.0 | +1.9 | +2 | +

| 147 | +6.5 | +3.0 | +5.2 | +2.0 | +2 | +

| 148 | +6.2 | +3.4 | +5.4 | +2.3 | +2 | +

| 149 | +5.9 | +3.0 | +5.1 | +1.8 | +2 | +

+$$P(x=x^i)=\frac{1}{k}$$ + +µ”éĶ«║Õ»åÕ║”ÕćĮµĢ░(probability Density Function),Õ»╣õ║ÄĶ┐×ń╗ŁÕ×ŗÕÅśķćÅ’╝īµłæõ╗¼ÕģłÕ«Üõ╣ēõĖĆõĖ¬ķÜŵ£║ÕÅśķćÅ’╝īńäČÕÉÄńö©µ”éńÄćÕ»åÕ║”ÕćĮµĢ░µØźµÅÅĶ┐░Ķ┐ÖõĖ¬ķÜŵ£║ÕÅśķćÅńÜäÕÅ¢ÕĆ╝ÕłåÕĖāŃĆéµ”éńÄćÕ»åÕ║”ÕćĮµĢ░µś»õĖĆõĖ¬ÕćĮµĢ░’╝īÕ«āńÜäĶŠōÕģźµś»ķÜŵ£║ÕÅśķćÅńÜäÕÅ¢ÕĆ╝’╝īĶŠōÕć║µś»ķÜŵ£║ÕÅśķćÅÕÅ¢Ķ┐ÖõĖ¬ÕĆ╝ńÜäµ”éńÄćŃĆéµ”éńÄćÕ»åÕ║”ÕćĮµĢ░ńÜäÕ«Üõ╣ēµś»’╝īÕ»╣õ║ÄĶ┐×ń╗ŁÕ×ŗķÜŵ£║ÕÅśķćÅX’╝īÕ«āńÜäµ”éńÄćÕ»åÕ║”ÕćĮµĢ░µś»õĖĆõĖ¬ÕćĮµĢ░P(x)’╝īÕ«āńÜäÕ«Üõ╣ēÕ¤¤µś»ķÜŵ£║ÕÅśķćÅXńÜäÕÅ¢ÕĆ╝ķøåÕÉłŃĆéP’╝łx)µś»õĖĆõĖ¬ķØ×Ķ┤¤ńÜäÕćĮµĢ░’╝īÕ«āńÜäń¦»Õłåµś»1’╝īÕŹ│’╝Ü

+$$\int_{-\infty}^{\infty}P(x)dx=1$$ +õĖöµ╗ĪĶČ│ķØ×Ķ┤¤µĆ¦’╝Ü +$$ \forall x \in \mathbb{X}, P(x)\geq 0$$ + +ń┤»Ķ«ĪÕłåÕĖāÕćĮµĢ░(cumulative distribution function)ĶĪ©ńż║Õ»╣Õ░Åõ║ÄxńÜäµ”éńÄćĶ┐øĶĪīń¦»Õłå’╝īÕŹ│’╝Ü

+$$CDF(x)=\int_{-\infty}^{x}P(x)dx$$ + + + +```python +import numpy as np +import matplotlib.pyplot as plt +from scipy.stats import uniform +%matplotlib inline +``` + + +```python +# generate the sample +fig,ax = plt.subplots(1,1) +# õĮ┐ńö©ÕÅéµĢ░locÕÆīscale,ÕÅ»õ╗źÕŠŚÕł░[loc, loc + scale]õĖŖńÜäÕØćÕīĆÕłåÕĖā’╝īsize=1000ĶĪ©ńż║µĀʵ£¼µĢ░’╝īrandom_state=123ĶĪ©ńż║ķÜŵ£║ń¦ŹÕŁÉ +r = uniform.rvs(loc=0,scale=1,size=1000,random_state=123) +# density=TrueĶĪ©ńż║µ”éńÄćÕ»åÕ║”’╝īhisttype='stepfilled'ĶĪ©ńż║ÕĪ½Õģģ’╝īalpha=0.5ĶĪ©ńż║ķĆŵśÄÕ║” +ax.hist(r,density=True,histtype='stepfilled',alpha=0.5) +# ÕØćÕīĆÕłåÕĖāpdf +x = np.linspace(uniform.ppf(0.01),uniform.ppf(0.99),100) +ax.plot(x,uniform.pdf(x),'r-',lw=5,alpha =0.6,label='uniform pdf') + +``` + + + + + [

+$$ \forall x \in \mathbb{X},P(\mathrm{x}=x) = \sum_y P(\mathrm{x}=x,\mathrm{y}=y)$$ + +µØĪõ╗ȵ”éĶ«║’╝łconditional probability’╝ēÕ£©ÕŠłÕżÜµāģÕåĄõĖŗ’╝īµłæõ╗¼õĖŹõ╗ģÕģ│Õ┐āõĖĆõĖ¬õ║ŗõ╗ČńÜäµ”éńÄć’╝īĶ┐śÕģ│Õ┐āÕ£©ÕÅ”õĖĆõĖ¬õ║ŗõ╗ČÕÅæńö¤ńÜäµØĪõ╗ČõĖŗ’╝īĶ┐ÖõĖ¬õ║ŗõ╗ČńÜäµ”éńÄćŃĆéĶ┐Öń¦ŹÕ£©ÕÅ”õĖĆõĖ¬õ║ŗõ╗ČÕÅæńö¤ńÜäµØĪõ╗ČõĖŗ’╝īõ║ŗõ╗ČńÜäµ”éńÄćń¦░õĖ║µØĪõ╗ȵ”éĶ«║ŃĆéµØĪõ╗ȵ”éĶ«║ńÜäÕ«Üõ╣ēµś»’╝Ü

+$$P(\mathrm{x}=x|\mathrm{y}=y)=\frac{P(\mathrm{x}=x,\mathrm{y}=y)}{P(\mathrm{y}=y)}$$ +Ķ┐ÖõĖ¬Õģ¼Õ╝ÅĶĪ©ńż║Õ£©yÕÅæńö¤ńÜäµØĪõ╗ČõĖŗ’╝īxÕÅæńö¤ńÜäµ”éńÄćŃĆé + +µØĪõ╗ȵ”éĶ«║ńÜäķōŠÕ╝ŵ│ĢÕłÖ(chain rule of conditional probability)’╝Üõ╗╗õĮĢÕżÜń╗┤ķÜŵ£║ÕÅśķćÅńÜäĶüöÕÉłµ”éĶ«║ÕłåÕĖā’╝īķāĮÕÅ»õ╗źÕłåĶ¦ŻµłÉÕŬµ£ēÕŬµ£ēõĖĆõĖ¬ÕÅśķćÅńÜäµØĪõ╗ȵ”éĶ«║ńøĖõ╣śńÜäÕĮóÕ╝Å

+$$P(\mathrm{x}=x,\mathrm{y}=y,\mathrm{z}=z)=P(\mathrm{x}=x|\mathrm{y}=y,\mathrm{z}=z)P(\mathrm{y}=y,\mathrm{z}=z)=P(\mathrm{x}=x|\mathrm{y}=y,\mathrm{z}=z)P(\mathrm{y}=y|\mathrm{z}=z)P(\mathrm{z}=z)$$ + +$$P(x_1,x_2,\cdots,x_n)=P(x_1|x_2,\cdots,x_n)P(x_2|x_3,\cdots,x_n)\cdots P(x_{n-1}|x_n)P(x_n)$$ + +ńŗ¼ń½ŗµĆ¦’╝łindependence’╝ēÕ”éµ×£õĖżõĖ¬ķÜŵ£║ÕÅśķćÅXÕÆīYµ╗ĪĶČ│’╝Ü

+$$P(\mathrm{x}=x,\mathrm{y}=y)=P(\mathrm{x}=x)P(\mathrm{y}=y)$$ +õ╣¤ÕŹ│µś»ĶüöÕÉłµ”éĶ«║ÕłåÕĖāÕÅ»õ╗źĶĪ©ńż║µłÉÕŬµ£ēõĖĆõĖ¬ÕÅśķćÅńÜäµØĪõ╗ȵ”éĶ«║ńøĖõ╣śńÜäÕĮóÕ╝ÅŃĆé + +µØĪõ╗Čńŗ¼ń½ŗµĆ¦’╝łconditional independence’╝ēÕ”éµ×£Õģ│õ║ÄxÕÆīyńÜäµØĪõ╗ȵ”éńÄćÕłåÕĖāÕ»╣õ║ÄzńÜäµ»ÅõĖĆõĖ¬ÕĆ╝ķāĮµ╗ĪĶČ│ńŗ¼ń½ŗµĆ¦’╝īķéŻõ╣łµłæõ╗¼Õ░▒Ķ»┤xÕÆīyÕ£©zńÜäµØĪõ╗ČõĖŗµś»µØĪõ╗Čńŗ¼ń½ŗńÜäŃĆé

+$$P(\mathrm{x}=x,\mathrm{y}=y|\mathrm{z}=z)=P(\mathrm{x}=x|\mathrm{z}=z)P(\mathrm{y}=y|\mathrm{z}=z)$$ + +### 2.1.4 ķÜŵ£║ÕÅśķćÅńÜäÕ║”ķćÅ +µ£¤µ£ø’╝łexpectation’╝ēµś»ķÜŵ£║ÕÅśķćÅńÜäÕ╣│ÕØćÕĆ╝’╝īµ£¤µ£øńÜäÕ«Üõ╣ēµś»’╝Ü

+$$E(X)=\sum_x xP(X=x)$$ +Õ»╣õ║ÄĶ┐×ń╗ŁÕ×ŗķÜŵ£║ÕÅśķćÅÕÅ»õ╗źķĆÜĶ┐ćń¦»ÕłåńÜäÕĮóÕ╝ÅĶĪ©ńż║’╝Ü

+$$E(X)=\int_{-\infty}^{\infty}xP(X=x)dx$$ + +ÕÅ”Õż¢’╝īµ£¤µ£øµś»ń║┐µĆ¦ńÜä’╝īÕŹ│’╝Ü

+$$E(aX+bY)=aE(X)+bE(Y)$$ + +µ¢╣ÕĘ«’╝łvariance’╝ēµś»ķÜŵ£║ÕÅśķćÅńÜäń”╗µĢŻń©ŗÕ║”’╝īµ¢╣ÕĘ«ńÜäÕ«Üõ╣ēµś»’╝Ü

+$$Var(X)=E[(X-E(X))^2]$$ + +µĀćÕćåÕĘ«’╝łstandard deviation’╝ēµś»µ¢╣ÕĘ«ńÜäÕ╣│µ¢╣µĀ╣’╝īµĀćÕćåÕĘ«ńÜäÕ«Üõ╣ēµś»’╝Ü

+$$\sigma(X)=\sqrt{Var(X)}$$ + +ÕŹÅµ¢╣ÕĘ«’╝łcovariance’╝ēµś»õĖżõĖ¬ķÜŵ£║ÕÅśķćÅńÜäń║┐µĆ¦ńøĖÕģ│ń©ŗÕ║”’╝īÕŹÅµ¢╣ÕĘ«ńÜäÕ«Üõ╣ēµś»’╝Ü

+$$Cov(X,Y)=E[(X-E(X))(Y-E(Y))]$$ + +**µ│©µäÅ**ÕŹÅµ¢╣ÕĘ«ńÜäń¼”ÕÅĘĶĪ©ńż║õĖżõĖ¬ķÜŵ£║ÕÅśķćÅńÜäń║┐µĆ¦ńøĖÕģ│ń©ŗÕ║”’╝īµŁŻµĢ░ĶĪ©ńż║µŁŻńøĖÕģ│’╝īĶ┤¤µĢ░ĶĪ©ńż║Ķ┤¤ńøĖÕģ│’╝ī0ĶĪ©ńż║õĖŹńøĖÕģ│ŃĆé

+**µ│©µäÅ**ńŗ¼ń½ŗõĖÄķøČÕŹÅµ¢╣ÕĘ«µø┤Õ╝║’╝īÕøĀõĖ║ńŗ¼ń½ŗĶ┐śµÄÆķÖżõ║åķØ×ń║┐µĆ¦ńÜäńøĖÕģ│ŃĆé + + +```python +x= np.array([1,2,3,4,5,6,7,8,9,10]) +y = np.array([10,9,8,7,6,5,4,3,2,1]) +Mean = np.mean(x) +Var = np.var(x) +Var_unbiased = np.var(x,ddof=1)# ddof=1ĶĪ©ńż║µŚĀÕüÅõ╝░Ķ«Ī +Std = np.std(x) +Cov = np.cov(x,y) +Mean,Var,Var_unbiased,Std,Cov +``` + + + + + (5.5, + 8.25, + 9.166666666666666, + 2.8722813232690143, + array([[ 9.16666667, -9.16666667], + [-9.16666667, 9.16666667]])) + + + +### 2.1.5 ÕĖĖńö©µ”éńÄćÕłåÕĖā +õ╝»ÕŖ¬Õł®ÕłåÕĖā’╝łBernoulli distribution’╝ēµś»õĖĆõĖ¬õ║īķĪ╣ÕłåÕĖāńÜäńē╣õŠŗ’╝īÕ«āÕŬµ£ēõĖżõĖ¬ÕÅ»ĶāĮńÜäÕÅ¢ÕĆ╝’╝ī0ÕÆī1’╝īÕ«āńÜäµ”éńÄćĶ┤©ķćÅÕćĮµĢ░µś»’╝łĶĪ©ńż║õĖƵ¼ĪÕ«×ķ¬īµłÉÕŖ¤ńÜäµ”éńÄć’╝ē’╝Ü

+$$P(X=1)=p$$, +$$P(X=0)=1-p$$, +$$P(X=x)=p^x(1-p)^{1-x}$$ + + +```python +def plot_distribution(X,axes=None): + '''ń╗ÖÕ«ÜķÜŵ£║ÕÅśķćÅX’╝īń╗śÕłČÕģČPDF,PMF,CDF''' + if axes is None: + fig,axes = plt.subplots(1,3,figsize=(12,4)) + x_min,x_max = X.interval(0.99)# 99%ńÜäµ”éńÄćÕ»åÕ║”Õ£©Õī║ķŚ┤Õåģ + x = np.linspace(x_min,x_max,1000) + # Ķ┐×ń╗ŁÕ×ŗÕÅśķćÅ’╝īńö╗PDF’╝øń”╗µĢŻÕ×ŗÕÅśķćÅ’╝īńö╗PMF + if hasattr(X.dist,'pdf'): + # axes[0]ĶĪ©ńż║ń¼¼õĖĆĶĪī’╝īń¼¼õĖĆÕłŚ + axes[0].plot(x,X.pdf(x),label='PDF') + axes[0].fill_between(x,X.pdf(x),alpha=0.5) # ÕĪ½Õģģ,ķĆŵśÄÕ║”0.5 + else: + x_int = np.unique(x.astype(int))# ÕÅ¢µĢ┤,uniqueÕÄ╗ķćŹ + axes[0].bar(x_int,X.pmf(x_int),label='PMF') + # CDF + axes[1].plot(x,X.cdf(x),label='CDF') + for ax in axes: + ax.legend() + return axes +``` + + +```python +from scipy.stats import bernoulli +fig,axes = plt.subplots(1,2,figsize=(12,4)) +r = bernoulli(p=0.6) # ńö¤µłÉõ╝»ÕŖ¬Õł®ÕłåÕĖā +plot_distribution(r,axes) +``` + + + + + array([

+$$P(X=k)=p_k$$ + +õŠŗՔ鵻ŵ¼ĪĶ»Ģķ¬īńÜäń╗ōµ×£Õ░▒ÕÅ»õ╗źĶĪ©ńż║µłÉõĖĆõĖ¬kń╗┤ńÜäÕÉæķćÅ’╝īµ»ÅõĖ¬ń╗┤Õ║”ĶĪ©ńż║õĖĆń¦Źń╗ōµ×£’╝īÕŬµ£ēµŁżµ¼ĪĶ»Ģķ¬īńÜäń╗ōµ×£Õ»╣Õ║öńÜäń╗┤Õ║”õĖ║1’╝īÕģČõĮÖń╗┤Õ║”õĖ║0’╝īõŠŗÕ”é’╝Ü

+$$P(X=(1,0,0,0))=p_1$$

+$$P(X=(0,1,0,0))=p_2$$

+$$P(X=(0,0,1,0))=p_3$$

+$$P(X=(0,0,0,1))=p_4$$ + + + +```python +def k_possibilities(k): + '''ńö¤µłÉkõĖ¬ÕÅ»ĶāĮńÜäń╗ōµ×£''' + res = np.random.rand(k)# random.rand(k)ńö¤µłÉkõĖ¬[0,1)õ╣ŗķŚ┤ńÜäķÜŵ£║µĢ░ + _sum = sum(res) # µ▒éÕÆī + for i,x in enumerate(res): + res[i] = x/_sum # ÕĮÆõĖĆÕī¢,enumerateĶ┐öÕø×ń┤óÕ╝ĢÕÆīÕĆ╝,iĶĪ©ńż║ń┤óÕ╝Ģ’╝īxĶĪ©ńż║ÕĆ╝ + return res +fig,axes = plt.subplots(1,2,figsize=(12,4)) +# õĖƵ¼ĪÕ«×ķ¬ī’╝īĶīāńĢ┤ÕłåÕĖā +n_samples = 1 +k=10 +samples = np.random.multinomial(n_samples,k_possibilities(k)) +axes[0].bar(range(len(samples)),samples/n_samples,label ='Multinomial') + +# nµ¼ĪÕ«×ķ¬ī’╝īÕżÜķĪ╣ÕłåÕĖā +n_samples = 1000 +samples = np.random.multinomial(n_samples,k_possibilities(k)) +axes[1].bar(range(len(samples)),samples/n_samples,label ='Multinomial') +for ax in axes: + ax.legend() +``` + + + + + +ķ½śµ¢»ÕłåÕĖā’╝łGaussian distribution’╝īµŁŻµĆüÕłåÕĖā’╝ēµś»õĖĆõĖ¬Ķ┐×ń╗ŁÕ×ŗµ”éńÄćÕłåÕĖā’╝īĶŗźķÜŵ£║ÕÅśķćÅ$X\sim \mathcal{N}(\mu,\sigma^2)$,Õ«āńÜäµ”éńÄćÕ»åÕ║”ÕćĮµĢ░µś»’╝Ü

+$$P(X=x)=\frac{1}{\sqrt{2\pi\sigma^2}}e^{-\frac{(x-\mu)^2}{2\sigma^2}}$$

+µ£ēµŚČõ╣¤õ╝Üńö©$\beta = \frac{1}{\sigma^2}$µØźĶĪ©ńż║ÕłåÕĖāńÜäń▓ŠÕ║”(ń▓ŠÕ║”ĶČŖÕż¦’╝īÕłåÕĖāĶČŖńŗŁń¬ä’╝īprecision)’╝Ü

+$$P(X=x)=\frac{1}{\sqrt{2\pi\beta^{-1}}}e^{-\frac{(x-\mu)^2}{2\beta}}$$ + +õĖŁÕ┐āµ×üķÖÉÕ«ÜńÉå’╝łcentral limit theorem’╝ēµś»õĖĆõĖ¬ķćŹĶ”üńÜäÕ«ÜńÉå’╝īÕ«āĶĪ©ńż║ÕĮōµĀʵ£¼ķćÅĶČ│Õż¤Õż¦µŚČ’╝īµĀʵ£¼ÕØćÕĆ╝ńÜäÕłåÕĖāõ╝ÜĶČŗĶ┐æõ║ĵŁŻµĆüÕłåÕĖā’╝īÕ”éÕÖ¬ÕŻ░ńÜäÕłåÕĖāÕ░▒µś»õĖĆõĖ¬ÕģĖÕ×ŗńÜäõŠŗÕŁÉ’╝īÕÖ¬ÕŻ░ńÜäÕłåÕĖāµś»ÕØćÕīĆÕłåÕĖā’╝īõĮåµś»ÕĮōÕÖ¬ÕŻ░ńÜäµĢ░ķćÅĶČ│Õż¤ÕżÜµŚČ’╝īÕÖ¬ÕŻ░ńÜäÕØćÕĆ╝ńÜäÕłåÕĖāÕ░▒õ╝ÜĶČŗĶ┐æõ║ĵŁŻµĆüÕłåÕĖāŃĆé + +Õ”éµ×£µłæõ╗¼Õ»╣ķÜŵ£║ÕÅśķćÅĶ┐øĶĪīµĀćÕćåÕī¢’╝īÕŹ│Õ░åķÜŵ£║ÕÅśķćÅÕćÅÕÄ╗ÕØćÕĆ╝Õ╣ČķÖżõ╗źµĀćÕćåÕĘ«’╝īķéŻõ╣łµĀćÕćåÕī¢ÕÉÄńÜäķÜŵ£║ÕÅśķćÅńÜäÕØćÕĆ╝õĖ║0’╝īµĀćÕćåÕĘ«õĖ║1’╝īĶ┐ÖµĀĘńÜäķÜŵ£║ÕÅśķćÅń¦░õĖ║µĀćÕćåµŁŻµĆüÕłåÕĖā’╝łstandard normal distribution’╝ē’╝ī

+$$Z=\frac{X-\mu}{\sigma}$$ + + +```python +from scipy.stats import norm +fig,axes = plt.subplots(1,2,figsize= (12,4)) +mu,sigma = 0,1# ÕØćÕĆ╝’╝īµĀćÕćåÕĘ« +r = norm(loc=mu,scale=sigma)# ńö¤µłÉµŁŻµĆüÕłåÕĖā +plot_distribution(r,axes) #ń╗śÕłČrńÜäPDFÕÆīCDF +``` + + + + + array([

+$$P(X=x;\sigma,\Sigma)=\frac{1}{(2\pi)^{n/2}|\Sigma|^{1/2}}e^{-\frac{1}{2}(x-\mu)^T\Sigma^{-1}(x-\mu)}$$ +

+ÕģĘõĮōµÄ©Õ»╝Ķ┐ćń©ŗÕ”éõĖŗ’╝Ü

+ÕģłÕüćĶ«Š $\mathrm{n}$ õĖ¬ÕÅśķćÅ $x=\left[x_1, x_2, \cdots, x_n\right]^{\mathrm{T}}$ õ║ÆõĖŹńøĖÕģ│’╝īõĖöµ£Źõ╗ĵŁŻµĆüÕłåÕĖā (ń╗┤Õ║”õĖŹńøĖÕģ│ÕżÜÕģāµŁŻµĆüÕłåÕĖā)’╝īÕÉäõĖ¬ń╗┤Õ║”ńÜäÕØćÕĆ╝ $E(x)=\left[\mu_1, \mu_2, \cdots, \mu_n\right]^{\mathrm{T}}$ ’╝īµ¢╣ÕĘ« $\sigma(x)=\left[\sigma_1, \sigma_2, \cdots, \sigma_n\right]^{\mathrm{T}}$ +

+µĀ╣µŹ«ĶüöÕÉłµ”éńÄćÕ»åÕ║”Õģ¼Õ╝Å: +$$ +\begin{aligned} +& f(x)=p\left(x_1, x_2 \ldots x_n\right)=p\left(x_1\right) p\left(x_2\right) \ldots p\left(x_n\right)=\frac{1}{(\sqrt{2 \pi})^n \sigma_1 \sigma_2 \cdots \sigma_n} e^{-\frac{\left(x_1-\mu_1\right)^2}{2 \sigma_1^2}-\frac{\left(x_2-\mu_2\right)^2}{2 \sigma_2^2} \cdots-\frac{\left(x_n-\mu_n\right)^2}{2 \sigma_n}} \\ +& \text { õ╗ż } z^2=\frac{\left(x_1-\mu_1\right)^2}{\sigma_1^2}+\frac{\left(x_2-\mu_2\right)^2}{\sigma_2^2} \cdots+\frac{\left(x_n-\mu_n\right)^2}{\sigma_n^2}, \sigma_z=\sigma_1 \sigma_2 \cdots \sigma_n +\end{aligned} +$$ +Ķ┐ÖµĀĘÕżÜÕģāµŁŻµĆüÕłåÕĖāÕÅłÕÅ»õ╗źÕåÖµłÉõĖĆÕģāķéŻń¦Źµ╝éõ║«ńÜäÕĮóÕ╝Åõ║å(µ│©µäÅõĖĆÕģāõĖÄÕżÜÕģāńÜäÕĘ«Õł½):

+$$ +f(z)=\frac{1}{(\sqrt{2 \pi})^n \sigma_z} e^{-\frac{z^2}{2}} +$$ +

+ÕøĀõĖ║ÕżÜÕģāµŁŻµĆüÕłåÕĖāµ£ēńØĆÕŠłÕ╝║ńÜäÕćĀõĮĢµĆصā│’╝īÕŹĢń║»õ╗Äõ╗ŻµĢ░ńÜäĶ¦ÆÕ║”ń£ŗÕŠģzÕŠłķÜŠń£ŗÕć║ zńÜäµ”éńÄćÕłåÕĖāĶ¦äÕŠŗ’╝īĶ┐Öķćīķ£ĆĶ”üĶĮ¼µŹóµłÉń¤®ķśĄÕĮóÕ╝Å:

+$$ +z^2=z^{\mathrm{T}} z=\left[x_1-\mu_1, x_2-\mu_2, \cdots, x_n-\mu_n\right]\left[\begin{array}{cccc} +\frac{1}{\sigma_1^2} & 0 & \cdots & 0 \\ +0 & \frac{1}{\sigma_2^2} & \cdots & 0 \\ +\vdots & \cdots & \cdots & \vdots \\ +0 & 0 & \cdots & \frac{1}{\sigma_n^2} +\end{array}\right]\left[x_1-\mu_1, x_2-\mu_2, \cdots, x_n-\mu_n\right]^{\mathrm{T}} +$$ +

+ńŁēÕ╝ŵ»öĶŠāķĢ┐’╝īĶ«®µłæõ╗¼Ķ”üÕüÜõĖĆõĖŗÕÅśķćŵø┐µŹó:

+$$ +x-\mu_x=\left[x_1-\mu_1, x_2-\mu_2, \cdots, x_n-\mu_n\right]^{\mathrm{T}} +$$ +

+Õ«Üõ╣ēõĖĆõĖ¬ń¼”ÕÅĘ +$$ +\sum=\left[\begin{array}{cccc} +\sigma_1^2 & 0 & \cdots & 0 \\ +0 & \sigma_2^2 & \cdots & 0 \\ +\vdots & \cdots & \cdots & \vdots \\ +0 & 0 & \cdots & \sigma_n^2 +\end{array}\right] +$$ +

+$\sum$ õ╗ŻĶĪ©ÕÅśķćÅ $\mathrm{X}$ ńÜäÕŹÅµ¢╣ÕĘ«ń¤®ķśĄ’╝ī iĶĪījÕłŚńÜäÕģāń┤ĀÕĆ╝ĶĪ©ńż║ $x_i$ õĖÄ $x_j$ ńÜäÕŹÅµ¢╣ÕĘ« +ÕøĀõĖ║ńÄ░Õ£©ÕÅśķćÅõ╣ŗķŚ┤µś»ńøĖõ║Æńŗ¼ń½ŗńÜä’╝īµēĆõ╗źÕŬµ£ēÕ»╣Ķ¦Æń║┐õĖŖ $(i=j)$ ÕŁśÕ£©Õģāń┤Ā’╝īÕģČõ╗¢Õ£░µ¢╣ķāĮńŁēõ║Ä 0 ’╝īõĖö $x_i$ õĖÄÕ«āµ£¼Ķ║½ńÜäÕŹÅµ¢╣ÕĘ«Õ░▒ńŁēõ║ĵ¢╣ÕĘ«ŃĆé +

+

+$\sum$ µś»õĖĆõĖ¬Õ»╣Ķ¦ÆķśĄ’╝īµĀ╣µŹ«Õ»╣Ķ¦Æń¤®ķśĄńÜäµĆ¦Ķ┤©’╝īÕ«āńÜäķĆåń¤®ķśĄ:

+$$ +\left(\sum\right)^{-1}=\left[\begin{array}{cccc} +\frac{1}{\sigma_1^2} & 0 & \cdots & 0 \\ +0 & \frac{1}{\sigma_2^2} & \cdots & 0 \\ +\vdots & \cdots & \cdots & \vdots \\ +0 & 0 & \cdots & \frac{1}{\sigma_n^2} +\end{array}\right]. +$$ +

+Õ»╣Ķ¦Æń¤®ķśĄńÜäĶĪīÕłŚÕ╝Å $=$ Õ»╣Ķ¦ÆÕģāń┤ĀńÜäõ╣śń¦» +$$ +\sigma_z=\left|\sum\right|^{\frac{1}{2}}=\sigma_1 \sigma_2 \ldots \sigma_n +$$ +

+µø┐µŹóÕÅśķćÅõ╣ŗÕÉÄ’╝īńŁēÕ╝ÅÕÅ»õ╗źń«ĆÕī¢õĖ║: +$$ +z^{\mathrm{T}} z=\left(x-\mu_x\right)^{\mathrm{T}} \sum^{-1}\left(x-\mu_x\right) +$$ +

+õ╗ŻÕģźõ╗źzõĖ║Ķć¬ÕÅśķćÅńÜäµĀćÕćåķ½śµ¢»ÕłåÕĖāÕćĮµĢ░õĖŁ: +$$ +f(z)=\frac{1}{(\sqrt{2 \pi})^n \sigma_z} e^{-\frac{z^2}{2}}=\frac{1}{(\sqrt{2 \pi})^n \sum^{\frac{1}{2}}} e^{-\frac{\left(x-\mu_x\right)^T(\Gamma)^{-1}\left(x-\mu_x\right)}{2}} +$$ +

+µ│©µäÅÕēŹķØóńÜäń│╗µĢ░ÕÅśÕī¢: õ╗ÄķØ×µĀćÕćåµŁŻµĆüÕłåÕĖā $->$ µĀćÕćåµŁŻµĆüÕłåÕĖāķ£ĆĶ”üÕ░åµ”éńÄćÕ»åÕ║”ÕćĮµĢ░ńÜäķ½śÕ║”ÕÄŗń╝® $\left|\sum\right|^{\frac{1}{2}}$ ÕĆŹ’╝īõ╗ÄõĖĆń╗┤ $\rightarrow$ nń╗┤ńÜäĶ┐ć ń©ŗõĖŁ’╝īµ»ÅÕó×ÕŖĀõĖĆń╗┤’╝īķ½śÕ║”Õ░åÕÄŗń╝® $\sqrt{2 \pi}$ ÕĆŹ + +reference: +https://www.cnblogs.com/bingjianing/p/9117330.html + + +```python +from scipy.stats import multivariate_normal +x,y = np.mgrid[-1:1:.01,-1:1:.01]# ńö¤µłÉńĮæµĀ╝ńé╣,µŁźķĢ┐õĖ║0.01 +pos = np.dstack((x,y))# ńö¤µłÉńĮæµĀ╝ńé╣ÕØɵĀć,shape=(200,200,2) +sigma = [[2,0.3],[0.3,0.5]] # ÕŹÅµ¢╣ÕĘ«ń¤®ķśĄ +mu = [0.5,0.2] +X = multivariate_normal(mu,sigma)# ńö¤µłÉÕżÜÕģāµŁŻµĆüÕłåÕĖā +fig,axes = plt.subplots(1,1,figsize=(12,4)) +axes.contourf(x,y,X.pdf(pos))# ń╗śÕłČńŁēķ½śń║┐,posĶĪ©ńż║Õ£©ńĮæµĀ╝ńé╣õĖŖńÜäµ”éńÄćÕ»åÕ║” +``` + + + + +

+ķÖżõ║åńö©õ║ÄÕłåµ×ɵ│ŖµØŠĶ┐ćń©ŗÕż¢’╝īĶ┐śÕÅ»õ╗źÕ£©ÕģČõ╗¢ÕÉäń¦ŹńÄ»ÕóāõĖŁµēŠÕł░’╝īÕģȵ”éńÄćÕ»åÕ║”ÕćĮµĢ░õĖ║’╝Ü +

+$$ +p(x)=\left\{\begin{array}{c} +\frac{1}{\theta} e^{-\frac{x}{\theta}}, x>0 \\ +0, x \leq 0 +\end{array} \quad(\theta>0)\right. +$$ +

+ÕłÖń¦░ķÜŵ£║ÕÅśķćÅ$X$ µ£Źõ╗ÄÕÅéµĢ░õĖ║ $\theta$ ńÜäµīćµĢ░ÕłåÕĖā, Ķ«░õĖ║ $X \sim \operatorname{EXP}(\theta)$. +

+ÕģČõĖŁ $\lambda = \frac{1}{\theta}$ ń¦░õĖ║ńÄćÕÅéµĢ░’╝łrate parameter’╝ēŃĆé +

+ÕŹ│µ»ÅÕŹĢõĮŹµŚČķŚ┤ÕåģÕÅæńö¤µ¤Éõ║ŗõ╗ČńÜäµ¼ĪµĢ░’╝łµ»öµ¢╣Ķ»┤’╝ÜÕ”éµ×£õĮĀÕ╣│ÕØćµ»ÅõĖ¬Õ░ŵŚČµÄźÕł░2µ¼ĪńöĄĶ»Ø’╝īķéŻõ╣łõĮĀķóäµ£¤ńŁēÕŠģµ»ÅõĖƵ¼ĪńöĄĶ»ØńÜ䵌ČķŚ┤µś»ÕŹŖõĖ¬Õ░ŵŚČ’╝ēŃĆéµīćµĢ░ÕłåÕĖāńÜäµ£¤µ£øÕÆīµ¢╣ÕĘ«ÕłåÕł½õĖ║ $\theta$ ÕÆī $\theta^2$. + +µīćµĢ░ÕłåÕĖāńÜäń┤»Ķ«ĪÕłåÕĖāÕćĮµĢ░õĖ║’╝Ü

+$$ P(X \leq x) = 1 - e^{-\frac{x}{\theta}} $$ + + + +```python +from scipy.stats import expon +fig,axes = plt.subplots(1,2,figsize=(12,4)) +r = expon(scale=2)# ńö¤µłÉµīćµĢ░ÕłåÕĖā’╝īscale=2ĶĪ©ńż║╬╗=1/2 +plot_distribution(r,axes) + +``` + + + + + array([

+$$ p(x) = \frac{1}{2 \lambda} e^{ - \frac{|x - \mu|}{\lambda}} $$ + +ÕģČõĖŁ $\mu$ ń¦░õĖ║ÕłåÕĖāńÜäõĮŹńĮ«ÕÅéµĢ░’╝łlocation parameter’╝ē’╝ī$\lambda$ ń¦░õĖ║ÕłåÕĖāńÜäÕ░║Õ║”ÕÅéµĢ░’╝łscale parameter’╝ēŃĆéµŗēµÖ«µŗēµ¢»ÕłåÕĖāńÜäµ£¤µ£øÕÆīµ¢╣ÕĘ«ÕłåÕł½õĖ║ $\mu$ ÕÆī $2 \lambda^2$. + + +```python +from scipy.stats import laplace +fig,axes = plt.subplots(1,2,figsize=(12,4)) +mu,gamma = 0,1 # ÕØćÕĆ╝’╝īµĀćÕćåÕĘ« +r = laplace(loc=0,scale=1)# ńö¤µłÉµŗēµÖ«µŗēµ¢»ÕłåÕĖā +plot_distribution(r,axes) +``` + + + + + array([

+[µ£║ÕÖ©ÕŁ”õ╣ĀńÜäµĢ░ÕŁ”Õ¤║ńĪĆ’╝ł1’╝ē--DirichletÕłåÕĖā](https://blog.csdn.net/jwh_bupt/article/details/8841644) + + +BetaÕłåÕĖāÕ╝Åõ║īķĪ╣ÕłåÕĖāńÜäÕģ▒ĶĮŁÕģłķ¬īÕłåÕĖā. + +DirichletÕłåÕĖāµś»õĖĆõĖ¬ÕżÜń╗┤ńÜäµ”éńÄćÕłåÕĖā’╝īÕ«āµś»õĖĆń╗ä(ÕżÜÕģā’╝ēńŗ¼ń½ŗńÜä $\operatorname{Beta}$ ÕłåÕĖāńÜäÕģ▒ĶĮŁÕģłķ¬īÕłåÕĖāŃĆéÕ£©Ķ┤ØÕÅȵ¢»µÄ©µ¢Ł’╝łBayesian inference’╝ēõĖŁ’╝īńŗäÕł®ÕģŗķøĘÕłåÕĖāõĮ£õĖ║ÕżÜķĪ╣ÕłåÕĖāńÜäÕģ▒ĶĮŁÕģłķ¬īÕŠŚÕł░Õ║öńö©’╝īÕ£©µ£║ÕÖ©ÕŁ”õ╣Ā’╝łmachine learning’╝ēõĖŁĶó½ńö©õ║ĵ×äÕ╗║ńŗäÕł®ÕģŗķøʵĘĘÕÉłµ©ĪÕ×ŗ’╝łDirichlet mixture model’╝ēµś»õĖĆń▒╗Õ£©Õ«×µĢ░Õ¤¤õ╗źµŁŻÕŹĢń║»ÕĮó’╝łstandard simplex’╝ēõĖ║ µö»µÆæķøå’╝łsupport’╝ēńÜäķ½śń╗┤Ķ┐×ń╗Łµ”éńÄćÕłåÕĖā’╝īµś»BetaÕłåÕĖāÕ£©ķ½śń╗┤µāģÕĮóńÜäµÄ©Õ╣┐ŃĆé + +reference:

+[ńÉåĶ¦ŻGammaÕłåÕĖāŃĆüBetaÕłåÕĖāõĖÄDirichletÕłåÕĖā +](https://zhuanlan.zhihu.com/p/37976562) +

+[µ£ĆķĆÜõ┐ŚµśōµćéńÜäńÖĮĶ»ØńŗäÕł®ÕģŗķøĘĶ┐ćń©ŗ(Dirichlet Process’╝ē](https://zhuanlan.zhihu.com/p/76991275) + + + +### 2.1.6 ÕĖĖĶ¦üÕćĮµĢ░ńÜäµ£ēńö©µĆ¦Ķ┤© + +logisitc sigmoidÕćĮµĢ░ķĆÜÕĖĖńö©µØźõ║¦ńö¤õ╝»ÕŖ¬Õł®ÕłåÕĖāńÜäµ”éńÄć’╝īÕøĀõĖ║Õ«āńÜäĶīāÕø┤µś» (0, 1)’╝īÕøĀµŁżÕ«āńÜäÕ»╝µĢ░µś»õ╝»ÕŖ¬Õł®ÕłåÕĖāńÜäµ”éńÄćÕ»åÕ║”ÕćĮµĢ░ŃĆésigmoid ÕćĮµĢ░Õ£©ÕÅśķćÅÕÅ¢ń╗ØÕ»╣ÕĆ╝ŌŠ«ÕĖĖŌ╝żńÜ䵣ŻÕĆ╝µł¢Ķ┤¤ÕĆ╝µŚČõ╝ÜÕć║ńÄ░ķź▒ÕÆī (Saturate)ńÄ░Ķ▒Ī’╝īµäÅÕæ│ńØĆÕćĮµĢ░õ╝ÜÕÅśÕŠŚÕŠłÕ╣│’╝īÕ╣ČõĖöÕ»╣ĶŠōŌ╝ŖńÜäÕŠ«Ō╝®µö╣ÕÅśõ╝ÜÕÅśÕŠŚõĖŹµĢŵä¤ŃĆé

+$$ sigmoid(x) = \frac{1}{1+e^{-x}} $$ + +softplusÕćĮµĢ░

+$$ softplus(x) = \log(1+e^x) $$ + +ÕøĀõĖ║Õ«āńÜäĶīāÕø┤µś» (0, Ōł×)’╝īsoftplusÕćĮµĢ░ÕÅ»õ╗źńö©µØźõ║¦ńö¤µŁŻÕż¬ÕłåÕĖāńÜä$\beta$ÕÆī$\sigma$ÕÅéµĢ░’╝īÕøĀµŁżÕ«āńÜäÕ»╝µĢ░µś»µŁŻÕż¬ÕłåÕĖāńÜäµ”éńÄćÕ»åÕ║”ÕćĮµĢ░ŃĆé +softplusÕćĮµĢ░ÕÉŹń¦░µØźµ║Éõ║ÄÕ«āµś»õĖĆõĖ¬Õ╣│µ╗æńÜäReLUÕćĮµĢ░’╝īReLUÕćĮµĢ░µś»õĖĆõĖ¬ķØ×ń║┐µĆ¦ÕćĮµĢ░’╝īÕ«āńÜäÕ«Üõ╣ēµś» +$$ ReLU(x) = max(0, x) $$ + + + +```python +x = np.linspace(-10,10,1000) +sigmoid = 1/(1+np.exp(-x)) +softplus = np.log(1+np.exp(x)) +fig,axes = plt.subplots(1,2,figsize=(12,4)) +axes[0].plot(x,sigmoid) +axes[0].set_title('Sigmoid') +axes[1].plot(x,softplus) +axes[1].set_title('Softplus') + +``` + + + + + Text(0.5, 1.0, 'Softplus') + + + + + + + +## 2.2 õ┐Īµü»Ķ«║ +õ┐Īµü»Ķ«║ĶāīÕÉÄńÜäµĆصā│’╝ÜõĖĆõ╗ČõĖŹÕż¬ÕÅ»ĶāĮńÜäõ║ŗõ╗ȵ»öõĖĆõ╗ȵ»öĶŠāÕÅ»ĶāĮńÜäõ║ŗõ╗ȵø┤µ£ēõ┐Īµü»ķćÅŃĆé’╝łõ┐Īµü»ķćÅńÜäÕ║”ķćÅÕ░▒ńŁēõ║ÄõĖŹńĪ«Õ«ÜµĆ¦ńÜäÕżÜÕ░æŃĆé’╝ē

+õ┐Īµü» (Information) ķ£ĆĶ”üµ╗ĪŌŠ£ńÜäõĖēõĖ¬µØĪõ╗Č’╝Ü +* ŌĮÉĶŠāÕÅ»ĶāĮÕÅæŌĮŻńÜäõ║ŗõ╗ČńÜäõ┐Īµü»ķćÅĶ”üÕ░æ +* ŌĮÉĶŠāõĖŹÕÅ»ĶāĮÕÅæŌĮŻńÜäõ║ŗõ╗ČńÜäõ┐Īµü»ķćÅĶ”üŌ╝ż +* ńŗ¼ŌĮ┤ÕÅæŌĮŻńÜäõ║ŗõ╗Čõ╣ŗķŚ┤ńÜäõ┐Īµü»ķćÅÕ║öĶ»źµś»ÕÅ»õ╗źÕÅĀÕŖĀńÜäŃĆéõŠŗÕ”é’╝īµŖĢµÄĘńÜäńĪ¼ÕĖüõĖżµ¼ĪµŁŻŌŠ»µ£ØõĖŖõ╝ĀķĆÆńÜäõ┐Īµü»ķćÅ’╝īÕ║öĶ»źµś»µŖĢµÄĘŌ╝Ƶ¼ĪńĪ¼ÕĖüµŁŻŌŠ»µ£ØõĖŖńÜäõ┐Īµü»ķćÅńÜäõĖżÕĆŹ + +Ķć¬õ┐Īµü» (Self-information) µś»õ┐Īµü»Ķ«║õĖŁńÜäÕ¤║µ£¼µ”éÕ┐Ą’╝īÕ«āµś»µīćÕŹĢõĖ¬õ║ŗõ╗ČÕÅæŌĮŻńÜäõ┐Īµü»ķćÅŃĆéĶć¬õ┐Īµü»ńÜäÕ«Üõ╣ēµś»

+$$ I(x) = -\log P(x) $$ + +ķ”ÖÕå£ńåĄ (Shannon Entropy)µś»Õ»╣õ║ĵĢ┤õĖ¬µ”éĶ«║ÕłåÕĖāP’╝īķÜŵ£║ÕÅśķćÅńÜäõĖŹńĪ«Õ«ÜµĆ¦ńÜäĶĪĪķćÅ’╝Ü

+$$ H(P) = -’╝ł p_1 * \log p_1 + p_2 * \log p_2 + \cdots + p_n * \log p_n) =-\sum_{x}P(x)\log P(x) $$ + +ĶüöÕÉłńåĄ (Joint Entropy) µś»Õ»╣õ║ÄõĖżõĖ¬ķÜŵ£║ÕÅśķćÅXÕÆīY’╝īÕ«āõ╗¼ńÜäĶüöÕÉłÕłåÕĖāP(X, Y)’╝īķÜŵ£║ÕÅśķćÅńÜäõĖŹńĪ«Õ«ÜµĆ¦ńÜäĶĪĪķćÅ’╝Ü

+$$ H(X, Y) = -\sum_{x,y}P(x, y)\log P(x, y) $$ + +µØĪõ╗ČńåĄ (Conditional Entropy) µś»Õ»╣õ║ÄõĖżõĖ¬ķÜŵ£║ÕÅśķćÅXÕÆīY’╝īÕ«āõ╗¼ńÜäĶüöÕÉłÕłåÕĖāP(X, Y)’╝īķÜŵ£║ÕÅśķćÅńÜäõĖŹńĪ«Õ«ÜµĆ¦ńÜäĶĪĪķćÅ’╝Ü

+$$ H(Y|X) = -\sum_{x,y}P(x, y)\log P(y|x) $$ + +õ║Æõ┐Īµü» (Mutual Information) ĶĪ©ńż║õĖżõĖ¬õ┐Īµü»ńøĖõ║żńÜäķā©Õłå’╝Ü

+$$ I(X;Y) = H(X)+H(Y) - H(X,Y) $$ + +õ┐Īµü»ÕÅśÕĘ«(Variation of Information) ĶĪ©ńż║õĖżõĖ¬õ║ŗõ╗ČńÜäõ┐Īµü»õĖŹµā│õ║żńÜäķā©Õłå’╝Ü

+$$ VI(X;Y) = H(X)+H(Y) - 2I(X;Y) $$ + + +```python +p = np.linspace(1e-6,1-1e-6,1000) # ńö¤µłÉµ”éńÄć +entropy = -p*np.log(p)-(1-p)*np.log(1-p) # ķ”ÖÕå£ńåĄ (Shannon Entropy) +plt.figure(figsize=(4,4)) +plt.plot(p,entropy) +plt.title('Shannon Entropy') + +``` + + + + + Text(0.5, 1.0, 'Shannon Entropy') + + + + + + + +õ┐Īµü»Õó×ńøŖ’╝łKullbackŌĆōLeibler divergence’╝ēÕÅłń¦░information divergence’╝īinformation gain’╝īrelative entropy µł¢ĶĆģKLICŃĆé +Õ£©µ”éńÄćĶ«║ÕÆīõ┐Īµü»Ķ«║õĖŁ’╝īõ┐Īµü»Õó×ńøŖµś»ķØ×Õ»╣ń¦░ńÜä’╝īńö©õ╗źÕ║”ķćÅõĖżń¦Źµ”éńÄćÕłåÕĖāPÕÆīQńÜäÕĘ«Õ╝éŃĆé

+$$ D_{KL}(P||Q) = \sum_{x}P(x)\log \frac{P(x)}{Q(x)} $$ + +õ║żÕÅēńåĄ (Cross Entropy) ÕüćĶ«ŠPµś»ń£¤Õ«×ńÜäÕłåÕĖā’╝īQµś»ķó䵥ŗńÜäÕłåÕĖā’╝īķéŻõ╣łõ║żÕÅēńåĄÕ░▒µś»ń£¤Õ«×ÕłåÕĖāÕÆīķó䵥ŗÕłåÕĖāõ╣ŗķŚ┤ńÜäĶĘØń”╗’╝Ü

+$$ H(P, Q) = H(P) + D_{KL}(P||Q) = -\sum_{x}P(x)\log Q(x) $$ + + +```python +# D_{KL}(P||Q) õĖÄD_{KL}(Q||P)µ»öĶŠā +x = np.linspace(1,8,500) +y1 = norm.pdf(x,loc =3,scale = 0.5) # loc=3,scale=0.5ĶĪ©ńż║ÕØćÕĆ╝õĖ║3’╝īµĀćÕćåÕĘ«õĖ║0.5 +y2 = norm.pdf(x,loc =6,scale = 0.5) +p = y1+y2 #µ×äķĆĀp(x) +KL_pq ,KL_qp = [],[] +q_list = [] +for mu in np.linspace(0,10,50): + for sigma in np.linspace(0.1,1,50): # ńö¤µłÉ50*50õĖ¬q(x),Õ»╗µēŠµ£Ćõ╝śq(x) + q = norm.pdf(x,loc =mu,scale = sigma) # µ×äķĆĀq(x) + q_list.append(q) + KL_pq.append(np.sum(p*np.log(p/q))) # D_{KL}(P||Q) + KL_qp.append(np.sum(q*np.log(q/p))) # D_{KL}(Q||P) +# min +min_KL_pq = np.argmin(KL_pq) # µ£ĆÕ░ÅÕĆ╝ńÜäń┤óÕ╝Ģ +min_KL_qp = np.argmin(KL_qp) + +fig,axes = plt.subplots(1,2,figsize=(12,4)) +axes[0].set_ylim(0,0.8) +axes[0].plot(x,p/2,'b',label='p(x)') +axes[0].plot(x,q_list[min_KL_pq],'r',label='$q^*(x)$') +axes[0].set_title('min D_{KL}(P||Q) ') +axes[0].set_xlabel('x') +axes[0].set_ylabel('p(x)') + +axes[1].set_ylim(0,0.8) +axes[1].plot(x,p/2,'b',label='p(x)') +axes[1].plot(x,q_list[min_KL_qp],'r',label='$q^*(x)$') +axes[1].set_title('min D_{KL}(Q||P)') +axes[1].set_xlabel('x') +axes[1].set_ylabel('p(x)') +``` + +

+$$ IG(X;Y) = H(Y) - H(Y|X) $$ + + +```python +import numpy as np +import pandas as pd +from math import log + +def create_data(): + datasets = [['ķØÆÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'õĖĆĶł¼', 'ÕÉ”'], + ['ķØÆÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'ÕźĮ', 'ÕÉ”'], + ['ķØÆÕ╣┤', 'µś»', 'ÕÉ”', 'ÕźĮ', 'µś»'], + ['ķØÆÕ╣┤', 'µś»', 'µś»', 'õĖĆĶł¼', 'µś»'], + ['ķØÆÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'õĖĆĶł¼', 'ÕÉ”'], + ['õĖŁÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'õĖĆĶł¼', 'ÕÉ”'], + ['õĖŁÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'ÕźĮ', 'ÕÉ”'], + ['õĖŁÕ╣┤', 'µś»', 'µś»', 'ÕźĮ', 'µś»'], + ['õĖŁÕ╣┤', 'ÕÉ”', 'µś»', 'ķØ×ÕĖĖÕźĮ', 'µś»'], + ['õĖŁÕ╣┤', 'ÕÉ”', 'µś»', 'ķØ×ÕĖĖÕźĮ', 'µś»'], + ['ĶĆüÕ╣┤', 'ÕÉ”', 'µś»', 'ķØ×ÕĖĖÕźĮ', 'µś»'], + ['ĶĆüÕ╣┤', 'ÕÉ”', 'µś»', 'ÕźĮ', 'µś»'], + ['ĶĆüÕ╣┤', 'µś»', 'ÕÉ”', 'ÕźĮ', 'µś»'], + ['ĶĆüÕ╣┤', 'µś»', 'ÕÉ”', 'ķØ×ÕĖĖÕźĮ', 'µś»'], + ['ĶĆüÕ╣┤', 'ÕÉ”', 'ÕÉ”', 'õĖĆĶł¼', 'ÕÉ”'], + ] + labels = [u'Õ╣┤ķŠä', u'µ£ēÕĘźõĮ£', u'µ£ēĶć¬ÕĘ▒ńÜ䵳┐ÕŁÉ', u'õ┐ĪĶ┤ʵāģÕåĄ', u'ń▒╗Õł½'] + # Ķ┐öÕø×µĢ░µŹ«ķøåÕÆīµ»ÅõĖ¬ń╗┤Õ║”ńÜäÕÉŹń¦░ + return datasets, labels + + +# ńåĄ +def calc_ent(datasets): + data_length = len(datasets) + label_count = {} + for i in range(data_length): + label = datasets[i][-1] + if label not in label_count: + label_count[label] = 0 + label_count[label] += 1 + ent = -sum([(p / data_length) * log(p / data_length, 2) for p in label_count.values()]) + return ent + + +# ń╗Åķ¬īµØĪõ╗ČńåĄ +def cond_ent(datasets, axis=0): + data_length = len(datasets) + feature_sets = {} + for i in range(data_length): + feature = datasets[i][axis] + if feature not in feature_sets: + feature_sets[feature] = [] + feature_sets[feature].append(datasets[i]) + cond_ent = sum([(len(p) / data_length) * calc_ent(p) for p in feature_sets.values()]) + return cond_ent + + +# õ┐Īµü»Õó×ńøŖ +def info_gain(ent, cond_ent): + return ent - cond_ent + + +def info_gain_train(datasets): + count = len(datasets[0]) - 1 + ent = calc_ent(datasets) + best_feature = [] + for c in range(count): + c_info_gain = info_gain(ent, cond_ent(datasets, axis=c)) + best_feature.append((c, c_info_gain)) + print('ńē╣ÕŠü({}) - info_gain - {:.3f}'.format(labels[c], c_info_gain)) + # µ»öĶŠāÕż¦Õ░Å + best_ = max(best_feature, key=lambda x: x[-1]) + return 'ńē╣ÕŠü({})ńÜäõ┐Īµü»Õó×ńøŖµ£ĆÕż¦’╝īķĆēµŗ®õĖ║µĀ╣ĶŖéńé╣ńē╣ÕŠü'.format(labels[best_[0]]) + +datasets, labels = create_data() +train_data = pd.DataFrame(datasets, columns=labels) +print(train_data) +print('ńē╣ÕŠüõ┐Īµü»Õó×ńøŖõĖ║’╝Ü', info_gain_train(np.array(datasets))) +``` + + Õ╣┤ķŠä µ£ēÕĘźõĮ£ µ£ēĶć¬ÕĘ▒ńÜ䵳┐ÕŁÉ õ┐ĪĶ┤ʵāģÕåĄ ń▒╗Õł½ + 0 ķØÆÕ╣┤ ÕÉ” ÕÉ” õĖĆĶł¼ ÕÉ” + 1 ķØÆÕ╣┤ ÕÉ” ÕÉ” ÕźĮ ÕÉ” + 2 ķØÆÕ╣┤ µś» ÕÉ” ÕźĮ µś» + 3 ķØÆÕ╣┤ µś» µś» õĖĆĶł¼ µś» + 4 ķØÆÕ╣┤ ÕÉ” ÕÉ” õĖĆĶł¼ ÕÉ” + 5 õĖŁÕ╣┤ ÕÉ” ÕÉ” õĖĆĶł¼ ÕÉ” + 6 õĖŁÕ╣┤ ÕÉ” ÕÉ” ÕźĮ ÕÉ” + 7 õĖŁÕ╣┤ µś» µś» ÕźĮ µś» + 8 õĖŁÕ╣┤ ÕÉ” µś» ķØ×ÕĖĖÕźĮ µś» + 9 õĖŁÕ╣┤ ÕÉ” µś» ķØ×ÕĖĖÕźĮ µś» + 10 ĶĆüÕ╣┤ ÕÉ” µś» ķØ×ÕĖĖÕźĮ µś» + 11 ĶĆüÕ╣┤ ÕÉ” µś» ÕźĮ µś» + 12 ĶĆüÕ╣┤ µś» ÕÉ” ÕźĮ µś» + 13 ĶĆüÕ╣┤ µś» ÕÉ” ķØ×ÕĖĖÕźĮ µś» + 14 ĶĆüÕ╣┤ ÕÉ” ÕÉ” õĖĆĶł¼ ÕÉ” + ńē╣ÕŠü(Õ╣┤ķŠä) - info_gain - 0.083 + ńē╣ÕŠü(µ£ēÕĘźõĮ£) - info_gain - 0.324 + ńē╣ÕŠü(µ£ēĶć¬ÕĘ▒ńÜ䵳┐ÕŁÉ) - info_gain - 0.420 + ńē╣ÕŠü(õ┐ĪĶ┤ʵāģÕåĄ) - info_gain - 0.363 + ńē╣ÕŠüõ┐Īµü»Õó×ńøŖõĖ║’╝Ü ńē╣ÕŠü(µ£ēĶć¬ÕĘ▒ńÜ䵳┐ÕŁÉ)ńÜäõ┐Īµü»Õó×ńøŖµ£ĆÕż¦’╝īķĆēµŗ®õĖ║µĀ╣ĶŖéńé╣ńē╣ÕŠü + + +## 2.3 ÕøŠµ©ĪÕ×ŗ +ÕøŠµ©ĪÕ×ŗ’╝łGraphical Model)µś»õĖĆń¦ŹĶĪ©ńż║µ”éńÄćÕłåÕĖāńÜäµ¢╣µ│Ģ’╝īÕ«āÕ░åµ”éńÄćÕłåÕĖāĶĪ©ńż║õĖ║õĖĆõĖ¬ÕøŠ’╝īÕøŠõĖŁńÜäĶŖéńé╣ĶĪ©ńż║ķÜŵ£║ÕÅśķćÅ’╝īĶŖéńé╣õ╣ŗķŚ┤ńÜäĶŠ╣ĶĪ©ńż║ķÜŵ£║ÕÅśķćÅõ╣ŗķŚ┤ńÜäõŠØĶĄ¢Õģ│ń│╗ŃĆé + +### 2.3.1 µ£ēÕÉæÕøŠµ©ĪÕ×ŗ directed graphical model + +µ£ēÕÉæÕøŠµ©ĪÕ×ŗµś»µīćÕøŠõĖŁńÜäĶŠ╣µś»µ£ēÕÉæńÜä’╝īÕŹ│ĶŠ╣ńÜäµ¢╣ÕÉæĶĪ©ńż║õ║åķÜŵ£║ÕÅśķćÅõ╣ŗķŚ┤ńÜäõŠØĶĄ¢Õģ│ń│╗ŃĆéµ£ēÕÉæÕøŠµ©ĪÕ×ŗÕÅ»õ╗źĶĪ©ńż║µØĪõ╗ȵ”éńÄćÕłåÕĖā(CPD)’╝īõ╣¤ÕÅ»õ╗źĶĪ©ńż║ķ®¼Õ░öń¦æÕż½ķÜŵ£║Õ£║ŃĆé + +µ£ēÕÉæÕøŠńÜäõ╗ŻĶĪ©µś»Ķ┤ØÕÅȵ¢»ńĮæŃĆé +Ķ┤ØÕÅȵ¢»ŌĮ╣õĖĵ£┤ń┤ĀĶ┤ØÕÅȵ¢»µ©ĪÕ×ŗÕ╗║ŌĮ┤Õ£©ńøĖÕÉīńÜäńø┤Ķ¦éÕüćĶ«ŠõĖŖ’╝ÜķĆÜĶ┐ćÕł®ńö©ÕłåÕĖāńÜäµØĪõ╗Čńŗ¼ń½ŗµĆ¦µØźĶÄĘÕŠŚń┤¦ÕćæĶĆīĶć¬ńäČńÜäĶĪ©ńż║ŃĆéĶ┤ØÕÅȵ¢»ŌĮ╣µĀĖŌ╝╝µś»Ō╝ĆõĖ¬µ£ēÕÉæŌĮåńÄ»ÕøŠ(DAG)’╝īÕģČĶŖéńé╣õĖ║Ķ«║Õ¤¤õĖŁńÜäķÜŵ£║ÕÅśķćÅ’╝īĶŖéńé╣ķŚ┤ńÜäµ£ēÕÉæń«ŁÕż┤ĶĪ©ŌĮ░Ķ┐ÖõĖżõĖ¬ĶŖéńé╣ńÜäõŠØĶĄ¢Õģ│ń│╗ŃĆé + + + +µ£ēÕÉæŌĮåńÄ»ÕøŠÕÅ»õ╗źńö▒Õ”éõĖŗ 3 ń¦ŹÕģāń╗ōµ×äµ×䵳ɒ╝Ü +* ÕÉīŌĮŚń╗ōµ×ä +* V Õ×ŗń╗ōµ×ä +* ķĪ║Õ║Åń╗ōµ×ä + + +Ķ┤ØÕÅȵ¢»ńĮæńÜäńŗ¼ń½ŗµĆ¦ +* Õ▒Ćķā©ńŗ¼ń½ŗµĆ¦ +* Õģ©Õ▒Ćńŗ¼ń½ŗµĆ¦ + * tail-to-tail + * head-to-tail + * head-to-head + ĶĆāĶÖæÕżŹµØéńÜäµ£ēÕÉæµŚĀńÄ»ÕøŠ’╝īÕ”éµ×£A,B,Cµś»õĖēõĖ¬ķøåÕÉł’╝īÕÅ»õ╗źµś»ÕŹĢńŗ¼ńÜäĶŖéńé╣µł¢ĶĆģĶŖéńé╣ńÜäķøåÕÉłŃĆéõĖ║õ║åÕłżµ¢ŁAÕÆīBµś»ÕÉ”µŚČCµØĪõ╗Čńŗ¼ń½ŗńÜä’╝īµłæõ╗¼ÕÅ»õ╗źĶĆāĶÖæAÕÆīBõ╣ŗķŚ┤ńÜäµēƵ£ēĶĘ»ÕŠäŃĆéÕ»╣õ║ÄÕģČõĖŁńÜäõĖƵØĪĶĘ»ÕŠä’╝īÕ”éµ×£µ╗ĪĶČ│õ╗źõĖŗõĖżńé╣ńÜäõ╗╗µäÅõĖĆńé╣’╝īķéŻõ╣łÕ░▒Ķ»┤Ķ┐ÖµØĪĶĘ»ÕŠäµś»ķś╗ÕĪ×’╝łblocked’╝ēńÜä’╝Ü + 1. ĶĘ»ÕŠäõĖŁÕŁśÕ£©µ¤ÉõĖ¬ĶŖéńé╣ X µś» head-to-tail µł¢ĶĆģ tail-to-tail ĶŖéńé╣’╝īÕ╣ČõĖö X µś»ÕīģÕɽգ© C õĖŁńÜä’╝ø + 2. ĶĘ»ÕŠäõĖŁÕŁśÕ£©µ¤ÉõĖ¬ĶŖéńé╣ X µś» head-to-head ĶŖéńé╣’╝īÕ╣ČõĖö X µł¢ X ńÜäŌ╝ēŌ╝”µś»õĖŹÕīģÕɽգ© C õĖŁńÜäŃĆé + + Õ”éµ×£ A,B ķŚ┤µēƵ£ēńÜäĶĘ»ÕŠäķāĮµś»ķś╗ÕĪ×ńÜä’╝īķéŻõ╣ł A,B Õ░▒µś»Õģ│õ║Ä C µØĪõ╗Čńŗ¼ŌĮ┤ńÜä’╝øÕÉ”ÕłÖ A,B õĖŹµś»Õģ│õ║Ä C µØĪõ╗Čńŗ¼ŌĮ┤ńÜäŃĆé + + + + + + + +```python +import networkx as nx +from pgmpy.models import BayesianModel +from pgmpy.factors.discrete import TabularCPD +import matplotlib.pyplot as plt +%matplotlib inline + +# Õ╗║ń½ŗõĖĆõĖ¬ń«ĆÕŹĢĶ┤ØÕÅȵ¢»µ©ĪÕ×ŗµĪåµ×Č +model = BayesianModel([('a', 'b'), ('a', 'c'), ('b', 'c'), ('b', 'd'), ('c', 'e')]) +# µ£ĆķĪČÕ▒éńÜäńłČĶŖéńé╣ńÜäµ”éńÄćÕłåÕĖāĶĪ© +cpd_a = TabularCPD(variable='a', variable_card=2, values=[[0.6, 0.4]]) # a: (0,1) + +# ÕģČÕ«āÕÉäĶŖéńé╣ńÜäµØĪõ╗ȵ”éńÄćÕłåÕĖāĶĪ©’╝łĶĪīÕ»╣Õ║öÕĮōÕēŹĶŖéńé╣ń┤óÕ╝Ģ’╝īÕłŚÕ»╣Õ║öńłČĶŖéńé╣ń┤óÕ╝Ģ’╝ē +cpd_b = TabularCPD(variable='b', variable_card=2, # b: (0,1) +values=[[0.75, 0.1], +[0.25, 0.9]], +evidence=['a'], +evidence_card=[2]) +cpd_c = TabularCPD(variable='c', variable_card=3, # c: (0,1,2) +values=[[0.3, 0.05, 0.9, 0.5], +[0.4, 0.25, 0.08, 0.3], +[0.3, 0.7, 0.02, 0.2]], +evidence=['a', 'b'], +evidence_card=[2, 2]) +cpd_d = TabularCPD(variable='d', variable_card=2, # d: (0,1) +values=[[0.95, 0.2], +[0.05, 0.8]], +evidence=['b'], +evidence_card=[2]) +cpd_e = TabularCPD(variable='e', variable_card=2, # e: (0,1) +values=[[0.1, 0.4, 0.99], +[0.9, 0.6, 0.01]], +evidence=['c'], +evidence_card=[3]) + +# Õ░åÕÉäĶŖéńé╣ńÜäµ”éńÄćÕłåÕĖāĶĪ©ÕŖĀÕģźńĮæń╗£ +model.add_cpds(cpd_a, cpd_b, cpd_c, cpd_d, cpd_e) +# ķ¬īĶ»üµ©ĪÕ×ŗµĢ░µŹ«ńÜ䵣ŻńĪ«µĆ¦ +print(u"ķ¬īĶ»üµ©ĪÕ×ŗµĢ░µŹ«ńÜ䵣ŻńĪ«µĆ¦:",model.check_model()) +# ń╗śÕłČĶ┤ØÕÅȵ¢»ÕøŠ (ĶŖéńé╣ + õŠØĶĄ¢Õģ│ń│╗) +nx.draw(model, with_labels=True, node_size=1000, font_weight='bold', node_color='y', \ +pos={"e":[4,3],"c":[4,5],"d":[8,5],"a":[2,7],"b":[6,7]}) +plt.text(2,7,model.get_cpds("a"), fontsize=10, color='b') +plt.text(5,6,model.get_cpds("b"), fontsize=10, color='b') +plt.text(1,4,model.get_cpds("c"), fontsize=10, color='b') +plt.text(4.2,2,model.get_cpds("e"), fontsize=10, color='b') +plt.text(7,3.4,model.get_cpds("d"), fontsize=10, color='b') + +plt.show() +``` + + + --------------------------------------------------------------------------- + + ModuleNotFoundError Traceback (most recent call last) + +

+pytest-ordering: µĄŗĶ»ĢķĪ║Õ║ÅµÄ¦ÕłČ +

+pytest-xdist: ÕłåÕĖāÕ╝ŵĄŗĶ»Ģ +

+pytest-cov: ńö¤µłÉµĄŗĶ»ĢĶ”åńø¢ńÄćµŖźÕæŖ +

+pytest-rerunfailures: Õż▒Ķ┤źķćŹĶ»Ģ +

+pytest-timeout: ĶČģµŚČµĄŗĶ»Ģ’╝īÕģüĶ«ĖÕ£©ÕæĮõ╗żĶĪīµīćÕ«ÜĶČģµŚČµŚČķŚ┤’╝īµł¢ĶĆģńø┤µÄźÕ£©µĄŗĶ»Ģõ╗ŻńĀüõĖŁµĀćµ│©ĶČģµŚČµŚČķŚ┤ŃĆé +

+pytest-repeat: ķćŹÕżŹµĄŗĶ»Ģ(ÕÅ»õ╗źõĮ┐ńö©--countÕÅéµĢ░µīćÕ«ÜķćŹÕżŹµ¼ĪµĢ░) +

+pytest-instafail: µĄŗĶ»ĢÕż▒Ķ┤źµŚČń½ŗÕŹ│Õü£µŁó’╝īµ¤źń£ŗķöÖĶ»»ńÜäĶ»”ń╗åõ┐Īµü»ŃĆé +

+pytest-sugar: õ╝śÕī¢µĄŗĶ»ĢµŖźÕæŖ,µśŠńż║Ķē▓ÕĮ®ÕÆīĶ┐øÕ║”µØĪ +

+pytest-html: õĖ║µĄŗĶ»Ģńö¤µłÉHTMLµŖźÕæŖ +```shell +pytest --html=report.html +``` +

+ +**ķØÖµĆüÕłåµ×Éńö©ńÜäµÅÆõ╗Č** + +pytest-pycodestyle: + +

+pytest-pep8: µŻĆµĄŗõ╗ŻńĀüµś»ÕÉ”ń¼”ÕÉł PEP8 Ķ¦äĶīā +

+pytest-flakes: µŻĆµĄŗõ╗ŻńĀüķŻÄµĀ╝ + +

+ +WebÕ╝ĆÕÅæńö©ńÜäµÅÆõ╗Č’╝Ü +WebķĪ╣ńø«µ£ēńē╣Õ«ÜńÜ䵥ŗĶ»ĢķĆ╗ĶŠæ’╝īpytestõ╣¤õĖŹĶāĮĶ«®µĄŗĶ»ĢÕÅśń«ĆÕŹĢ’╝īõĮåµś»µ£ēÕćĀõĖ¬µÅÆõ╗ČÕÅ»õ╗źÕĖ«Õ┐ÖŃĆé +

+pytest-django: ńö©õ║ĵĄŗĶ»Ģ Django ķĪ╣ńø«’╝īDjangoµś»ÕŠłµĄüĶĪīńÜäÕ¤║õ║ÄPythonńÜäwebÕ╝ĆÕÅæµĪåµ×Č’╝īÕ«āµ£¼Ķ║½ÕīģÕɽńö©õ║ĵĄŗĶ»ĢńÜähookÕćĮµĢ░’╝īÕģüĶ«ĖµĄŗĶ»ĢDjangoÕ║öńö©ńÜäÕÉäõĖ¬ń╗äõ╗Č’╝īDjangoµĄŗĶ»ĢõĮ┐ńö©ńÜ䵜»unittest’╝ø +

+pytest-selenium:ÕƤÕŖ®µĄÅĶ¦łÕÖ©Õ«īµłÉĶć¬ÕŖ©Õī¢µĄŗĶ»Ģ’╝īµ»öÕ”éĶ»┤ÕÉ»ÕŖ©õĖĆõĖ¬webµĄÅĶ¦łÕÖ©’╝īµēōÕ╝ĆńĮæÕØĆURL’╝īĶ┐ÉĶĪīwebÕ║öńö©’╝ø +

+pytest-flask’╝ܵĄŗĶ»ĢFlaskÕ║öńö©’╝īFlaskµś»õĖĆõĖ¬ĶĮ╗ķćÅń║¦ńÜäwebµĪåµ×Č,pytest-flaskµÅÆõ╗ȵÅÉõŠøõ║åõĖĆń╗äÕŠłµ£ēńö©ńÜäfixtureµØźÕĖ«ÕŖ®FlaskÕ║öńö©’╝ø + + + + + + + + diff --git "a/_posts/2022-12-28-pytest\346\265\213\350\257\225\345\256\236\346\210\230.md" "b/_posts/2022-12-28-pytest\346\265\213\350\257\225\345\256\236\346\210\230.md" new file mode 100644 index 0000000000..5b7cff572a --- /dev/null +++ "b/_posts/2022-12-28-pytest\346\265\213\350\257\225\345\256\236\346\210\230.md" @@ -0,0 +1,32 @@ +--- +layout: post +title: "pytestµĄŗĶ»ĢÕ«×µłś" +date: 2022-12-28 +description: "õ╗ŗń╗ŹpytestÕ«ēĶŻģTasksķĪ╣ńø«ńö©õ║ÄńÜ«õĖŗµĄŗĶ»Ģ’╝īpytestńÜ䵥ŗĶ»Ģńö©õŠŗ’╝īõ╗źÕÅŖõĮ┐ńö©ÕżÜń¦ŹµÅÆõ╗ČķģŹÕÉłĶ┐øĶĪīµĄŗĶ»ĢńÜ䵥üń©ŗŃĆé" +tag: Ķć¬ÕŖ©Õī¢µĄŗĶ»Ģ +--- + +## ĶĮ»õ╗ȵĄŗĶ»Ģµś»õ╗Ćõ╣ł +ĶĮ»õ╗ȵĄŗĶ»ĢńÜäõĖĆõĖ¬ńø«ńÜ䵜»ķ¬īĶ»üõĮĀńÜäńī£µā│-ńī£µā│ĶĮ»õ╗ČńÜäÕåģķā©ķĆ╗ĶŠæ’╝īÕīģµŗ¼ń¼¼õĖēµ¢╣ńÜ䵩ĪÕØŚŃĆüõ╗ŻńĀüÕīģŃĆéńöÜĶć│PythonńÜäÕåģÕ╗║ńÜäµĢ░µŹ«ń╗ōµ×䵜»Õ”éõĮĢĶ┐ÉĶĪīńÜäŃĆéTasksķĪ╣ńø«õĮ┐ńö©ÕÉŹõĖ║TaskńÜäµĢ░µŹ«ń╗ōµ×ä’╝īÕ«āµś»ńö©namedtupleÕĘźÕÄéÕćĮµĢ░ńö¤µłÉńÜäŃĆéTaskńö©õ║ÄÕ£©UIÕ▒éÕÆīAPIÕ▒éõ╣ŗķŚ┤õ╝ĀķĆÆõ┐Īµü»ŃĆé +```python +from collections import namedtuple +Task = namedtuple('Task', ['summary', 'owner', 'done', 'id']) +# õĮ┐ńö©_new_.defaults_ÕłøÕ╗║õĖĆõĖ¬ķ╗śĶ«żńÜäTaskÕ«×õŠŗ +Task.__new__.__defaults__ = (None, None, False, None) +``` +Ķ┐ÉĶĪīpytestµŚČÕÅ»õ╗źµīćÕ«Üńø«ÕĮĢÕÆīµ¢ćõ╗ČŃĆéÕ”éµ×£õĖŹµīćÕ«Ü’╝īõ╝ܵɣń┤óÕĮōÕēŹńø«ÕĮĢõ╗źÕÅŖÕģČÕŁÉńø«ÕĮĢõĖŁõ╗źtest_Õ╝ĆÕż┤µł¢ĶĆģÕĘ▓_testń╗ōÕ░ŠńÜäµ¢ćõ╗ČŃĆépytestõ╝ÜĶć¬ÕŖ©µÉ£ń┤óĶ┐Öõ║øµ¢ćõ╗ČõĖŁńÜ䵥ŗĶ»Ģńö©õŠŗŃĆé +rootdir: D:\pytest\Tasks\tests, +inifile: pytest.ini & tox.ini & setup.cfg + +µĄŗĶ»Ģń╗ōµ×£ +µ»ÅõĖ¬µ¢ćõ╗ČńÜ䵥ŗĶ»ĢµāģÕåĄÕÅ¬ÕŹĀµŹ«õĖĆĶĪī’╝īõĖżõĖ¬ńé╣ÕÅĘĶĪ©ńż║õĖżõĖ¬µĄŗĶ»Ģńö©õŠŗÕØćÕĘ▓ķĆÜĶ┐ć’╝øĶĆīFailure/erro/skip/xfail/xpassĶĪ©ńż║µĄŗĶ»Ģńö©õŠŗÕż▒Ķ┤ź/ķöÖĶ»»/ĶĘ│Ķ┐ć/ķóäµ£¤Õż▒Ķ┤ź/ķóäµ£¤Õż▒Ķ┤źõĮåķĆÜĶ┐ć’╝īõ╝ÜĶó½µĀćĶ«░õĖ║F/E/s/x/XŃĆé + +## ń╝¢ÕåÖµĄŗĶ»ĢÕćĮµĢ░ +µĄŗĶ»ĢÕćĮµĢ░ńÜäÕæĮÕÉŹĶ¦äÕłÖ’╝Ütest_Õ╝ĆÕż┤µł¢ĶĆģõ╗ź_testń╗ōÕ░ŠŃĆé +µĄŗĶ»ĢTasksķĪ╣ńø«ńÜäµ¢ćõ╗Čńø«ÕĮĢÕ”éõĖŗ’╝Ü + + +µēƵ£ēńÜ䵥ŗĶ»ĢķāĮµöŠÕ£©testsµ¢ćõ╗ČÕż╣õĖŁ’╝īõĖÄÕīģÕɽń©ŗÕ║ŵ║Éõ╗ŻńĀüńÜäsrcµ¢ćõ╗ČÕż╣ÕłåÕ╝ĆŃĆéµ£ēõĖĆõ║øµ¢ćõ╗ȵ»öĶŠāķćŹĶ”ü’╝īÕ”éREADME.rst(rstµś»õĮ┐ńö©reStrucuredTextń╝¢ÕåÖńÜäµ¢ćµĪŻµĀ╝Õ╝Å,readmeµś»ķĪ╣ńø«ķĪ╗ń¤ź’╝īCHANGELOGµś»Ķ«░ÕĮĢķĪ╣ńø«ÕÅśµø┤ńÜ䵌źÕ┐Śµ¢ćõ╗Č)’╝īLICENSE.txt(Ķ«ĖÕÅ»Ķ»üµ¢ćõ╗Č)’╝īsetup.py(Õ«ēĶŻģĶäܵ£¼)’╝īsetup.cfg(ķģŹńĮ«µ¢ćõ╗Č)’╝īpytest.ini(ķģŹńĮ«µ¢ćõ╗Č)’╝ītox.ini(ķģŹńĮ«µ¢ćõ╗Č)’╝īconftest.py’╝łµ£¼Õ£░µÅÆõ╗ČÕ║ō’╝īhookÕćĮµĢ░Õ░åĶć¬Õ«Üõ╣ēķĆ╗ĶŠæÕ╝ĢÕģźpytest,ńö©õ║ĵö╣Õ¢äpytestńÜäµē¦ĶĪīµĄüń©ŗ’╝øfixturesÕłÖµś»õĖĆõ║øńö©õ║ĵĄŗĶ»ĢÕēŹÕÉĵē¦ĶĪīķģŹńĮ«ÕÅŖķöƵ»üķĆ╗ĶŠæńÜäÕż¢ÕŻ│ÕćĮµĢ░’╝ēŃĆü_init_.py(ÕłØÕ¦ŗÕī¢µ¢ćõ╗Č,ĶĪ©ńż║ÕćĮµĢ░õĖ╗ÕģźÕÅŻ)ŃĆé + +## õĮ┐ńö©fixtureµē¦ĶĪīķģŹńĮ«ÕÆīķöƵ»üķĆ╗ĶŠæ +@pytest.fixture()õĖŁńÜäÕÅéµĢ░scopeĶĪ©ńż║fixtureńÜäõĮ£ńö©Õ¤¤’╝īµ£ēfunctionŃĆüclassŃĆümoduleŃĆüsessionÕøøõĖ¬ÕŠģķĆēÕĆ╝ŃĆé diff --git "a/_posts/2023-01-11-Linux\347\275\221\347\273\234\351\205\215\347\275\256.md" "b/_posts/2023-01-11-Linux\347\275\221\347\273\234\351\205\215\347\275\256.md" new file mode 100644 index 0000000000..115b9c599f --- /dev/null +++ "b/_posts/2023-01-11-Linux\347\275\221\347\273\234\351\205\215\347\275\256.md" @@ -0,0 +1,343 @@ +--- +layout: post +title: "LinuxńĮæń╗£ķģŹńĮ«" +date: 2023-01-11 +description: "õ╗ŗń╗ŹÕ”éõĮĢµ¤źń£ŗLinuxń│╗ń╗¤õĖŗńÜäńĮæń╗£ķģŹńĮ«,µ¤źń£ŗõĖ╗µ£║ÕÉŹŃĆüńĮæÕŹĪŃĆüĶĘ»ńö▒ÕÖ©ŃĆüńĮæń╗£Ķ┐׵ğµ¢╣Õ╝Å’╝īµĄŗĶ»ĢńĮæń╗£Ķ┐×ķĆÜńŁēńŁē" +tag: Linux +--- + +# linuxń│╗ń╗¤ńÜäńĮæń╗£Ķ┐׵ğńŖȵĆü + +## LINUXńĮæń╗£Ķ«ŠńĮ« +Ķ┐ÖõĖĆĶŖéõĖ╗Ķ”üĶ«▓Õ”éõĮĢµ¤źń£ŗÕ╣Čõ┐«µö╣Õ”éõĖ╗µ£║ÕÉŹ’╝īĶĘ»ńö▒ÕÖ©’╝īńĮæÕŹĪ’╝īńĮæń╗£Ķ┐׵ğµ¢╣Õ╝ÅńŁēńŁēŃĆé + +### 1.µ¤źń£ŗńĮæń╗£ķģŹńĮ« + +µ¤źń£ŗµēƵ£ēµ┤╗ÕŖ©ńÜäńĮæń╗£µÄźÕÅŻ + + ifconfig -a + +ens33:ń¼¼õĖĆÕØŚõ╗źÕż¬ńĮæÕŹĪńÜäÕÉŹń¦░,"ens33"õĖŁńÜä"en"µś»""EtherNetŌĆØ"ńÜäń╝®ÕåÖ’╝īĶĪ©ńż║ńĮæÕŹĪń▒╗Õ×ŗõĖ║õ╗źÕż¬ńĮæ’╝ī"s"ĶĪ©ńż║ńāŁµÅƵŗöµÅƵ¦ĮõĖŖńÜäĶ«ŠÕżć(hot-plugslot.┬ʵĢ░ÕŁŚŌĆ£33ŌĆØĶĪ©ńż║µÅƵ¦Įń╝¢ÕÅĘŃĆé + + ifconfig ens33 + inet 192.168.245.211 #ipÕ£░ÕØĆ + netmask 255. + broadcast 192.168.245.255 #Õ╣┐µÆŁÕ£░ÕØĆ + inet6 + ether 00:0c:29:5a:5a:5a #macÕ£░ÕØĆ + + + +### 2.µ¤źń£ŗńĮæń╗£ńŖȵĆü + + netstat -tunlp + # -t’╝ܵ¤źń£ŗTCP (Transmission Control Protocol’╝īõ╝ĀĶŠōµÄ¦ÕłČÕŹÅĶ««’╝ēńøĖÕģ│ńÜäõ┐Īµü» + # -u’╝ܵ¤źń£ŗUDP (User Datagram Protocol’╝īńö©µłĘµĢ░µŹ«µŖźÕŹÅĶ««’╝ēńøĖÕģ│ńÜäõ┐Īµü» + # -n’╝ܵśŠńż║µĢ░ÕŁŚµĀ╝Õ╝ÅńÜäIPÕ£░ÕØĆ(õĖ╗µ£║Õ£░ÕØĆŃĆüń½»ÕÅŻõ┐Īµü») + # -l’╝ܵśŠńż║ńøæÕÉ¼ÕźŚµÄźÕŁŚ’╝łListeninńŖȵĆüńÜäńĮæń╗£Ķ┐׵ğÕÅŖń½»ÕÅŻõ┐Īµü»’╝ē + # -p’╝ܵśŠńż║Ķ┐øń©ŗõ┐Īµü»’╝łĶ»źķĆēķĪ╣ķ£ĆĶ”ürootµØāķÖÉ’╝ē + + +### 3. õĖ┤µŚČõ┐«µö╣õĖ╗µ£║ÕÉŹ + + hostnamectl set-hostname +### 4.µ░Ėõ╣ģõ┐«µö╣õĖ╗µ£║ÕÉŹ + + vim /etc/hostname + vim /etc/hosts + +### 5.µĄŗĶ»ĢńĮæń╗£Ķ┐×ķĆܵƦ + + ping www.baidu.com + ping -c 3 www.baidu.com #µĄŗĶ»Ģ3µ¼Ī + ping -c 3 -i 0.2 www.baidu.com #µ»Åµ¼ĪķŚ┤ķÜö0.2ń¦Æ + ping -c 3 -i 0.2 -w 1 www.baidu.com #ĶČģµŚČµŚČķŚ┤õĖ║1ń¦Æ’╝łÕŬpingõ║öń¦Æ’╝ī5ń¦Æõ╣ŗÕÉÄń╗ōµØ¤’╝ē + +õĖĆĶł¼µØźĶ»┤’╝īńĮæń╗£õĖŹķĆÜ’╝īńö©pingµØźÕ«ÜõĮŹķŚ«ķóśĶŖéńé╣ńÜäõĮŹńĮ«’╝īpingńÜäķĪ║Õ║ÅÕ”éõĖŗ’╝Ü + + ping 127.0.0.1 #ping µ£¼Õ£░Õø×ńÄ»’╝īµĄŗĶ»Ģµ£¼Õ£░ńĮæń╗£ÕŹÅĶ««µś»ÕÉ”µŁŻÕĖĖ + ping 192.168.0.31 #ping µ£¼Õ£░IP’╝īµĄŗĶ»Ģµ£¼Õ£░ńĮæń╗£µÄźÕÅŻµś»ÕÉ”µŁŻÕĖĖ + ping 192.168.0.254 # ping ńĮæÕģ│’╝īµĄŗĶ»ĢńĮæÕģ│µś»ÕÉ”ÕĘźõĮ£µŁŻÕĖĖ + ping 202.106.0.20 # ping Õż¢ķā©ńĮæń╗£’╝īµĄŗĶ»Ģµ£ŹÕŖĪÕĢåńĮæń╗£µś»ÕÉ”ÕĘźõĮ£µŁŻÕĖĖ + +### 6.µ¤źń£ŗĶĘ»ńö▒ĶĪ© + + route -n + # -n’╝Üõ╗źµĢ░ÕŁŚµĀ╝Õ╝ŵśŠńż║ĶĘ»ńö▒ĶĪ©õ┐Īµü» + # -v’╝ܵśŠńż║Ķ»”ń╗åńÜäĶĘ»ńö▒ĶĪ©õ┐Īµü» + # -e’╝ܵśŠńż║ĶĘ»ńö▒ĶĪ©õĖŁńÜäķöÖĶ»»õ┐Īµü» + # -A’╝ܵśŠńż║µēƵ£ēńÜäĶĘ»ńö▒ĶĪ©õ┐Īµü» + # -g’╝ܵśŠńż║ńĮæÕģ│õ┐Īµü» + # -C’╝ܵśŠńż║ń╝ōÕŁśõ┐Īµü» + # -F’╝ܵśŠńż║Ķ┐ćµ╗żõ┐Īµü» + # -M’╝ܵśŠńż║ÕżÜµÆŁõ┐Īµü» + # -N’╝ܵśŠńż║ńĮæń╗£õ┐Īµü» + # -S’╝ܵśŠńż║ÕźŚµÄźÕŁŚõ┐Īµü» + # -T’╝ܵśŠńż║TCPõ┐Īµü» + # -U’╝ܵśŠńż║UDPõ┐Īµü» + # -V’╝ܵśŠńż║ńēłµ£¼õ┐Īµü» + # -W’╝ܵśŠńż║ńĮæÕŹĪõ┐Īµü» + # -X’╝ܵśŠńż║X.25õ┐Īµü» + # -Z’╝ܵśŠńż║SCTPõ┐Īµü» + +### 7.µ¤źń£ŗDNSµ£ŹÕŖĪÕÖ© + + cat /etc/resolv.conf + #nameserver + #µĄŗĶ»ĢDNSµ£ŹÕŖĪÕÖ©µś»ÕÉ”ÕÅ»ńö© + nslookup www.baidu.com #ńø«µĀćõĖ╗µ£║Õ£░ÕØĆ + # Ķ¦Żµ×ÉDNSõ┐Īµü»µöČķøå + dig www.baidu.com + # µ£¼Õ£░õĖ╗µ£║µśĀÕ░äµ¢ćõ╗Č + # etc/hosts µ¢ćõ╗ČõĖŁĶ«░ÕĮĢńØĆõĖĆõ╗ĮõĖ╗µ£║ÕÉŹõĖÄ IP Õ£░ÕØĆńÜ䵜ĀÕ░äÕģ│ń│╗ĶĪ©’╝īõĖĆĶł¼ńö©µØźõ┐ØÕŁśń╗ÅÕĖĖķ£ĆĶ”üĶ«┐ķŚ«ńÜäõĖ╗µ£║ńÜäõ┐Īµü»ŃĆé + # ÕĮōĶ«┐ķŚ«õĖĆõĖ¬µ£¬ń¤źńÜäÕ¤¤ÕÉŹµŚČ’╝īÕģłµ¤źµēŠĶ»źµ¢ćõ╗ČõĖŁµś»ÕÉ”µ£ēńøĖÕ║öńÜ䵜ĀÕ░äĶ«░ÕĮĢ’╝īÕ”éµ×£µēŠõĖŹÕł░ÕåŹÕÄ╗ÕÉæDNS µ£ŹÕŖĪÕÖ©µ¤źĶ»ó + cat /etc/hosts + # µ£¼Õ£░õĖ╗µ£║ÕÉŹĶ¦Żµ×ɵ¢ćõ╗Č + # /etc/nsswitch.conf µ¢ćõ╗ČõĖŁĶ«░ÕĮĢńØƵ£¼Õ£░õĖ╗µ£║ÕÉŹĶ¦Żµ×ÉńÜäķĪ║Õ║Å’╝īõĖĆĶł¼µāģÕåĄõĖŗ’╝īµ£¼Õ£░õĖ╗µ£║ÕÉŹĶ¦Żµ×ÉńÜäķĪ║Õ║ÅõĖ║’╝Ü + # hosts > dns > files > nis > nisplus > db > ldap > compat > hesiod > myhostname + +### 8.µ¤źń£ŗńĮæÕŹĪõ┐Īµü» + + ifconfig + # -a’╝ܵśŠńż║µēƵ£ēńĮæÕŹĪõ┐Īµü» + # -s’╝ܵśŠńż║ńĮæÕŹĪńÜäń«ĆĶ”üõ┐Īµü» + # -d’╝ܵśŠńż║ńĮæÕŹĪńÜäĶ»”ń╗åõ┐Īµü» + # -v’╝ܵśŠńż║ńĮæÕŹĪńÜäĶ»”ń╗åõ┐Īµü» + # -r’╝ܵśŠńż║ĶĘ»ńö▒õ┐Īµü» + # -m’╝ܵśŠńż║ÕżÜµÆŁõ┐Īµü» + # -u’╝ܵśŠńż║UDPõ┐Īµü» + # -t’╝ܵśŠńż║TCPõ┐Īµü» + # -x’╝ܵśŠńż║X.25õ┐Īµü» + # -z’╝ܵśŠńż║SCTPõ┐Īµü» + + +### 9.ńĮæń╗£Ķ┐׵ğµ¢╣Õ╝Å + +#### ÕŖ©µĆüńĮæń╗£dhcp + +##### ńĮæµĪźµ¢╣Õ╝Å +link: https://blog.csdn.net/qq_59323083/article/details/125531699 + + # 1.Õ«ēĶŻģńĮæµĪźÕĘźÕģĘ + yum install bridge-utils + # 2.ķģŹńĮ«ńĮæµĪź + vim /etc/sysconfig/network-scripts/ifcfg-eth0 + # µĘ╗ÕŖĀõ╗źõĖŗÕåģÕ«╣ + DEVICE=eth0 + BOOTPROTO=dhcp + ONBOOT=yes + BRIDGE=br0 + # 3.ķģŹńĮ«ńĮæµĪź + vim /etc/sysconfig/network-scripts/ifcfg-br0 + # µĘ╗ÕŖĀõ╗źõĖŗÕåģÕ«╣ + DEVICE=br0 + BOOTPROTO=static + IPADDR= + +##### NATµ¢╣Õ╝Å +µēōÕ╝ĆĶÖܵŗ¤ńĮæń╗£ń╝¢ĶŠæÕÖ©’╝īµēƵ£ēµĢ░µŹ«õĖŹĶ”üÕÄ╗µö╣ÕŖ©’╝īÕ”éõĖŗÕøŠµēĆńż║’╝Ü + +µēōÕ╝ĆĶÖܵŗ¤µ£║Ķ«ŠńĮ«’╝īńĮæń╗£ķĆéķģŹÕÖ©’╝īķĆēµŗ®NATµ©ĪÕ╝Å’╝īńäČÕÉÄńé╣Õć╗ķ½śń║¦’╝īķĆēµŗ®ń½»ÕÅŻĶĮ¼ÕÅæ’╝īµĘ╗ÕŖĀń½»ÕÅŻĶĮ¼ÕÅæĶ¦äÕłÖ’╝īÕ”éõĖŗÕøŠµēĆńż║’╝Ü + +ķćŹÕÉ»ńĮæń╗£ + + systemctl restart network + +µŻĆµ¤źńĮæń╗£Ķ┐×ķĆܵƦ + + ping www.baidu.com + +#### ķØÖµĆüńĮæń╗£ + +##### ńĮæµĪźµ©ĪÕ╝ÅĶüöńĮæ’╝łstatic’╝ē + +ķĆÜĶ┐ćVMwareń╝¢ĶŠæĶÅ£ÕŹĢµĀÅńé╣Õć╗ĶÖܵŗ¤ńĮæń╗£ń╝¢ĶŠæÕÖ©,Ķ«ŠńĮ«VMnet0’╝īķĆēµŗ®µĪźµÄźµ©ĪÕ╝Å’╝īÕż¢ķā©Ķ┐׵ğõĖŹĶ”üķĆēĶć¬ÕŖ©’╝īĶĆīµś»ķĆēµŗ®õĮĀńÜäÕ«┐õĖ╗õĖ╗µ£║ńÜäńĮæÕŹĪ’╝īĶĆāĶÖæÕł░õĖĆĶł¼µ£ēµ£ēń║┐ÕÆīµŚĀń║┐õĖżÕØŚńĮæÕŹĪ’╝īõĮåĶ┐ÖķćīķĆēµŗ®ńÜäĶ┐ÖÕØŚńĮæÕŹĪµś»Ķ┐׵ğInternetńÜä’╝īµ»öÕ”é’╝īĶ┐ÖõĖ¬ÕøŠõĖŁµēĆńż║’╝īµłæõĮ┐ńö©µŚĀń║┐ńĮæÕŹĪĶ┐×µÄźÕł░Internet’╝īµēĆõ╗źķĆēµŗ®Õ«ā’╝īńäČÕÉÄŌĆ£ńĪ«Õ«ÜŌĆØŃĆé(Õ”éÕøŠµēĆńż║) + +ĶÖܵŗ¤µ£║ Ķ«ŠńĮ« ńĮæń╗£ķĆéķģŹÕÖ© ķĆēµŗ®µĪźµÄźµ©ĪÕ╝Å’╝īÕ”éõĖŗÕøŠµēĆńż║’╝Ü + +õ┐«µö╣ķģŹńĮ«µ¢ćõ╗Č/etc/sysconfig/network-scripts/ifcfg-ens33 + +ķćŹÕÉ»ńĮæń╗£µ£ŹÕŖĪ + + systemctl restart network + +##### NATµ©ĪÕ╝ÅĶüöńĮæ’╝łstatic’╝ē + +ķĆÜĶ┐ćVMwareń╝¢ĶŠæĶÅ£ÕŹĢµĀÅńé╣Õć╗ĶÖܵŗ¤ńĮæń╗£ń╝¢ĶŠæÕÖ©’╝īķĆēõĖŁVMnet8ńé╣Õć╗NATĶ«ŠńĮ«’╝Ü + +õĖŹõĮ┐ńö©µ£¼Õ£░DHCPµ£ŹÕŖĪ’╝īĶ┐ÖµĀĘÕ░▒ÕŠŚÕŗŠµČłDHCPķĆēķĪ╣’╝īńäČÕÉĵ¤źń£ŗDHCPńĪ«õ┐ص£¬ÕÉ»ńö©ŃĆé + + +ń¼¼ÕøøµŁź’╝īµēōÕ╝ĆNATĶ«ŠńĮ«’╝īĶ«░ÕĮĢõĖŗÕøŠõĖŁĶĪ©ńż║ńÜäµĢ░µŹ«ńö©õ║Äõ┐«µö╣ķģŹńĮ«µ¢ćõ╗Č’╝Ü + + +ń¼¼õ║öµŁź’╝īµēōÕ╝ĆĶÖܵŗ¤µ£║Ķ«ŠńĮ«’╝īķģŹńĮ«ńĮæń╗£ķĆéķģŹÕÖ©’╝īÕ”éõĖŗÕøŠµēĆńż║’╝Ü + +ń¼¼ÕģŁµŁź’╝īõ┐«µö╣ķģŹńĮ«µ¢ćõ╗Č/etc/sysconfig/network-scripts/ifcfg-ens33’╝īõ┐«µö╣ńÜ䵌ČÕĆÖÕ┐ģķĪ╗µīēń¼¼ÕøøµŁźńÜäIPńĮ浫ĄÕÆīńĮæÕģ│õ┐«µö╣’╝īÕģĘõĮōµĀ╣µŹ«õĮĀĶć¬ÕĘ▒ńÜäµāģÕåĄÕå│Õ«ÜĶ┐ÖõĖ¬ńĮ浫Ą’╝īµ»öÕ”é’╝īµłæńÜäńĮ浫Ąµś»192.168.75.0’╝īńĮæÕģ│µś»192.168.75.2’╝īÕŁÉńĮæµÄ®ńĀüµś»255.255.255.0ŃĆé + + + +ń¼¼õĖāµŁź’╝īķćŹÕÉ»µ£ŹÕŖĪ’╝Ü + + systemctl restart network + +## ķģŹńĮ«DNS + +ń¼¼õĖƵŁź’╝Üõ┐«µö╣ķģŹńĮ«µ¢ćõ╗Č /etc/resolv.conf ’╝īÕ”éµ×£õĮĀÕģ¼ÕÅĖµ£ēĶć¬ÕĘ▒ńÜäDNSµ£ŹÕŖĪÕÖ©’╝īķéŻõ╣łńö©µ£¼Õģ¼ÕÅĖńÜä’╝īõ╣¤ÕÅ»õ╗źÕł░ńĮæõĖŖµ¤źµēŠÕģŹĶ┤╣ńÜäDNSµ£ŹÕŖĪÕÖ©’╝īµ»öÕ”é’╝Ü + +õĖŁÕøĮõ║ÆĶüöńĮæń╗£õĖŁÕ┐ā’╝Ü1.2.4.8ŃĆü210.2.4.8ŃĆü101.226.4.6’╝łńöĄõ┐ĪÕÅŖń¦╗ÕŖ©’╝ēŃĆü123.125.81.6’╝łĶüöķĆÜ’╝ē +ķś┐ķćīDNS’╝Ü223.5.5.5ŃĆü223.6.6.6 +googleDNS’╝Ü8.8.8.8ŃĆü8.8.4.4 +openDNS’╝Ü208.67.222.222208.67.220.220208.67.222.220208.67.220.222 +ÕÅ»õ╗źķś╗µīĪÕɽµ£ēµüȵäÅńĮæń½ÖńÜädns +208.67.220.123 + +µŚĀÕŖ½µīü ÕÄ╗Õ╣┐ÕæŖµł¢ń▓Śõ┐ŚńĮæń½Ödns:114.114.114.114 ÕÆī 114.114.115.115 + +µŗ”µł¬ķÆōķ▒╝ńŚģµ»Æµ£©ķ®¼ńĮæń½Ö,ÕÅ»Õó×Õ╝║ńĮæķōČŃĆüĶ»üÕłĖŃĆüĶ┤Łńē®ŃĆüµĖĖµłÅŃĆüķÜÉń¦üõ┐Īµü»Õ«ēÕģ©ńÜäDNS 114.114.114.119 ÕÆī 114.114.115.119 + +ńäČÕÉÄõ┐«µö╣ķģŹńĮ«µ¢ćõ╗Č /etc/resolv.conf’╝īÕ”éõĖŗĶĪ©µēĆńż║’╝Ü + + +**ÕÅ»µ£ĆÕżÜÕåÖ3õĖ¬** + +ÕĮōõĮĀķģŹÕźĮresolv.confµ¢ćõ╗ČÕÉÄ’╝īĶ┐ćõ║åõĖĆõ╝Ü’╝īÕÅæńÄ░ÕłÜµēŹķģŹńĮ«ÕźĮńÜäDNSÕÅłÕż▒µĢłõ║å’╝īÕĤµØźDNSĶó½ń│╗ń╗¤ķ揵¢░Ķ”åńø¢µł¢ĶĆģĶó½µĖģķÖż’╝üµēĆõ╗źõĮĀĶ┐śÕ┐ģķĪ╗Õ«īµłÉõ╗źõĖŗÕĘźõĮ£ŃĆé + +ń¼¼õ║īµŁź’╝Üõ┐«µö╣/etc/NetworkManager/NetworkManager.confµ¢ćõ╗Č + + + +## ńĮæń╗£Õ¤║µ£¼ń«ĪńÉå--õĖÄńĮæń╗£ķģŹńĮ«ńøĖÕģ│ńÜäÕĖĖńö©ÕæĮõ╗ż + +1. µ¤źń£ŗńĮæń╗£ķģŹńĮ«õ┐Īµü» +ifconfig ńÜäÕŖ¤ĶāĮµś»ń«ĪńÉåńĮæń╗£µÄźÕÅŻ’╝īńö©õ║ĵ¤źń£ŗŃĆüķģŹńĮ«ŃĆüÕÉ»ńö©µł¢ń”üńö©ńĮæń╗£µÄźÕÅŻŃĆé + + ifconfig interface [aftype] options | address ŌĆ” + +  + +ifconfigÕæĮõ╗żµś»LinuxõĖŗńö©µØźķģŹńĮ«ÕÆīµśŠńż║ńĮæń╗£µÄźÕÅŻõ┐Īµü»ńÜäÕæĮõ╗ż’╝īÕ«āÕÅ»õ╗źµśŠńż║ńĮæń╗£µÄźÕÅŻńÜäĶ»”ń╗åõ┐Īµü»’╝īÕīģµŗ¼IPÕ£░ÕØĆŃĆüÕŁÉńĮæµÄ®ńĀüŃĆüÕ╣┐µÆŁÕ£░ÕØĆŃĆüMACÕ£░ÕØĆńŁēŃĆé + + ifconfig + #Õ«ēĶŻģifconfigÕæĮõ╗ż + yum -y install net-tools + # õ╗ĵ║ÉÕż┤Õ╝ĆÕ¦ŗÕ«ēĶŻģ + yum -y install net-tools.x86_64 + +ifconfigĶ»Łµ│Ģ + + ifconfig [ķĆēķĪ╣] [µÄźÕÅŻÕÉŹ] + ifconfig [ķĆēķĪ╣] [µÄźÕÅŻÕÉŹ] [Õ£░ÕØĆ] [Õ╣┐µÆŁÕ£░ÕØĆ] [ÕŁÉńĮæµÄ®ńĀü] +ńĮæÕŹĪµÄ¦ÕłČÕæĮõ╗ż + + ifconfig eth0 up # ÕÉ»ÕŖ©ńĮæÕŹĪ + ifconfig eth0 down # Õģ│ķŚŁńĮæÕŹĪ + ifconfig eth0 + ifup eth0 # ÕÉ»ÕŖ©ńĮæÕŹĪ + ifup ens33 + ifup eth0:0 # ÕÉ»ÕŖ©ĶÖܵŗ¤ńĮæÕŹĪ + ifdown ens33 + +nmcliÕæĮõ╗ż +Ķ»źÕæĮõ╗żÕÅ»õ╗źÕ«īµłÉńĮæÕŹĪõĖŖµēƵ£ēńÜäķģŹńĮ«ÕĘźõĮ£’╝īÕ╣ČõĖöÕÅ»õ╗źÕåÖÕģźķģŹńĮ«µ¢ćõ╗Č’╝īķćŹÕÉ»ÕÉÄõŠØńäȵ£ēµĢłŃĆé + + nmcli device show ens33 # µ¤źń£ŗńĮæÕŹĪõ┐Īµü» + nmcli device status # µ¤źń£ŗńĮæÕŹĪńŖȵĆü + nmcli device disconnect ens33 # µ¢ŁÕ╝ĆńĮæÕŹĪ + nmcli device connect ens33 # Ķ┐׵ğńĮæÕŹĪ + nmcli device modify ens33 ipv4.addresses + nmcli device modify ens33 ipv4.addresses + +µŻĆµ¤źńĮæÕŹĪń¤źÕÉ”Ķ┐׵ğńĮæń║┐ńÜäÕæĮõ╗ż + + ethtool ens33 # µ¤źń£ŗńĮæÕŹĪõ┐Īµü» + ethtool ens33 | grep "Link detected" # µ¤źń£ŗńĮæÕŹĪµś»ÕÉ”Ķ┐׵ğńĮæń║┐ + + +2. pingÕæĮõ╗ż + + ping [options] hostname/ip + +  + +3. µŻĆµ¤źńĮæń╗£ńŖȵĆü’╝łnetstat’╝ē + + netstat [-veenNcCF] [

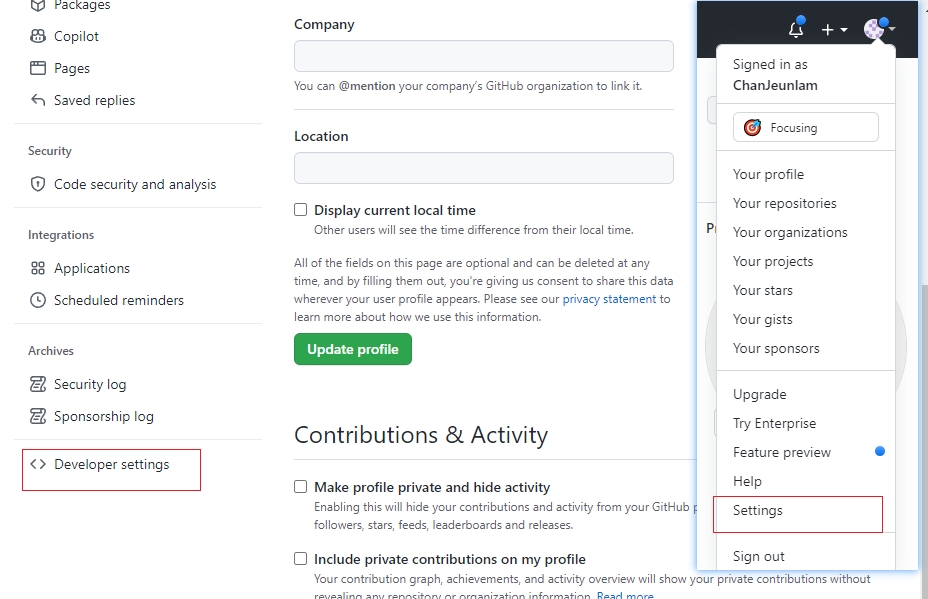

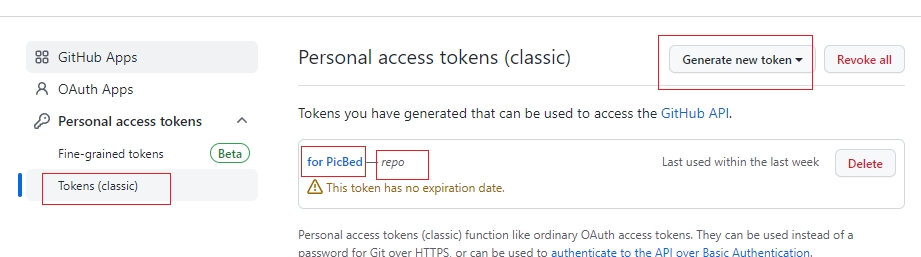

+Õ£©utilsµ¢ćõ╗ČÕż╣õĖŗķØóµ¢░Õ╗║õĖĆõĖ¬YamlUtil.pyµ¢ćõ╗Č’╝īńö©µØźÕ░üĶŻģyamlµ¢ćõ╗ČńÜäĶ»╗ÕÅ¢µōŹõĮ£ŃĆé +```python +import yaml +import os +# set up the class to read the yaml file +class YamlReader: + def __init__(self, yamlf): + # Õłżµ¢Łµ¢ćõ╗ȵś»ÕÉ”ÕŁśÕ£© + if os.path.exists(yamlf): + self.yamlf = yamlf + else: + raise FileNotFoundError("µ¢ćõ╗ČõĖŹÕŁśÕ£©’╝ü") + self._data = None # Õ«Üõ╣ēõĖĆõĖ¬ń¦üµ£ēÕ▒׵Ʀ’╝īńö©µØźÕŁśÕé©Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« + # @propertyĶŻģķź░ÕÖ©ńÜäõĮ£ńö©µś»µŖŖõĖĆõĖ¬µ¢╣µ│ĢÕÅśµłÉÕ▒׵ƦĶ░āńö© + @property + def data(self): + # read data from yaml file + # Õłżµ¢Łµś»ÕÉ”ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īÕ”éµ×£ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īµŁżµŚČself._dataõĖ║ÕŁŚÕģĖ’╝īõĖŹõĖ║None’╝īÕ░▒õĖŹķ£ĆĶ”üÕåŹµ¼ĪĶ»╗ÕÅ¢µĢ░µŹ«ŃĆé + if not self._data: + with open(self.yamlf, 'rb') as f: # rbµś»õ╗źõ║īĶ┐øÕłČĶ»╗ÕÅ¢ + self._data = yaml.safe_load(f) + return self._data # Ķ┐öÕø×Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« +``` +µĄŗĶ»ĢõĖĆõĖŗĶ┐ÖõĖ¬utilµ¢ćõ╗ȵś»ÕÉ”ÕÅ»õ╗źµŁŻÕĖĖĶ»╗ÕÅ¢yamlµ¢ćõ╗Č,Õ£©t_yamlµ¢ćõ╗ČÕż╣õĖŗķØóµ¢░Õ╗║õĖĆõĖ¬yaml_demo.pyµ¢ćõ╗Č’╝īńö©µØźµĄŗĶ»ĢYamlUtil.pyµ¢ćõ╗ȵś»ÕÉ”ÕÅ»õ╗źµŁŻÕĖĖĶ»╗ÕÅ¢yamlµ¢ćõ╗ČŃĆé +```python +from utils.YamlUtil import YamlReader +yaml_path = "./data.yml" +data = YamlReader(yaml_path).data +print(data) +``` +yamlµ¢ćõ╗ČÕåģÕ«╣Õ”éõĖŗ’╝Ü +```yaml +name: "test_yml" +result: "success" +``` +ĶŠōÕć║ń╗ōµ×£Õ”éõĖŗ’╝Ü +```commandline +{'name': 'test_yml', 'result': 'success'} +``` + +õ╗źõĖŖÕ░üĶŻģńÜäYamlUtil.pyµ¢ćõ╗ČÕŬĶāĮĶ»╗ÕÅ¢ÕŹĢõĖ¬yamlµ¢ćõ╗Č’╝īÕ”éµ×£Ķ”üĶ»╗ÕÅ¢ÕżÜõĖ¬yamlµ¢ćõ╗Č’╝īķ£ĆĶ”üÕ£©YamlUtil.pyµ¢ćõ╗ČõĖŁµĘ╗ÕŖĀõĖĆõĖ¬µ¢╣µ│Ģ’╝īńö©µØźĶ»╗ÕÅ¢ÕżÜõĖ¬yamlµ¢ćõ╗ČŃĆé +

+õ╗źõĖŖńÜäYamlUtil.pyµ©ĪÕØŚÕ£©Ķ»╗ÕÅ¢õĖŗÕłŚÕżÜõĖ¬yamlµ¢ćõ╗ȵŚČÕĆÖńÜäµŖźķöÖõ┐Īµü»Õ”éõĖŗ’╝Ü +yamlµ¢ćõ╗ČÕåģÕ«╣’╝Ü +```yaml +--- +"username1": "test123" +"password": "123456" +--- +"username1": "test456" +"password": "123456" +``` +µŖźķöÖõ┐Īµü»Õ”éõĖŗ’╝Ü +```commandline +raise ComposerError("expected a single document in the stream", +yaml.composer.ComposerError: expected a single document in the stream + in "./data.yaml", line *, column 1 +``` + +Õ£©YamlUtil.pyµ¢ćõ╗ČõĖŁµĘ╗ÕŖĀõĖĆõĖ¬µ¢╣µ│Ģ’╝īńö©µØźĶ»╗ÕÅ¢ÕżÜõĖ¬yamlµ¢ćõ╗Č: +```python +import yaml +import os +# set up the class to read the yaml file +class YamlReader: + def __init__(self, yamlf): + # Õłżµ¢Łµ¢ćõ╗ȵś»ÕÉ”ÕŁśÕ£© + if os.path.exists(yamlf): + self.yamlf = yamlf + else: + raise FileNotFoundError("µ¢ćõ╗ČõĖŹÕŁśÕ£©’╝ü") + self._data = None # Õ«Üõ╣ēõĖĆõĖ¬ń¦üµ£ēÕ▒׵Ʀ’╝īńö©µØźÕŁśÕé©Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« + self._data_all = None # Õ«Üõ╣ēõĖĆõĖ¬ń¦üµ£ēÕ▒׵Ʀ’╝īńö©µØźÕŁśÕé©Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« + # @propertyĶŻģķź░ÕÖ©ńÜäõĮ£ńö©µś»µŖŖõĖĆõĖ¬µ¢╣µ│ĢÕÅśµłÉÕ▒׵ƦĶ░āńö© + @property + def data(self): + # read data from yaml file + # Õłżµ¢Łµś»ÕÉ”ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īÕ”éµ×£ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īµŁżµŚČself._dataõĖ║ÕŁŚÕģĖ’╝īõĖŹõĖ║None’╝īÕ░▒õĖŹķ£ĆĶ”üÕåŹµ¼ĪĶ»╗ÕÅ¢µĢ░µŹ«ŃĆé + if not self._data: + with open(self.yamlf, 'rb') as f: # rbµś»õ╗źõ║īĶ┐øÕłČĶ»╗ÕÅ¢ + self._data = yaml.safe_load(f) + return self._data # Ķ┐öÕø×Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« + # Ķ»╗ÕÅ¢ÕżÜõĖ¬yamlµ¢ćõ╗Č + def data_all(self): + # read data from yaml file + # Õłżµ¢Łµś»ÕÉ”ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īÕ”éµ×£ÕĘ▓ń╗ÅĶ»╗ÕÅ¢Ķ┐ćµĢ░µŹ«’╝īµŁżµŚČself._dataõĖ║ÕŁŚÕģĖ’╝īõĖŹõĖ║None’╝īÕ░▒õĖŹķ£ĆĶ”üÕåŹµ¼ĪĶ»╗ÕÅ¢µĢ░µŹ«ŃĆé + if not self._data_all: + with open(self.yamlf, 'rb') as f: # rbµś»õ╗źõ║īĶ┐øÕłČĶ»╗ÕÅ¢ + self._data_all = list(yaml.safe_load_all(f)) # list()ÕćĮµĢ░Õ░åyaml.safe_load_all(f)ĶĮ¼µŹóõĖ║ÕłŚĶĪ© + return self._data_all # Ķ┐öÕø×Ķ»╗ÕÅ¢ńÜäµĢ░µŹ« +``` +yamlµ¢ćõ╗ČÕåģÕ«╣’╝Ü +```yaml +--- +"username1": "test123" +"password": "123456" +--- +"username1": "test456" +"password": "123456" +``` +yaml_demo.pyµ¢ćõ╗ČÕåģÕ«╣’╝Ü +```python +from utils.YamlUtil import YamlReader +yaml_path = "./data.yaml" +data = YamlReader(yaml_path).data_all() +print(data) +``` +ĶŠōÕć║ń╗ōµ×£Õ”éõĖŗ’╝Ü +```commandline +[{'username1': 'test123', 'password': '123456'}, {'username1': 'test456', 'password': '123456'}] +``` +## YamlķģŹńĮ«µ¢ćõ╗ČĶ«ŠńĮ« +Õ£©configµ¢ćõ╗ČõĖŗķØó’╝īµ¢░Õ╗║õĖĆõĖ¬yamlµ¢ćõ╗Č’╝īÕæĮÕÉŹõĖ║config.yaml’╝īµ¢ćõ╗ČÕåģÕ«╣Õ”éõĖŗ’╝Ü +```yaml +# µĄŗĶ»ĢńÄ»Õóā +BASE: + test: + url: "http://211.103.136.242:8064" +``` +Õ£©configµ¢ćõ╗ČõĖŗķØó’╝īµ¢░Õ╗║õĖĆõĖ¬pyµ¢ćõ╗Č’╝īÕæĮÕÉŹõĖ║config.py’╝īńö©µØźĶ»╗ÕÅ¢ķģŹńĮ«µ¢ćõ╗Čconfig.yamlõĖŁńÜäÕåģÕ«╣’╝īµ¢ćõ╗ČÕåģÕ«╣Õ”éõĖŗ’╝Ü +ķ”¢Õģłµś»’╝īĶÄĘÕÅ¢ÕĮōÕēŹńø«ÕĮĢ +```python +# 1. ĶÄĘÕÅ¢ÕĮōÕēŹÕ¤║µ£¼ńø«ÕĮĢ +import os +current = os.path.abspath(__file__)# __file__ĶĪ©ńż║ÕĮōÕēŹµ¢ćõ╗Č,Ķ┐ÖµŁźµōŹõĮ£µś»ĶÄĘÕÅ¢ÕĮōÕēŹµ¢ćõ╗ČńÜäń╗ØÕ»╣ĶĘ»ÕŠä +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config/config.py +tmp_dir = os.path.dirname(current)# ĶÄĘÕÅ¢ÕĮōÕēŹµ¢ćõ╗ČńÜäńłČńø«ÕĮĢ +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config +# ĶÄĘÕÅ¢configńø«ÕĮĢńÜäńłČĶĘ»ÕŠä +base_dir = os.path.dirname(tmp_dir) +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W +# Õ«Üõ╣ēconfigńø«ÕĮĢńÜäĶĘ»ÕŠä +_config_dir = os.path.join(base_dir, "config") # _Õ╝ĆÕż┤ńÜäÕÅśķćÅĶĪ©ńż║ń¦üµ£ēÕÅśķćÅ +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config +# µł¢ĶĆģõ╣¤ÕÅ»õ╗źĶ┐ÖµĀĘÕåÖ’╝Ü +# _config_dir = base_dir + os.sep + "config" +# Õ«Üõ╣ēconfig.yamlµ¢ćõ╗ČńÜäĶĘ»ÕŠä +_config_yaml = os.path.join(_config_dir, "config.yaml") + +def get_config_path(): + return _config_dir +def get_config_file(): + return _config_yaml +``` + +ńäČÕÉĵś»’╝īĶ»╗ÕÅ¢ķģŹńĮ«µ¢ćõ╗Čconfig.yamlõĖŁńÜäÕåģÕ«╣ +```python +from utils.YamlUtil import YamlReader +# 1. ĶÄĘÕÅ¢ÕĮōÕēŹÕ¤║µ£¼ńø«ÕĮĢ +import os +current = os.path.abspath(__file__)# __file__ĶĪ©ńż║ÕĮōÕēŹµ¢ćõ╗Č,Ķ┐ÖµŁźµōŹõĮ£µś»ĶÄĘÕÅ¢ÕĮōÕēŹµ¢ćõ╗ČńÜäń╗ØÕ»╣ĶĘ»ÕŠä +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config/config.py +tmp_dir = os.path.dirname(current)# ĶÄĘÕÅ¢ÕĮōÕēŹµ¢ćõ╗ČńÜäńłČńø«ÕĮĢ +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config +# ĶÄĘÕÅ¢configńø«ÕĮĢńÜäńłČĶĘ»ÕŠä +base_dir = os.path.dirname(tmp_dir) +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W +# Õ«Üõ╣ēconfigńø«ÕĮĢńÜäĶĘ»ÕŠä +_config_dir = os.path.join(base_dir, "config") # _Õ╝ĆÕż┤ńÜäÕÅśķćÅĶĪ©ńż║ń¦üµ£ēÕÅśķćÅ +# /home/hugo/PycharmProjects/InterAutoTest_W/venv/bin/python /home/hugo/PycharmProjects/InterAutoTest_W/config +# µł¢ĶĆģõ╣¤ÕÅ»õ╗źĶ┐ÖµĀĘÕåÖ’╝Ü +# _config_dir = base_dir + os.sep + "config" +# Õ«Üõ╣ēconfig.yamlµ¢ćõ╗ČńÜäĶĘ»ÕŠä +_config_yaml = os.path.join(_config_dir, "config.yaml") + +def get_config_path(): + return _config_dir +def get_config_file(): + return _config_yaml # _õĖŗÕłÆń║┐Õ╝ĆÕż┤ńÜäÕÅśķćÅĶĪ©ńż║ń¦üµ£ēÕÅśķćÅ + +# 2. Ķ»╗ÕÅ¢ķģŹńĮ«µ¢ćõ╗Č +class ConfigYaml: + # ÕłØÕ¦ŗÕī¢yamlĶ»╗ÕÅ¢ķģŹńĮ«µ¢ćõ╗Č + def __init__(self): + self.config = YamlReader(get_config_file()).data # self.ĶĪ©ńż║ÕĮōÕēŹń▒╗ńÜäÕ«×õŠŗ + # ĶÄĘÕÅ¢url + def get_conf_url(self): + return self.config['BASE']['test']['url'] +if __name__ == '__main__': + conf_read = ConfigYaml() + print(conf_read.get_conf_url()) +``` +Ķ┐ÖõĖƵŁźÕüÜÕ«īõ╣ŗÕÉÄ’╝īÕø×Õł░µĄŗĶ»Ģńö©õŠŗµ¢ćõ╗Čtest_mall.py’╝īÕ£©Ķ┐ÖõĖ¬µĄŗĶ»Ģńö©õŠŗ’╝īĶ░āńö©config.pyµ¢ćõ╗ČõĖŁńÜäÕåģÕ«╣’╝īÕÅ»õ╗źÕ«×ńÄ░µĄŗĶ»ĢµĢ░µŹ«ÕÆīµĄŗĶ»Ģńö©õŠŗńÜäÕłåń”╗ŃĆé +