diff --git a/zh_0_3/GLOSSARY.md b/zh_0_3/GLOSSARY.md

new file mode 100644

index 0000000..d338536

--- /dev/null

+++ b/zh_0_3/GLOSSARY.md

@@ -0,0 +1,2 @@

+

+

diff --git a/zh_0_3/README.md b/zh_0_3/README.md

new file mode 100644

index 0000000..82d3f70

--- /dev/null

+++ b/zh_0_3/README.md

@@ -0,0 +1,29 @@

+

+

+[OpenFalcon](http://open-falcon.com)是一款企业级、高可用、可扩展的开源监控解决方案。

+

+在大家的热心支持和帮助下,OpenFalcon 已经成为国内最流行的监控系统之一。

+

+目前:

+- 在 [github](https://github.com/open-falcon/falcon-plus) 上取得了数千个star,数百次fork,上百个pull-request;

+- 社区用户6000+;

+- 超过200家公司都在不同程度使用open-falcon,包括大陆、新加坡、台湾等地;

+- 社区贡献了包括MySQL、redis、windows、交换机、LVS、Mongodb、Memcache、docker、mesos、URL监控等多种插件支持;

+

+-----

+**Acknowledgements**

+

+- OpenFalcon was initially started by Xiaomi and we would also like to acknowledge contributions by engineers from [these companies](./contributing.html) and [these individual developers](./contributing.html).

+- The OpenFalcon logo and website were contributed by Cepave Design Team.

+- [Wei Lai](https://github.com/laiwei) is the founder of OpenFalcon software and community.

+- The [english doc](http://book.open-falcon.com/en/index.html) is translated by [宋立岭](https://github.com/songliling).

+

+-----

+- QQ五群:42607978 (请加该群)//请大家优先在 github 上提交 [issue](https://github.com/open-falcon/falcon-plus/issues), 方便问题沉淀,github issue 会最高优先级解决。

+- QQ四群:697503992 (已满员)

+- QQ一群:373249123 (已满员)

+- QQ二群:516088946 (已满员)

+- QQ三群:469342415 (已满员)

+

+

+ diff --git a/zh_0_3/SUMMARY.md b/zh_0_3/SUMMARY.md

new file mode 100644

index 0000000..82ddef0

--- /dev/null

+++ b/zh_0_3/SUMMARY.md

@@ -0,0 +1,87 @@

+# SUMMARY

+

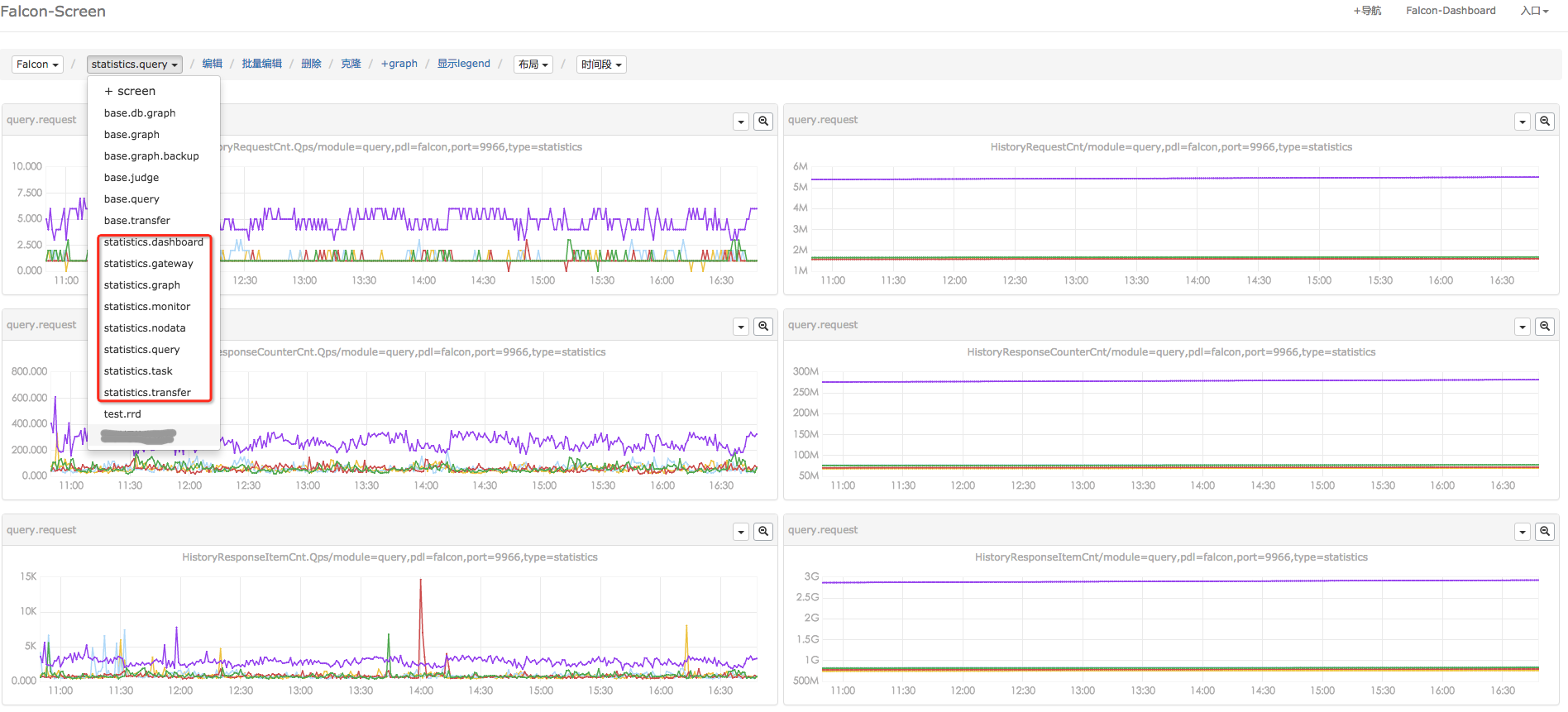

+### 第 Ⅰ 部分:社区

+* [社区介绍](README.md)

+* [贡献列表](contributing.md)

+* [项目介绍](intro/README.md)

+

+### 第 Ⅱ 部分:安装

+* [单机安装](quick_install/README.md)

+ * [环境准备](quick_install/prepare.md)

+ * [启动后端](quick_install/backend.md)

+ * [安装前端](quick_install/frontend.md)

+ * [v0.1平滑升级到v0.2](quick_install/upgrade.md)

+* [分布式安装](distributed_install/README.md)

+ * [环境准备](distributed_install/prepare.md)

+ * [Agent](distributed_install/agent.md)

+ * [Transfer](distributed_install/transfer.md)

+ * [Graph](distributed_install/graph.md)

+ * [API](distributed_install/api.md)

+ * [DashBoard](quick_install/frontend.md)

+ * [邮件/短信/微信发送接口](distributed_install/mail-sms.md)

+ * [Heartbeat Server](distributed_install/hbs.md)

+ * [Judge](distributed_install/judge.md)

+ * [Alarm](distributed_install/alarm.md)

+ * [Task](distributed_install/task.md)

+ * [Gateway](distributed_install/gateway.md)

+ * [Nodata](distributed_install/nodata.md)

+ * [Aggregator](distributed_install/aggregator.md)

+ * [Agent-updater](distributed_install/agent-updater.md)

+

+### 第 Ⅲ 部分:手册

+* [使用手册](usage/README.md)

+ * [快速入门](usage/getting-started.md)

+ * [Nodata配置](usage/nodata.md)

+ * [集群监控](usage/aggregator.md)

+ * [报警触发函数](usage/func.md)

+ * [自定义push数据](usage/data-push.md)

+ * [历史数据查询](usage/query.md)

+ * [进程端口监控](usage/proc-port-monitor.md)

+ * [MySQL监控](usage/mymon.md)

+ * [Redis监控](usage/redis.md)

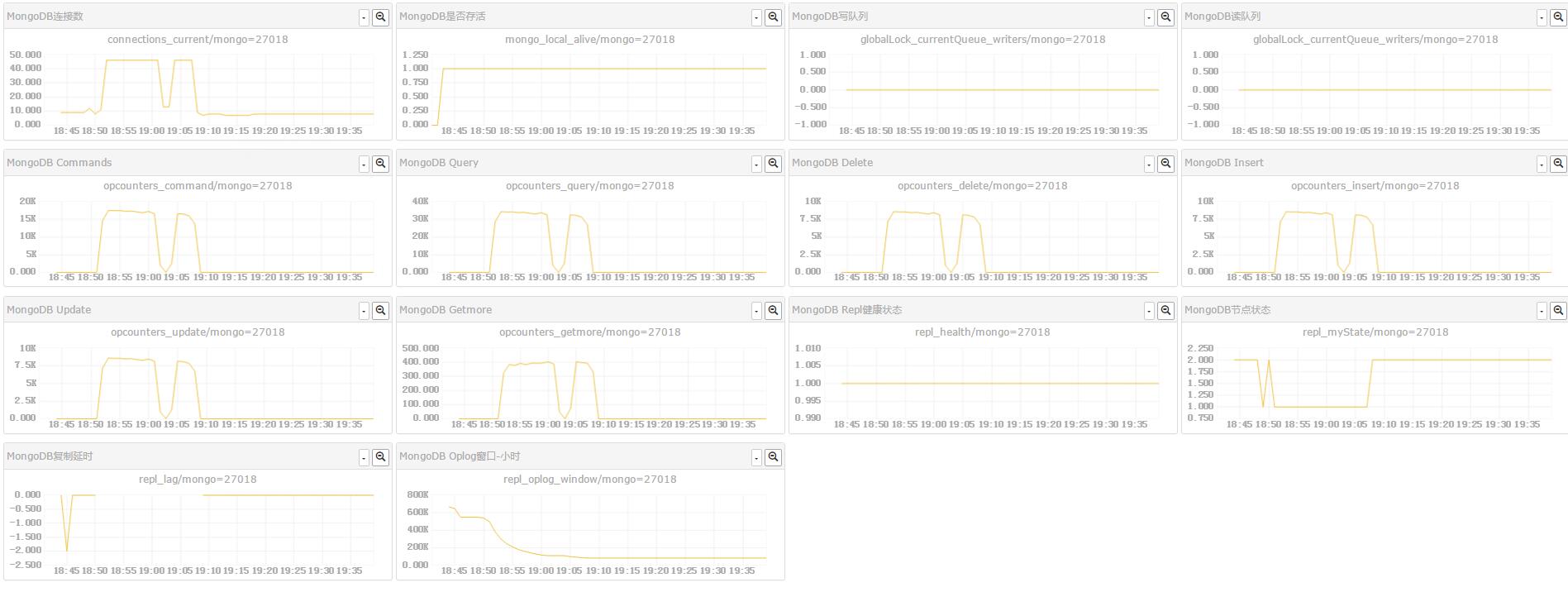

+ * [MongoDB监控](usage/MongoDB.md)

+ * [Memcache监控](usage/memcache.md)

+ * [RabbitMQ监控](usage/rabbitmq.md)

+ * [Solr监控](usage/solr.md)

+ * [交换机监控](usage/switch.md)

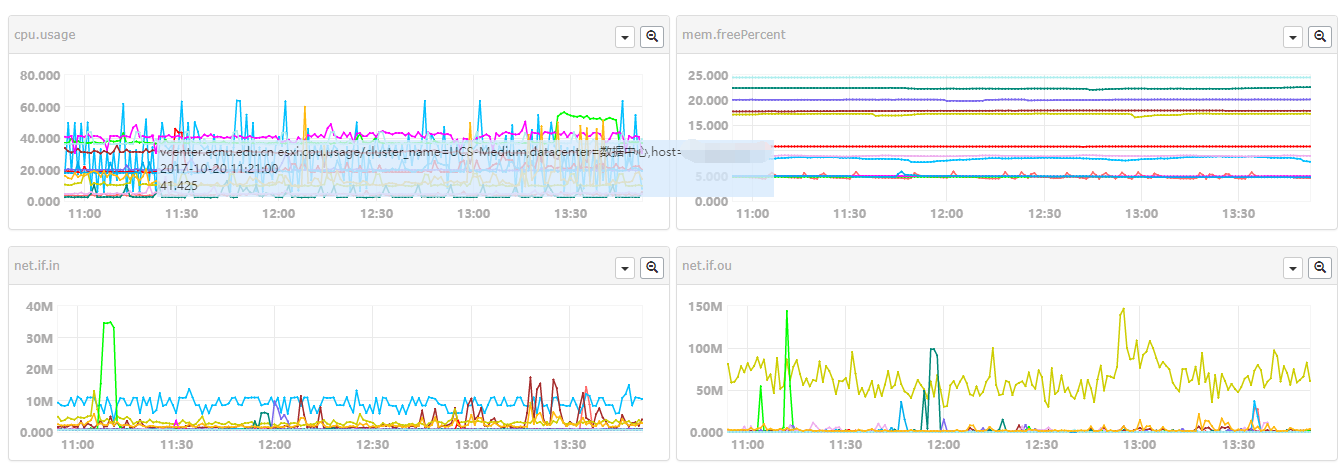

+ * [ESXi监控](usage/esxi.md)

+ * [Windows主机监控](usage/win.md)

+ * [HAProxy监控](usage/haproxy.md)

+ * [docker容器监控](usage/docker.md)

+ * [Nginx监控](usage/ngx_metric.md)

+ * [JMX监控](usage/jmx.md)

+ * [硬件监控](usage/hwcheck.md)

+ * [LVS监控](usage/lvs.md)

+ * [Url监控](usage/urlooker.md)

+ * [mesos](usage/mesos.md)

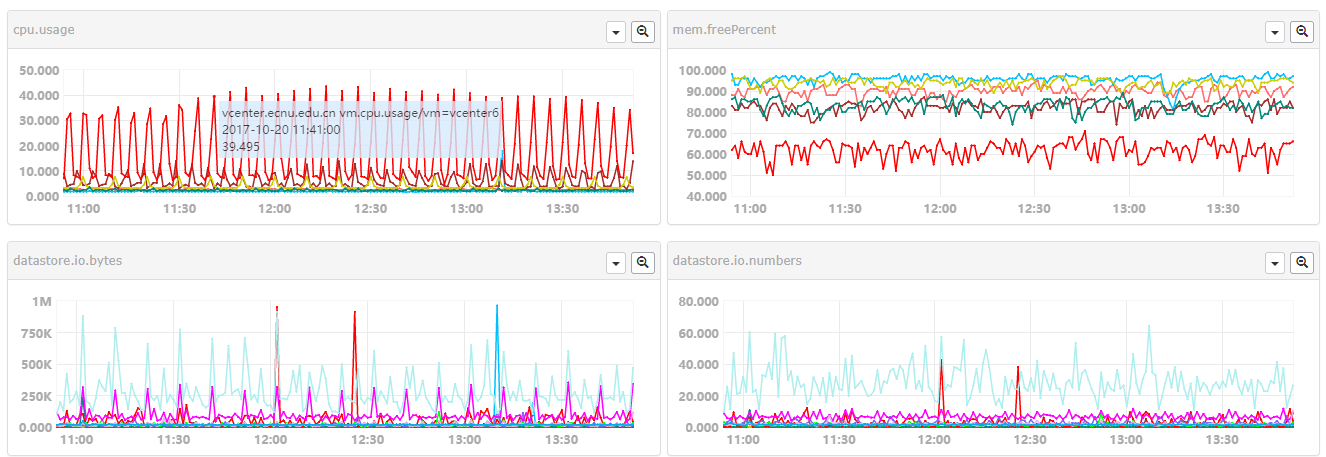

+ * [vSphere监控](usage/vsphere.md)

+ * [Flume监控](usage/flume.md)

+ * [目录和进程资源监控](usage/du-proc.md)

+ * [故障自愈](usage/fault-recovery.md)

+ * [VSphere和ESXI监控](usage/vsphere-esxi.md)

+

+### 第 Ⅳ 部分:理念

+* [设计理念](philosophy/README.md)

+ * [数据模型](philosophy/data-model.md)

+ * [话说数据采集](philosophy/data-collect.md)

+ * [plugin机制](philosophy/plugin.md)

+ * [Tag和HostGroup](philosophy/tags-and-hostgroup.md)

+* [二次开发](dev/README.md)

+ * [社区贡献](dev/community_resource.md)

+ * [修改绘图曲线精度](dev/change_graph_rra.md)

+ * [修改网卡流量单位](dev/change_net_unit.md)

+ * [支持 Grafana 视图展现](dev/support_grafana.md)

+ * [API](api/README.md)

+* [实践经验](practice/README.md)

+ * [部署](practice/deploy.md)

+ * [自监控](practice/monitor.md)

+ * [Graph扩容二三事](practice/graph-scaling.md)

+

+### 第 Ⅴ 部分:FAQ

+* [FAQ](faq/README.md)

+ * [采集相关](faq/collect.md)

+ * [报警相关](faq/alarm.md)

+ * [绘图相关](faq/graph.md)

+ * [Linux常用监控指标](faq/linux-metrics.md)

+ * [QQ群问答整理](faq/qq.md)

+* [Changelog](changelog/README.md)

diff --git a/zh_0_3/api/README.md b/zh_0_3/api/README.md

new file mode 100644

index 0000000..45f742f

--- /dev/null

+++ b/zh_0_3/api/README.md

@@ -0,0 +1,2 @@

+# open-falcon api

+- [api v0.2](http://open-falcon.com/falcon-plus/)

diff --git a/zh_0_3/authors.md b/zh_0_3/authors.md

new file mode 100644

index 0000000..aa9601e

--- /dev/null

+++ b/zh_0_3/authors.md

@@ -0,0 +1 @@

+../zh/authors.md

\ No newline at end of file

diff --git a/zh_0_3/changelog/README.md b/zh_0_3/changelog/README.md

new file mode 100644

index 0000000..258bafe

--- /dev/null

+++ b/zh_0_3/changelog/README.md

@@ -0,0 +1,117 @@

+

+

+## [v0.2.0] 2017-06-17

+

+> https://github.com/open-falcon/falcon-plus/releases/tag/v0.2.0

+

+> http://www.jianshu.com/p/6fb2c2b4d030

+

+> **全新的前端**

+

+- Open-Falcon 所有前端组件进行了统一整合,包括dashboard、screen、portal、alarm-dashboard、UIC、fe、links等统一整合到了 [dashboard](https://github.com/open-falcon/dashboard) 组件;

+- Dashboard 全站增加权限控制;

+- Dashboard 增加删除指定 endpoint、counter 以及对应的 rrd 文件的功能;

+- Dashboard 首页默认展示 endpoint 列表,并支持 endpoint 列表和 counter 列表翻页功能;

+- Dashboard 增加删除一级 screen 的功能;

+- 支持将报警的 callback 参数和内容在 Dashboard 页面上展示;

+- 支持微信报警通道;

+- Dashboard 支持展示过往的历史报警信息;

+

+> **统一的后端**

+

+- alarm支持报警历史信息入库存储和展示;

+- 「报警合并」模块`links`的功能合并到统一前端 Dashboard 中,降低用户配置和维护成本;

+- 「报警发送」模块`sender`的功能合并到 alarm 中,降低用户配置和维护成本;

+- query的功能合并到了falcon-api组件中;

+- 支持非周期性上报数据存储;

+- agent支持通过自定义配置,只采集指定磁盘挂载点的磁盘监控数据;

+- agent支持配置一个默认 tag,这样通过该 agent 上报的所有数据都会自动追加这个tag;

+- judge新增报警判断函数`lookup(#num, limit)`,如果检测到过去num个周期内,有limit次符合条件就报警;

+

+> **过去那些等待已久的bugfix**

+

+- 修复grafana不支持metric含有大写字母的bug;

+- 修复agent写多个transfer高可用不生效的bug;

+- 修复agent发送数据给transfer的超时设置不合理的问题;

+

+> **全新的 [RESTful API](http://open-falcon.com/falcon-plus)**:让 open-falcon 没有难自动化的操作

+

+- 发布了全新设计的组件 falcon-api,falcon-plus 所有的功能都可以通过 RESTful API 来完成;

+- 统一前端 Dashboard 绝大部分功能都是通过 [falcon-plus](https://github.com/open-falcon/falcon-plus) [api](http://open-falcon.com/falcon-plus) 来实现;

+

+

+## [0.1.0] 2016-03-08

+

+> https://github.com/open-falcon/of-release/releases/tag/v0.1.0

+

+> http://www.jianshu.com/p/7751eb324a51

+

+### highlights

+- `文档` API梳理和文档完善 http://docs.openfalcon.apiary.io `OpenFalcon-team @hitripod`

+- `优化` graph集群扩容时,历史数据自动迁移 `OpenFalcon-team @yubo laiwei niean`

+- `优化` 数据上报的最小间隔,可以在配置文件中更改 `OpenFalcon-team @niean`

+- `新功能` 监控数据支持写入opentsdb `美团 OpenFalcon-team @Charlesdong`

+- `新功能` 适配支持grafana `快网 OpenFalcon-team @hitripod`

+- `新功能` 新增集群监控 `OpenFalcon-team @ulricqin`

+- `新功能` 新增nodata监控 `OpenFalcon-team @niean`

+- `新功能` agent内置URL监控 `@onlymellb`

+- `优化` agent支持对多个transfer的负载均衡 `@cmgs`

+- `优化` 往HostGroup中添加机器的时候如果发现机器名不存在,就直接插入host表 `@wkshare`

+- `优化` dashboard绘图线条采用深颜色的配色方案 `美团 OpenFalcon-team @skyeydemon`

+

+### changelog

+- [agent] 优化:agent支持配置多个transfer地址 @CMGS https://github.com/open-falcon/agent/pull/37

+- [agent] 优化:agent支持URL探测 @onlymellb https://github.com/open-falcon/agent/pull/27

+- [alarm] bugfix:修改beego api不兼容引起的编译报错 @ulricqin

+- [common] 新功能:增加tsdb的支持 @Charlesdong https://github.com/open-falcon/common/pull/2

+- [dashboard] 优化:checkbox均支持使用shift快捷多选 @skyeydemon https://github.com/open-falcon/dashboard/pull/14

+- [dashboard] 优化:绘图线条采用深颜色的配色方案 @skydemon https://github.com/open-falcon/dashboard/pull/13

+- [dashboard] 优化:日期选择框高亮当前时间,方便用户选择 @iambocai https://github.com/open-falcon/dashboard/pull/12

+- [dashboard] bugfix: 修复charts页面刷新时偶尔不出图的问题 @niean

+- [fe] bugfix:修改beego api不兼容引起的编译报错 @hitripod

+- [gateway] 优化:gateway支持配置多个transfer列表间负载均衡 @niean

+- [gateway] 优化:gateway引入perfcounter,用来统计gateway自身的稳定性指标 @niean

+- [graph] 数据上报的最小间隔,可以在配置文件中更改 @niean

+- [graph] graph集群扩容时,历史数据自动迁移 @yubo laiwei niean https://github.com/open-falcon/graph/pull/14

+- [hbs] 新功能:配置agent支持URL监控[url.check.health] onlymellb https://github.com/open-falcon/hbs/pull/4

+- [nodata] 新模块:当某些采集项超时未上报数据时,如果配置了nodata策略则会生成一条默认的数据 @niean

+- [portal] API: 增加了获取expression和strategy详情的API @modeyang

+- [portal] 优化:往HostGroup中添加机器的时候如果发现机器名存在,就直接插入host表 @wkshare https://github.com/open-falcon/portal/pull/4

+- [portal] 新功能:支持集群聚合监控 @ulricqin

+- [portal] 新功能:支持nodata @niean

+- [query] 增加API来支持Grafana展示 @hitripod https://github.com/open-falcon/query/pull/5

+- [transfer] 数据支持写入opentsdb @Charlesdong https://github.com/open-falcon/transfer/pull/5

+- [transfer] 数据上报周期的最小限制可配置 @niean https://github.com/open-falcon/transfer/pull/7

+- [transfer] migrating的功能从transfer中去除 @laiwei https://github.com/open-falcon/transfer/pull/8

+- [aggregator] 新模块:集群聚合监控 @ulricqin

+

+----

+## [0.0.5] 2015-08-20

+- [agent] new feature: 增加了udp、du相关采集项

+- [agent] bugfix: 修复了配置了新的插件需要重启agent的bug

+- [agent] bugfix: 修复了reload配置文件,hostname改动可能无法生效的问题 @oiooj

+- [alarm] bugfix: 修复了告警email中的换行问题

+- [alarm] bugfix: 修复了告警分级配置项为空时处理不当的问题

+- [alarm] enhancement: 修改http的默认端口为9912(之前为6060)

+- [transfer] new feature: 新增了数据双写的功能,即transfer可以将同一份数据发送到后端的多个graph或者judge,用于容灾

+- [transfer] enhancement: 发往judge的数据,按照时间戳做对齐和规整(与发往graph保持一致)

+- [transfer] bugfix: 修复transfer返回给客户端的结果中latency单位错误的问题

+- [graph] new feature: 新增了last API接口,可以返回指定counter最新的点

+- [query] new feature: 新增了last API接口,可以返回指定counter最新的点

+- [hbs] bugfix: 配合agent, 修复了配置了新的插件需要重启agent的bug

+- [plugin] new feature: 新增了插件项目,里面有一些常用的插件脚本

+- [gateway] 新增组件,解决网络分区后的监控数据回传问题。代码及功能描述,请移步到[这里](https://github.com/open-falcon/gateway);Gitbook中没有该组件的描述。

+

+

+## [0.0.4] 2015-06-09

+- [alarm] bugfix:修复告警邮件中的换行问题

+- [transfer] bugfix:当某个后端的graph宕机的时候,会引起transfer的发送能力下降

+- [graph] bugfix: 当存储rrd数据文件的目录不存在或者没有读写权限的时候,程序作退出处理

+- [fe] 新增了Golang版本的uic组件

+

+

+## [0.0.3] 2015-06-02

+ - [dashboard] bugfix: search counters by tags in screen

+ - [judge] enhancement: clean stale data in memory

+

+

diff --git a/zh_0_3/contributing.md b/zh_0_3/contributing.md

new file mode 100644

index 0000000..92c19e9

--- /dev/null

+++ b/zh_0_3/contributing.md

@@ -0,0 +1 @@

+../zh/contributing.md

\ No newline at end of file

diff --git a/zh_0_3/dev/README.md b/zh_0_3/dev/README.md

new file mode 100644

index 0000000..7cc5afa

--- /dev/null

+++ b/zh_0_3/dev/README.md

@@ -0,0 +1,23 @@

+

+

+# 环境准备

+

+请参考[环境准备](quick_install/prepare.md)

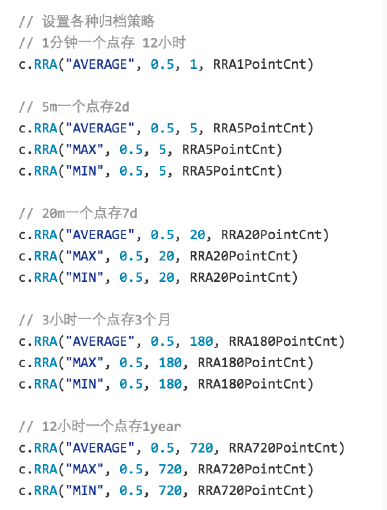

+# 自定义修改归档策略

+修改open-falcon/graph/rrdtool/rrdtool.go

+

+

+

+

+重新编译graph组件,并替换原有的二进制

+

+清理掉原来的所有rrd文件(默认在/home/work/data/6070/下面)

+

+# 插件机制

+1. 找一个git存放公司的所有插件

+2. 通过调用agent的/plugin/update接口拉取插件repo到本地

+3. 在portal中配置哪些机器可以执行哪些插件

+4. 插件命名方式:$step_xx.yy,需要有可执行权限,分门别类存放到repo的各个目录

+5. 把采集到的数据打印到stdout

+6. 如果觉得git方式不方便,可以改造agent,定期从某个http地址下载打包好的plugin.tar.gz

+

diff --git a/zh_0_3/dev/change_graph_rra.md b/zh_0_3/dev/change_graph_rra.md

new file mode 100644

index 0000000..62ea715

--- /dev/null

+++ b/zh_0_3/dev/change_graph_rra.md

@@ -0,0 +1,87 @@

+

+

+## 修改绘图曲线精度

+

+默认的,Open-Falcon只保存最近12小时的原始监控数据,12小时之后的数据被降低精度、采样存储。

+

+如果默认的精度不能满足你的需求,可以按照如下步骤,修改绘图曲线的存储精度。

+

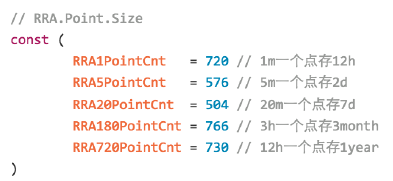

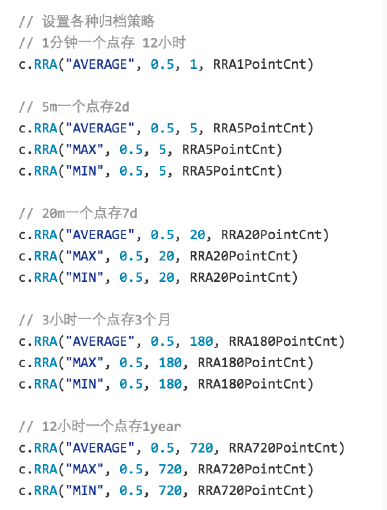

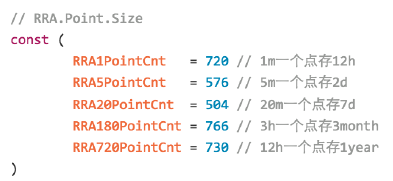

+#### 第一步,修改graph组件的RRA,并重新编译graph组件

+graph组件的RRA,定义在文件 graph/rrdtool/[rrdtool.go](https://github.com/open-falcon/graph/blob/master/rrdtool/rrdtool.go#L57)中,默认如下:

+

+```golang

+// RRA.Point.Size

+const (

+ RRA1PointCnt = 720 // 1m一个点存12h

+ RRA5PointCnt = 576 // 5m一个点存2d

+ // ...

+)

+

+func create(filename string, item *cmodel.GraphItem) error {

+ now := time.Now()

+ start := now.Add(time.Duration(-24) * time.Hour)

+ step := uint(item.Step)

+

+ c := rrdlite.NewCreator(filename, start, step)

+ c.DS("metric", item.DsType, item.Heartbeat, item.Min, item.Max)

+

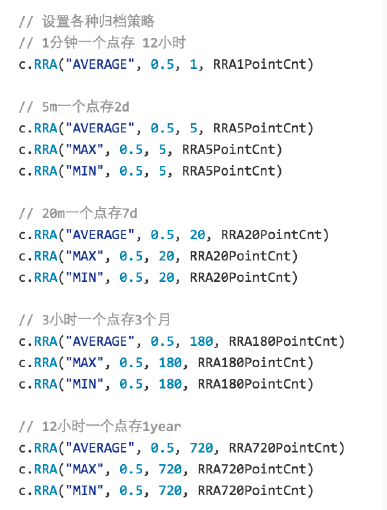

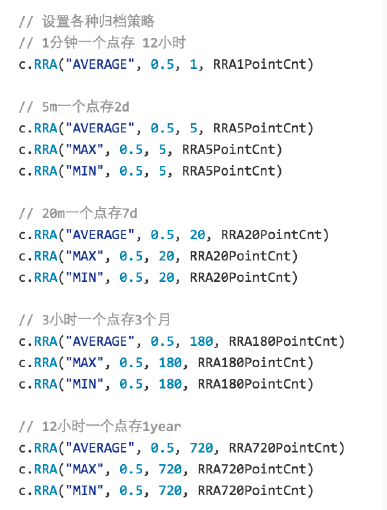

+ // 设置各种归档策略

+ // 1分钟一个点存 12小时

+ c.RRA("AVERAGE", 0.5, 1, RRA1PointCnt)

+

+ // 5m一个点存2d

+ c.RRA("AVERAGE", 0.5, 5, RRA5PointCnt)

+ c.RRA("MAX", 0.5, 5, RRA5PointCnt)

+ c.RRA("MIN", 0.5, 5, RRA5PointCnt)

+

+ // ...

+

+ return c.Create(true)

+}

+

+```

+

+比如,你只想保存90天的原始数据,可以将代码修改为:

+

+```golang

+// RRA.Point.Size

+const (

+ RRA1PointCnt = 129600 // 1m一个点存90d,取值 90*24*3600/60

+)

+

+func create(filename string, item *cmodel.GraphItem) error {

+ now := time.Now()

+ start := now.Add(time.Duration(-24) * time.Hour)

+ step := uint(item.Step)

+

+ c := rrdlite.NewCreator(filename, start, step)

+ c.DS("metric", item.DsType, item.Heartbeat, item.Min, item.Max)

+

+ // 设置各种归档策略

+ // 1分钟一个点存 90d

+ c.RRA("AVERAGE", 0.5, 1, RRA1PointCnt)

+

+ return c.Create(true)

+}

+```

+

+#### 第二步,清除graph的历史数据

+清除已上报的所有指标的历史数据,即删除所有的rrdfile。不删除历史数据,已上报指标的精度更改将不能生效。

+

+#### 第三步,重新部署graph服务

+编译修改后的graph源码,关停原有的graph老服务、发布修改后的graph。

+

+只需要修改graph组件、不需要修改Open-Falcon的其他组件,新的精度就能生效。你可以通过Dashboard、Screen来查看新的精度的绘图曲线。

+

+

+

+### 注意事项:

+

+修改监控绘图曲线精度时,需要:

+

++ 修改graph源代码,更新RRA

++ 清除graph的历史数据。不删除历史数据,已上报指标的精度更改将不能生效

++ 除了graph之外,Open-Falcon的其他任何组件 不需要被修改

++ 修改RRA后,可能会出现"绘图曲线点数过多、浏览器被卡死"的问题。请合理规划RRA存储的点数,或者调整绘图曲线查询时的时间段选择。

+

+

diff --git a/zh_0_3/dev/change_net_unit.md b/zh_0_3/dev/change_net_unit.md

new file mode 100644

index 0000000..1fbfaa6

--- /dev/null

+++ b/zh_0_3/dev/change_net_unit.md

@@ -0,0 +1,92 @@

+

+

+## 修改网卡流量单位

+

+目前是以 Bytes 为单位,如果要改为 Bits 的话(如:Mbps),可以修改 agent 代码。

+

+采集原始网卡流量数据的代码 `github.com/toolkits/nux/ifstat.go`,如下:

+

+```golang

+func NetIfs(onlyPrefix []string) ([]*NetIf, error) {

+ ...

+

+ {

+

+ ...

+

+ netIf.InBytes, _ = strconv.ParseInt(fields[0], 10, 64)

+ netIf.InPackages, _ = strconv.ParseInt(fields[1], 10, 64)

+ netIf.InErrors, _ = strconv.ParseInt(fields[2], 10, 64)

+ netIf.InDropped, _ = strconv.ParseInt(fields[3], 10, 64)

+ netIf.InFifoErrs, _ = strconv.ParseInt(fields[4], 10, 64)

+ netIf.InFrameErrs, _ = strconv.ParseInt(fields[5], 10, 64)

+ netIf.InCompressed, _ = strconv.ParseInt(fields[6], 10, 64)

+ netIf.InMulticast, _ = strconv.ParseInt(fields[7], 10, 64)

+

+ netIf.OutBytes, _ = strconv.ParseInt(fields[8], 10, 64)

+ netIf.OutPackages, _ = strconv.ParseInt(fields[9], 10, 64)

+ netIf.OutErrors, _ = strconv.ParseInt(fields[10], 10, 64)

+ netIf.OutDropped, _ = strconv.ParseInt(fields[11], 10, 64)

+ netIf.OutFifoErrs, _ = strconv.ParseInt(fields[12], 10, 64)

+ netIf.OutCollisions, _ = strconv.ParseInt(fields[13], 10, 64)

+ netIf.OutCarrierErrs, _ = strconv.ParseInt(fields[14], 10, 64)

+ netIf.OutCompressed, _ = strconv.ParseInt(fields[15], 10, 64)

+

+ netIf.TotalBytes = netIf.InBytes + netIf.OutBytes

+ netIf.TotalPackages = netIf.InPackages + netIf.OutPackages

+ netIf.TotalErrors = netIf.InErrors + netIf.OutErrors

+ netIf.TotalDropped = netIf.InDropped + netIf.OutDropped

+

+ ret = append(ret, &netIf)

+ }

+

+ return ret, nil

+}

+```

+

+agent 相对应的代码 `github.com/open-falcon/agent/funcs/ifstats.go`,如下:

+

+```golang

+func CoreNetMetrics(ifacePrefix []string) []*model.MetricValue {

+

+ netIfs, err := nux.NetIfs(ifacePrefix)

+ if err != nil {

+ log.Println(err)

+ return []*model.MetricValue{}

+ }

+

+ cnt := len(netIfs)

+ ret := make([]*model.MetricValue, cnt*20)

+

+ for idx, netIf := range netIfs {

+ iface := "iface=" + netIf.Iface

+ ret[idx*20+0] = CounterValue("net.if.in.bytes", netIf.InBytes, iface)

+ ret[idx*20+1] = CounterValue("net.if.in.packets", netIf.InPackages, iface)

+ ret[idx*20+2] = CounterValue("net.if.in.errors", netIf.InErrors, iface)

+ ret[idx*20+3] = CounterValue("net.if.in.dropped", netIf.InDropped, iface)

+ ret[idx*20+4] = CounterValue("net.if.in.fifo.errs", netIf.InFifoErrs, iface)

+ ret[idx*20+5] = CounterValue("net.if.in.frame.errs", netIf.InFrameErrs, iface)

+ ret[idx*20+6] = CounterValue("net.if.in.compressed", netIf.InCompressed, iface)

+ ret[idx*20+7] = CounterValue("net.if.in.multicast", netIf.InMulticast, iface)

+ ret[idx*20+8] = CounterValue("net.if.out.bytes", netIf.OutBytes, iface)

+ ret[idx*20+9] = CounterValue("net.if.out.packets", netIf.OutPackages, iface)

+ ret[idx*20+10] = CounterValue("net.if.out.errors", netIf.OutErrors, iface)

+ ret[idx*20+11] = CounterValue("net.if.out.dropped", netIf.OutDropped, iface)

+ ret[idx*20+12] = CounterValue("net.if.out.fifo.errs", netIf.OutFifoErrs, iface)

+ ret[idx*20+13] = CounterValue("net.if.out.collisions", netIf.OutCollisions, iface)

+ ret[idx*20+14] = CounterValue("net.if.out.carrier.errs", netIf.OutCarrierErrs, iface)

+ ret[idx*20+15] = CounterValue("net.if.out.compressed", netIf.OutCompressed, iface)

+ ret[idx*20+16] = CounterValue("net.if.total.bytes", netIf.TotalBytes, iface)

+ ret[idx*20+17] = CounterValue("net.if.total.packets", netIf.TotalPackages, iface)

+ ret[idx*20+18] = CounterValue("net.if.total.errors", netIf.TotalErrors, iface)

+ ret[idx*20+19] = CounterValue("net.if.total.dropped", netIf.TotalDropped, iface)

+ }

+ return ret

+}

+```

+

+举例來说,我们可以直接在 agent 要上报数据的时候,将 Bit 转换为 Byte,同时修改 Counter 的名称,如下:

+

+```golang

+ret[idx*20+0] = CounterValue("net.if.in.bits", netIf.InBytes*8, iface)

+```

diff --git a/zh_0_3/dev/community_resource.md b/zh_0_3/dev/community_resource.md

new file mode 100644

index 0000000..7ef663b

--- /dev/null

+++ b/zh_0_3/dev/community_resource.md

@@ -0,0 +1,51 @@

+

+

+## 第三方监控插件

+* [Windows Agent](https://github.com/LeonZYang/agent)

+* [MySQL Monitor](https://github.com/open-falcon/mymon)

+* [Redis Monitor](https://github.com/ZhuoRoger/redismon)

+* [RPC Monitor](https://github.com/iambocai/falcon-monit-scripts)

+* [Switch Monitor](https://github.com/gaochao1/swcollector)

+* [Falcon-Agent宕机监控](https://github.com/freedomkk-qfeng/falcon-scripts/tree/master/agent_monitor)

+* [memcached](https://github.com/iambocai/falcon-monit-scripts/tree/master/memcached)

+* [Docker 监控Lib库](https://github.com/HunanTV/eru-metric)

+* [mesos 监控](https://github.com/mesos-utility/mesos-metrics)

+* [Winodws/Linux 自动汇报资产](https://github.com/triaquae/MadKing)

+* [Nginx监控: 企业级监控标准](https://github.com/GuyCheung/falcon-ngx_metric)

+* [JMX监控: 基于open-falcon的jmx监控插件](https://github.com/toomanyopenfiles/jmxmon)

+* [适配Open-Falcon的综合监控SuitAgent](https://github.com/cqyijifu/OpenFalcon-SuitAgent)

+* [Baidu-RPC Monitor](https://github.com/solrex/brpc-open-falcon)

+* [Elasticsearch Monitor](https://github.com/solrex/es-open-falcon)

+* [Redis Monitor (多实例)](https://github.com/solrex/redis-open-falcon)

+* [SSDB Monitor](https://github.com/solrex/ssdb-open-falcon)

+* [ActiveMQ](https://github.com/zhaoxiaole/falcon-plugin/tree/master/ActiveMQ)

+* [统计每个cpu core 详情的插件脚本](https://github.com/open-falcon/plugin/blob/master/common/60_stats_per_cpu_core.py)

+* [统计进程资源消耗的插件脚本](https://github.com/open-falcon/plugin/blob/master/common/60_proc_resource_status.py)

+* [针对falcon开发的监控脚本和服务](https://github.com/sageskr/monitor)

+* [Windows metrics collector](https://github.com/freedomkk-qfeng/falcon-scripts/tree/master/windows_collect)

+* [Dell服务器硬件状态监控脚本](https://github.com/51web/hwcheck)

+

+## SDK

+* [Node.js perfcounter](https://github.com/efeiefei/openfalcon-perfcounter)

+* [Golang perfcounter](https://github.com/niean/goperfcounter)

+

+## 其他

+* [SMS sender](http://book.open-falcon.com/zh/install/mail-sms.html)

+* [Mail sender](https://github.com/niean/mailsender)

+* [Open-Falcon Ansible Playbook](https://github.com/iambocai/falcon-playbook)

+* [Open-Falcon Docker](https://github.com/frostynova/open-falcon-docker)

+

+## 讲稿

+* [OpenFalcon交流:一个适合在公司内部推广OpenFalcon的PPT](http://pan.baidu.com/s/1o7wsrUi)

+* [OpenFalcon @ SACC-2015](http://pan.baidu.com/s/1o6S6t1C)

+* OpenFalcon编写的整个脑洞历程: 开发过程中的权衡与折中

+* [OpenFalcon操作录屏演示 10多分钟](http://pan.baidu.com/s/1dEsW54P)

+* 小米开源监控系统OpenFalcon应对高并发7种手段

+

+

+## 会议

+

+#### 麒麟会技术沙龙-Open-Falcon v0.1.0 发布

+* [来炜——Open-Falcon新版特性解析和规划](http://pan.baidu.com/s/1dFsJa5j)

+* [谢丹博——Open-Falcon在美团的落地与升华](http://pan.baidu.com/s/1o8Cd3MM)

+* [欧曜玮——企业级监控平台的变革与演进](http://pan.baidu.com/s/1hsvuHKg)

diff --git a/zh_0_3/dev/support_grafana.md b/zh_0_3/dev/support_grafana.md

new file mode 100644

index 0000000..64b0ceb

--- /dev/null

+++ b/zh_0_3/dev/support_grafana.md

@@ -0,0 +1,14 @@

+

+

+## 支持 Grafana 视图展现

+

+相较于 Open-Falcon 内建的 Dashboard,Grafana 可以很有弹性的自定义图表,并且可以针对 Dashboard 做权限控管、上标签以及查询,图表的展示选项也更多样化。本篇教学帮助您

+做好 Open-Falcon 的面子工程!

+

+### 安装和使用步骤

+

+请参考 [grafana open-falcon](https://github.com/open-falcon/grafana-openfalcon-datasource)

+

+

+### 致谢

+- 感谢fastweb @kordan @masato25 等朋友的贡献;

diff --git a/zh_0_3/distributed_install/README.md b/zh_0_3/distributed_install/README.md

new file mode 100644

index 0000000..47f81ad

--- /dev/null

+++ b/zh_0_3/distributed_install/README.md

@@ -0,0 +1,26 @@

+

+

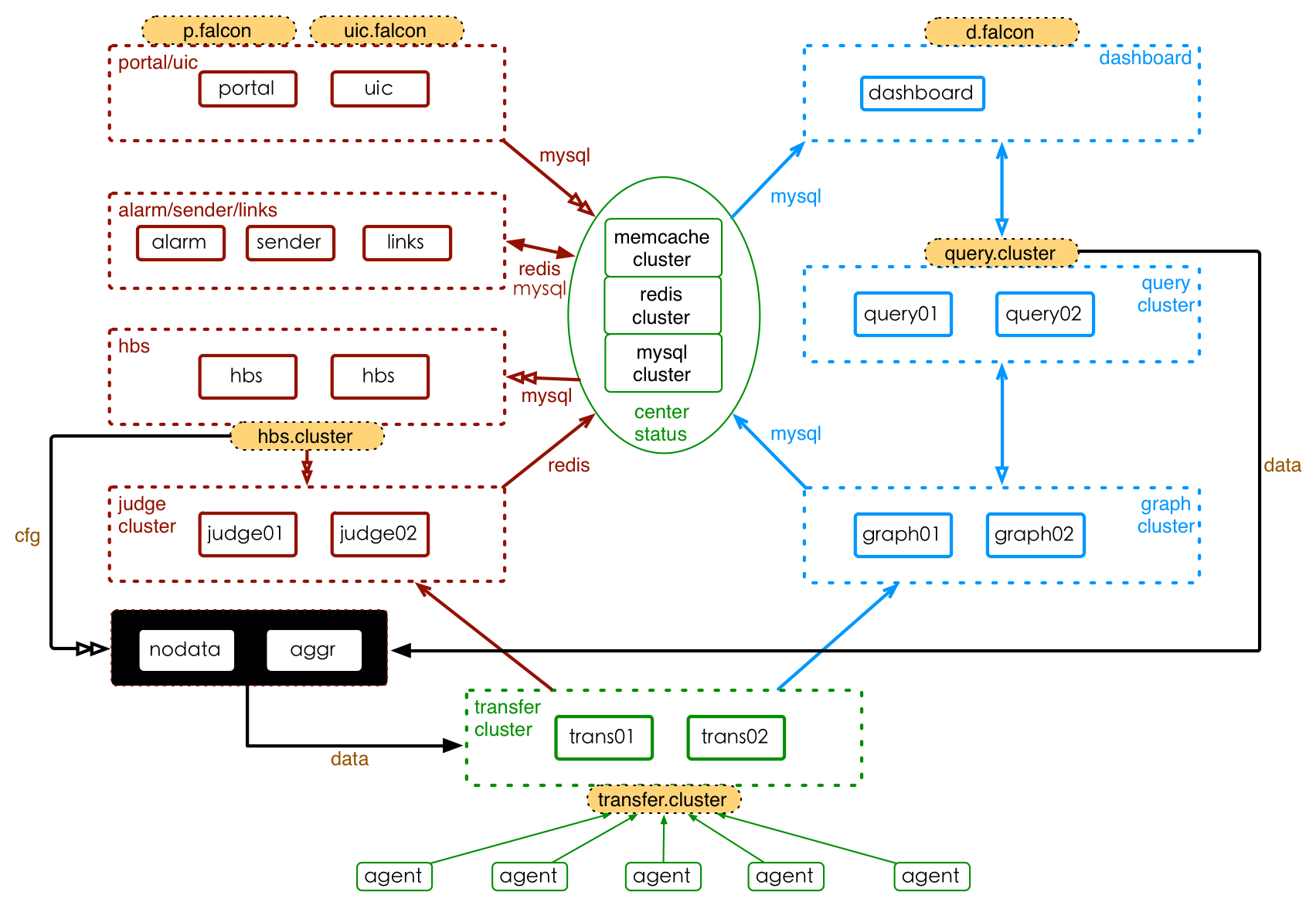

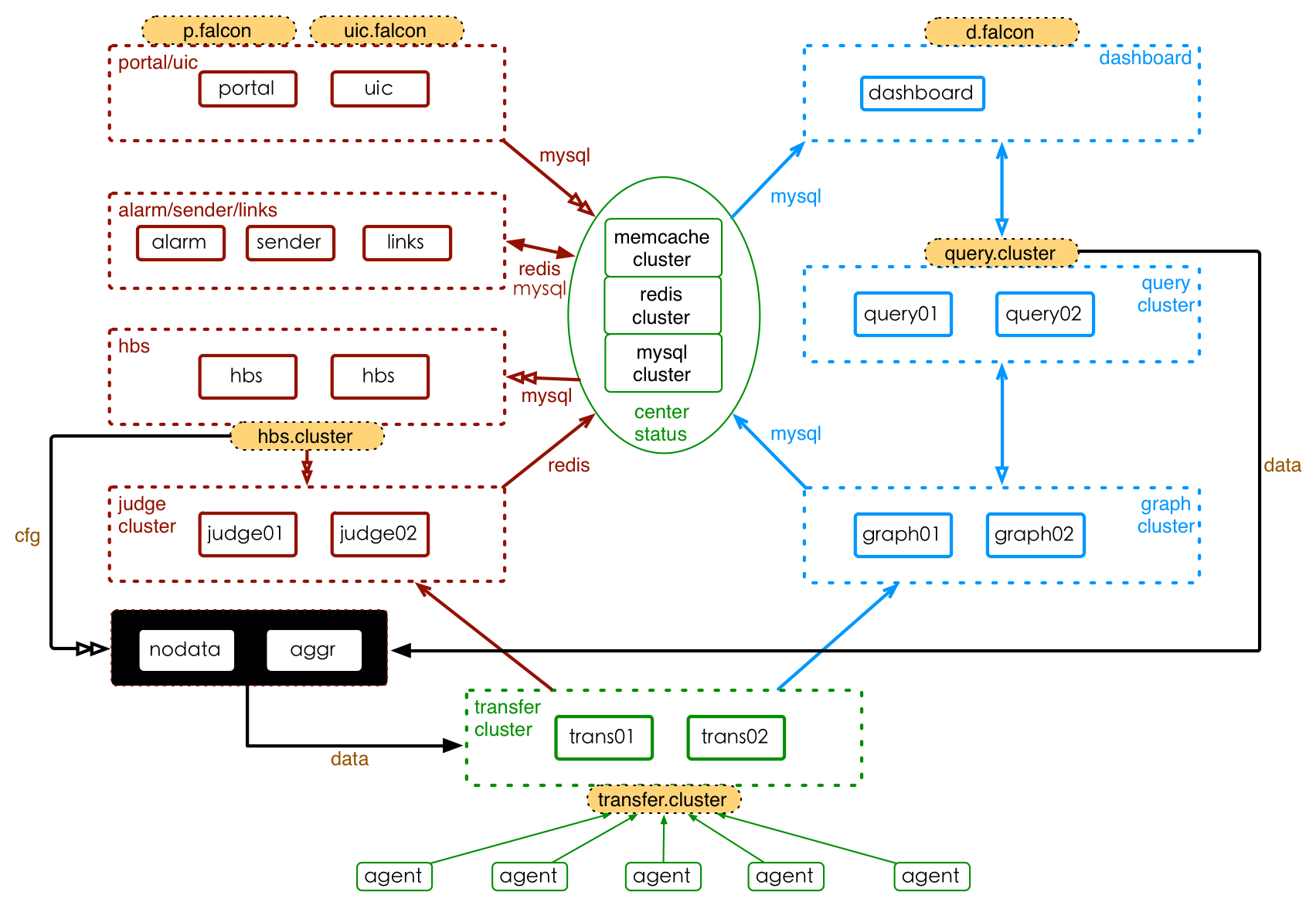

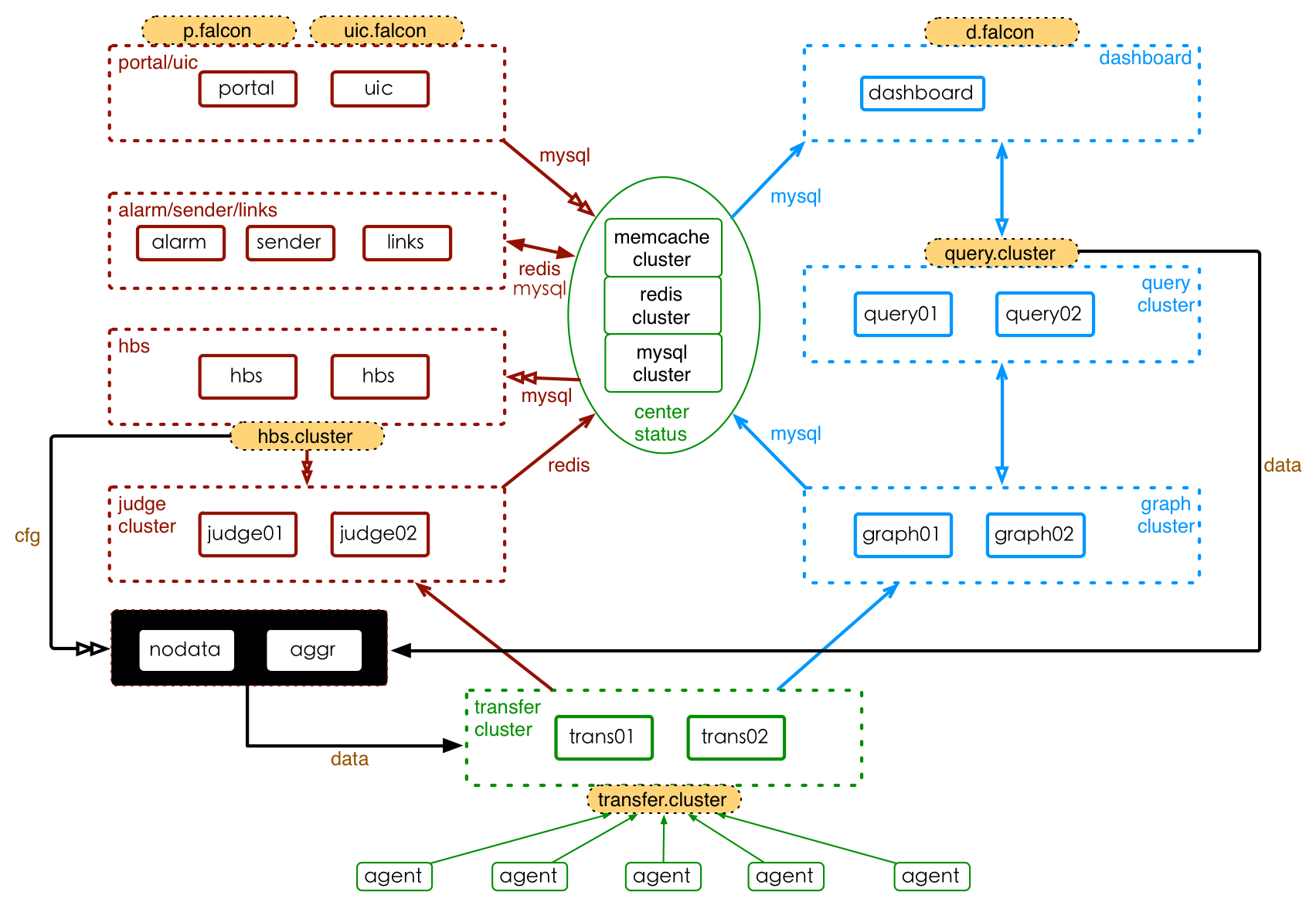

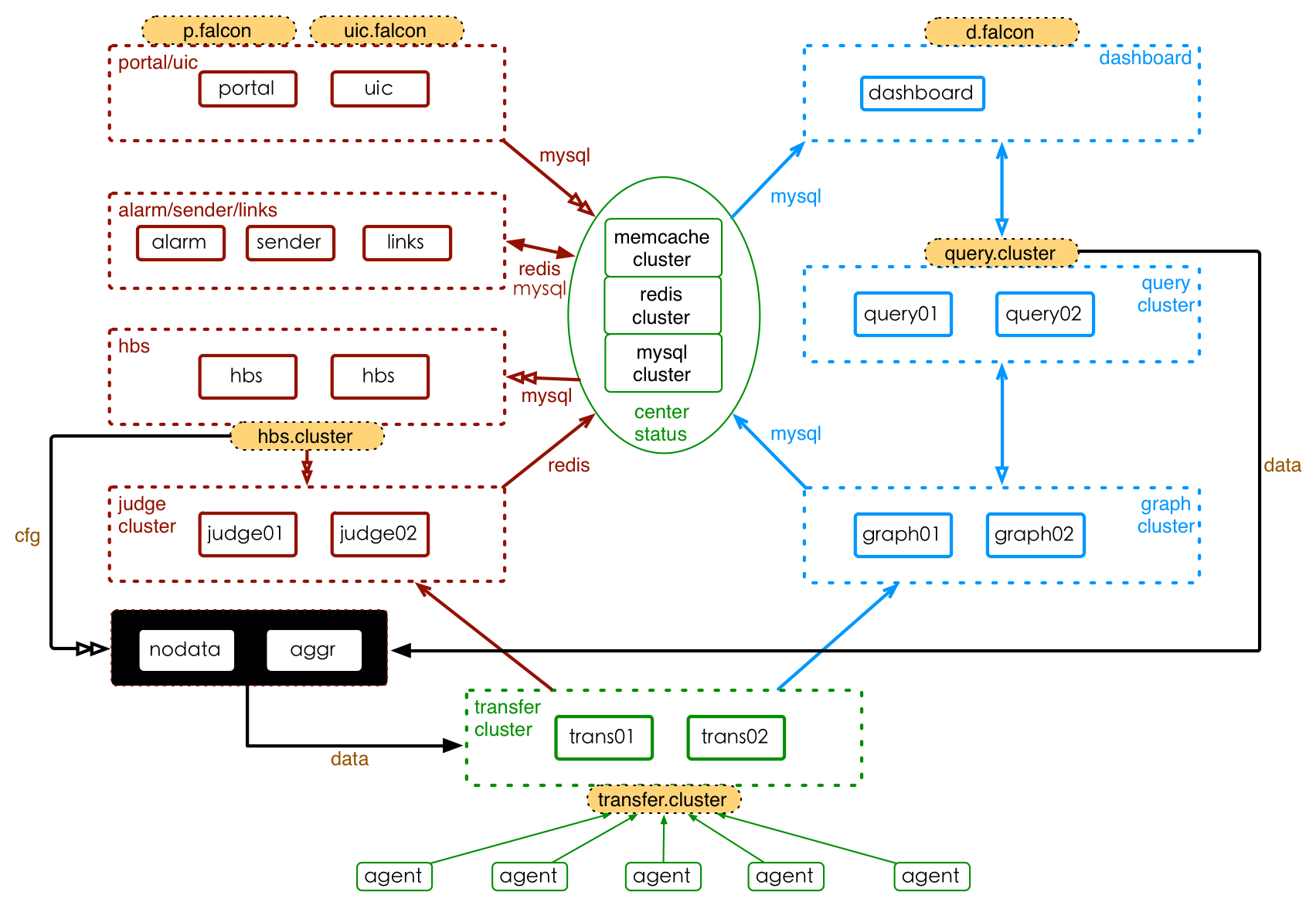

+# 概述

+

+Open-Falcon是一个比较大的分布式系统,有十几个组件。按照功能,这十几个组件可以划分为 基础组件、作图链路组件和报警链路组件,其安装部署的架构如下图所示,

+

+

+

+## 在单台机器上快速安装

+

+请直接参考[quick_install](../quick_install/README.md)

+

+## Docker化的Open-Falcon安装

+

+参考:

+- https://github.com/open-falcon/falcon-plus/blob/master/docker/README.md

+- https://github.com/open-falcon/dashboard/blob/master/README.md

+

+## 在多台机器上分布式安装

+

+在多台机器上,分布式安装open-falcon,就是本章的内容,请按照本章节的顺序,安装每个组件。

+

+## 视频教程教你安装

+

+《[Open-Falcon部署与架构解析](http://www.jikexueyuan.com/course/1651.html)》

+

diff --git a/zh_0_3/distributed_install/agent-updater.md b/zh_0_3/distributed_install/agent-updater.md

new file mode 100644

index 0000000..8b09ba9

--- /dev/null

+++ b/zh_0_3/distributed_install/agent-updater.md

@@ -0,0 +1,17 @@

+

+

+# Agent-updater

+

+每台机器都要部署falcon-agent,如果公司机器量比较少,用pssh、ansible、fabric之类的工具手工安装问题也不大。但是公司机器量多了之后,手工安装、升级、回滚falcon-agent将成为噩梦。

+

+个人开发了agent-updater这个工具,用于管理falcon-agent,agent-updater也有一个agent:ops-updater,可以看做是一个超级agent,用于管理其他agent的agent,呵呵,ops-updater推荐在装机的时候一起安装上。ops-updater通常是不会升级的。

+

+具体参看:https://github.com/open-falcon/ops-updater

+

+如果你想学习如何使用Go语言编写一个完整的项目,也可以研究一下agent-updater,我甚至录制了一个视频教程来演示一步一步如何开发出来的。课程链接:

+

+- http://www.jikexueyuan.com/course/1336.html

+- http://www.jikexueyuan.com/course/1357.html

+- http://www.jikexueyuan.com/course/1462.html

+- http://www.jikexueyuan.com/course/1490.html

+

diff --git a/zh_0_3/distributed_install/agent.md b/zh_0_3/distributed_install/agent.md

new file mode 100644

index 0000000..e9f6690

--- /dev/null

+++ b/zh_0_3/distributed_install/agent.md

@@ -0,0 +1,100 @@

+

+

+# Agent

+

+agent用于采集机器负载监控指标,比如cpu.idle、load.1min、disk.io.util等等,每隔60秒push给Transfer。agent与Transfer建立了长连接,数据发送速度比较快,agent提供了一个http接口/v1/push用于接收用户手工push的一些数据,然后通过长连接迅速转发给Transfer。

+

+## 部署说明

+

+agent需要部署到所有要被监控的机器上,比如公司有10万台机器,那就要部署10万个agent。agent本身资源消耗很少,不用担心。

+

+

+## 配置说明

+

+配置文件必须叫cfg.json,可以基于cfg.example.json修改

+

+```

+{

+ "debug": true, # 控制一些debug信息的输出,生产环境通常设置为false

+ "hostname": "", # agent采集了数据发给transfer,endpoint就设置为了hostname,默认通过`hostname`获取,如果配置中配置了hostname,就用配置中的

+ "ip": "", # agent与hbs心跳的时候会把自己的ip地址发给hbs,agent会自动探测本机ip,如果不想让agent自动探测,可以手工修改该配置

+ "plugin": {

+ "enabled": false, # 默认不开启插件机制

+ "dir": "./plugin", # 把放置插件脚本的git repo clone到这个目录

+ "git": "https://github.com/open-falcon/plugin.git", # 放置插件脚本的git repo地址

+ "logs": "./logs" # 插件执行的log,如果插件执行有问题,可以去这个目录看log

+ },

+ "heartbeat": {

+ "enabled": true, # 此处enabled要设置为true

+ "addr": "127.0.0.1:6030", # hbs的地址,端口是hbs的rpc端口

+ "interval": 60, # 心跳周期,单位是秒

+ "timeout": 1000 # 连接hbs的超时时间,单位是毫秒

+ },

+ "transfer": {

+ "enabled": true,

+ "addrs": [

+ "127.0.0.1:18433"

+ ], # transfer的地址,端口是transfer的rpc端口, 可以支持写多个transfer的地址,agent会保证HA

+ "interval": 60, # 采集周期,单位是秒,即agent一分钟采集一次数据发给transfer

+ "timeout": 1000 # 连接transfer的超时时间,单位是毫秒

+ },

+ "http": {

+ "enabled": true, # 是否要监听http端口

+ "listen": ":1988",

+ "backdoor": false

+ },

+ "collector": {

+ "ifacePrefix": ["eth", "em"], # 默认配置只会采集网卡名称前缀是eth、em的网卡流量,配置为空就会采集所有的,lo的也会采集。可以从/proc/net/dev看到各个网卡的流量信息

+ "mountPoint": []

+ },

+ "default_tags": {

+ },

+ "ignore": { # 默认采集了200多个metric,可以通过ignore设置为不采集

+ "cpu.busy": true,

+ "df.bytes.free": true,

+ "df.bytes.total": true,

+ "df.bytes.used": true,

+ "df.bytes.used.percent": true,

+ "df.inodes.total": true,

+ "df.inodes.free": true,

+ "df.inodes.used": true,

+ "df.inodes.used.percent": true,

+ "mem.memtotal": true,

+ "mem.memused": true,

+ "mem.memused.percent": true,

+ "mem.memfree": true,

+ "mem.swaptotal": true,

+ "mem.swapused": true,

+ "mem.swapfree": true

+ }

+}

+```

+

+## 进程管理

+

+```

+./open-falcon start agent 启动进程

+./open-falcon stop agent 停止进程

+./open-falcon monitor agent 查看日志

+

+```

+

+## 验证

+

+看var目录下的log是否正常,或者浏览器访问其1988端口。另外agent提供了一个`--check`参数,可以检查agent是否可以正常跑在当前机器上

+

+```

+./falcon-agent --check

+```

+

+## /v1/push接口

+

+我们设计初衷是不希望用户直接连到Transfer发送数据,而是通过agent的/v1/push接口转发,接口使用范例:

+

+```

+ts=`date +%s`; curl -X POST -d "[{\"metric\": \"metric.demo\", \"endpoint\": \"qd-open-falcon-judge01.hd\", \"timestamp\": $ts,\"step\": 60,\"value\": 9,\"counterType\": \"GAUGE\",\"tags\": \"project=falcon,module=judge\"}]" http://127.0.0.1:1988/v1/push

+```

+

+## 视频教程

+

+为该模块录制了一个视频,做了源码级解读:http://www.jikexueyuan.com/course/2242.html

diff --git a/zh_0_3/distributed_install/aggregator.md b/zh_0_3/distributed_install/aggregator.md

new file mode 100644

index 0000000..126fe24

--- /dev/null

+++ b/zh_0_3/distributed_install/aggregator.md

@@ -0,0 +1,54 @@

+

+

+# Aggregator

+

+集群聚合模块。聚合某集群下的所有机器的某个指标的值,提供一种集群视角的监控体验。

+

+

+## 服务部署

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```

+# 修改配置, 配置项含义见下文

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./open-falcon start aggregator

+

+# 检查log

+./open-falcon monitor aggregator

+

+# 停止服务

+./open-falcon stop aggregator

+

+```

+

+

+## 配置说明

+配置文件默认为./cfg.json。默认情况下,安装包会有一个cfg.example.json的配置文件示例。各配置项的含义,如下

+

+```

+{

+ "debug": true,

+ "http": {

+ "enabled": true,

+ "listen": "0.0.0.0:6055"

+ },

+ "database": {

+ "addr": "root:@tcp(127.0.0.1:3306)/falcon_portal?loc=Local&parseTime=true", // 如数据库使用密码, 配置稍有不同: "addr": "root:password@tcp(127.0.0.1:3306)/falcon_portal?loc=Local&parseTime=true&allowNativePasswords=true"

+ "idle": 10,

+ "ids": [1, -1],

+ "interval": 55

+ },

+ "api": {

+ "connect_timeout": 500,

+ "request_timeout": 2000,

+ "plus_api": "http://127.0.0.1:8080", #falcon-plus api模块的运行地址

+ "plus_api_token": "default-token-used-in-server-side", #和falcon-plus api 模块交互的认证token

+ "push_api": "http://127.0.0.1:1988/v1/push" #push数据的http接口,这是agent提供的接口

+ }

+}

+

+

+```

diff --git a/zh_0_3/distributed_install/alarm.md b/zh_0_3/distributed_install/alarm.md

new file mode 100644

index 0000000..c254ff7

--- /dev/null

+++ b/zh_0_3/distributed_install/alarm.md

@@ -0,0 +1,90 @@

+

+

+# Alarm

+

+alarm模块是处理报警event的,judge产生的报警event写入redis,alarm从redis读取处理,并进行不同渠道的发送。

+

+## 设计初衷

+

+报警event的处理逻辑并非仅仅是发邮件、发短信这么简单。为了能够自动化对event做处理,alarm需要支持在产生event的时候回调用户提供的接口;有的时候报警短信、邮件太多,对于优先级比较低的报警,希望做报警合并,这些逻辑都是在alarm中做的。

+

+我们在配置报警策略的时候配置了报警级别,比如P0/P1/P2等等,每个及别的报警都会对应不同的redis队列 alarm去读取这个数据的时候我们希望先读取P0的数据,再读取P1的数据,最后读取P5的数据,因为我们希望先处理优先级高的。于是:用了redis的brpop指令。

+

+已经发送的告警信息,alarm会写入MySQL中保存,这样用户就可以在dashboard中查阅历史报警,同时针对同一个策略发出的多条报警,在MySQL存储的时候,会聚类;历史报警保存的周期,是可配置的,默认为7天。

+

+## 部署说明

+

+alarm是个单点。对于未恢复的告警是放到alarm的内存中的,alarm还需要做报警合并,故而alarm只能部署一个实例。需要对alarm的存活做好监控。

+

+## 配置说明

+

+配置文件必须叫cfg.json,可以基于cfg.example.json修改

+

+```

+{

+ "log_level": "debug",

+ "http": {

+ "enabled": true,

+ "listen": "0.0.0.0:9912"

+ },

+ "redis": {

+ "addr": "127.0.0.1:6379",

+ "maxIdle": 5,

+ "highQueues": [

+ "event:p0",

+ "event:p1",

+ "event:p2"

+ ],

+ "lowQueues": [

+ "event:p3",

+ "event:p4",

+ "event:p5",

+ "event:p6"

+ ],

+ "userIMQueue": "/queue/user/im",

+ "userSmsQueue": "/queue/user/sms",

+ "userMailQueue": "/queue/user/mail"

+ },

+ "api": {

+ "im": "http://127.0.0.1:10086/wechat", //微信发送网关地址

+ "sms": "http://127.0.0.1:10086/sms", //短信发送网关地址

+ "mail": "http://127.0.0.1:10086/mail", //邮件发送网关地址

+ "dashboard": "http://127.0.0.1:8081", //dashboard模块的运行地址

+ "plus_api":"http://127.0.0.1:8080", //falcon-plus api模块的运行地址

+ "plus_api_token": "default-token-used-in-server-side" //用于和falcon-plus api模块服务端之间的通信认证token

+ },

+ "falcon_portal": {

+ "addr": "root:@tcp(127.0.0.1:3306)/alarms?charset=utf8&loc=Asia%2FChongqing",

+ "idle": 10,

+ "max": 100

+ },

+ "worker": {

+ "im": 10,

+ "sms": 10,

+ "mail": 50

+ },

+ "housekeeper": {

+ "event_retention_days": 7, //报警历史信息的保留天数

+ "event_delete_batch": 100

+ }

+}

+

+```

+## 进程管理

+

+```

+# 启动

+./open-falcon start alarm

+

+# 停止

+./open-falcon stop alarm

+

+# 查看日志

+./open-falcon monitor alarm

+```

+

+## 报警合并

+

+如果某个核心服务挂了,可能会造成大面积报警,为了减少报警短信数量,我们做了报警合并功能。把报警信息写入dashboard模块,然后dashboard返回一个url地址给alarm,alarm将这个url链接发给用户,这样用户只要收到一条短信(里边是个url地址),点击url进去就是多条报警内容。

+

+highQueues中配置的几个event队列中的事件是不会做报警合并的,因为那些是高优先级的报警,报警合并只是针对lowQueues中的事件。如果所有的事件都不想做报警合并,就把所有的event队列都配置到highQueues中即可

\ No newline at end of file

diff --git a/zh_0_3/distributed_install/api.md b/zh_0_3/distributed_install/api.md

new file mode 100644

index 0000000..7e652d8

--- /dev/null

+++ b/zh_0_3/distributed_install/api.md

@@ -0,0 +1,67 @@

+

+

+# API

+api组件,提供统一的restAPI操作接口。比如:api组件接收查询请求,根据一致性哈希算法去相应的graph实例查询不同metric的数据,然后汇总拿到的数据,最后统一返回给用户。

+

+## 服务部署

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```

+# 修改配置, 配置项含义见下文, 注意graph集群的配置

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./open-falcon start api

+

+# 停止服务

+./open-falcon stop api

+

+# 查看日志

+./open-falcon monitor api

+

+```

+

+## 配置说明

+

+注意: 请确保 `graphs`的内容与transfer的配置**完全一致**

+

+```

+{

+ "log_level": "debug",

+ "db": { //数据库相关的连接配置信息

+ //如数据库使用密码, 配置方式稍有不同, 示例: "dsn": "root:password@tcp(127.0.0.1:3306)/graph?loc=Local&parseTime=true&allowNativePasswords=true"

+ "faclon_portal": "root:@tcp(127.0.0.1:3306)/falcon_portal?charset=utf8&parseTime=True&loc=Local",

+ "graph": "root:@tcp(127.0.0.1:3306)/graph?charset=utf8&parseTime=True&loc=Local",

+ "uic": "root:@tcp(127.0.0.1:3306)/uic?charset=utf8&parseTime=True&loc=Local",

+ "dashboard": "root:@tcp(127.0.0.1:3306)/dashboard?charset=utf8&parseTime=True&loc=Local",

+ "alarms": "root:@tcp(127.0.0.1:3306)/alarms?charset=utf8&parseTime=True&loc=Local",

+ "db_bug": true

+ },

+ "graphs": { // graph模块的部署列表信息

+ "cluster": {

+ "graph-00": "127.0.0.1:6070"

+ },

+ "max_conns": 100,

+ "max_idle": 100,

+ "conn_timeout": 1000,

+ "call_timeout": 5000,

+ "numberOfReplicas": 500

+ },

+ "metric_list_file": "./api/data/metric",

+ "web_port": ":8080", // http监听端口

+ "access_control": true, // 如果设置为false,那么任何用户都可以具备管理员权限

+ "salt": "pleaseinputwhichyouareusingnow", //数据库加密密码的时候的salt

+ "skip_auth": false, //如果设置为true,那么访问api就不需要经过认证

+ "default_token": "default-token-used-in-server-side", //用于服务端各模块间的访问授权

+ "gen_doc": false,

+ "gen_doc_path": "doc/module.html"

+}

+

+

+

+```

+

+## 补充说明

+- 部署完成api组件后,请修改dashboard组件的配置、使其能够正确寻址到api组件。

+- 请确保api组件的graph列表 与 transfer的配置 一致。

diff --git a/zh_0_3/distributed_install/gateway.md b/zh_0_3/distributed_install/gateway.md

new file mode 100644

index 0000000..88432d6

--- /dev/null

+++ b/zh_0_3/distributed_install/gateway.md

@@ -0,0 +1,7 @@

+

+

+# Gateway

+

+**如果您没有遇到机房分区问题,请直接忽略此组件**。

+

+如果您已经遇到机房分区问题、并急需解决机房分区时监控数据回传的问题,请使用该组件。更多的资料在[这里](https://github.com/open-falcon/falcon-plus/blob/master/modules/gateway/README.md)。

diff --git a/zh_0_3/distributed_install/graph.md b/zh_0_3/distributed_install/graph.md

new file mode 100644

index 0000000..ddc6160

--- /dev/null

+++ b/zh_0_3/distributed_install/graph.md

@@ -0,0 +1,64 @@

+

+

+# Graph

+

+graph是存储绘图数据的组件。graph组件 接收transfer组件推送上来的监控数据,同时处理api组件的查询请求、返回绘图数据。

+

+## 服务部署

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```

+# 修改配置, 配置项含义见下文

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./open-falcon start graph

+

+# 停止服务

+./open-falcon stop graph

+

+# 查看日志

+./open-falcon monitor graph

+

+```

+

+## 配置说明

+配置文件默认为./cfg.json。默认情况下,安装包会有一个cfg.example.json的配置文件示例。各配置项的含义,如下

+

+```

+{

+ "debug": false, //true or false, 是否开启debug日志

+ "http": {

+ "enabled": true, //true or false, 表示是否开启该http端口,该端口为控制端口,主要用来对graph发送控制命令、统计命令、debug命令

+ "listen": "0.0.0.0:6071" //表示监听的http端口

+ },

+ "rpc": {

+ "enabled": true, //true or false, 表示是否开启该rpc端口,该端口为数据接收端口

+ "listen": "0.0.0.0:6070" //表示监听的rpc端口

+ },

+ "rrd": {

+ "storage": "./data/6070" // 历史数据的文件存储路径(如有必要,请修改为合适的路)

+ },

+ "db": {

+ // 所有的 graph 共用一个数据库

+ "dsn": "root:@tcp(127.0.0.1:3306)/graph?loc=Local&parseTime=true", //MySQL的连接信息,默认用户名是root,密码为空,host为127.0.0.1,database为graph(如有必要,请修改)

+ //如数据库使用密码, 配置稍有不同: "dsn": "root:password@tcp(127.0.0.1:3306)/graph?loc=Local&parseTime=true&allowNativePasswords=true"

+ "maxIdle": 4 //MySQL连接池配置,连接池允许的最大连接数,保持默认即可

+ },

+ "callTimeout": 5000, //RPC调用超时时间,单位ms

+ "ioWorkerNum": 64, //底层io.Worker的数量, 注意: 这个功能是v0.2.1版本之后引入的,v0.2.1版本之前的配置文件不需要该参数

+ "migrate": { //扩容graph时历史数据自动迁移

+ "enabled": false, //true or false, 表示graph是否处于数据迁移状态

+ "concurrency": 2, //数据迁移时的并发连接数,建议保持默认

+ "replicas": 500, //这是一致性hash算法需要的节点副本数量,建议不要变更,保持默认即可(必须和transfer的配置中保持一致)

+ "cluster": { //未扩容前老的graph实例列表

+ "graph-00" : "127.0.0.1:6070"

+ }

+ }

+}

+

+```

+

+## 补充说明

+部署完graph组件后,请修改transfer和api的配置,使这两个组件可以寻址到graph。

diff --git a/zh_0_3/distributed_install/hbs.md b/zh_0_3/distributed_install/hbs.md

new file mode 100644

index 0000000..03e88b2

--- /dev/null

+++ b/zh_0_3/distributed_install/hbs.md

@@ -0,0 +1,61 @@

+

+

+# HBS(Heartbeat Server)

+

+心跳服务器,公司所有agent都会连到HBS,每分钟发一次心跳请求。

+

+## 设计初衷

+

+Portal的数据库中有一个host表,维护了公司所有机器的信息,比如hostname、ip等等。这个表中的数据通常是从公司CMDB中同步过来的。但是有些规模小一些的公司是没有CMDB的,那此时就需要手工往host表中录入数据,这很麻烦。于是我们赋予了HBS第一个功能:agent发送心跳信息给HBS的时候,会把hostname、ip、agent version、plugin version等信息告诉HBS,HBS负责更新host表。

+

+falcon-agent有一个很大的特点,就是自发现,不用配置它应该采集什么数据,就自动去采集了。比如cpu、内存、磁盘、网卡流量等等都会自动采集。我们除了要采集这些基础信息之外,还需要做端口存活监控和进程数监控。那我们是否也要自动采集监听的端口和各个进程数目呢?我们没有这么做,因为这个数据量比较大,汇报上去之后用户大部分都是不关心的,太浪费。于是我们换了一个方式,只采集用户配置的。比如用户配置了对某个机器80端口的监控,我们才会去采集这个机器80端口的存活性。那agent如何知道自己应该采集哪些端口和进程呢?向HBS要,HBS去读取Portal的数据库,返回给agent。

+

+之后我们会介绍一个用于判断报警的组件:Judge,Judge需要获取所有的报警策略,让Judge去读取Portal的DB么?不太好。因为Judge的实例数目比较多,如果公司有几十万机器,Judge实例数目可能会是几百个,几百个Judge实例去访问Portal数据库,也是一个比较大的压力。既然HBS无论如何都要访问Portal的数据库了,那就让HBS去获取所有的报警策略缓存在内存里,然后Judge去向HBS请求。这样一来,对Portal DB的压力就会大大减小。

+

+

+## 部署说明

+

+hbs是可以水平扩展的,至少部署两个实例以保证可用性。一般一个实例可以搞定5000台机器,所以说,如果公司有10万台机器,可以部署20个hbs实例,前面架设lvs,agent中就配置上lvs vip即可。

+

+## 配置说明

+

+配置文件必须叫cfg.json,可以基于cfg.example.json修改

+

+```

+{

+ "debug": true,

+ "database": "root:password@tcp(127.0.0.1:3306)/falcon_portal?loc=Local&parseTime=true", # Portal的数据库地址

+ "hosts": "", # portal数据库中有个host表,如果表中数据是从其他系统同步过来的,此处配置为sync,否则就维持默认,留空即可

+ "maxIdle": 100,

+ "listen": ":6030", # hbs监听的rpc地址

+ "trustable": [""],

+ "http": {

+ "enabled": true,

+ "listen": "0.0.0.0:6031" # hbs监听的http地址

+ }

+}

+```

+

+## 进程管理

+

+```

+# 启动

+./open-falcon start hbs

+

+# 停止

+./open-falcon stop hbs

+

+# 查看日志

+./open-falcon monitor hbs

+

+```

+

+## 补充

+

+如果你先部署了agent,后部署的hbs,那咱们部署完hbs之后需要回去修改agent的配置,把agent配置中的heartbeat部分enabled设置为true,addr设置为hbs的rpc地址。如果hbs的配置文件维持默认,rpc端口就是6030,http端口是6031,agent中应该配置为hbs的rpc端口,小心别弄错了。

+

+

+## 视频教程

+

+为hbs模块录制了一个视频,做了源码级解读:http://www.jikexueyuan.com/course/1873.html

+

diff --git a/zh_0_3/distributed_install/judge.md b/zh_0_3/distributed_install/judge.md

new file mode 100644

index 0000000..fae87e7

--- /dev/null

+++ b/zh_0_3/distributed_install/judge.md

@@ -0,0 +1,74 @@

+

+

+# Judge

+

+Judge用于告警判断,agent将数据push给Transfer,Transfer不但会转发给Graph组件来绘图,还会转发给Judge用于判断是否触发告警。

+

+## 设计初衷

+

+因为监控系统数据量比较大,一台机器显然是搞不定的,所以必须要有个数据分片方案。Transfer通过一致性哈希来分片,每个Judge就只需要处理一小部分数据就可以了。所以判断告警的功能不能放在直接的数据接收端:Transfer,而应该放到Transfer后面的组件里。

+

+

+## 部署说明

+

+Judge监听了一个http端口,提供了一个http接口:/count,访问之,可以得悉当前Judge实例处理了多少数据量。推荐的做法是一个Judge实例处理50万~100万数据,用个5G~10G内存,如果所用物理机内存比较大,比如有128G,可以在一个物理机上部署多个Judge实例。

+

+## 配置说明

+

+配置文件必须叫cfg.json,可以基于cfg.example.json修改

+

+```

+{

+ "debug": true,

+ "debugHost": "nil",

+ "remain": 11,

+ "http": {

+ "enabled": true,

+ "listen": "0.0.0.0:6081"

+ },

+ "rpc": {

+ "enabled": true,

+ "listen": "0.0.0.0:6080"

+ },

+ "hbs": {

+ "servers": ["127.0.0.1:6030"], # hbs最好放到lvs vip后面,所以此处最好配置为vip:port

+ "timeout": 300,

+ "interval": 60

+ },

+ "alarm": {

+ "enabled": true,

+ "minInterval": 300, # 连续两个报警之间至少相隔的秒数,维持默认即可

+ "queuePattern": "event:p%v",

+ "redis": {

+ "dsn": "127.0.0.1:6379", # 与alarm、sender使用一个redis; Open-Falcon v0.3 支持设置redis密码,同时支持无认证格式,支持格式为 127.0.0.1:6379、@127.0.0.1:6379、auth@127.0.0.1:6379

+ "maxIdle": 5,

+ "connTimeout": 5000,

+ "readTimeout": 5000,

+ "writeTimeout": 5000

+ }

+ }

+}

+```

+

+remain这个配置详细解释一下:

+remain指定了judge内存中针对某个数据存多少个点,比如host01这个机器的cpu.idle的值在内存中最多存多少个,配置报警的时候比如all(#3),这个#后面的数字不能超过remain-1,一般维持默认就够用了

+

+## 进程管理

+

+我们提供了一个control脚本来完成常用操作

+

+```

+# 启动

+./open-falcon start judge

+

+# 停止

+./open-falcon stop judge

+

+# 查看日志

+./open-falcon monitor judge

+```

+

+## 视频教程

+

+为judge模块录制了一个视频,做了源码级解读:http://www.jikexueyuan.com/course/1850.html

+

diff --git a/zh_0_3/distributed_install/mail-sms.md b/zh_0_3/distributed_install/mail-sms.md

new file mode 100644

index 0000000..dede31f

--- /dev/null

+++ b/zh_0_3/distributed_install/mail-sms.md

@@ -0,0 +1,104 @@

+

+

+# 邮件、短信、微信、电话发送接口

+

+监控系统产生报警事件之后需要发送报警邮件或者报警短信,各个公司可能有自己的邮件服务器,有自己的邮件发送方法;有自己的短信通道,有自己的短信发送方法。falcon为了适配各个公司,在接入方案上做了一个规范,需要各公司提供http的短信和邮件发送接口。

+

+##### 短信发送http接口:

+

+```

+method: post

+params:

+ - content: 短信内容

+ - tos: 使用逗号分隔的多个手机号

+```

+

+#####邮件发送http接口:

+

+```

+method: post

+params:

+ - content: 邮件内容

+ - subject: 邮件标题

+ - tos: 使用逗号分隔的多个邮件地址

+```

+

+##### im发送http接口:

+

+```

+method: post

+params:

+ - content: im内容

+ - tos: 使用逗号分隔的多个im号码

+```

+

+不过你可以使用社区提供的 `邮件发送网关` 和 `微信网关`,或者使用灵犀提供的 [云告警通道](http://t.cn/RpkS0d2)。

+

+- [邮件网关](https://github.com/open-falcon/mail-provider)

+- [微信网关](https://github.com/Yanjunhui/chat)

+

+----

+# LinkedSee灵犀云通道短信/语音通知接入

+目前open-falcon支持LinkedSee灵犀云通道短信/语音通知API快速接入,只需一个API即可快速对接Open Falcon,快速让您拥有告警通知功能,90%的告警压缩比。云通道短信/语音通知接口接入步骤如下:

+

+#### 1、注册开通LinkedSee灵犀云通道

+LinkedSee灵犀云通道是专为IT运维打造的专属告警通道,多通道接入,最大程度避免堵塞,支持基于通知内容关键字的分析,合并同类事件,可以帮助您快速定位故障问题。访问LinkedSee灵犀标准版官网地址:[注册地址](http://t.cn/RpkS0d2)

+,注册灵犀账号,直接开通云通道服务。若已有账号,则直接登录即可。

+

+

+

+#### 2、创建应用

+注册成功后,登录系统进入控制台后,点击云通道进入工作台页面。击新建应用,创建应用,如下所示,输入应用名称之后点击保存。

+

+

+目前云通道提供短信告警、电话告警、短信通知、语音通知等4种使用场景,创建应用时默认开通短信告警和电话告警两种方式,为保证能正常接收到所有语音和短信告警,应确保短信和电话告警两种方式是打开状态。

+

+#### 3、获取应用token

+创建应用成功之后 ,点击查看应用token,如下所示:

+

+附注:token在后续的api接入步骤中使用。请复制后保存,以备后续使用。

+

+

+#### 4、获取token后拼接URL

+获取token后,需要跟LinkSee灵犀云通道的短信和语音告警url进行拼接:

+

+- 发送短信通知地址为:https://www.linkedsee.com/alarm/falcon_sms/`this_is_your_token`

+- 发送语音通知地址为:https://www.linkedsee.com/alarm/falcon_voice/`this_is_your_token`

+

+如若目前创建的应用的token为:d7a11a42aeac6848c3a389622f8,则:

+

+- 发送短信地址为:https://www.linkedsee.com/alarm/falcon_sms/d7a11a42aeac6848c3a389622f8

+- 发送语音告警的地址为:https://www.linkedsee.com/alarm/falcon_voice/d7a11a42aeac6848c3a389622f8

+

+#### 5、配置open-falcon:

+将上面的url配置在open-falcon alarm模块的配置文件cfg.json中,可以基于cfg.example.json修改,目前直接适配open-falcon v0.2。接口部分如下所示:

+

+```

+"api": {

+ "im": "http://127.0.0.1:10086/wechat", //微信发送网关地址

+ "sms": "http://127.0.0.1:10086/sms", //短信发送网关地址

+ "mail": "http://127.0.0.1:10086/mail", //邮件发送网关地址

+ "dashboard": "http://127.0.0.1:8081", //dashboard模块的运行地址

+ "plus_api":"http://127.0.0.1:8080", //falcon-plus api模块的运行地址

+ "plus_api_token": "default-token-used-in-server-side" //用于和falcon-plus api模块服务端之间的通信认证token

+ }

+```

+将step4的URL写在截图红框处, 如下所示:

+

+

+若发短信,则把短信发送网关地址替换为上一步中拼接的URL;若要发送语音消息,则将sms处的地址替换为语音对应的url。目前falcon暂不支持同时发送语音和短信通知,若要同时使用语音和短信报警,可以开通linkedsee云告警服务,同时还支持微信和邮件报警。

+

+#### 6、触发告警

+Open-Falcon配置完成后,请您触发一条告警,检查是否配置成功。目前Open-Falcon接入LinkedSee灵犀云通道之后,语⾳播报通道是固定内容的语⾳,若想使⽤动态语音播报和更多高级告警功能,欢迎使用云告警产品。>>[接入帮助](https://www.linkedsee.com/standard/support/#/access-falcon)

+

+附注:如果未成功,请确认是否按照上述步骤进行配置。如果确认没有问题,可以联系我们。我们将及时为您提供支持。热线电话:010-84148522

+

+#### 7、认证充值

+目前云通道免费版默认为短信10条,电话10通,完成接入配置之后,为保证信息安全,需要点击申请企业认证,填写企业认证相关信息审核通过之后即可充值购买更多的短信和语音告警数量。充值成功之后 ,可以查看用量统计和通知记录,帮助您更好的监控硬件性能,提升效率。

+

+

+#### 欢迎体验LinkedSee云告警高级服务

+- 一分钟拥有短信、微信、邮件、电话四种告警通知方式;

+- 支持告警升级策略、排班表及关键字合并策略;

+- 可以支持指定时间窗内的告警接收数量;

+- 多个维度的数据分析,更好的支持个性化需求;

diff --git a/zh_0_3/distributed_install/nodata.md b/zh_0_3/distributed_install/nodata.md

new file mode 100644

index 0000000..6cd2281

--- /dev/null

+++ b/zh_0_3/distributed_install/nodata.md

@@ -0,0 +1,61 @@

+

+

+# Nodata

+

+nodata用于检测监控数据的上报异常。nodata和实时报警judge模块协同工作,过程为: 配置了nodata的采集项超时未上报数据,nodata生成一条默认的模拟数据;用户配置相应的报警策略,收到mock数据就产生报警。采集项上报异常检测,作为judge模块的一个必要补充,能够使judge的实时报警功能更加可靠、完善。

+

+## 服务部署

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```

+# 修改配置, 配置项含义见下文

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./open-falcon start nodata

+

+# 停止服务

+./open-falcon stop nodata

+

+# 检查日志

+./open-falcon monitor nodata

+

+```

+

+## 配置说明

+配置文件默认为./cfg.json。默认情况下,安装包会有一个cfg.example.json的配置文件示例。各配置项的含义,如下

+

+```

+{

+ "debug": true,

+ "http": {

+ "enabled": true,

+ "listen": "0.0.0.0:6090"

+ },

+ "plus_api":{

+ "connectTimeout": 500,

+ "requestTimeout": 2000,

+ "addr": "http://127.0.0.1:8080", #falcon-plus api模块的运行地址

+ "token": "default-token-used-in-server-side" #用于和falcon-plus api模块的交互认证token

+ },

+ "config": {

+ "enabled": true,

+ "dsn": "root:@tcp(127.0.0.1:3306)/falcon_portal?loc=Local&parseTime=true&wait_timeout=604800",

+ "maxIdle": 4

+ },

+ "collector":{

+ "enabled": true,

+ "batch": 200,

+ "concurrent": 10

+ },

+ "sender":{

+ "enabled": true,

+ "connectTimeout": 500,

+ "requestTimeout": 2000,

+ "transferAddr": "127.0.0.1:6060", #transfer的http监听地址,一般形如"domain.transfer.service:6060"

+ "batch": 500

+ }

+}

+

+```

diff --git a/zh_0_3/distributed_install/prepare.md b/zh_0_3/distributed_install/prepare.md

new file mode 100644

index 0000000..61bcf8d

--- /dev/null

+++ b/zh_0_3/distributed_install/prepare.md

@@ -0,0 +1,4 @@

+

+

+## 环境准备

+请参考[环境准备](./prepare.md)

diff --git a/zh_0_3/distributed_install/task.md b/zh_0_3/distributed_install/task.md

new file mode 100644

index 0000000..56da2ed

--- /dev/null

+++ b/zh_0_3/distributed_install/task.md

@@ -0,0 +1,100 @@

+

+

+# Task

+

+task是监控系统一个必要的辅助模块。定时任务,实现了如下几个功能:

+

++ index更新。包括图表索引的全量更新 和 垃圾索引清理。

++ falcon服务组件的自身状态数据采集。定时任务了采集了transfer、graph、task这三个服务的内部状态数据。

++ falcon自检控任务。

+

+

+## 源码编译

+

+```bash

+# update common lib

+cd $GOPATH/src/github.com/open-falcon/common

+git pull

+

+# compile

+cd $GOPATH/src/github.com/open-falcon/task

+go get ./...

+./control build

+./control pack

+```

+

+最后一步会pack出一个tar.gz的安装包,拿着这个包去部署服务即可。

+

+## 服务部署

+

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```bash

+# 修改配置, 配置项含义见下文

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./control start

+

+# 校验服务,这里假定服务开启了8002的http监听端口。检验结果为ok表明服务正常启动。

+curl -s "127.0.0.1:8002/health"

+

+...

+# 停止服务

+./control stop

+

+```

+

+服务启动后,可以通过日志查看服务的运行状态,日志文件地址为./var/app.log。可以通过调试脚本```./test/debug```查看服务器的内部状态数据,如 运行 ```bash ./test/debug``` 可以得到服务器内部状态的统计信息。

+

+

+## 配置说明

+配置文件默认为./cfg.json。默认情况下,安装包会有一个cfg.example.json的配置文件示例。各配置项的含义,如下

+

+```

+debug: true/false, 如果为true,日志中会打印debug信息

+

+http

+ - enable: true/false, 表示是否开启该http端口,该端口为控制端口,主要用来对task发送控制命令、统计命令、debug命令等

+ - listen: 表示http-server监听的端口

+

+index

+ - enable: true/false, 表示是否开启索引更新任务

+ - dsn: 索引服务的MySQL的连接信息,默认用户名是root,密码为空,host为127.0.0.1,database为graph(如有必要,请修改)

+ - maxIdle: MySQL连接池配置,连接池允许的最大空闲连接数,保持默认即可

+ - cluster: 后端graph索引更新的定时任务描述。一条记录的形如: "graph地址:执行周期描述",通过设置不同的执行周期,来实现负载在时间上的均衡。

+ eg. 后端部署了两个graph实例,cluster可以配置为

+ "cluster":{

+ "test.hostname01:6071" : "0 0 0 ? * 0-5", //周0-5,每天的00:00:00,开始执行索引全量更新;"0 0 0 ? * 0-5"为quartz表达式

+ "test.hostname02:6071" : "0 30 0 ? * 0-5", //周0-5,每天的00:30:00,开始执行索引全量更新

+ }

+ - autoDelete: true|false, 是否自动删除垃圾索引。默认为false

+

+collector

+ - enable: true/false, 表示是否开启falcon的自身状态采集任务

+ - destUrl: 监控数据的push地址,默认为本机的1988接口

+ - srcUrlFmt: 监控数据采集的url格式, %s将由机器名或域名替换

+ - cluster: falcon后端服务列表,用具体的"module,hostname:port"表示,module取值可以为graph、transfer、task等

+

+```

+

+## 补充说明

+

+部署完成task组件后,请修改collector配置、使task能够正确采集transfer & graph的内部状态,请修改monitor配置、使task模块能够自检控Open-Falon的各组件(当前支持transfer、graph、query、judge等)。

+

+### 关于自监控报警

+因为多点监控的需求,自版本v0.0.10开始,我们将自监控报警功能 从Task模块移除。关于Open-Falcon自监控的详情,请参见[这里](http://book.open-falcon.com/zh/practice/monitor.html)。

+

+### 关于过期索引清除

+监控数据停止上报后,该数据对应的索引也会停止更新、变为过期索引。过期索引,影响视听,部分用户希望删除之。

+

+我们原来的方案,是: 通过task模块,有数据上报的索引、每天被更新一次,7天未被更新的索引、清除之。但是,很多用户不能正确配置graph实例的http接口,导致正常上报的监控数据的索引 无法被更新;7天后,合法索引被task模块误删除。

+

+为了解决上述问题,我们在默认配置里面,停掉了task模块自动删除过期索引的功能(autoDelete=false);如果你确定配置的index.cluster正确无误,可以自行打开该功能。

+

+当然,我们提供了更安全的、手动删除过期索引的方法。用户按需触发索引删除操作,具体步骤为:

+

+1.进行一次索引数据的全量更新。方法为: 针对每个graph实例,运行```curl -s "127.0.0.1:6071/index/updateAll"```,异步地触发graph实例的索引全量更新(这里假设graph的http监听端口为6071),等待所有的graph实例完成索引全量更新后 进行第2步操作。单个graph实例,索引全量更新的耗时,因counter数量、mysql数据库性能而不同,一般耗时不大于30min。

+

+2.待索引全量更新完成后,发起过期索引删除 ``` curl -s "$Hostname.Of.Task:$Http.Port/index/delete" ```。运行索引删除前,请务必**确保索引全量更新已完成**。

diff --git a/zh_0_3/distributed_install/transfer.md b/zh_0_3/distributed_install/transfer.md

new file mode 100644

index 0000000..ae48bf9

--- /dev/null

+++ b/zh_0_3/distributed_install/transfer.md

@@ -0,0 +1,91 @@

+

+

+# Transfer

+

+transfer是数据转发服务。它接收agent上报的数据,然后按照哈希规则进行数据分片、并将分片后的数据分别push给graph&judge等组件。

+

+## 服务部署

+服务部署,包括配置修改、启动服务、检验服务、停止服务等。这之前,需要将安装包解压到服务的部署目录下。

+

+```

+# 修改配置, 配置项含义见下文

+mv cfg.example.json cfg.json

+vim cfg.json

+

+# 启动服务

+./open-falcon start transfer

+

+# 校验服务,这里假定服务开启了6060的http监听端口。检验结果为ok表明服务正常启动。

+curl -s "127.0.0.1:6060/health"

+

+# 停止服务

+./open-falcon stop transfer

+

+# 查看日志

+./open-falcon monitor transfer

+```

+

+

+

+## 配置说明

+配置文件默认为./cfg.json。默认情况下,安装包会有一个cfg.example.json的配置文件示例。各配置项的含义,如下

+

+## Configuration

+```

+ debug: true/false, 如果为true,日志中会打印debug信息

+

+ minStep: 30, 允许上报的数据最小间隔,默认为30秒

+

+ http

+ - enabled: true/false, 表示是否开启该http端口,该端口为控制端口,主要用来对transfer发送控制命令、统计命令、debug命令等

+ - listen: 表示监听的http端口

+

+ rpc

+ - enabled: true/false, 表示是否开启该jsonrpc数据接收端口, Agent发送数据使用的就是该端口

+ - listen: 表示监听的http端口

+

+ socket #即将被废弃,请避免使用

+ - enabled: true/false, 表示是否开启该telnet方式的数据接收端口,这是为了方便用户一行行的发送数据给transfer

+ - listen: 表示监听的http端口

+

+ judge

+ - enabled: true/false, 表示是否开启向judge发送数据

+ - batch: 数据转发的批量大小,可以加快发送速度,建议保持默认值

+ - connTimeout: 单位是毫秒,与后端建立连接的超时时间,可以根据网络质量微调,建议保持默认

+ - callTimeout: 单位是毫秒,发送数据给后端的超时时间,可以根据网络质量微调,建议保持默认

+ - pingMethod: 后端提供的ping接口,用来探测连接是否可用,必须保持默认

+ - maxConns: 连接池相关配置,最大连接数,建议保持默认

+ - maxIdle: 连接池相关配置,最大空闲连接数,建议保持默认

+ - replicas: 这是一致性hash算法需要的节点副本数量,建议不要变更,保持默认即可

+ - cluster: key-value形式的字典,表示后端的judge列表,其中key代表后端judge名字,value代表的是具体的ip:port

+

+ graph

+ - enabled: true/false, 表示是否开启向graph发送数据

+ - batch: 数据转发的批量大小,可以加快发送速度,建议保持默认值

+ - connTimeout: 单位是毫秒,与后端建立连接的超时时间,可以根据网络质量微调,建议保持默认

+ - callTimeout: 单位是毫秒,发送数据给后端的超时时间,可以根据网络质量微调,建议保持默认

+ - pingMethod: 后端提供的ping接口,用来探测连接是否可用,必须保持默认

+ - maxConns: 连接池相关配置,最大连接数,建议保持默认

+ - maxIdle: 连接池相关配置,最大空闲连接数,建议保持默认

+ - replicas: 这是一致性hash算法需要的节点副本数量,建议不要变更,保持默认即可

+ - cluster: key-value形式的字典,表示后端的graph列表,其中key代表后端graph名字,value代表的是具体的ip:port(多个地址用逗号隔开, transfer会将同一份数据发送至各个地址,利用这个特性可以实现数据的多重备份)

+

+ tsdb

+ - enabled: true/false, 表示是否开启向open tsdb发送数据

+ - batch: 数据转发的批量大小,可以加快发送速度

+ - connTimeout: 单位是毫秒,与后端建立连接的超时时间,可以根据网络质量微调,建议保持默认

+ - callTimeout: 单位是毫秒,发送数据给后端的超时时间,可以根据网络质量微调,建议保持默认

+ - maxConns: 连接池相关配置,最大连接数,建议保持默认

+ - maxIdle: 连接池相关配置,最大空闲连接数,建议保持默认

+ - retry: 连接后端的重试次数和发送数据的重试次数

+ - address: tsdb地址或者tsdb集群vip地址, 通过tcp连接tsdb.

+

+```

+

+## 补充说明

+部署完成transfer组件后,请修改agent的配置,使其指向正确的transfer地址。在安装完graph和judge后,请修改transfer的相应配置、使其能够正确寻址到这两个组件。

+

+

+## 视频教程

+

+为transfer模块录制了一个视频,做了源码级解读:http://www.jikexueyuan.com/course/2061.html

diff --git a/zh_0_3/donate.md b/zh_0_3/donate.md

new file mode 100644

index 0000000..6d73481

--- /dev/null

+++ b/zh_0_3/donate.md

@@ -0,0 +1 @@

+../zh/donate.md

\ No newline at end of file

diff --git a/zh_0_3/faq/README.md b/zh_0_3/faq/README.md

new file mode 100644

index 0000000..190bfde

--- /dev/null

+++ b/zh_0_3/faq/README.md

@@ -0,0 +1,76 @@

+

+

+1. open-falcon v0.2的api文档是如何生成的?API文档地址 http://open-falcon.com/falcon-plus/

+> 人工生成yaml描述文件,通过Jekyll来生成静态站点,使用github来serve,api站点的源码在 https://github.com/open-falcon/falcon-plus/tree/master/docs 这里。不过可以通过打开api组件的gen_doc选项,然后api会把请求和应答都记录下来,作为撰写api yaml文件的参考。

+

+1. open-falcon v0.2 有管理员帐号吗?

+> 可以通过dashboard自行注册新用户,第一个用户名为root的帐号会被认为是超级管理员,超级管理员可以设置其他用户为管理员。

+

+1. open-falcon v0.2 dashboard 可以禁止用户自己注册吗?

+> 可以的,在api组件的配置文件中,将`signup_disable`配置项修改为true,重启api即可。

+

+1. open-falcon v0.2 dashboard 添加graph或者clone screen的时候,偶尔会出现'record not found'错误。

+> 这是api的bug引起的,已经在 [pull-request #186](https://github.com/open-falcon/falcon-plus/pull/186) 修复,请重新编译最新的api代码。

+

+1. open-falcon 可以监控udp的端口吗?

+> 支持的,参考 [pull-request #66](https://github.com/open-falcon/falcon-plus/pull/66)。

+

+1. open-falcon v0.2 如何单独编译安装api模块?

+> 参考[环境准备](https://book.open-falcon.com/zh_0_2/quick_install/prepare.html), 在falcon-plus的目录下,执行`make api`即可编译最新的api组件。

+

+1. open-falcon 支持Grafana吗?

+> 支持的,请参考[open-falcon grafana datasource](https://github.com/open-falcon/grafana-openfalcon-datasource)。

+

+1. 为什么连续3次报警之后,不再发送报警了?

+> 报警策略配置中,有一个最大报警次数的配置,比如你配置了cpu.idle小于5报警,max设置为3,那么报警达到3次之后即使仍然小于5也不会再报警了,直到接下来某次cpu.idle大于5了,就会报一个ok出来。以后如果又小于5了,那就会再次报警。

+

+1. 手动删除了数据库中 endpoint表、endpoint_counter中的一些记录后,相同的指标不会再次插入到MySQL中了。

+> 可以手工运行一次 graph 的索引刷新命令,即针对每个graph实例执行:`curl -s http://127.0.0.1:6071/index/updateAll` (这里假定graph模块http监听端口为6071)。

+

+1. graph的磁盘占用越来越大,怎么清理掉无用的数据?(rrd文件目录越来越大)

+> 在每台graph机器的rrd文件目录下面,执行如下命令 `find . -name '*.rrd' -mtime +7 | xargs rm -f'` 即可删除过去7天没有更新的rrd文件。

+

+1. 如何清理MySQL表过期的监控指标项?

+> 可以根据 graph.endpoint,graph.endpoint_counter,graph.tag_endpoint 三张表中的t_modify字段,找出很长一段时间都没有更新过的条目,进行删除。建议在操作数据库前,对数据库表做一个备份,免得误操作无法恢复,其次建议在操作前先触发一次索引的全量更新。

+

+1. 报警达到最大次数之后,如何再次报警?

+> 有三种方法:1是调大最大告警次数;2是修改告警阈值让该告警恢复;3是上报一个正常的值让该报警恢复。

+

+1. open-falcon 有英文版本吗?

+> open-falcon v0.2开始,dashboard部分支持i18n,点[这里](https://github.com/open-falcon/dashboard/blob/master/i18n.md)参与。

+

+1. open-falcon 支持发送报警到微信吗?(钉钉呢?)

+> open-falcon v0.2 原生支持发送报警到微信,可以参考 [alarm配置](https://book.open-falcon.com/zh_0_2/distributed_install/mail-sms.html) 和 [微信网关搭建](https://github.com/Yanjunhui/chat) 。发送报警到钉钉,可以参考[issue #134](https://github.com/open-falcon/falcon-plus/issues/134)。

+

+1. open-falcon 扩容增加graph节点,怎么让数据重新迁移?

+> 平滑扩容步骤,请参考 [graph扩容历史数据自动迁移](http://www.jianshu.com/p/16baba04c959)。

+

+1. open-falcon 能监控windows吗?

+> 可以的,请参考社区对 [windows监控的解决方案](https://book.open-falcon.com/zh_0_2/usage/win.html)。

+

+1. open-falcon 能监控交换机吗?

+> 可以的,请参考社区对 [交换机监控的解决方案](https://book.open-falcon.com/zh_0_2/usage/switch.html)。

+

+1. open-falcon v0.2 中没有sender模块了吗?

+> 是的,为了减少维护成本和安装成本,在open-falcon v0.2 中,移除了sender模块,将该功能集成在alarm模块中了。

+

+1. graph中,对于同一个Counter,在收到数据的时候,如果该数据的Timestamp小于Store中第一个数据的Timestamp,则该数据会被丢弃,这是为什么呢? 我想知道,这个地方出于这个考虑,是因为rrdtool的限制么,不能在Store中插入数据,只能追加数据吗? [issue](https://github.com/open-falcon/falcon-plus/issues/292)

+> 是的,在rrdtool的设计模式下,数据只能追加,不能插入。所以falcon在graph中提前对数据做了一个按照时间戳的排序。

+

+1. 宕机后,nodata报警有一定时间的延迟和滞后,是什么原因? [issue](https://github.com/open-falcon/falcon-plus/issues/294)

+> nodata的工作逻辑是:通过api去graph中查询数据,如果没有查询到数据,则对这个counter补发设定后的值。nodata的补发数据 和 用户正常上报数据,都是靠时钟来对齐的,因此在nodata的代码中,强行延迟了一到两个周期,以免造成 nodata 补发的值先到达graph,这样就会造成正常的值失效。

+

+1. counter中的tag字段,里面的所有空格都被去掉这是出于什么考虑呢? [issue](https://github.com/open-falcon/falcon-plus/issues/289)

+> 这算作一个最佳实践的约定吧,并非代码实现层面的考虑。空格建议大家在上报之前自行替换为-号。

+

+1. 报警信息里磁盘信息是以bit计数的,怎么控制单位呢? [issue](https://github.com/open-falcon/falcon-plus/issues/275)

+> open-falcon中没有「单位」的概念,数据都是遵从用户上报时的含义,理解上要保持一致。

+

+1. 上报数据中有中文时,graph 读取数据报错:errno: 0x023a, str:opening error [issue](https://github.com/open-falcon/falcon-plus/issues/274)

+> 这和中文没有关系,这个错误,应该是读取不存在的counter造成的,可以忽略。

+

+1. 按天为单位,上报数据如何正确上报和展现?[issue](https://github.com/open-falcon/falcon-plus/issues/271)

+> step要设置为86400,并且坚持每天push一次数据;push上去后,服务端会对时间戳做归一化,即服务端记录的时间戳 = int(当前时间戳/86400)。

+

+1. open-falcon 的报警历史是存储在什么地方的?

+> 在v0.1版本中,历史报警信息是不存储的,发送后就丢弃了;在v0.2中,做了改进,报警发送后会将历史报警存储在数据库中,请参考 `alarms` 库下面的表。当然,也可以通过 [API](http://open-falcon.com/falcon-plus/#/alarm_eventcases_list) 来访问这些信息。

diff --git a/zh_0_3/faq/alarm.md b/zh_0_3/faq/alarm.md

new file mode 100644

index 0000000..63d9e1b

--- /dev/null

+++ b/zh_0_3/faq/alarm.md

@@ -0,0 +1,39 @@

+

+

+# 报警相关常见问题

+

+#### 配置了策略,一直没有报警,如何排查?

+

+1. 排查sender、alarm、judge、hbs、agent、transfer的log

+2. 浏览器访问alarm的http页面,看是否有未恢复的告警,如果有就是生成报警了,后面没发出去,很可能是邮件、短信发送接口出问题了,检查sender中配置的api

+3. 打开agent的debug,看是否在正常push数据

+4. 看agent配置,是否正确配置了heartbeat(hbs)和transfer的地址,并enabled

+5. 看transfer配置,是否正确配置了judge地址

+6. jduge提供了一个http接口用于debug,可以检查某个数据是否正确push上来了,比如qd-open-falcon-judge01.hd这个机器的cpu.idle数据,可以这么查看

+```bash

+curl http://127.0.0.1:6081/history/qd-open-falcon-judge01.hd/cpu.idle

+```

+7. 检查服务器的时间是否已经同步,可以用 [ntp](https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/System_Administrators_Guide/sect-Understanding_chrony_and-its_configuration.html) 或 chrony 来实现

+

+上面的127.0.0.1:6081指的是judge的http端口

+7. 检查judge配置的hbs地址是否正确

+8. 检查hbs配置的数据库地址是否正确

+9. 检查portal中配置的策略模板是否配置了报警接收人

+10. 检查portal中配置的策略模板是否绑定到某个HostGroup了,并且目标机器恰好在这个HostGroup中

+11. 去UIC检查报警接收组中是否把自己加进去了

+12. 去UIC检查自己的联系信息是否正确

+

+#### 在Portal页面创建了一个HostGroup,往HostGroup中增加机器的时候报错

+

+1. 检查agent是否正确配置了heartbeat地址,并enabled了

+2. 检查hbs log

+3. 检查hbs配置的数据库地址是否正确

+4. 检查hbs的配置hosts是否配置为sync了,只有留空的时候hbs才会去写host表,host表中有数据才能在页面上添加机器

+

+

+#### 在alarm这边配置了短信、邮件、微信通知,在alarm 日志中看到告警写入 redis 队列都有,但实际发送有时候只有1种,有时2种,有时3种都有。

+1. 检查是否有多个alarm进程同时读取一个redis队列,引起相互干扰,如urlooker的alarm。

+2. 修改redis队列名称,如修改urlooker的redis队列名称,使2个alarm读取不同的队列,避免造成干扰。

+

+

+

diff --git a/zh_0_3/faq/collect.md b/zh_0_3/faq/collect.md

new file mode 100644

index 0000000..65f9c82

--- /dev/null

+++ b/zh_0_3/faq/collect.md

@@ -0,0 +1,62 @@

+

+

+# 数据收集相关问题

+Open-Falcon数据收集,分为[绘图数据]收集和[报警数据]收集。下面介绍,如何验证两个链路的数据收集是否正常。

+

+

+### 如何验证[绘图数据]收集是否正常

+数据链路是:`agent->transfer->graph->query->dashboard`。graph有一个http接口可以验证`agent->transfer->graph`这条链路,比如graph的http端口是6071,可以这么访问验证:

+

+```bash

+# $endpoint和$counter是变量

+curl http://127.0.0.1:6071/history/$endpoint/$counter

+

+# 如果上报的数据不带tags,访问方式是这样的:

+curl http://127.0.0.1:6071/history/host01/agent.alive

+

+# 如果上报的数据带有tags,访问方式如下,其中tags为module=graph,project=falcon

+curl http://127.0.0.1:6071/history/host01/qps/module=graph,project=falcon

+```

+如果调用上述接口返回空值,则说明agent没有上报数据、或者transfer服务异常。

+

+

+### 如何验证[报警数据]收集是否正常

+

+数据链路是:`agent->transfer->judge`,judge有一个http接口可以验证`agent->transfer->judge`这条链路,比如judge的http端口是6081,可以这么访问验证:

+

+```bash

+curl http://127.0.0.1:6081/history/$endpoint/$counter

+

+# $endpoint和$counter是变量,举个例子:

+curl http://127.0.0.1:6081/history/host01/cpu.idle

+

+# counter=$metric/sorted($tags)

+# 如果上报的数据带有tag,访问方式是这样的,比如:

+curl http://127.0.0.1:6081/history/host01/qps/module=judge,project=falcon

+```

+如果调用上述接口返回空值,则说明agent没有上报数据、或者transfer服务异常。

+

+**注意**: v0.2.1版本之后judge新增了优化内存使用的功能,如果metric没有对应的strategy或者expression,judge内存中不会存储该metirc的历史数据,所以判断报警数据收集这条链路是否正常时需要先确定metric是否有对应的报警条件

+

+```bash

+# 检查metric是否有对应的strategy

+curl http://127.0.0.1:6081/strategy/$endpoint/$counter

+

+# 检查metric是否有对应的expression

+curl http://127.0.0.1:6081/expression/$counter

+

+

+# $endpoint和$counter是变量

+# expression报警条件必须包含tag,当metric上报数据没有携带tag时只检测是否有对应的strategy即可

+# 举个例子:

+curl http://127.0.0.1:6081/strategy/host01/cpu.idle

+

+# counter=$metric/sorted($tags)

+# 如果上报的数据带有tag,需要检测streategy和expression是否存在

+# 举个例子: 当上报的metric为qps, tag为module=judge,project=falcon时, 访问方式是这样的:

+curl http://127.0.0.1:6081/strategy/host01/qps

+

+curl http://127.0.0.1:6081/expression/qps/module=judge

+

+curl http://127.0.0.1:6081/expression/qps/project=falcon

+```

diff --git a/zh_0_3/faq/graph.md b/zh_0_3/faq/graph.md

new file mode 100644

index 0000000..4267eff

--- /dev/null

+++ b/zh_0_3/faq/graph.md

@@ -0,0 +1,339 @@

+

+

+# 绘图链路常见问题

+

+### 如何清除过期索引

+监控数据停止上报后,该数据对应的索引也会停止更新、变为过期索引。过期索引,影响视听,部分用户希望删除之。

+

+我们原来的方案,是: 通过task模块,有数据上报的索引、每天被更新一次,7天未被更新的索引、清除之。但是,很多用户不能正确配置graph实例的http接口,导致正常上报的监控数据的索引 无法被更新;7天后,合法索引被task模块误删除。

+

+为了解决上述问题,我们停掉了task模块自动删除过期索引的功能、转而提供了过期索引删除的接口。用户按需触发索引删除操作,具体步骤为:

+

+1.运行task模块,并正确配置graph集群及其http端口,即task配置文件中index.cluster的内容。此处配置不正确,不应该进行索引删除操作,否则将导致索引数据的误删除。

+

+2.进行一次索引数据的全量更新。方法为 ``` curl -s "http://$Hostname.Of.Task:$Http.Port/index/updateAll" ```。这里,"$Hostname.Of.Task:$Http.Port"是task的http接口地址。

+PS:索引数据存放在graph实例上,这里,只是通过task,触发了各个graph实例的索引全量更新。更直接的办法,是,到每个graph实例上,运行```curl -s "http://127.0.0.1:6071/index/updateAll"```,直接触发graph实例 进行索引全量更新(这里假设graph的http监听端口为6071)。

+

+3.待索引全量更新完成后,发起过期索引删除 ``` curl -s "http://$Hostname.Of.Task:$Http.Port/index/delete" ```。运行索引删除前,请务必**确保索引全量更新已完成**。典型的做法为,周六运行一次索引全量更新,周日运行一次索引删除;索引更新和删除之间,留出足够的时间。

+

+在此,建议您: **若无必要,请勿删除索引**;若确定要删除索引,请确保删除索引之前,对所有的graph实例进行一次索引全量更新。

+

+

+### Dashboard索引缺失、查询不到endpoint或counter

+手动更改graph的数据库后,可能会出现上述情况。这里的手动更改,包括:更改graph的数据库配置(数据库地址,名称等)、删除重建graph数据库/表、手动更改graph数据表的内容等。出现上述情况后,可以通过 如下两种途径的任一种 来解决问题,

+

+1. 触发graph的索引全量更新、补救手工操作带来的异常。触发方式为,运行```curl -s "http://$hostname:$port/index/updateAll"```,其中```$hostname```为graph所在的服务器地址,```$port```为graph的http监听端口。这种方式,不会删除已上报的监控数据,但是会对数据库造成短时间的读写压力。

+2. 删除graph已存储的数据,并重启graph。默认情况下,graph的数据存储目录为 ```/home/work/data/6070/```。这种方式,会使已上报的数据被删除。

+

+

+

+### Dashboard图表曲线为空

+图表曲线,一般会有3-5个上报周期的延迟。如果5个周期后仍然没有图表曲线,请往下看。

+绘图链路,数据上报的流程为: agent -> transfer -> graph -> query -> dashboard。这个流程中任何一环节出问题,都会导致用户在dashboard中看不到曲线。一个建议的问题排查流程,如下

+

+1. 确保绘图链路的各组件,都已启动。

+2. 排查dashboard的问题。首先查看dashboard的日志,默认地址为```./var/app.log```,常见的日志报错原因有dashboard依赖库安装不完整、本地http代理劫持访问请求等。然后查看dashboard的配置,默认为```./gunicorn.conf```和```./rrd/config.py```。确认gunicorn.conf中指定的访问地址,确认config.py中指定的query地址、dashboard数据库配置 和 graph数据库配置。

+3. 排查query的问题。首先看下query的日志```./var/app.log```是否有报错信息。然后确认query的graph列表配置```./graph_backends.txt```和 服务配置```./cfg.json```。可以通过脚本```./scripts/query```来做一些定量的debug,比如你上报了一个 endpoint="ty-op-mon-cloud.us", metric="agent.alive" 的采集项,可以运行 ```bash ./scripts/query "ty-op-mon-cloud.us" "agent.alive" ``` 来查看该采集项的数据,如果能够查到数据 则说明query及之前的graph、transfer、agent很可能是正常的。

+4. 排查graph的问题。首先看下graph的日志```./var/app.log```是否有报错。然后确认下graph配置文件```./cfg.json```是否配置了正确的数据库db。没有发现问题?启动对graph的debug,方法见***Graph调试***一节。

+5. 排查transfer的问题。首先看transfer的日志```./var/app.log```是否有报错。然后确认配置文件```./cfg.json```是否enable了对graph集群的发送功能、是否正确配置了graph集群列表。确认完毕后,仍没有发现问题,怎么办?启动对transfer的debug,方法见***Transfer调试***一节。

+6. 排查agent的问题。打开agent的debug日志,观察数据上报情况。

+

+

+

+### Dashboard图表曲线有断点

+dashboard出现断点,可能的原因为:

+

+1. 用户监控数据上报异常。可能是用户自动的数据采集 被中断,或者上报周期不规律等。

+2. falcon系统异常,导致监控数据丢失。问题最可能发生在transfer到graph这个链路上,可以通过transfer&graph的debug接口来确认原因。

+

+

+### Graph绘图数据高可用

+默认情况下,绘图数据以分片的形式、存储在单个graph实例上。一旦graph实例所在的机器磁盘坏掉, 绘图数据就会永久丢失。

+

+为了解决这个问题,Open-Falcon提供了绘图数据高可用的解决方案: 数据双打/多打,即 将同一份绘图数据 同时打到2+个graph实例上、使这2+个graph实例的数据完全相同、互为镜像备份,当发生故障时 就可以用 镜像备份实例 来替换 故障的实例。具体的,绘图数据高可用的实现过程,如下:

+

+1. 配置transfer的graph节点列表,使每个节点都有2+个互为镜像的graph实例;transfer会向 互为镜像的几个graph实例 发送相同的数据。eg.你可以配置graph节点 形如``` "g-00" : "host1:6070,host2:6070"```,多个graph实例之间以逗号隔开,这样 ```host1:6070``` 和 ```host2:6070```就会互为镜像。注意,transfer版本应不低于***0.0.14***,否则 不能支持此功能。

+2. 启动/重启transfer,开始数据双打或者多打。transfer的压力,会随着镜像数量的增加而增大,所以 需要合理控制graph镜像的数量。

+3. 配置query的graph列表。当前,query只支持 **一个节点对应一个graph实例**。以第1步的transfer配置为例,你可以配置query的graph节点```g-00```的graph实例为 ```"g-00":"host1:6070"``` 或者 ```"g-00":"host2:6070"```、而不能是 ```"g-00":"host1:6070,host2:6070"```

+4. 当某个graph实例发生故障(eg.磁盘故障)时,修改query的graph列表、踢掉坏死的graph实例、并用其镜像实例顶替之。一方面,更上层的业务只会在query配置修改期间不可用,这个过程可以控制在分钟级别。另一方面,即使坏掉了一个graph实例,其上绘图数据 也可以从镜像实例上找到,从而实现了数据的高可用。

+

+当然,这个高可用方案 需要增加更多的graph实例、会使transfer资源消耗倍增、需要手动进行故障切换,还有很多的改进空间。

+

+

+

+### 如何确定某个counter对应的rrd文件

+每个counter,上报到graph之后,都是以一个独立的rrd文件,存储在磁盘上。那么如何确定counter和rrd的对应关系呢?

+query组件提供了一个调试用的http接口,可以帮助我们查询到该对应关系

+

+`info.py`

+

+```python

+#!/usr/bin/env python

+

+import requests

+import json

+import sys

+

+d = [

+ {

+ "endpoint": sys.argv[1],

+ "counter": sys.argv[2],

+ },

+]

+url = "http://127.0.0.1:9966/graph/info"

+r = requests.post(url, data=json.dumps(d))

+print r.text

+

+```

+

+`使用方法`

+

+ python info.py your.hostname your.metric/tag1=tag1-val,tag2=tag2-val

+

+

+

+### Graph调试

+graph以http的方式提供了多个调试接口。主要有 内部状态统计接口、历史数据查询接口等。脚本```./test/debug```将一些接口封装成了shell的形式,可自行查阅代码、不在此做介绍。

+

+**历史数据查询接口**```HTTP:GET, curl -s "http://hostname:port/history/$endpoint/$metric/$tags"```,返回graph接收到的、最新的3个数据。

+

+```bash

+# history没有tags的数据,$endpoint=test.host, $metric=agent.alive

+curl -s "http://127.0.0.1:6071/history/test.host/agent.alive" | python -m json.tool

+

+# history有tags的数据,$tags='module=graph,pdl=falcon'

+curl -s "http://127.0.0.1:6071/history/test.host/qps/module=graph,pdl=falcon" | python -m json.tool

+```

+

+**内部状态统计接口**```HTTP:GET, curl -s "http://hostname:port/statistics/all"```,输出json格式的内部状态数据,格式如下。这些内部状态数据,被task组件采集后push到falcon系统,用于绘图展示、报警等。

+

+```bash

+curl -s "http://127.0.0.1:6071/statistics/all" | python -m json.tool

+

+# output

+{

+ "data": [

+ { // counter of received items

+ "Cnt": 7, // cnt

+ "Name": "GraphRpcRecvCnt", // name of counter

+ "Other": {}, // other infos

+ "Qps": 0, // growth rate of this counter, per second

+ "Time": "2015-06-18 12:20:06" // time when this counter takes place

+ },

+ { // counter of query requests graph received

+ "Cnt": 0,

+ "Name": "GraphQueryCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-18 12:20:06"

+ },

+ { // counter of all sent items in query

+ "Cnt": 0,

+ "Name": "GraphQueryItemCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-18 12:20:06"

+ },

+ { // counter of info requests graph received

+ "Cnt": 0,

+ "Name": "GraphInfoCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-18 12:20:06"

+ },

+ { // counter of last requests graph received

+ "Cnt": 3,

+ "Name": "GraphLastCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-18 12:20:06"

+ },

+ { // counter of index updates

+ "Cnt": 0,

+ "Name": "IndexUpdateAllCnt",

+ "Other": {},

+ "Time": "2015-06-18 10:58:52"

+ }

+ ],

+ "msg": "success"

+}

+```

+

+

+### Transfer调试

+transfer以http的方式提供了多个调试接口。主要有 内部状态统计接口、转发数据追踪接口等。脚本```./test/debug```将一些http接口封装成了shell的形式,可自行查阅代码、不在此做介绍。

+

+**转发数据追踪接口** ```HTTP:GET, curl -s "http://hostname:port/trace/$endpoint/$metric/$tags"```,输出json格式的trace数据。transfer会过滤出以```/$endpoint/$metric/$tags```标记的数据,第一次调用时设置过滤条件、不会返回数据,之后每次调用返回已接收到的数据、最多3个点。这个接口主要用于debug。

+

+```bash

+# trace没有tags的数据,$endpoint=test.host, $metric=agent.alive

+curl -s "http://127.0.0.1:6060/trace/test.host/agent.alive" | python -m json.tool

+

+# trace有tags的数据,$tags='module=graph,pdl=falcon'

+curl -s "http://127.0.0.1:6060/trace/test.host/qps/module=graph,pdl=falcon" | python -m json.tool

+```

+

+**内部状态统计接口**```HTTP:GET, curl -s "http://hostname:port/statistics/all"```,输出json格式的内部状态数据,格式如下。这些内部状态数据,被task组件采集后push到falcon系统,用于绘图展示、报警等。

+

+```bash

+curl -s "http://127.0.0.1:6060/statistics/all" | python -m json.tool

+

+# output

+{

+ "data": [

+ { // counter of items received

+ "Cnt": 0, // counter, total number of items received since transfer started

+ "Name": "RecvCnt", // name of this this counter

+ "Other": {}, // other infos

+ "Qps": 0, // growth rate of this counter, items per sec

+ "Time": "2015-06-10 07:46:35" // time when this counter takes place

+ },

+ { // counter of items received from RPC

+ "Cnt": 0,

+ "Name": "RpcRecvCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items received from HTTP-API

+ "Cnt": 0,

+ "Name": "HttpRecvCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items received from SOCKET

+ "Cnt": 0,

+ "Name": "SocketRecvCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items sent to judge

+ "Cnt": 0,

+ "Name": "SendToJudgeCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items sent to graph

+ "Cnt": 0,

+ "Name": "SendToGraphCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items sent to graph-migrating

+ "Cnt": 0,

+ "Name": "SendToGraphMigratingCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of dropped items sent to judge. transfer would drop items if it could not push them to receivers timely

+ "Cnt": 0,

+ "Name": "SendToJudgeDropCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of dropped items sent to graph

+ "Cnt": 0,

+ "Name": "SendToGraphDropCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of dropped items sent to graph-migrating

+ "Cnt": 0,

+ "Name": "SendToGraphMigratingDropCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items transfer failed to send to judge

+ "Cnt": 0,

+ "Name": "SendToJudgeFailCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items transfer failed to send to graph

+ "Cnt": 0,

+ "Name": "SendToGraphFailCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of items transfer failed to send to graph-migrating

+ "Cnt": 0,

+ "Name": "SendToGraphMigratingFailCnt",

+ "Other": {},

+ "Qps": 0,

+ "Time": "2015-06-10 07:46:35"

+ },

+ { // counter of cached items which would be sent to judge instances

+ "Cnt": 0,

+ "Name": "JudgeSendCacheCnt",

+ "Other": {},

+ "Time": "2015-06-10 07:46:33"

+ },

+ { // counter of cached items which would be sent to graph instances

+ "Cnt": 0,

+ "Name": "GraphSendCacheCnt",

+ "Other": {},

+ "Time": "2015-06-10 07:46:33"

+ },

+ { // counter of cached items which would be sent to grap-migrating instances

+ "Cnt": 0,

+ "Name": "GraphMigratingCacheCnt",

+ "Other": {},

+ "Time": "2015-06-10 07:46:33"

+ }

+ ],

+ "msg": "success"

+}

+```

+

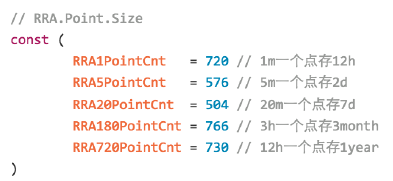

+### 设置绘图数据的存储周期

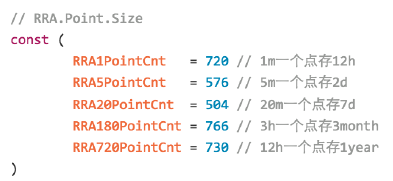

+Graph组件默认保存5年的数据,存储数据的RRA配置为:

+

+```go

+// find this in 'graph/rrdtool/rrdtool.go'

+func create(filename string, item *model.GraphItem) error {

+ now := time.Now()

+ start := now.Add(time.Duration(-24) * time.Hour)

+ step := uint(item.Step)

+

+ c := rrdlite.NewCreator(filename, start, step)

+ c.DS("metric", item.DsType, item.Heartbeat, item.Min, item.Max)

+

+ // 设置各种归档策略

+ // 1分钟一个点存 12小时

+ c.RRA("AVERAGE", 0.5, 1, 720)

+

+ // 5m一个点存2d

+ c.RRA("AVERAGE", 0.5, 5, 576)

+ c.RRA("MAX", 0.5, 5, 576)

+ c.RRA("MIN", 0.5, 5, 576)

+

+ // 20m一个点存7d

+ c.RRA("AVERAGE", 0.5, 20, 504)

+ c.RRA("MAX", 0.5, 20, 504)

+ c.RRA("MIN", 0.5, 20, 504)

+

+ // 3小时一个点存3个月

+ c.RRA("AVERAGE", 0.5, 180, 766)

+ c.RRA("MAX", 0.5, 180, 766)

+ c.RRA("MIN", 0.5, 180, 766)

+

+ // 1天一个点存5year

+ c.RRA("AVERAGE", 0.5, 720, 730)

+ c.RRA("MAX", 0.5, 720, 730)

+ c.RRA("MIN", 0.5, 720, 730)

+

+ return c.Create(true)

+}

+

+```

+你可以通过修改rrdtool的RRA ``` c.RRA($CF, 0.5, $PN, $PCNT) ```,来设置Graph的数据存储周期。关于RRA的概念,请查阅rrdtool的相关资料。

diff --git a/zh_0_3/faq/linux-metrics.md b/zh_0_3/faq/linux-metrics.md

new file mode 100644

index 0000000..7541cf7

--- /dev/null

+++ b/zh_0_3/faq/linux-metrics.md

@@ -0,0 +1,198 @@

+

+

+# Linux运维基础采集项

+

+做运维,不怕出问题,怕的是出了问题,抓不到现场,两眼摸黑。所以,依靠强大的监控系统,收集尽可能多的指标,意义重大。但哪些指标才是有意义的呢,本着从实践中来的思想,各位工程师在长期摸爬滚打中总结出来的经验最有价值。

+

+在各位运维工程师长期的工作实践中,我们总结了在系统运维过程中,经常会参考的一些指标,主要包括以下几个类别:

+

+- CPU

+- Load

+- 内存

+- 磁盘

+- IO

+- 网络相关

+- 内核参数

+- ss 统计输出

+- 端口采集

+- 核心服务的进程存活信息采集

+- 关键业务进程资源消耗

+- NTP offset采集

+- DNS解析采集

+

+每个类别,具体的详细指标如下,这些指标,都是open-falcon的agent组件直接支持的。falcon-agent每隔一定时间间隔(目前是60秒)会采集一次相关的指标,并汇报给server端。

+

+# CPU相关采集项

+

+计算方法:通过采集/proc/stat来得到,大家可以参考sar命令的统计输出来理解。

+