+

-1. 进入 [**Clusters**](https://tidbcloud.com/console/clusters) 页面,然后点击目标集群的名称,进入其概览页面。

+1. 进入 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,点击目标集群名称进入集群概览页。

-2. 点击右上角的 **Connect**,显示连接对话框。

+2. 点击右上角的 **Connect**,弹出连接对话框。

-3. 确认连接对话框中的配置与你的操作环境匹配。

+3. 确保连接对话框中的配置与你的操作环境一致。

- **Connection Type** 设置为 `Public`

- **Branch** 设置为 `main`

- **Connect With** 设置为 `General`

- - **Operating System** 与你的环境一致。

+ - **Operating System** 与你的环境一致

> **Tip:**

>

- > 如果你的程序在 Windows Subsystem for Linux (WSL) 中运行,请切换到对应的 Linux 发行版。

+ > 如果你的程序运行在 Windows Subsystem for Linux (WSL) 中,请切换到对应的 Linux 发行版。

-4. 点击 **Generate Password**,生成随机密码。

+4. 点击 **Generate Password** 生成随机密码。

> **Tip:**

>

- > 如果之前已经创建过密码,可以使用原有密码,也可以点击 **Reset Password** 生成新密码。

+ > 如果你之前已经创建过密码,可以继续使用原密码,或点击 **Reset Password** 生成新密码。

-5. 运行以下命令,将 `.env.example` 复制并重命名为 `.env`:

+5. 运行以下命令,复制 `.env.example` 并重命名为 `.env`:

```shell

cp .env.example .env

```

-6. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例内容如下:

+6. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例结果如下:

```dotenv

- TIDB_HOST='{host}' # 例如 gateway01.ap-northeast-1.prod.aws.tidbcloud.com

+ TIDB_HOST='{host}' # e.g. gateway01.ap-northeast-1.prod.aws.tidbcloud.com

TIDB_PORT='4000'

- TIDB_USER='{user}' # 例如 xxxxxx.root

+ TIDB_USER='{user}' # e.g. xxxxxx.root

TIDB_PASSWORD='{password}'

TIDB_DB_NAME='test'

- CA_PATH='{ssl_ca}' # 例如 /etc/ssl/certs/ca-certificates.crt(Debian / Ubuntu / Arch)

+ CA_PATH='{ssl_ca}' # e.g. /etc/ssl/certs/ca-certificates.crt (Debian / Ubuntu / Arch)

```

- 一定要将 `{}` 占位符替换为从连接对话框获取的连接参数。

+ 请务必将 `{}` 占位符替换为连接对话框中获取的连接参数。

7. 保存 `.env` 文件。

-1. 进入 [**Clusters**](https://tidbcloud.com/console/clusters) 页面,然后点击目标集群的名称,进入其概览页面。

+1. 进入 [**Clusters**](https://tidbcloud.com/console/clusters) 页面,点击目标集群名称进入集群概览页。

-2. 点击右上角的 **Connect**,显示连接对话框。

+2. 点击右上角的 **Connect**,弹出连接对话框。

3. 在连接对话框中,从 **Connection Type** 下拉列表选择 **Public**,然后点击 **CA cert** 下载 CA 证书。

- 如果还未配置 IP 访问列表,请点击 **Configure IP Access List** 或按照 [Configure an IP Access List](https://docs.pingcap.com/tidbcloud/configure-ip-access-list) 的步骤进行配置,然后再首次连接。

+ 如果你还未配置 IP 访问列表,请点击 **Configure IP Access List**,或参考 [Configure an IP Access List](https://docs.pingcap.com/tidbcloud/configure-ip-access-list) 进行配置后再首次连接。

- 除了 **Public** 连接类型外,TiDB Cloud Dedicated 还支持 **Private Endpoint** 和 **VPC Peering** 连接类型。更多信息请参考 [Connect to Your TiDB Cloud Dedicated Cluster](https://docs.pingcap.com/tidbcloud/connect-to-tidb-cluster)。

+ 除了 **Public** 连接类型,TiDB Cloud Dedicated 还支持 **Private Endpoint** 和 **VPC Peering** 连接类型。更多信息请参见 [Connect to Your TiDB Cloud Dedicated Cluster](https://docs.pingcap.com/tidbcloud/connect-to-tidb-cluster)。

-4. 运行以下命令,将 `.env.example` 复制并重命名为 `.env`:

+4. 运行以下命令,复制 `.env.example` 并重命名为 `.env`:

```shell

cp .env.example .env

```

-5. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例内容如下:

+5. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例结果如下:

```dotenv

- TIDB_HOST='{host}' # 例如 tidb.xxxx.clusters.tidb-cloud.com

+ TIDB_HOST='{host}' # e.g. tidb.xxxx.clusters.tidb-cloud.com

TIDB_PORT='4000'

- TIDB_USER='{user}' # 例如 root

+ TIDB_USER='{user}' # e.g. root

TIDB_PASSWORD='{password}'

TIDB_DB_NAME='test'

CA_PATH='{your-downloaded-ca-path}'

```

- 一定要将 `{}` 占位符替换为从连接对话框获取的连接参数,并将 `CA_PATH` 配置为上一步下载的证书路径。

+ 请务必将 `{}` 占位符替换为连接对话框中获取的连接参数,并将 `CA_PATH` 配置为上一步下载的证书路径。

6. 保存 `.env` 文件。

-

+

-在 [Discord](https://discord.gg/DQZ2dy3cuc?utm_source=doc) 或 [Slack](https://slack.tidb.io/invite?team=tidb-community&channel=everyone&ref=pingcap-docs) 社区提问,或 [提交支持工单](/support.md)。

+在 [Discord](https://discord.gg/DQZ2dy3cuc?utm_source=doc) 或 [Slack](https://slack.tidb.io/invite?team=tidb-community&channel=everyone&ref=pingcap-docs) 社区提问,或[提交支持工单](/support.md)。

-在 [Discord](https://discord.gg/DQZ2dy3cuc?utm_source=doc) 或 [Slack](https://slack.tidb.io/invite?team=tidb-community&channel=everyone&ref=pingcap-docs) 社区提问,或 [提交支持工单](https://tidb.support.pingcap.com/)。

+在 [Discord](https://discord.gg/DQZ2dy3cuc?utm_source=doc) 或 [Slack](https://slack.tidb.io/invite?team=tidb-community&channel=everyone&ref=pingcap-docs) 社区提问,或[提交支持工单](https://tidb.support.pingcap.com/)。

-

\ No newline at end of file

+

diff --git a/latest_translation_commit.json b/latest_translation_commit.json

index 399a4b0fb0015..dffbd4ccda02d 100644

--- a/latest_translation_commit.json

+++ b/latest_translation_commit.json

@@ -1 +1 @@

-{"target":"release-8.5","sha":"0205ededf901476ea31dcd603f21ab9c9bed3f0d"}

+{"target":"release-8.5","sha":"6b3c0fadec1d62f44690ecaafa0ac03d762a2ba9"}

\ No newline at end of file

diff --git a/tidb-cloud/ai-feature-concepts.md b/tidb-cloud/ai-feature-concepts.md

index be01bcd87bcac..6fd2f3724fa54 100644

--- a/tidb-cloud/ai-feature-concepts.md

+++ b/tidb-cloud/ai-feature-concepts.md

@@ -1,50 +1,50 @@

---

-title: AI 功能

+title: AI Features

summary: 了解 TiDB Cloud 的 AI 功能。

---

# AI 功能

-TiDB Cloud 中的 AI 功能使你能够充分利用先进技术进行数据探索、搜索和集成。从自然语言驱动的 SQL 查询生成到高性能向量搜索,TiDB 将数据库功能与现代 AI 功能相结合,为创新应用提供动力。通过支持流行的 AI 框架、嵌入模型以及与 ORM 库的无缝集成,TiDB 为语义搜索和 AI 驱动的分析等用例提供了一个多功能平台。

+TiDB Cloud 的 AI 功能让你能够充分利用先进技术进行数据探索、搜索和集成。从基于自然语言的 SQL 查询生成,到高性能的向量搜索,TiDB 将数据库能力与现代 AI 功能相结合,为创新应用提供强大动力。TiDB 支持主流 AI 框架、嵌入模型,并可与 ORM 库无缝集成,为语义搜索和 AI 驱动分析等场景提供了多样化的平台。

-本文档重点介绍这些 AI 功能以及它们如何增强 TiDB 体验。

+本文档将重点介绍这些 AI 功能,以及它们如何提升 TiDB 的使用体验。

## Chat2Query(Beta)

-Chat2Query 是集成在 SQL 编辑器中的 AI 驱动功能,可帮助用户使用自然语言指令生成、调试或重写 SQL 查询。更多信息,请参见[使用 AI 辅助的 SQL 编辑器探索数据](/tidb-cloud/explore-data-with-chat2query.md)。

+Chat2Query 是集成在 SQL Editor 中的 AI 驱动功能,能够帮助用户通过自然语言指令生成、调试或重写 SQL 查询。更多信息,参见 [Explore your data with AI-assisted SQL Editor](/tidb-cloud/explore-data-with-chat2query.md)。

-此外,TiDB Cloud 为 TiDB Cloud Serverless 集群提供 Chat2Query API。启用后,TiDB Cloud 将自动在数据服务中创建一个名为 Chat2Query 的系统数据应用和一个 Chat2Data 端点。你可以调用此端点,通过提供指令让 AI 生成并执行 SQL 语句。更多信息,请参见[开始使用 Chat2Query API](/tidb-cloud/use-chat2query-api.md)。

+此外,TiDB Cloud 为 TiDB Cloud Serverless 集群提供了 Chat2Query API。启用后,TiDB Cloud 会自动创建一个名为 Chat2Query 的系统 Data App,以及一个 Data Service 中的 Chat2Data endpoint。你可以调用该 endpoint,通过提供指令让 AI 生成并执行 SQL 语句。更多信息,参见 [Get started with Chat2Query API](/tidb-cloud/use-chat2query-api.md)。

## 向量搜索(Beta)

-向量搜索是一种优先考虑数据含义以提供相关结果的搜索方法。

+向量搜索是一种以数据语义为核心、提供相关性结果的搜索方式。

-与依赖精确关键词匹配和词频的传统全文搜索不同,向量搜索将各种数据类型(如文本、图像或音频)转换为高维向量,并基于这些向量之间的相似度进行查询。这种搜索方法捕捉数据的语义含义和上下文信息,从而更准确地理解用户意图。

+与依赖精确关键词匹配和词频的传统全文搜索不同,向量搜索会将多种数据类型(如文本、图片或音频)转换为高维向量,并基于这些向量之间的相似度进行查询。这种搜索方式能够捕捉数据的语义含义和上下文信息,从而更准确地理解用户意图。

-即使搜索词与数据库中的内容不完全匹配,向量搜索仍然可以通过分析数据的语义提供符合用户意图的结果。例如,对"会游泳的动物"进行全文搜索只会返回包含这些确切关键词的结果。相比之下,向量搜索可以返回其他会游泳的动物的结果,如鱼或鸭子,即使这些结果不包含确切的关键词。

+即使搜索词与数据库中的内容并不完全匹配,向量搜索也能通过分析数据的语义,返回符合用户意图的结果。例如,全文搜索 “a swimming animal” 只会返回包含这些精确关键词的结果。而向量搜索则可以返回其他游泳动物(如鱼或鸭子)的结果,即使这些结果中并不包含完全相同的关键词。

-更多信息,请参见[向量搜索(Beta)概述](/tidb-cloud/vector-search-overview.md)。

+更多信息,参见 [Vector Search (Beta) Overview](/vector-search/vector-search-overview.md)。

## AI 集成

### AI 框架

-TiDB 官方支持多个流行的 AI 框架,使你能够轻松地将基于这些框架开发的 AI 应用程序与 TiDB 向量搜索集成。

+TiDB 官方支持多种主流 AI 框架,使你能够轻松将基于这些框架开发的 AI 应用与 TiDB 向量搜索集成。

-有关支持的 AI 框架列表,请参见[向量搜索集成概述](/tidb-cloud/vector-search-integration-overview.md#ai-frameworks)。

+支持的 AI 框架列表,参见 [Vector Search Integration Overview](/vector-search/vector-search-integration-overview.md#ai-frameworks)。

-### 嵌入模型和服务

+### 嵌入模型与服务

-向量嵌入(也称为嵌入)是一个数字序列,用于在高维空间中表示现实世界的对象。它捕捉非结构化数据(如文档、图像、音频和视频)的含义和上下文。

+向量嵌入(embedding),也称为嵌入,是一组数字序列,用于在高维空间中表示现实世界的对象。它能够捕捉非结构化数据(如文档、图片、音频和视频)的语义和上下文信息。

-嵌入模型是将数据转换为[向量嵌入](/tidb-cloud/vector-search-overview.md#vector-embedding)的算法。选择合适的嵌入模型对于确保语义搜索结果的准确性和相关性至关重要。

+嵌入模型是一类将数据转换为 [vector embeddings](/vector-search/vector-search-overview.md#vector-embedding) 的算法。选择合适的嵌入模型对于确保语义搜索结果的准确性和相关性至关重要。

-TiDB 向量搜索支持存储最多 16383 维的向量,可以适应大多数嵌入模型。对于非结构化文本数据,你可以在 [Massive Text Embedding Benchmark (MTEB) 排行榜](https://huggingface.co/spaces/mteb/leaderboard)上找到性能最佳的文本嵌入模型。

+TiDB 向量搜索支持存储最多 16383 维的向量,能够满足大多数嵌入模型的需求。对于非结构化文本数据,你可以在 [Massive Text Embedding Benchmark (MTEB) Leaderboard](https://huggingface.co/spaces/mteb/leaderboard) 上找到表现最优的文本嵌入模型。

### 对象关系映射(ORM)库

-对象关系映射(ORM)库是一种工具,通过允许开发人员像处理编程语言中的对象一样处理数据库记录,从而促进应用程序和关系数据库之间的交互。

+对象关系映射(ORM)库是一类工具,能够让开发者以所选编程语言中的对象形式操作数据库记录,从而简化应用与关系型数据库之间的交互。

-TiDB 允许你将向量搜索与 ORM 库集成,以便与传统关系数据一起管理向量数据。这种集成对于需要存储和查询 AI 模型生成的向量嵌入的应用程序特别有用。通过使用 ORM 库,开发人员可以无缝地与存储在 TiDB 中的向量数据交互,利用数据库的功能执行最近邻搜索等复杂的向量操作。

+TiDB 支持将向量搜索与 ORM 库集成,实现对向量数据与传统关系数据的统一管理。这一集成对于需要存储和查询 AI 模型生成的向量嵌入的应用尤为有用。通过使用 ORM 库,开发者可以无缝操作存储在 TiDB 中的向量数据,利用数据库能力执行如最近邻搜索等复杂的向量操作。

-有关支持的 ORM 库列表,请参见[向量搜索集成概述](/tidb-cloud/vector-search-integration-overview.md#object-relational-mapping-orm-libraries)。

+支持的 ORM 库列表,参见 [Vector Search Integration Overview](/vector-search/vector-search-integration-overview.md#object-relational-mapping-orm-libraries)。

\ No newline at end of file

diff --git a/tidb-cloud/architecture-concepts.md b/tidb-cloud/architecture-concepts.md

index e0c124ceddfd2..4857f90bc27d8 100644

--- a/tidb-cloud/architecture-concepts.md

+++ b/tidb-cloud/architecture-concepts.md

@@ -5,100 +5,100 @@ summary: 了解 TiDB Cloud 的架构概念。

# 架构

-TiDB Cloud 是一个全托管的数据库即服务(DBaaS),它将开源 HTAP(混合事务和分析处理)数据库 [TiDB](https://docs.pingcap.com/tidb/stable/overview) 的灵活性和强大功能带到了 AWS、Azure 和 Google Cloud 平台。

+TiDB Cloud 是一款全托管的数据库即服务(DBaaS),将开源 HTAP(混合事务与分析处理)数据库 [TiDB](https://docs.pingcap.com/tidb/stable/overview) 的灵活性与强大功能带到 AWS、Azure 和 Google Cloud。

-TiDB 兼容 MySQL,这使得迁移和使用现有应用程序变得容易,同时提供无缝扩展能力,可以处理从小型工作负载到大规模高性能集群的各种场景。它在一个系统中同时支持事务处理(OLTP)和分析处理(OLAP)工作负载,简化了运维并实现了实时数据洞察。

+TiDB 兼容 MySQL,使得迁移和对接现有应用变得简单,同时具备无缝扩展能力,能够应对从小型负载到大规模高性能集群的各种需求。它在同一系统中同时支持事务型(OLTP)和分析型(OLAP)负载,简化运维并实现实时洞察。

-TiDB Cloud 提供两种部署选项:**TiDB Cloud Serverless**,用于自动扩展、成本效益高的工作负载,以及 **TiDB Cloud Dedicated**,用于具有专用资源和高级功能的企业级应用。TiDB Cloud 让你能够轻松扩展数据库、处理复杂的管理任务,并专注于开发可靠、高性能的应用程序。

+TiDB Cloud 提供两种部署选项:**TiDB Cloud** **Serverless**,适用于自动弹性伸缩、成本高效的负载,以及 **TiDB Cloud Dedicated**,为企业级应用提供专属资源和高级能力。TiDB Cloud 让你轻松扩展数据库,处理复杂的管理任务,专注于开发可靠且高性能的应用。

## TiDB Cloud Serverless

-TiDB Cloud Serverless 是一个全托管的无服务器解决方案,提供与传统 TiDB 类似的 HTAP 功能,同时提供自动扩展功能,以减轻用户在容量规划和管理复杂性方面的负担。它包含一个基础使用的免费层级,对超出免费限制的使用采用基于消费的计费方式。TiDB Cloud Serverless 提供两种高可用性选项以满足不同的运维需求。

+TiDB Cloud Serverless 是一款全托管的无服务器解决方案,提供与传统 TiDB 类似的 HTAP 能力,同时具备自动弹性伸缩,减轻用户在容量规划和管理复杂性方面的负担。它包含一个免费额度,超出免费额度的部分按用量计费。TiDB Cloud Serverless 提供两种高可用性类型,以满足不同的运维需求。

-默认情况下,使用可用区高可用性选项的集群将所有组件都部署在同一个可用区内,这样可以降低网络延迟。

+默认情况下,选择 Zonal High Availability 选项的集群,其所有组件都位于同一个可用区,从而带来更低的网络延迟。

-

+

-对于需要最大基础设施隔离和冗余的应用,区域高可用性选项会将节点分布在多个可用区中。

+对于需要最大基础设施隔离和冗余的应用,可以选择 Regional High Availability 选项,将节点分布在多个可用区。

-

+

## TiDB Cloud Dedicated

-TiDB Cloud Dedicated 专为关键业务而设计,提供跨多个可用区的高可用性、水平扩展和完整的 HTAP 功能。

+TiDB Cloud Dedicated 专为关键业务场景设计,提供跨多个可用区的高可用性、水平扩展能力以及完整的 HTAP 能力。

-它基于隔离的云资源构建,如 VPC、虚拟机、托管 Kubernetes 服务和云存储,充分利用主要云服务提供商的基础设施。TiDB Cloud Dedicated 集群支持完整的 TiDB 功能集,支持快速扩展、可靠备份、在特定 VPC 中部署以及地理级别的灾难恢复。

+它基于隔离的云资源(如 VPC、VM、托管 Kubernetes 服务和云存储)构建,充分利用主流云服务商的基础设施。TiDB Cloud Dedicated 集群支持完整的 TiDB 功能集,实现快速扩容、可靠备份、在指定 VPC 内部署以及地理级别的灾备能力。

-

+

## TiDB Cloud 控制台

-[TiDB Cloud 控制台](https://tidbcloud.com/)是 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 的基于 Web 的管理界面。它提供了管理集群、导入或迁移数据、监控性能指标、配置备份、设置安全控制以及与其他云服务集成的工具,所有这些都可以在一个用户友好的平台上完成。

+[TiDB Cloud 控制台](https://tidbcloud.com/) 是 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 的 Web 管理界面。你可以通过它管理集群、导入或迁移数据、监控性能指标、配置备份、设置安全控制,并与其他云服务集成,所有操作都在一个易用的平台上完成。

## TiDB Cloud CLI(Beta)

-TiDB Cloud CLI(`ticloud`)允许你通过简单的命令直接从终端管理 TiDB Cloud Serverless 和 TiDB Cloud Dedicated。你可以执行以下任务:

+TiDB Cloud CLI,即 `ticloud`,允许你通过简单命令在终端直接管理 TiDB Cloud Serverless 和 TiDB Cloud Dedicated。你可以执行如下任务:

- 创建、删除和列出集群。

- 向集群导入数据。

- 从集群导出数据。

-更多信息,请参见 [TiDB Cloud CLI 参考](/tidb-cloud/cli-reference.md)。

+更多信息,参见 [TiDB Cloud CLI Reference](/tidb-cloud/cli-reference.md)。

## TiDB Cloud API(Beta)

-TiDB Cloud API 是一个基于 REST 的接口,提供了对 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 资源进行编程访问的能力。它支持自动化和高效处理任务,如管理项目、集群、备份、恢复、数据导入、计费以及 [TiDB Cloud 数据服务](/tidb-cloud/data-service-overview.md)中的其他资源。

+TiDB Cloud API 是基于 REST 的接口,提供对 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 资源的编程访问能力。它支持自动化、高效地处理项目、集群、备份、恢复、数据导入、计费以及 [TiDB Cloud Data Service](/tidb-cloud/data-service-overview.md) 中的其他资源管理任务。

-更多信息,请参见 [TiDB Cloud API 概述](/tidb-cloud/api-overview.md)。

+更多信息,参见 [TiDB Cloud API Overview](/tidb-cloud/api-overview.md)。

## 节点

在 TiDB Cloud 中,每个集群由 TiDB、TiKV 和 TiFlash 节点组成。

-- 在 TiDB Cloud Dedicated 集群中,你可以根据性能需求完全管理专用 TiDB、TiKV 和 TiFlash 节点的数量和大小。更多信息,请参见[可扩展性](/tidb-cloud/scalability-concepts.md)。

-- 在 TiDB Cloud Serverless 集群中,TiDB、TiKV 和 TiFlash 节点的数量和大小是自动管理的。这确保了无缝扩展,无需用户处理节点配置或管理任务。

+- 在 TiDB Cloud Dedicated 集群中,你可以根据性能需求完全管理专属 TiDB、TiKV 和 TiFlash 节点的数量和规格。更多信息,参见 [Scalability](/tidb-cloud/scalability-concepts.md)。

+- 在 TiDB Cloud Serverless 集群中,TiDB、TiKV 和 TiFlash 节点的数量和规格由系统自动管理,实现无缝扩展,无需用户手动配置或管理节点。

### TiDB 节点

-[TiDB 节点](/tidb-computing.md)是一个无状态的 SQL 层,使用 MySQL 兼容的端点连接应用程序。它处理 SQL 查询的解析、优化和创建分布式执行计划等任务。

+[TiDB 节点](/tidb-computing.md) 是无状态的 SQL 层,通过兼容 MySQL 的端点与应用连接。它负责解析、优化 SQL 查询,并生成分布式执行计划。

-你可以部署多个 TiDB 节点以实现水平扩展并管理更高的工作负载。这些节点与负载均衡器(如 TiProxy 或 HAProxy)配合使用,提供无缝接口。TiDB 节点本身不存储数据——它们将数据请求转发到 TiKV 节点进行行式存储或 TiFlash 节点进行列式存储。

+你可以部署多个 TiDB 节点以实现水平扩展,满足更高的负载需求。这些节点通常与负载均衡器(如 TiProxy 或 HAProxy)配合,提供无缝的访问接口。TiDB 节点本身不存储数据——它们会将数据请求转发给 TiKV 节点(行存储)或 TiFlash 节点(列存储)。

### TiKV 节点

-[TiKV 节点](/tikv-overview.md)是 TiDB 架构中数据存储的核心,作为分布式事务性键值存储引擎,提供可靠性、可扩展性和高可用性。

+[TiKV 节点](/tikv-overview.md) 是 TiDB 架构中数据存储的核心,作为分布式事务型键值存储引擎,具备高可靠性、可扩展性和高可用性。

**主要特性:**

- **基于 Region 的数据存储**

- - 数据被划分为多个 [Region](https://docs.pingcap.com/tidb/dev/glossary#regionpeerraft-group),每个 Region 覆盖特定的键范围(左闭右开区间:从 `StartKey` 到 `EndKey`)。

- - 每个 TiKV 节点中共存多个 Region,确保高效的数据分布。

+ - 数据被划分为多个 [Region](https://docs.pingcap.com/tidb/dev/glossary#regionpeerraft-group),每个 Region 覆盖特定的 Key Range(左闭右开区间:`StartKey` 到 `EndKey`)。

+ - 每个 TiKV 节点内可包含多个 Region,实现高效的数据分布。

- **事务支持**

- - TiKV 节点在键值层面提供原生分布式事务支持,默认隔离级别为快照隔离。

- - TiDB 节点将 SQL 执行计划转换为对 TiKV 节点 API 的调用,实现无缝的 SQL 级事务支持。

+ - TiKV 节点在键值层面原生支持分布式事务,默认隔离级别为快照隔离(Snapshot Isolation)。

+ - TiDB 节点会将 SQL 执行计划转化为对 TiKV 节点 API 的调用,从而实现无缝的 SQL 级事务支持。

- **高可用性**

- - TiKV 节点中的所有数据都会被复制(默认三副本)以确保持久性。

- - TiKV 确保原生高可用性并支持自动故障转移,防止节点故障。

+ - TiKV 节点中的所有数据都会被复制(默认三副本),以保证数据持久性。

+ - TiKV 原生支持高可用和自动故障转移,保障节点故障时的数据安全。

-- **可扩展性和可靠性**

+- **可扩展性与可靠性**

- - TiKV 节点设计用于处理不断扩大的数据集,同时保持分布式一致性和容错性。

+ - TiKV 节点设计用于应对不断扩展的数据集,同时保持分布式一致性和容错能力。

### TiFlash 节点

-[TiFlash 节点](/tiflash/tiflash-overview.md)是 TiDB 架构中的一种专门存储节点。与普通的 TiKV 节点不同,TiFlash 采用列式存储模型,专为分析加速而设计。

+[TiFlash 节点](/tiflash/tiflash-overview.md) 是 TiDB 架构中的一种专用存储节点。与普通 TiKV 节点不同,TiFlash 采用列式存储模型,专为分析加速设计。

**主要特性:**

- **列式存储**

- TiFlash 节点以列式格式存储数据,这使其针对分析查询进行了优化,显著提高了读密集型工作负载的性能。

+ TiFlash 节点以列式格式存储数据,针对分析型查询进行了优化,大幅提升了读密集型负载的性能。

-- **向量搜索索引支持**

+- **向量检索索引支持**

- 向量搜索索引功能使用表的 TiFlash 副本,支持高级搜索功能,提高复杂分析场景的效率。

+ 向量检索索引功能利用表的 TiFlash 副本,实现高级检索能力,并提升复杂分析场景下的效率。

\ No newline at end of file

diff --git a/tidb-cloud/backup-and-restore-concepts.md b/tidb-cloud/backup-and-restore-concepts.md

index c2ce2fffc6eb9..cd5e4d214f7db 100644

--- a/tidb-cloud/backup-and-restore-concepts.md

+++ b/tidb-cloud/backup-and-restore-concepts.md

@@ -1,42 +1,42 @@

---

-title: 备份和恢复

-summary: 了解 TiDB Cloud 的备份和恢复概念。

+title: 备份与恢复

+summary: 了解 TiDB Cloud 的备份与恢复相关概念。

---

-# 备份和恢复

+# 备份与恢复

-TiDB Cloud 备份和恢复功能旨在通过使你能够备份和恢复集群数据来保护你的数据并确保业务连续性。

+TiDB Cloud 的备份与恢复功能旨在保护你的数据安全,并通过支持集群数据的备份与恢复,保障业务的连续性。

## 自动备份

-对于 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 集群,默认情况下会自动进行快照备份,并根据你的备份保留策略进行存储。

+对于 TiDB Cloud Serverless 和 TiDB Cloud Dedicated 集群,默认会自动进行快照备份,并根据你的备份保留策略进行存储。

-更多信息,请参见以下内容:

+如需了解更多信息,请参见以下内容:

- [TiDB Cloud Serverless 集群的自动备份](/tidb-cloud/backup-and-restore-serverless.md#automatic-backups)

- [TiDB Cloud Dedicated 集群的自动备份](/tidb-cloud/backup-and-restore.md#turn-on-auto-backup)

## 手动备份

-手动备份是 TiDB Cloud Dedicated 的一项功能,使你能够根据需要将数据备份到已知状态,然后随时恢复到该状态。

+手动备份是 TiDB Cloud Dedicated 的一项功能,允许你根据需要将数据备份到已知状态,并可在任何时间恢复到该状态。

-更多信息,请参见[执行手动备份](/tidb-cloud/backup-and-restore.md#perform-a-manual-backup)。

+如需了解更多信息,请参见 [执行手动备份](/tidb-cloud/backup-and-restore.md#perform-a-manual-backup)。

## 双区域备份

-双区域备份是 TiDB Cloud Dedicated 的一项功能,使你能够将备份从集群所在区域复制到另一个不同的区域。启用后,所有备份都会自动复制到指定区域。这提供了跨区域数据保护和灾难恢复能力。估计约 99% 的数据可以在一小时内复制到次要区域。

+双区域备份是 TiDB Cloud Dedicated 的一项功能,允许你将集群所在区域的备份复制到另一个不同的区域。启用后,所有备份会自动复制到指定区域。这为跨区域数据保护和灾难恢复提供了能力。预计大约 99% 的数据可以在一小时内复制到次级区域。

-更多信息,请参见[开启双区域备份](/tidb-cloud/backup-and-restore.md#turn-on-dual-region-backup)。

+如需了解更多信息,请参见 [开启双区域备份](/tidb-cloud/backup-and-restore.md#turn-on-dual-region-backup)。

## 时间点恢复

-时间点恢复是一项功能,使你能够将任意时间点的数据恢复到新集群。你可以使用它来:

+时间点恢复是一项功能,允许你将任意时间点的数据恢复到一个新集群。你可以使用该功能:

- 降低灾难恢复中的 RPO。

-- 通过恢复到错误事件发生之前的时间点来解决数据写入错误的情况。

+- 通过恢复到错误事件发生前的时间点,解决数据写入错误的问题。

- 审计业务的历史数据。

如果你想执行时间点恢复,请注意以下事项:

-- 对于 TiDB Cloud Serverless 集群,时间点恢复仅适用于可扩展集群,不适用于免费集群。更多信息,请参见[恢复模式](/tidb-cloud/backup-and-restore-serverless.md#restore-mode)。

-- 对于 TiDB Cloud Dedicated 集群,你需要提前[启用 PITR](/tidb-cloud/backup-and-restore.md#turn-on-point-in-time-restore)。

+- 对于 TiDB Cloud Serverless 集群,时间点恢复仅适用于可扩展集群,不适用于免费集群。更多信息请参见 [恢复模式](/tidb-cloud/backup-and-restore-serverless.md#restore-mode)。

+- 对于 TiDB Cloud Dedicated 集群,你需要提前 [开启 PITR](/tidb-cloud/backup-and-restore.md#turn-on-point-in-time-restore)。

\ No newline at end of file

diff --git a/tidb-cloud/backup-and-restore-serverless.md b/tidb-cloud/backup-and-restore-serverless.md

index b8b3cc58c0b09..399acb54b4a4d 100644

--- a/tidb-cloud/backup-and-restore-serverless.md

+++ b/tidb-cloud/backup-and-restore-serverless.md

@@ -1,76 +1,76 @@

---

-title: 备份和恢复 TiDB Cloud Serverless 数据

-summary: 了解如何备份和恢复 TiDB Cloud Serverless 集群。

+title: 备份与恢复 TiDB Cloud Serverless 数据

+summary: 了解如何备份和恢复你的 TiDB Cloud Serverless 集群。

aliases: ['/tidbcloud/restore-deleted-tidb-cluster']

---

-# 备份和恢复 TiDB Cloud Serverless 数据

+# 备份与恢复 TiDB Cloud Serverless 数据

-本文介绍如何在 TiDB Cloud 上备份和恢复 TiDB Cloud Serverless 集群数据。

+本文档介绍了如何在 TiDB Cloud 上备份和恢复你的 TiDB Cloud Serverless 集群数据。

-> **提示:**

+> **Tip:**

>

-> 要了解如何备份和恢复 TiDB Cloud Dedicated 集群数据,请参阅[备份和恢复 TiDB Cloud Dedicated 数据](/tidb-cloud/backup-and-restore.md)。

+> 如需了解如何备份和恢复 TiDB Cloud Dedicated 集群数据,请参见 [Back Up and Restore TiDB Cloud Dedicated Data](/tidb-cloud/backup-and-restore.md)。

## 查看备份页面

-1. 在[**集群**](https://tidbcloud.com/project/clusters)页面,点击目标集群的名称进入其概览页面。

+1. 在 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,点击目标集群的名称,进入其概览页面。

- > **提示:**

+ > **Tip:**

>

- > 你可以使用左上角的组合框在组织、项目和集群之间切换。

+ > 你可以使用左上角的下拉框在组织、项目和集群之间切换。

-2. 在左侧导航栏中,点击**数据** > **备份**。

+2. 在左侧导航栏,点击 **Data** > **Backup**。

## 自动备份

-TiDB Cloud Serverless 自动备份你的集群数据,允许你从备份快照恢复数据,以在发生灾难时最大限度地减少数据丢失。

+TiDB Cloud Serverless 会自动备份你的集群数据,使你能够从备份快照中恢复数据,以最大程度减少灾难发生时的数据丢失。

### 了解备份设置

-免费集群和可扩展集群的自动备份设置有所不同,如下表所示:

+自动备份设置在免费集群和可扩展集群之间有所不同,具体如下表所示:

-| 备份设置 | 免费集群 | 可扩展集群 |

-|------------------|--------------|------------------|

-| 备份周期 | 每日 | 每日 |

-| 备份保留期 | 1 天 | 14 天 |

-| 备份时间 | 固定时间 | 可配置 |

+| 备份设置 | 免费集群 | 可扩展集群 |

+|------------------|--------------|--------------------|

+| Backup Cycle | Daily | Daily |

+| Backup Retention | 1 day | 14 days |

+| Backup Time | Fixed time | Configurable |

-- **备份周期**是进行备份的频率。

+- **Backup Cycle** 表示备份的频率。

-- **备份保留期**是备份保留的时间。过期的备份无法恢复。

+- **Backup Retention** 表示备份的保留时长。过期的备份无法恢复。

-- **备份时间**是开始调度备份的时间。注意,最终的备份时间可能会晚于配置的备份时间。

+- **Backup Time** 表示备份开始调度的时间。请注意,最终的备份时间可能会滞后于配置的备份时间。

- - 免费集群:备份时间是随机固定的时间。

- - 可扩展集群:你可以将备份时间配置为每半小时。默认值是随机固定的时间。

+ - 免费集群:备份时间为随机固定时间。

+ - 可扩展集群:你可以将备份时间配置为每半小时一次。默认值为随机固定时间。

### 配置备份设置

-要为可扩展集群设置备份时间,请执行以下步骤:

+如需为可扩展集群设置备份时间,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。这将打开**备份设置**窗口,你可以根据需求配置自动备份设置。

+2. 点击 **Backup Setting**。此操作会打开 **Backup Setting** 窗口,你可以根据需求配置自动备份设置。

-3. 在**备份时间**中,为每日集群备份安排一个开始时间。

+3. 在 **Backup Time** 中,为每日集群备份安排开始时间。

-4. 点击**确认**。

+4. 点击 **Confirm**。

## 恢复

-TiDB Cloud Serverless 集群提供恢复功能,帮助在意外数据丢失或损坏时恢复数据。

+TiDB Cloud Serverless 集群提供恢复功能,帮助在数据意外丢失或损坏时进行数据恢复。

### 恢复模式

-TiDB Cloud Serverless 支持集群的快照恢复和时间点恢复。

+TiDB Cloud Serverless 支持快照恢复和时间点恢复。

-- **快照恢复**:从特定备份快照恢复集群。

+- **Snapshot Restore**:从指定的备份快照恢复你的集群。

-- **时间点恢复(beta)**:将集群恢复到特定时间点。

+- **Point-in-Time Restore (beta)**:将你的集群恢复到指定时间点。

- 免费集群:不支持。

- - 可扩展集群:可以恢复到过去 14 天内的任意时间点,但不能早于集群创建时间或晚于当前时间减去一分钟。

+ - 可扩展集群:可恢复到最近 14 天内的任意时间,但不能早于集群创建时间,也不能晚于当前时间减去 1 分钟。

### 恢复目标

@@ -78,82 +78,82 @@ TiDB Cloud Serverless 支持原地恢复和恢复到新集群。

**原地恢复**

-恢复到当前集群将覆盖现有数据。请注意以下事项:

+恢复到当前集群会覆盖现有数据。请注意以下事项:

-- 一旦开始恢复,现有连接将被终止。

-- 在恢复过程中,集群将不可用,新的连接将被阻止。

-- 恢复将影响 `mysql` 架构中的表。对用户凭据、权限或系统变量的任何更改都将恢复到备份时的状态。

+- 恢复开始后,现有连接会被终止。

+- 恢复过程中,集群将不可用,新的连接会被阻塞。

+- 恢复会影响 `mysql` schema 下的表。用户凭证、权限或系统变量的任何更改都将回退到备份时的状态。

**恢复到新集群**

创建并恢复到新集群。请注意以下事项:

-- 源集群的用户凭据和权限不会恢复到新集群。

+- 源集群的用户凭证和权限不会恢复到新集群。

### 恢复超时

-恢复过程通常在几分钟内完成。如果恢复时间超过三小时,将自动取消。取消恢复的结果取决于目标:

+恢复过程通常会在几分钟内完成。如果恢复超过 3 小时,将会被自动取消。被取消的恢复结果取决于恢复目标:

-- **原地恢复**:集群状态从**恢复中**变为**可用**,集群变为可访问。

-- **恢复到新集群**:新集群被删除,源集群保持不变。

+- **In-place restore**:集群状态会从 **Restoring** 变为 **Available**,集群重新可用。

+- **Restore to a new cluster**:新集群会被删除,源集群保持不变。

-如果取消恢复后数据损坏且无法恢复,请联系 [TiDB Cloud 支持团队](/tidb-cloud/tidb-cloud-support.md)寻求帮助。

+如果恢复被取消后数据损坏且无法恢复,请联系 [TiDB Cloud Support](/tidb-cloud/tidb-cloud-support.md) 获取帮助。

### 执行恢复

-要恢复你的 TiDB Cloud Serverless 集群,请按照以下步骤操作:

+如需恢复你的 TiDB Cloud Serverless 集群,请按照以下步骤操作:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**恢复**。设置窗口显示。

+2. 点击 **Restore**。会弹出设置窗口。

-3. 在**恢复模式**中,你可以选择从特定备份恢复或从任意时间点恢复。

+3. 在 **Restore Mode** 中,你可以选择从指定备份或任意时间点进行恢复。

-

-1. 运行以下命令,将 `.env.example` 复制并重命名为 `.env`:

+1. 运行以下命令,复制 `.env.example` 并重命名为 `.env`:

```shell

cp .env.example .env

```

-2. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例内容如下:

+2. 将对应的连接字符串复制粘贴到 `.env` 文件中。示例结果如下:

```dotenv

TIDB_HOST='{tidb_server_host}'

@@ -169,14 +169,14 @@ peewee 是一个支持多数据库的 ORM 库。它为数据库提供了高级

TIDB_DB_NAME='test'

```

- 一定要将 `{}` 占位符替换为连接参数,并删除 `CA_PATH` 行。如果你在本地运行 TiDB,默认主机地址为 `127.0.0.1`,密码为空。

+ 请务必将 `{}` 占位符替换为连接参数,并删除 `CA_PATH` 这一行。如果你在本地运行 TiDB,默认主机地址为 `127.0.0.1`,密码为空。

3. 保存 `.env` 文件。

-### 步骤 4:运行代码并检查结果

+### 第 4 步:运行代码并检查结果

1. 执行以下命令运行示例代码:

@@ -184,15 +184,15 @@ peewee 是一个支持多数据库的 ORM 库。它为数据库提供了高级

python peewee_example.py

```

-2. 查看 [Expected-Output.txt](https://github.com/tidb-samples/tidb-python-peewee-quickstart/blob/main/Expected-Output.txt),确认输出是否匹配。

+2. 检查 [Expected-Output.txt](https://github.com/tidb-samples/tidb-python-peewee-quickstart/blob/main/Expected-Output.txt) 文件,确认输出是否一致。

## 示例代码片段

你可以参考以下示例代码片段,完成你自己的应用开发。

-完整示例代码和运行方法,请查看 [tidb-samples/tidb-python-peewee-quickstart](https://github.com/tidb-samples/tidb-python-peewee-quickstart) 仓库。

+完整示例代码及运行方法请参考 [tidb-samples/tidb-python-peewee-quickstart](https://github.com/tidb-samples/tidb-python-peewee-quickstart) 仓库。

-### 连接到 TiDB

+### 连接 TiDB

```python

from peewee import MySQLDatabase

@@ -216,7 +216,7 @@ def get_db_engine():

)

```

-使用此函数时,需要将 `${tidb_host}`、`${tidb_port}`、`${tidb_user}`、`${tidb_password}`、`${tidb_db_name}` 和 `${ca_path}` 替换为你的 TiDB 集群的实际值。

+使用该函数时,你需要将 `${tidb_host}`、`${tidb_port}`、`${tidb_user}`、`${tidb_password}`、`${tidb_db_name}` 和 `${ca_path}` 替换为你 TiDB 集群的实际值。

### 定义数据表

@@ -238,15 +238,15 @@ class Player(BaseModel):

table_name = "players"

```

-更多信息请参考 [peewee 文档:Models 和 Fields](https://docs.peewee-orm.com/en/latest/peewee/models.html)。

+更多信息请参考 [peewee 文档:Models and Fields](https://docs.peewee-orm.com/en/latest/peewee/models.html)。

### 插入数据

```python

-# 插入单条记录

+# Insert a single record

Player.create(name="test", coins=100, goods=100)

-# 插入多条记录

+# Insert multiple records

Player.insert_many(

[

{"name": "test1", "coins": 100, "goods": 100},

@@ -255,66 +255,66 @@ Player.insert_many(

).execute()

```

-更多信息请参考 [Insert data](/develop/dev-guide-insert-data.md)。

+更多信息请参考 [插入数据](/develop/dev-guide-insert-data.md)。

### 查询数据

```python

-# 查询所有记录

+# Query all records

players = Player.select()

-# 查询单条记录

+# Query a single record

player = Player.get(Player.name == "test")

-# 查询多条记录

+# Query multiple records

players = Player.select().where(Player.coins == 100)

```

-更多信息请参考 [Query data](/develop/dev-guide-get-data-from-single-table.md)。

+更多信息请参考 [查询数据](/develop/dev-guide-get-data-from-single-table.md)。

### 更新数据

```python

-# 更新单条记录

+# Update a single record

player = Player.get(Player.name == "test")

player.coins = 200

player.save()

-# 更新多条记录

+# Update multiple records

Player.update(coins=200).where(Player.coins == 100).execute()

```

-更多信息请参考 [Update data](/develop/dev-guide-update-data.md)。

+更多信息请参考 [更新数据](/develop/dev-guide-update-data.md)。

### 删除数据

```python

-# 删除单条记录

+# Delete a single record

player = Player.get(Player.name == "test")

player.delete_instance()

-# 删除多条记录

+# Delete multiple records

Player.delete().where(Player.coins == 100).execute()

```

-更多信息请参考 [Delete data](/develop/dev-guide-delete-data.md)。

+更多信息请参考 [删除数据](/develop/dev-guide-delete-data.md)。

## 后续步骤

-- 通过 [peewee 文档](https://docs.peewee-orm.com/) 学习更多用法。

-- 参考 [开发者指南](https://github.com/tidb-samples/tidb-python-peewee-quickstart) 中的章节,学习 TiDB 应用开发的最佳实践,例如 [Insert data](/develop/dev-guide-insert-data.md)、[Update data](/develop/dev-guide-update-data.md)、[Delete data](/develop/dev-guide-delete-data.md)、[Single table reading](/develop/dev-guide-get-data-from-single-table.md)、[Transactions](/develop/dev-guide-transaction-overview.md) 和 [SQL 性能优化](/develop/dev-guide-optimize-sql-overview.md)。

-- 通过专业的 [TiDB 开发者课程](https://www.pingcap.com/education/) 学习,并在考试通过后获得 [TiDB 认证](https://www.pingcap.com/education/certification/)。

+- 通过 [peewee 官方文档](https://docs.peewee-orm.com/) 学习更多 peewee 的用法。

+- 通过 [开发者指南](/develop/dev-guide-overview.md) 各章节,学习 TiDB 应用开发最佳实践,例如 [插入数据](/develop/dev-guide-insert-data.md)、[更新数据](/develop/dev-guide-update-data.md)、[删除数据](/develop/dev-guide-delete-data.md)、[单表读取](/develop/dev-guide-get-data-from-single-table.md)、[事务](/develop/dev-guide-transaction-overview.md) 以及 [SQL 性能优化](/develop/dev-guide-optimize-sql-overview.md)。

+- 通过专业的 [TiDB 开发者课程](https://www.pingcap.com/education/),并在通过考试后获得 [TiDB 认证](https://www.pingcap.com/education/certification/)。

## 需要帮助?

+

- 要从选定的备份快照恢复,请执行以下步骤:

+ 如需从选定的备份快照恢复,请执行以下步骤:

- 1. 点击**快照恢复**。

- 2. 选择要恢复的备份快照。

+ 1. 点击 **Snapshot Restore**。

+ 2. 选择你要恢复的备份快照。

-

+

-

- 要将可扩展集群恢复到特定时间点,请执行以下步骤:

+ 如需为可扩展集群恢复到指定时间点,请执行以下步骤:

- 1. 点击**时间点恢复**。

- 2. 选择要恢复到的日期和时间。

+ 1. 点击 **Point-in-Time Restore**。

+ 2. 选择你要恢复到的日期和时间。

-4. 在**目标**中,你可以选择恢复到新集群或原地恢复。

+4. 在 **Destination** 中,你可以选择恢复到新集群或原地恢复。

+

- 要恢复到新集群,请执行以下步骤:

+ 如需恢复到新集群,请执行以下步骤:

- 1. 点击**恢复到新集群**。

- 2. 为新集群输入名称。

- 3. 为新集群选择集群方案。

- 4. 如果你选择可扩展集群,请设置每月支出限额,然后根据需要配置高级设置。否则,跳过此步骤。

+ 1. 点击 **Restore to a New Cluster**。

+ 2. 输入新集群的名称。

+ 3. 选择新集群的集群方案。

+ 4. 如果你选择的是可扩展集群,请设置每月消费上限,并根据需要配置高级设置。否则跳过此步骤。

-

+

-

- 要原地恢复,点击**原地恢复**。

+ 如需原地恢复,点击 **In-place Restore**。

-5. 点击**恢复**开始恢复过程。

+5. 点击 **Restore** 开始恢复流程。

-一旦恢复过程开始,集群状态将变为**恢复中**。集群将保持不可用状态,直到恢复完成且状态变为**可用**。

+恢复流程开始后,集群状态会变为 **Restoring**。在恢复完成并状态变为 **Available** 之前,集群将保持不可用。

## 限制

-- 如果启用了 TiFlash 副本,在恢复后它将在一段时间内不可用,因为数据需要在 TiFlash 中重建。

+- 如果启用了 TiFlash 副本,恢复后 TiFlash 会有一段时间不可用,因为数据需要在 TiFlash 中重建。

- TiDB Cloud Serverless 集群不支持手动备份。

-- 默认情况下,数据量超过 1 TiB 的集群不支持恢复到新集群。如需处理更大的数据集,请联系 [TiDB Cloud 支持团队](/tidb-cloud/tidb-cloud-support.md)寻求帮助。

+- 数据量超过 1 TiB 的集群默认不支持恢复到新集群。如需处理更大数据集,请联系 [TiDB Cloud Support](/tidb-cloud/tidb-cloud-support.md) 获取帮助。

\ No newline at end of file

diff --git a/tidb-cloud/backup-and-restore.md b/tidb-cloud/backup-and-restore.md

index d23270ae8f6eb..5f1bb7bb58fa0 100644

--- a/tidb-cloud/backup-and-restore.md

+++ b/tidb-cloud/backup-and-restore.md

@@ -1,274 +1,274 @@

---

-title: 备份和恢复 TiDB Cloud Dedicated 数据

-summary: 了解如何备份和恢复 TiDB Cloud Dedicated 集群。

+title: 备份与恢复 TiDB Cloud 专属集群数据

+summary: 了解如何备份和恢复你的 TiDB Cloud 专属集群。

aliases: ['/tidbcloud/restore-deleted-tidb-cluster']

---

-# 备份和恢复 TiDB Cloud Dedicated 数据

+# 备份与恢复 TiDB Cloud 专属集群数据

-本文档介绍如何在 TiDB Cloud 上备份和恢复 TiDB Cloud Dedicated 集群数据。TiDB Cloud Dedicated 支持自动备份和手动备份。你还可以将备份数据恢复到新集群,或从回收站恢复已删除的集群。

+本文档介绍了如何在 TiDB Cloud 上备份和恢复你的 TiDB Cloud 专属集群数据。TiDB Cloud 专属集群支持自动备份和手动备份。你还可以将备份数据恢复到新集群,或从回收站恢复已删除的集群。

-> **提示**

+> **Tip**

>

-> 要了解如何备份和恢复 TiDB Cloud Serverless 集群数据,请参阅[备份和恢复 TiDB Cloud Serverless 数据](/tidb-cloud/backup-and-restore-serverless.md)。

+> 如需了解如何备份和恢复 TiDB Cloud Serverless 集群数据,请参见 [备份与恢复 TiDB Cloud Serverless 数据](/tidb-cloud/backup-and-restore-serverless.md)。

## 限制

-- 对于 v6.2.0 或更高版本的集群,TiDB Cloud Dedicated 默认支持从备份中恢复用户账号和 SQL 绑定。

-- TiDB Cloud Dedicated 不支持恢复存储在 `mysql` 架构中的系统变量。

-- 建议你先导入数据,然后执行**手动**快照备份,最后启用时间点恢复。因为通过 TiDB Cloud 控制台导入的数据**不会**生成变更日志,无法自动检测和备份。更多信息,请参阅[从云存储将 CSV 文件导入到 TiDB Cloud Dedicated](/tidb-cloud/import-csv-files.md)。

-- 如果多次开启和关闭时间点恢复,你只能选择最近一次启用时间点恢复后的可恢复范围内的时间点。早期的可恢复范围将无法访问。

-- 请勿同时修改**时间点恢复**和**双区域备份**的开关。

+- 对于 v6.2.0 及以上版本的集群,TiDB Cloud 专属集群默认支持从备份中恢复用户账户和 SQL 绑定。

+- TiDB Cloud 专属集群不支持恢复存储在 `mysql` schema 中的系统变量。

+- 建议你先导入数据,然后执行一次**手动**快照备份,最后开启 Point-in-time Restore。因为通过 TiDB Cloud 控制台导入的数据**不会**生成变更日志,无法被自动检测和备份。更多信息请参见 [从云存储导入 CSV 文件到 TiDB Cloud 专属集群](/tidb-cloud/import-csv-files.md)。

+- 如果你多次开启和关闭 Point-in-time Restore,只能选择最近一次开启后可恢复范围内的时间点,之前的可恢复范围将无法访问。

+- **不要**同时修改 **Point-in-time Restore** 和 **Dual Region Backup** 的开关。

## 备份

### 查看备份页面

-1. 在项目的[**集群**](https://tidbcloud.com/project/clusters)页面上,点击目标集群的名称以进入其概览页面。

+1. 在项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,点击目标集群名称进入其概览页面。

- > **提示:**

+ > **Tip:**

>

- > 你可以使用左上角的组合框在组织、项目和集群之间切换。

+ > 你可以使用左上角的下拉框在组织、项目和集群之间切换。

-2. 在左侧导航栏中,点击**数据** > **备份**。

+2. 在左侧导航栏,点击 **Data** > **Backup**。

### 开启自动备份

-TiDB Cloud Dedicated 支持[快照备份](https://docs.pingcap.com/tidb/stable/br-snapshot-guide)和[日志备份](https://docs.pingcap.com/tidb/stable/br-pitr-guide)。快照备份使你能够将数据恢复到备份点。默认情况下,快照备份会根据你的备份保留策略自动进行并存储。你可以随时禁用自动备份。

+TiDB Cloud 专属集群支持 [快照备份](https://docs.pingcap.com/tidb/stable/br-snapshot-guide) 和 [日志备份](https://docs.pingcap.com/tidb/stable/br-pitr-guide)。快照备份可以让你将数据恢复到备份时的状态。默认情况下,快照备份会自动执行并根据你的备份保留策略进行存储。你可以随时关闭自动备份。

-#### 开启时间点恢复

+#### 开启 Point-in-time Restore

-> **注意**

+> **Note**

>

-> 时间点恢复功能支持 v6.4.0 或更高版本的 TiDB Cloud Dedicated 集群。

+> Point-in-time Restore 功能仅支持 v6.4.0 及以上版本的 TiDB Cloud 专属集群。

-此功能支持将任意时间点的数据恢复到新集群。你可以使用它来:

+该功能支持将任意时间点的数据恢复到新集群。你可以用它来:

-- 降低灾难恢复的 RPO。

-- 通过恢复到错误事件发生前的时间点来解决数据写入错误的情况。

+- 降低灾备场景下的 RPO。

+- 通过恢复到错误事件发生前的时间点,解决数据写入错误问题。

- 审计业务的历史数据。

-强烈建议开启此功能。成本与快照备份相同。更多信息,请参阅[数据备份成本](https://www.pingcap.com/tidb-dedicated-pricing-details#backup-storage-cost)。

+强烈建议你开启此功能。其费用与快照备份相同。更多信息请参见 [数据备份费用](https://www.pingcap.com/tidb-dedicated-pricing-details#backup-storage-cost)。

-要为 TiDB Cloud Dedicated 集群开启此功能,请执行以下步骤:

+要为你的 TiDB Cloud 专属集群开启此功能,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。

+2. 点击 **Backup Setting**。

-3. 将**自动备份**开关切换为**开启**。

+3. 将 **Auto Backup** 开关切换为 **On**。

-4. 将**时间点恢复**开关切换为**开启**。

+4. 将 **Point-in-time Restore** 开关切换为 **On**。

- > **警告**

+ > **Warning**

>

- > 时间点恢复仅在下一次备份任务完成后生效。要使其更早生效,你可以在启用后[手动执行备份](#执行手动备份)。

+ > Point-in-Time Restore 仅在下一个备份任务完成后生效。若需提前生效,可以在开启后[手动执行一次备份](#perform-a-manual-backup)。

-5. 点击**保存**以保存更改。

+5. 点击 **Save** 保存更改。

#### 配置备份计划

-TiDB Cloud Dedicated 支持每日和每周备份计划。默认情况下,备份计划设置为每日。你可以选择一天或一周中的特定时间开始快照备份。

+TiDB Cloud 专属集群支持每日和每周备份计划。默认情况下,备份计划为每日。你可以选择一天或一周中的特定时间启动快照备份。

-要为 TiDB Cloud Dedicated 集群配置备份计划,请执行以下步骤:

+要为你的 TiDB Cloud 专属集群配置备份计划,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。

+2. 点击 **Backup Setting**。

-3. 将**自动备份**开关切换为**开启**。

+3. 将 **Auto Backup** 开关切换为 **On**。

-4. 按如下配置备份计划:

+4. 按如下方式配置备份计划:

- - 在**备份周期**中,点击**每日备份**或**每周备份**选项卡。对于**每周备份**,你需要指定备份的星期几。

+ - 在 **Backup Cycle** 中,点击 **Daily Backup** 或 **Weekly Backup** 标签。若选择 **Weekly Backup**,需指定每周的备份日期。

- > **警告**

+ > **Warning**

>

- > - 启用每周备份时,时间点恢复功能默认开启且无法禁用。

- > - 如果你将备份周期从每周更改为每日,时间点恢复功能将保持其原始设置。如果需要,你可以手动禁用它。

+ > - 启用每周备份时,Point-in-time Restore 功能会默认开启且无法关闭。

+ > - 若将备份周期从每周切换为每日,Point-in-time Restore 功能会保持原有设置。你可以根据需要手动关闭。

- - 在**备份时间**中,为每日或每周集群备份安排开始时间。

+ - 在 **Backup Time** 中,设置每日或每周集群备份的开始时间。

- 如果你未指定首选备份时间,TiDB Cloud 会分配默认备份时间,即集群所在区域时区的凌晨 2:00。

+ 如果你未指定备份时间,TiDB Cloud 会分配默认备份时间,即集群所在区域时区的凌晨 2:00。

- > **注意**

+ > **Note**

>

- > - 当数据导入作业正在进行时,备份作业会自动延迟。在数据导入或集群扩展期间**请勿**运行手动备份。

+ > - 当数据导入任务进行中时,备份任务会自动延迟。**不要**在数据导入或集群扩容期间执行手动备份。

- - 在**备份保留**中,配置最短备份数据保留期。默认期限为 7 天。为了最大限度地减少对业务的影响,建议在工作负载较低的时段安排自动备份。

+ - 在 **Backup Retention** 中,配置备份数据的最小保留周期。默认周期为 7 天。为尽量减少对业务的影响,建议在业务低峰期安排自动备份。

- > **注意**

+ > **Note**

>

- > - 除最新的自动备份外,所有超过保留期的自动备份都将被删除。最新的自动备份不会被删除,除非你手动删除它。这确保了在发生意外删除时,你可以恢复集群数据。

- > - 删除集群后,保留期内的自动备份将移至回收站。

+ > - 除最新备份外,所有超出保留周期的自动备份将被删除。最新的自动备份不会被删除,除非你手动删除它。这样可以确保在误删时仍可恢复集群数据。

+ > - 删除集群后,保留周期内的自动备份会被移入回收站。

### 开启双区域备份

-> **注意:**

+> **Note:**

>

> - 目前,双区域备份功能仅适用于托管在 AWS 和 Google Cloud 上的集群。

-> - 托管在 Google Cloud 上的 TiDB Cloud Dedicated 集群与 Google Cloud Storage 无缝协作。与 Google Cloud Storage 类似,**TiDB Cloud Dedicated 仅支持在相同的多区域代码内进行双区域配对,就像 Google 双区域存储一样**。例如,在亚洲,目前你必须将东京和大阪配对在一起以进行双区域存储。更多信息,请参阅[双区域](https://cloud.google.com/storage/docs/locations#location-dr)。

+> - 托管在 Google Cloud 上的 TiDB Cloud 专属集群可无缝对接 Google Cloud Storage。与 Google Cloud Storage 类似,**TiDB Cloud 专属集群仅支持在同一多区域代码下的 Google 双区域存储配对**。例如,在亚洲,目前必须将东京和大阪配对用于双区域存储。更多信息请参见 [Dual-regions](https://cloud.google.com/storage/docs/locations#location-dr)。

-TiDB Cloud Dedicated 支持通过将备份从集群区域复制到另一个不同区域来实现双区域备份。启用此功能后,所有备份都会自动复制到指定区域。这提供了跨区域数据保护和灾难恢复能力。估计约 99% 的数据可以在一小时内复制到次要区域。

+TiDB Cloud 专属集群支持双区域备份,通过将集群所在区域的备份复制到另一个不同区域。开启该功能后,所有备份会自动复制到指定区域。这为数据跨区域保护和灾难恢复提供了能力。预计约 99% 的数据可在一小时内复制到次级区域。

-双区域备份成本包括备份存储使用费和跨区域数据传输费。更多信息,请参阅[数据备份成本](https://www.pingcap.com/tidb-dedicated-pricing-details#backup-storage-cost)。

+双区域备份费用包括备份存储用量和跨区域数据传输费用。更多信息请参见 [数据备份费用](https://www.pingcap.com/tidb-dedicated-pricing-details#backup-storage-cost)。

-要为 TiDB Cloud Dedicated 集群开启双区域备份,请执行以下步骤:

+要为你的 TiDB Cloud 专属集群开启双区域备份,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。

+2. 点击 **Backup Setting**。

-3. 将**双区域备份**开关切换为**开启**。

+3. 将 **Dual Region Backup** 开关切换为 **On**。

-4. 从**次要区域**下拉列表中,选择一个区域来存储备份文件。

+4. 在 **Secondary Region** 下拉列表中,选择用于存储备份文件的区域。

-5. 点击**保存**以保存更改。

+5. 点击 **Save** 保存更改。

### 关闭自动备份

-> **注意**

+> **Note**

>

-> 关闭自动备份也会默认关闭时间点恢复。

+> 关闭自动备份会默认关闭 point-in-time restore。

-要关闭 TiDB Cloud Dedicated 集群的自动备份,请执行以下步骤:

+要关闭 TiDB Cloud 专属集群的自动备份,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。

+2. 点击 **Backup Setting**。

-3. 将**自动备份**开关切换为**关闭**。

+3. 将 **Auto Backup** 开关切换为 **Off**。

-4. 点击**保存**以保存更改。

+4. 点击 **Save** 保存更改。

### 关闭双区域备份

-> **提示**

+> **Tip**

>

-> 禁用双区域备份不会立即删除次要区域中的备份。这些备份将根据备份保留计划稍后清理。要立即删除它们,你可以手动[删除备份](#删除备份)。

+> 禁用双区域备份不会立即删除次级区域的备份。这些备份会根据备份保留计划稍后清理。如需立即移除,可以手动[删除备份](#delete-backups)。

-要关闭 TiDB Cloud Dedicated 集群的双区域备份,请执行以下步骤:

+要关闭 TiDB Cloud 专属集群的双区域备份,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**备份设置**。

+2. 点击 **Backup Setting**。

-3. 将**双区域备份**开关切换为**关闭**。

+3. 将 **Dual Region Backup** 开关切换为 **Off**。

-4. 点击**保存**以保存更改。

+4. 点击 **Save** 保存更改。

### 执行手动备份

-手动备份是用户发起的备份,使你能够根据需要将数据备份到已知状态,然后随时恢复到该状态。

+手动备份是由用户发起的备份,允许你根据需要将数据备份到已知状态,并可随时恢复到该状态。

-> **注意**

+> **Note**

>

-> - 手动备份将无限期保留,直到你选择手动删除它们或你的账户关闭。

-> - TiDB Cloud Dedicated 集群删除后,其现有的手动备份将移至回收站,并保留在那里直到手动删除或你的账户关闭。

+> - 手动备份会被无限期保留,直到你手动删除或账户关闭。

+> - 删除 TiDB Cloud 专属集群后,现有的手动备份会被移入回收站,直至你手动删除或账户关闭。

-要对 TiDB Cloud Dedicated 集群应用手动备份,请执行以下步骤:

+要为你的 TiDB Cloud 专属集群执行手动备份,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 在右上角,点击 **...** > **手动备份**。

+2. 在右上角点击 **...** > **Manual Backup**。

-3. 在显示的对话框中,输入**名称**。

+3. 在弹出的对话框中输入 **Name**。

-4. 点击**确认**。然后你的集群数据将被备份。

+4. 点击 **Confirm**,集群数据即被备份。

### 删除备份

#### 删除备份文件

-要删除 TiDB Cloud Dedicated 集群的现有备份文件,请执行以下步骤:

+要删除 TiDB Cloud 专属集群的现有备份文件,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 找到要删除的相应备份文件,在**操作**列中点击 **...** > **删除**。

+2. 找到你要删除的备份文件,在 **Action** 列点击 **...** > **Delete**。

-#### 删除正在运行的备份作业

+#### 删除正在运行的备份任务

-要删除 TiDB Cloud Dedicated 集群的正在运行的备份作业,请按照与[**删除备份文件**](#删除备份文件)类似的过程操作。

+要删除 TiDB Cloud 专属集群正在运行的备份任务,操作方式与 [**删除备份文件**](#delete-backup-files) 类似。

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 找到处于**等待中**或**运行中**状态的正在运行的备份作业,在**操作**列中点击 **...** > **删除**。

+2. 找到处于 **Pending** 或 **Running** 状态的备份任务,在 **Action** 列点击 **...** > **Delete**。

## 恢复

-### 将数据恢复到新集群

+### 恢复数据到新集群

-> **注意**

+> **Note**

>

-> 从备份恢复 TiDB 集群时,恢复过程会保留原始时区设置而不覆盖它。

+> 当你从备份恢复 TiDB 集群时,恢复过程会保留原有的时区设置,不会覆盖。

-要从备份将 TiDB Cloud Dedicated 集群数据恢复到新集群,请执行以下步骤:

+要将 TiDB Cloud 专属集群的数据从备份恢复到新集群,请执行以下步骤:

-1. 导航到集群的[**备份**](#查看备份页面)页面。

+1. 进入集群的 [**Backup**](#view-the-backup-page) 页面。

-2. 点击**恢复**。设置窗口显示。

+2. 点击 **Restore**,弹出设置窗口。

-3. 在**恢复模式**中,选择**从区域恢复**,表示备份存储的区域。

+3. 在 **Restore Mode** 中,选择 **Restore From Region**,即备份存储的区域。

- > **注意**

+ > **Note**

>

- > - **从区域恢复**的默认值与备份集群相同。

+ > - **Restore From Region** 的默认值与备份集群相同。

-4. 在**恢复模式**中,选择将任意时间点的数据或选定的备份恢复到新集群。

+4. 在 **Restore Mode** 中,选择将任意时间点的数据或选定备份恢复到新集群。

+

- 要将备份保留期内任意时间点的数据恢复到新集群,请确保**备份设置**中的**时间点恢复**已开启,然后执行以下步骤:

+ 若要将备份保留期内任意时间点的数据恢复到新集群,请确保 **Backup Setting** 中已开启 **Point-in-time Restore**,然后执行以下步骤:

- - 点击**选择时间点**。

- - 选择要恢复到的**日期**和**时间**。

+ - 点击 **Select Time Point**。

+ - 选择你要恢复的 **Date** 和 **Time**。

-

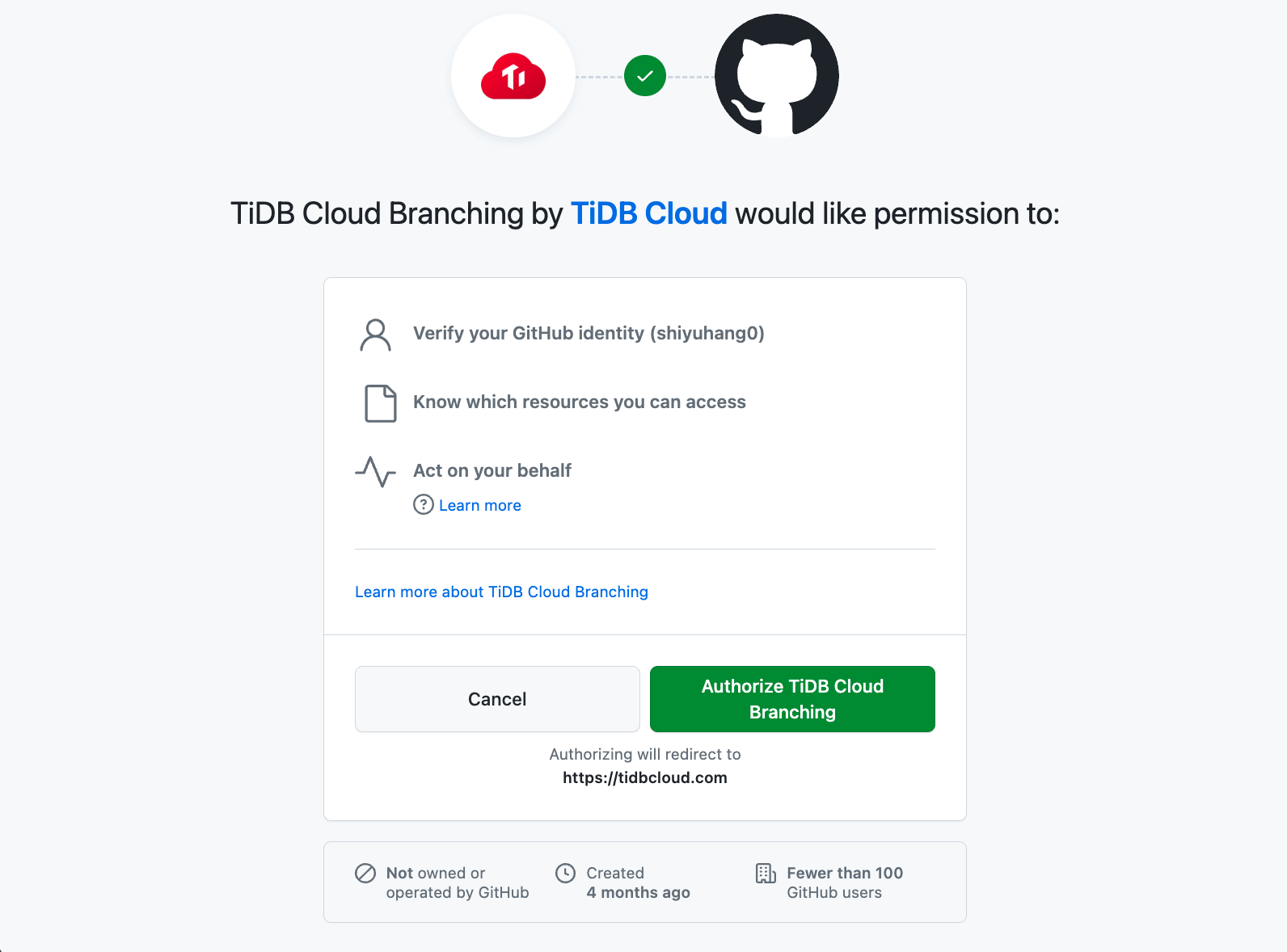

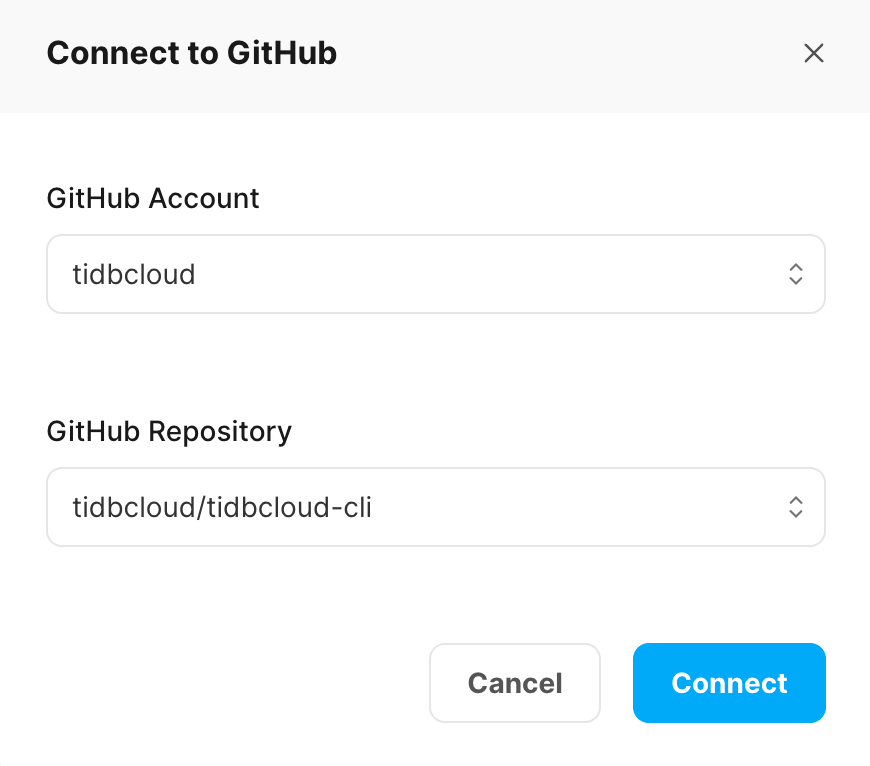

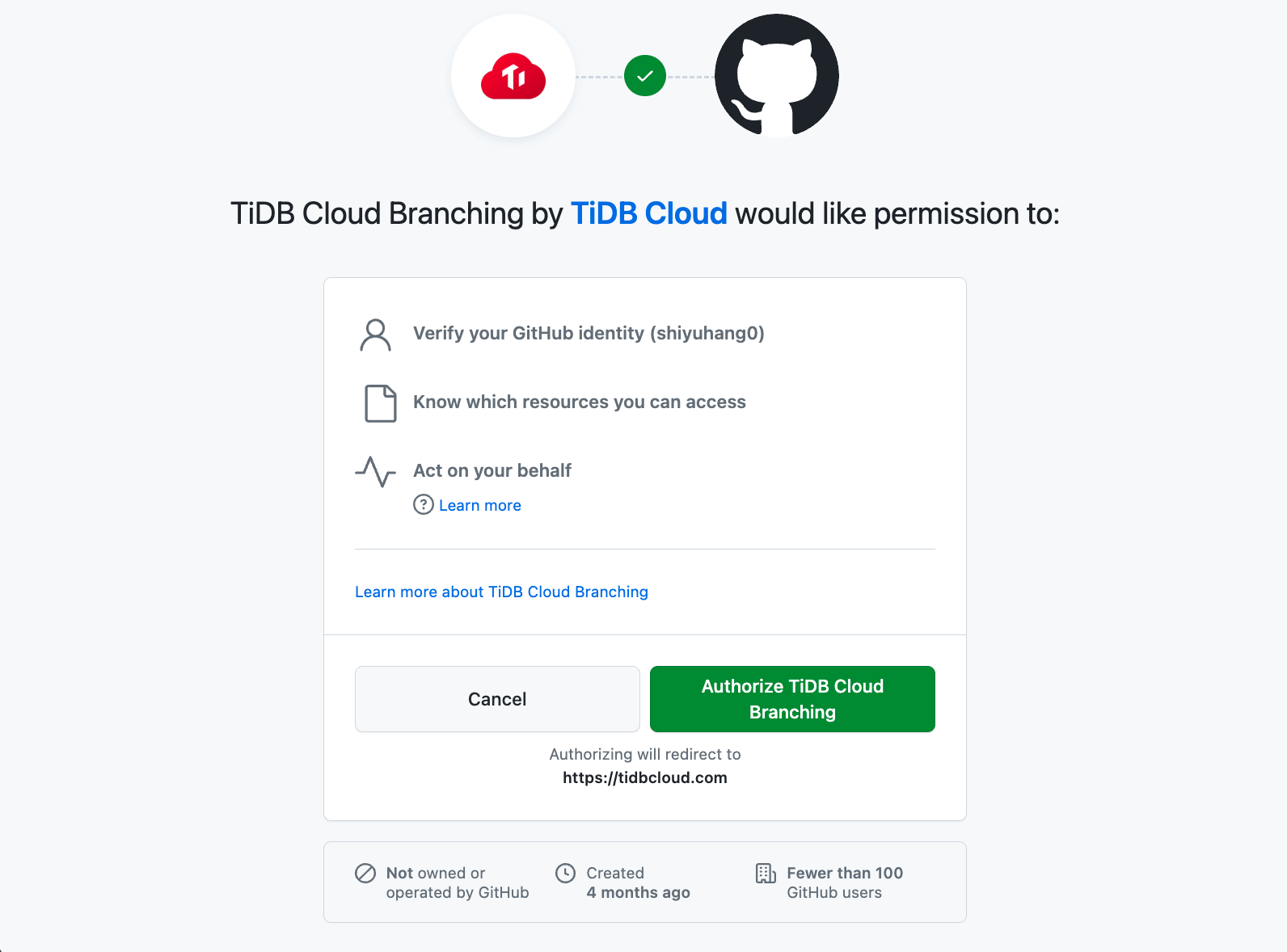

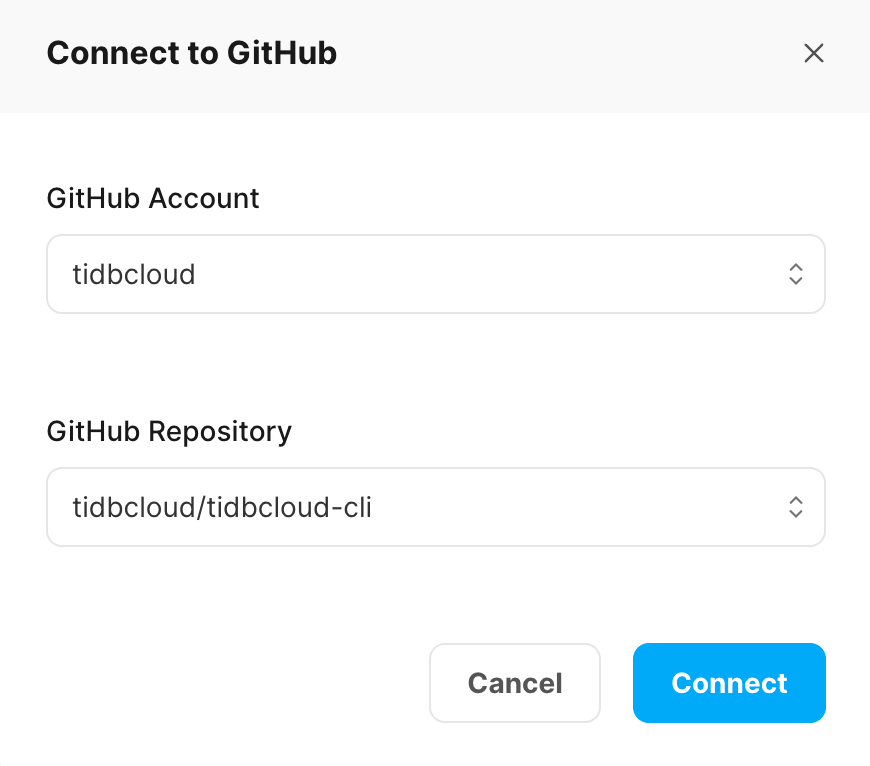

+  -4. 在**连接到 GitHub**对话框中,从**GitHub 账号**下拉列表中选择一个 GitHub 账号。

+4. 在 **Connect to GitHub** 对话框中,在 **GitHub Account** 下拉列表中选择一个 GitHub 账号。

- 如果列表中没有你的账号,请点击**安装其他账号**,然后按照屏幕上的说明安装账号。

+ 如果你的账号不在列表中,点击 **Install Other Account**,然后按照屏幕提示安装该账号。

-5. 从**GitHub 仓库**下拉列表中选择你的目标仓库。如果列表较长,你可以通过输入名称来搜索仓库。

+5. 在 **GitHub Repository** 下拉列表中选择你的目标仓库。如果列表较长,可以通过输入名称进行搜索。

-6. 点击**连接**以建立 TiDB Cloud Serverless 集群与 GitHub 仓库之间的连接。

+6. 点击 **Connect**,将你的 TiDB Cloud Serverless 集群与 GitHub 仓库连接起来。

-4. 在**连接到 GitHub**对话框中,从**GitHub 账号**下拉列表中选择一个 GitHub 账号。

+4. 在 **Connect to GitHub** 对话框中,在 **GitHub Account** 下拉列表中选择一个 GitHub 账号。

- 如果列表中没有你的账号,请点击**安装其他账号**,然后按照屏幕上的说明安装账号。

+ 如果你的账号不在列表中,点击 **Install Other Account**,然后按照屏幕提示安装该账号。

-5. 从**GitHub 仓库**下拉列表中选择你的目标仓库。如果列表较长,你可以通过输入名称来搜索仓库。

+5. 在 **GitHub Repository** 下拉列表中选择你的目标仓库。如果列表较长,可以通过输入名称进行搜索。

-6. 点击**连接**以建立 TiDB Cloud Serverless 集群与 GitHub 仓库之间的连接。

+6. 点击 **Connect**,将你的 TiDB Cloud Serverless 集群与 GitHub 仓库连接起来。

-## TiDB Cloud Branching 应用程序行为

+## TiDB Cloud Branching 应用行为

-将 TiDB Cloud Serverless 集群连接到 GitHub 仓库后,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) GitHub 应用程序可以自动管理该仓库中每个拉取请求对应的 TiDB Cloud Serverless 分支。以下列出了拉取请求变更的默认行为:

+当你将 TiDB Cloud Serverless 集群与 GitHub 仓库连接后,对于该仓库中的每个拉取请求,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) GitHub 应用都可以自动管理其对应的 TiDB Cloud Serverless 分支。以下是针对拉取请求变更的默认行为列表:

-| 拉取请求变更 | TiDB Cloud Branching 应用程序行为 |

-|------------------------------------|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

-| 创建拉取请求 | 当你在仓库中创建拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会为你的 TiDB Cloud Serverless 集群创建一个分支。当 `branch.mode` 设置为 `reset` 时,分支名称遵循 `${github_branch_name}_${pr_id}` 格式。当 `branch.mode` 设置为 `reserve` 时,分支名称遵循 `${github_branch_name}_${pr_id}_${commit_sha}` 格式。请注意,分支数量有[限制](/tidb-cloud/branch-overview.md#limitations-and-quotas)。 |

-| 向拉取请求推送新提交 | 当 `branch.mode` 设置为 `reset` 时,每次你向仓库的拉取请求推送新提交时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序都会重置 TiDB Cloud Serverless 分支。当 `branch.mode` 设置为 `reserve` 时,应用程序会为最新提交创建一个新分支。 |

-| 关闭或合并拉取请求 | 当你关闭或合并拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会删除该拉取请求的分支。 |

-| 重新打开拉取请求 | 当你重新打开拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会为该拉取请求的最新提交创建一个分支。 |

+| 拉取请求变更 | TiDB Cloud Branching 应用行为 |

+|------------------------------------|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

+| 创建拉取请求 | 当你在仓库中创建拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会为你的 TiDB Cloud Serverless 集群创建一个分支。当 `branch.mode` 设置为 `reset` 时,分支名称为 `${github_branch_name}_${pr_id}` 格式。当 `branch.mode` 设置为 `reserve` 时,分支名称为 `${github_branch_name}_${pr_id}_${commit_sha}` 格式。请注意,分支数量有 [限制](/tidb-cloud/branch-overview.md#limitations-and-quotas)。 |

+| 向拉取请求推送新提交 | 当 `branch.mode` 设置为 `reset` 时,每次你向仓库中的拉取请求推送新提交,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会重置 TiDB Cloud Serverless 分支。当 `branch.mode` 设置为 `reserve` 时,应用会为最新提交创建一个新分支。 |

+| 关闭或合并拉取请求 | 当你关闭或合并拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会删除该拉取请求对应的分支。 |

+| 重新打开拉取请求 | 当你重新打开拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会为该拉取请求的最新提交创建一个分支。 |

-## 配置 TiDB Cloud Branching 应用程序

+## 配置 TiDB Cloud Branching 应用

-要配置 [TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序的行为,你可以在仓库的根目录中添加一个 `tidbcloud.yml` 文件,然后根据以下说明将所需的配置添加到该文件中。

+要配置 [TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用的行为,你可以在仓库根目录下添加一个 `tidbcloud.yml` 文件,并根据以下说明将所需配置添加到该文件中。

### branch.blockList

-**类型:** 字符串数组。**默认值:** `[]`。

+**Type:** string 数组。**Default:** `[]`。

-指定禁止 TiDB Cloud Branching 应用程序使用的 GitHub 分支,即使它们在 `allowList` 中。

+指定禁止 TiDB Cloud Branching 应用的 GitHub 分支,即使它们在 `allowList` 中。

```yaml

github:

@@ -83,9 +83,9 @@ github:

### branch.allowList

-**类型:** 字符串数组。**默认值:** `[.*]`。

+**type:** string 数组。**Default:** `[.*]`。

-指定允许 TiDB Cloud Branching 应用程序使用的 GitHub 分支。

+指定允许 TiDB Cloud Branching 应用的 GitHub 分支。

```yaml

github:

@@ -96,12 +96,12 @@ github:

### branch.mode

-**类型:** 字符串。**默认值:** `reset`。

+**Type:** string。**Default:** `reset`。

-指定 TiDB Cloud Branching 应用程序如何处理分支更新:

+指定 TiDB Cloud Branching 应用如何处理分支更新:

-- 如果设置为 `reset`,TiDB Cloud Branching 应用程序将使用最新数据更新现有分支。

-- 如果设置为 `reserve`,TiDB Cloud Branching 应用程序将为你的最新提交创建一个新分支。

+- 如果设置为 `reset`,TiDB Cloud Branching 应用会用最新数据更新已有分支。

+- 如果设置为 `reserve`,TiDB Cloud Branching 应用会为你的最新提交创建一个新分支。

```yaml

github:

@@ -111,9 +111,9 @@ github:

### branch.autoDestroy

-**类型:** 布尔值。**默认值:** `true`。

+**Type:** boolean。**Default:** `true`。

-如果设置为 `false`,当拉取请求被关闭或合并时,TiDB Cloud Branching 应用程序将不会删除 TiDB Cloud Serverless 分支。

+如果设置为 `false`,当拉取请求关闭或合并时,TiDB Cloud Branching 应用不会删除 TiDB Cloud Serverless 分支。

```yaml

github:

@@ -121,17 +121,17 @@ github:

autoDestroy: true

```

-## 创建分支 CI 工作流

+## 创建基于分支的 CI 工作流

-使用分支的最佳实践之一是创建分支 CI 工作流。通过该工作流,你可以在合并拉取请求之前使用 TiDB Cloud Serverless 分支而不是生产集群来测试你的代码。你可以在[这里](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)找到一个实际示例。

+使用分支的最佳实践之一是创建基于分支的 CI 工作流。通过该工作流,你可以在合并拉取请求之前,使用 TiDB Cloud Serverless 分支而不是生产集群来测试你的代码。你可以在 [这里](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example) 查看在线演示。

-以下是创建工作流的主要步骤:

+创建该工作流的主要步骤如下:

-1. [将 TiDB Cloud Serverless 分支功能与你的 GitHub 仓库集成](#将-tidb-cloud-serverless-分支功能与-github-仓库集成)。

+1. [将 TiDB Cloud Serverless 分支与 GitHub 仓库集成](#integrate-branching-with-your-github-repository)。

2. 获取分支连接信息。

- 你可以使用 [wait-for-tidbcloud-branch](https://github.com/tidbcloud/wait-for-tidbcloud-branch) action 来等待 TiDB Cloud Serverless 分支就绪并获取分支的连接信息。

+ 你可以使用 [wait-for-tidbcloud-branch](https://github.com/tidbcloud/wait-for-tidbcloud-branch) action 等待 TiDB Cloud Serverless 分支就绪,并获取分支的连接信息。

示例用法:

@@ -151,20 +151,20 @@ github:

echo "The user is ${{ steps.wait-for-branch.outputs.user }}"

echo "The password is ${{ steps.wait-for-branch.outputs.password }}"

```

-

+

- `token`:GitHub 会自动创建一个 [GITHUB_TOKEN](https://docs.github.com/en/actions/security-guides/automatic-token-authentication) 密钥。你可以直接使用它。

- `public-key` 和 `private-key`:TiDB Cloud [API 密钥](https://docs.pingcap.com/tidbcloud/api/v1beta#section/Authentication/API-Key-Management)。

3. 修改你的测试代码。

- 修改你的测试代码以接受来自 GitHub Actions 的连接信息。例如,你可以通过环境变量接受连接信息,如[实际示例](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)所示。

+ 修改你的测试代码,使其能够从 GitHub Actions 接收连接信息。例如,你可以通过环境变量接收连接信息,具体可参考 [在线演示](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)。

-## 下一步

+## 后续操作

-通过以下示例了解如何使用分支 GitHub 集成:

+你可以通过以下示例,了解如何使用分支 GitHub 集成:

- [branching-gorm-example](https://github.com/tidbcloud/branching-gorm-example)

- [branching-django-example](https://github.com/tidbcloud/branching-django-example)

- [branching-rails-example](https://github.com/tidbcloud/branching-rails-example)

-你也可以在不使用分支 GitHub 集成的情况下构建分支 CI/CD 工作流。例如,你可以使用 [`setup-tidbcloud-cli`](https://github.com/tidbcloud/setup-tidbcloud-cli) 和 GitHub Actions 来自定义你的 CI/CD 工作流。

+你也可以在不使用分支 GitHub 集成的情况下,构建自己的分支 CI/CD 工作流。例如,你可以使用 [`setup-tidbcloud-cli`](https://github.com/tidbcloud/setup-tidbcloud-cli) 和 GitHub Actions 自定义你的 CI/CD 工作流。

\ No newline at end of file

diff --git a/tidb-cloud/branch-manage.md b/tidb-cloud/branch-manage.md

index d75218741b0d3..ef1ea030aa389 100644

--- a/tidb-cloud/branch-manage.md

+++ b/tidb-cloud/branch-manage.md

@@ -5,95 +5,95 @@ summary: 了解如何管理 TiDB Cloud Serverless 分支。

# 管理 TiDB Cloud Serverless 分支

-本文档介绍如何使用 [TiDB Cloud 控制台](https://tidbcloud.com) 管理 TiDB Cloud Serverless 分支。如需使用 TiDB Cloud CLI 进行管理,请参阅 [`ticloud branch`](/tidb-cloud/ticloud-branch-create.md)。

+本文档介绍如何使用 [TiDB Cloud 控制台](https://tidbcloud.com) 管理 TiDB Cloud Serverless 分支。若需使用 TiDB Cloud CLI 进行管理,请参见 [`ticloud branch`](/tidb-cloud/ticloud-branch-create.md)。

## 所需权限

-- 要[创建分支](#创建分支)或[连接到分支](#连接到分支),你必须具有组织的 `Organization Owner` 角色或目标项目的 `Project Owner` 角色。

-- 要[查看项目中集群的分支](#查看分支),你必须属于该项目。

+- 若要[创建分支](#create-a-branch)或[连接到分支](#connect-to-a-branch),你必须是组织的 `Organization Owner` 角色或目标项目的 `Project Owner` 角色。

+- 若要[查看项目中集群的分支](#create-a-branch),你必须属于该项目。

-有关权限的更多信息,请参阅[用户角色](/tidb-cloud/manage-user-access.md#user-roles)。

+关于权限的更多信息,请参见 [用户角色](/tidb-cloud/manage-user-access.md#user-roles)。

## 创建分支

-> **注意:**

+> **Note:**

>

-> 你只能为 2023 年 7 月 5 日之后创建的 TiDB Cloud Serverless 集群创建分支。更多限制请参阅[限制和配额](/tidb-cloud/branch-overview.md#limitations-and-quotas)。

+> 你只能为 2023 年 7 月 5 日之后创建的 TiDB Cloud Serverless 集群创建分支。更多限制请参见 [限制与配额](/tidb-cloud/branch-overview.md#limitations-and-quotas)。

要创建分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在**分支**页面的右上角,点击**创建分支**。此时会显示一个对话框。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在 **Branches** 页面右上角,点击 **Create Branch**。此时会弹出对话框。

- 或者,要从现有父分支创建分支,找到目标父分支所在的行,然后在**操作**列中点击 **...** > **创建分支**。

+ 或者,也可以从已有的父分支创建分支,找到目标父分支所在行,然后在 **Action** 列点击 **...** > **Create Branch**。

-4. 在**创建分支**对话框中,配置以下选项:

+4. 在 **Create Branch** 对话框中,配置以下选项:

- - **名称**:输入分支的名称。

- - **父分支**:选择原始集群或现有分支。`main` 代表当前集群。

- - **包含数据截至**:选择以下其中一项:

- - **当前时间点**:从当前状态创建分支。

- - **指定日期和时间**:从指定时间创建分支。

+ - **Name**:输入分支名称。

+ - **Parent branch**:选择原始集群或已有分支。`main` 代表当前集群。

+ - **Include data up to**:选择以下之一:

+ - **Current point in time**:从当前状态创建分支。

+ - **Specific date and time**:从指定时间点创建分支。

-5. 点击**创建**。

+5. 点击 **Create**。

-根据集群中的数据大小,分支创建将在几分钟内完成。

+根据你集群中的数据量,分支创建将在几分钟内完成。

## 查看分支

要查看集群的分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

- 集群的分支列表将显示在右侧窗格中。

+ 集群的分支列表会显示在右侧面板。

## 连接到分支

要连接到分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要连接的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**连接**。此时会显示连接信息对话框。

-5. 点击**生成密码**或**重置密码**以创建或重置 root 密码。

-6. 使用连接信息连接到分支。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Connect**。此时会弹出连接信息对话框。

+5. 点击 **Generate Password** 或 **Reset Password** 以创建或重置 root 密码。

+6. 使用连接信息连接到该分支。

-或者,你也可以从集群概览页面获取连接字符串:

+另外,你也可以在集群概览页面获取连接字符串:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 点击右上角的**连接**。

-3. 在`分支`下拉列表中选择要连接的分支。

-4. 点击**生成密码**或**重置密码**以创建或重置 root 密码。

-5. 使用连接信息连接到分支。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在右上角点击 **Connect**。

+3. 在 `Branch` 下拉列表中选择你要连接的分支。

+4. 点击 **Generate Password** 或 **Reset Password** 以创建或重置 root 密码。

+5. 使用连接信息连接到该分支。

## 删除分支

要删除分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要删除的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**删除**。

-5. 确认删除。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Delete**。

+5. 确认删除操作。

## 重置分支

重置分支会将其与父分支的最新数据同步。

-> **注意:**

+> **Note:**

>

-> 此操作不可逆。在重置分支之前,请确保已备份任何重要数据。

+> 此操作不可逆。在重置分支前,请确保你已备份所有重要数据。

要重置分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要重置的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**重置**。

-5. 确认重置。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Reset**。

+5. 确认重置操作。

-## 下一步

+## 后续操作

-- [将 TiDB Cloud Serverless 分支集成到 GitHub CI/CD 流程中](/tidb-cloud/branch-github-integration.md)

+- [将 TiDB Cloud Serverless 分支集成到你的 GitHub CI/CD 流水线](/tidb-cloud/branch-github-integration.md)

\ No newline at end of file

diff --git a/tidb-cloud/branch-overview.md b/tidb-cloud/branch-overview.md

index 82e012823b6ef..407f747db3717 100644

--- a/tidb-cloud/branch-overview.md

+++ b/tidb-cloud/branch-overview.md

@@ -1,53 +1,53 @@

---

-title: TiDB Cloud Serverless 分支(Beta)概述

+title: TiDB Cloud Serverless Branching (Beta) Overview

summary: 了解 TiDB Cloud Serverless 分支的概念。

---

# TiDB Cloud Serverless 分支(Beta)概述

-TiDB Cloud 允许你为 TiDB Cloud Serverless 集群创建分支。集群的分支是一个独立的实例,包含从原始集群分叉的数据副本。它提供了一个隔离的环境,让你可以自由实验而不用担心影响原始集群。

+TiDB Cloud 允许你为 TiDB Cloud Serverless 集群创建分支。集群的分支是一个独立的实例,包含从原始集群分叉出来的数据副本。它提供了一个隔离的环境,使你可以自由地进行实验,而无需担心影响原始集群。

-通过 TiDB Cloud Serverless 分支,开发人员可以并行工作,快速迭代新功能,在不影响生产数据库的情况下排查问题,并在需要时轻松回滚更改。此功能简化了开发和部署过程,同时确保生产数据库具有高度的稳定性和可靠性。

+通过 TiDB Cloud Serverless 分支,开发者可以并行工作,快速迭代新功能,排查问题而不影响生产数据库,并且在需要时可以轻松回滚更改。该功能简化了开发和部署流程,同时确保生产数据库的高稳定性和可靠性。

## 实现方式

-创建集群的分支时,分支中的数据会在特定时间点从原始集群或其父分支分叉。这意味着之后在父分支或子分支中所做的更改不会相互同步。

+当为集群创建分支时,分支中的数据会在某一特定时间点与原始集群或其父分支的数据分叉。这意味着之后在父集群或分支中所做的更改将不会相互同步。

-为确保快速且无缝的分支创建,TiDB Cloud Serverless 使用写时复制技术在原始集群及其分支之间共享数据。此过程通常在几分钟内完成,用户无法察觉,确保不会影响原始集群的性能。

+为了确保分支创建的快速与无缝,TiDB Cloud Serverless 采用了写时复制(copy-on-write)技术,在原始集群与其分支之间共享数据。该过程通常在几分钟内完成,对用户来说几乎无感知,并且不会影响原始集群的性能。

## 使用场景

-你可以轻松快速地创建分支以获得隔离的数据环境。在以下场景中,当多个开发人员或团队需要独立工作、测试更改、修复错误、尝试新功能或推出更新而不影响生产数据库时,分支特别有用。

+你可以轻松快速地创建分支,以获得隔离的数据环境。在以下场景中,分支非常有用,适用于多个开发者或团队需要独立工作、测试更改、修复 bug、尝试新功能或发布更新而不影响生产数据库的情况。

-- 功能开发:开发人员可以在隔离环境中开发新功能,而不会影响生产数据库。每个功能都可以有自己的分支,允许快速迭代和实验,而不会影响其他正在进行的工作。

+- 功能开发:开发者可以在隔离环境中开发新功能,而不会影响生产数据库。每个功能都可以有自己的分支,实现快速迭代和实验,而不会影响其他正在进行的工作。

-- 错误修复:开发人员可以创建专门用于修复特定错误的分支,测试修复方案,然后在验证后合并回去,而不会给生产数据库带来新的问题。

+- Bug 修复:开发者可以为修复特定 bug 创建专用分支,测试修复效果,并在验证后合并回去,而不会给生产数据库引入新的问题。

-- 实验:在开发新功能或进行更改时,开发人员可以创建分支来尝试不同的方法或配置。这使他们能够比较各种选项,收集数据,并在更改合并到生产数据库之前做出明智的决定。

+- 实验:在开发新功能或进行更改时,开发者可以创建分支,尝试不同的方法或配置。这样可以对比多种方案,收集数据,并在更改合并到生产数据库前做出明智决策。

-- 性能优化:有时会进行数据库更改以提高性能。通过分支,开发人员可以在隔离环境中实验和微调各种配置、索引或算法,以找到最有效的解决方案。

+- 性能优化:有时会对数据库进行更改以提升性能。通过分支,开发者可以在隔离环境中实验和微调各种配置、索引或算法,从而找到最优方案。

-- 测试和暂存:团队可以创建用于测试和暂存的分支。它为质量保证、用户验收测试或暂存定制提供了一个受控环境,然后再将更改合并到生产数据库中。

+- 测试与预发布:团队可以为测试和预发布目的创建分支。它为质量保证、用户验收测试或上线前的定制化提供了受控环境。

-- 并行开发:不同的团队或开发人员可以同时处理不同的项目。每个项目都可以有自己的分支,实现独立开发和实验,同时仍然能够将更改合并回生产数据库。

+- 并行开发:不同团队或开发者可以同时进行独立项目开发。每个项目都可以有自己的分支,实现独立开发和实验,同时仍可将更改合并回生产数据库。

-## 限制和配额

+## 限制与配额

-目前,TiDB Cloud Serverless 分支处于 beta 阶段,免费使用。

+目前,TiDB Cloud Serverless 分支处于 beta 阶段,免费提供。

-- 对于 TiDB Cloud 中的每个组织,默认情况下你最多可以在所有集群中创建五个 TiDB Cloud Serverless 分支。集群的分支将在与集群相同的区域中创建,你不能为受限集群或大于 100 GiB 的集群创建分支。

+- 对于 TiDB Cloud 中的每个组织,默认情况下你最多可以在所有集群中创建 5 个 TiDB Cloud Serverless 分支。集群的分支会被创建在与集群相同的区域,且无法为受限集群或大于 100 GiB 的集群创建分支。

-- 对于免费集群的每个分支,允许 10 GiB 存储空间。对于可扩展集群的每个分支,允许 100 GiB 存储空间。一旦达到存储限制,此分支上的读写操作将被限制,直到你减少存储空间。

+- 免费集群的每个分支允许使用 10 GiB 存储空间。可扩展集群的每个分支允许使用 100 GiB 存储空间。当存储空间达到上限时,该分支的读写操作将被限制,直到你减少存储空间为止。

-- 如果你的集群有带 TiFlash 副本的表,这些副本在你创建新分支后将暂时不可用,因为 TiFlash 需要重建副本数据。

+- 如果你的集群包含 TiFlash 副本表,在你创建新分支后,这些副本在新分支中会暂时不可用,因为 TiFlash 需要重新构建副本数据。

-- 当从特定时间点[创建分支](/tidb-cloud/branch-manage.md#create-a-branch)时:

+- 当你从某一特定时间点[创建分支](/tidb-cloud/branch-manage.md#create-a-branch)时:

- - 对于免费集群的分支,你可以选择过去 24 小时内的任何时间。

- - 对于可扩展集群的分支,你可以选择过去 14 天内的任何时间。

+ - 免费集群的分支可以选择最近 24 小时内的任意时间点。

+ - 可扩展集群的分支可以选择最近 14 天内的任意时间点。

如果你需要更多配额,请[联系 TiDB Cloud 支持](/tidb-cloud/tidb-cloud-support.md)。

-## 下一步

+## 后续操作

- [了解如何管理分支](/tidb-cloud/branch-manage.md)

diff --git a/tidb-cloud/built-in-monitoring.md b/tidb-cloud/built-in-monitoring.md

index 1cbfacf7cfaef..f47ee0810ade5 100644

--- a/tidb-cloud/built-in-monitoring.md

+++ b/tidb-cloud/built-in-monitoring.md

@@ -1,129 +1,129 @@

---

title: TiDB Cloud 内置指标

-summary: 了解如何查看 TiDB Cloud 内置指标并理解这些指标的含义。

+summary: 了解如何查看 TiDB Cloud 内置指标及这些指标的含义。

---

# TiDB Cloud 内置指标

-TiDB Cloud 在指标页面上收集和显示集群的一整套标准指标。通过查看这些指标,你可以轻松识别性能问题并确定当前的数据库部署是否满足你的需求。

+TiDB Cloud 会在 **Metrics** 页面收集并展示你的集群的全套标准指标。通过查看这些指标,你可以轻松识别性能问题,并判断当前的数据库部署是否满足你的需求。

-## 查看指标页面

+## 查看 Metrics 页面

-要在**指标**页面上查看指标,请执行以下步骤:

+要在 **Metrics** 页面查看指标,请按照以下步骤操作:

-1. 在项目的[**集群**](https://tidbcloud.com/project/clusters)页面上,点击目标集群的名称进入其概览页面。

+1. 在你的项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,点击目标集群的名称,进入其概览页面。

- > **提示:**

+ > **Tip:**

>

- > 你可以使用左上角的组合框在组织、项目和集群之间切换。

+ > 你可以使用左上角的下拉框在组织、项目和集群之间切换。

-2. 在左侧导航栏中,点击**监控** > **指标**。

+2. 在左侧导航栏,点击 **Monitoring** > **Metrics**。

## 指标保留策略

-对于 TiDB Cloud Dedicated 集群和 TiDB Cloud Serverless 集群,指标数据保留 7 天。

+对于 TiDB Cloud Dedicated 集群和 TiDB Cloud Serverless 集群,指标数据会保留 7 天。

## TiDB Cloud Dedicated 集群的指标

-以下部分说明了 TiDB Cloud Dedicated 集群的**指标**页面上的指标。

+以下章节介绍了 TiDB Cloud Dedicated 集群在 **Metrics** 页面上的各项指标。

### 概览

| 指标名称 | 标签 | 描述 |

| :------------| :------| :-------------------------------------------- |

-| Database Time by SQL types | database time, {SQL type} | database time:每秒总数据库时间。

-## TiDB Cloud Branching 应用程序行为

+## TiDB Cloud Branching 应用行为

-将 TiDB Cloud Serverless 集群连接到 GitHub 仓库后,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) GitHub 应用程序可以自动管理该仓库中每个拉取请求对应的 TiDB Cloud Serverless 分支。以下列出了拉取请求变更的默认行为:

+当你将 TiDB Cloud Serverless 集群与 GitHub 仓库连接后,对于该仓库中的每个拉取请求,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) GitHub 应用都可以自动管理其对应的 TiDB Cloud Serverless 分支。以下是针对拉取请求变更的默认行为列表:

-| 拉取请求变更 | TiDB Cloud Branching 应用程序行为 |

-|------------------------------------|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

-| 创建拉取请求 | 当你在仓库中创建拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会为你的 TiDB Cloud Serverless 集群创建一个分支。当 `branch.mode` 设置为 `reset` 时,分支名称遵循 `${github_branch_name}_${pr_id}` 格式。当 `branch.mode` 设置为 `reserve` 时,分支名称遵循 `${github_branch_name}_${pr_id}_${commit_sha}` 格式。请注意,分支数量有[限制](/tidb-cloud/branch-overview.md#limitations-and-quotas)。 |

-| 向拉取请求推送新提交 | 当 `branch.mode` 设置为 `reset` 时,每次你向仓库的拉取请求推送新提交时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序都会重置 TiDB Cloud Serverless 分支。当 `branch.mode` 设置为 `reserve` 时,应用程序会为最新提交创建一个新分支。 |

-| 关闭或合并拉取请求 | 当你关闭或合并拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会删除该拉取请求的分支。 |

-| 重新打开拉取请求 | 当你重新打开拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序会为该拉取请求的最新提交创建一个分支。 |

+| 拉取请求变更 | TiDB Cloud Branching 应用行为 |

+|------------------------------------|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

+| 创建拉取请求 | 当你在仓库中创建拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会为你的 TiDB Cloud Serverless 集群创建一个分支。当 `branch.mode` 设置为 `reset` 时,分支名称为 `${github_branch_name}_${pr_id}` 格式。当 `branch.mode` 设置为 `reserve` 时,分支名称为 `${github_branch_name}_${pr_id}_${commit_sha}` 格式。请注意,分支数量有 [限制](/tidb-cloud/branch-overview.md#limitations-and-quotas)。 |

+| 向拉取请求推送新提交 | 当 `branch.mode` 设置为 `reset` 时,每次你向仓库中的拉取请求推送新提交,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会重置 TiDB Cloud Serverless 分支。当 `branch.mode` 设置为 `reserve` 时,应用会为最新提交创建一个新分支。 |

+| 关闭或合并拉取请求 | 当你关闭或合并拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会删除该拉取请求对应的分支。 |

+| 重新打开拉取请求 | 当你重新打开拉取请求时,[TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用会为该拉取请求的最新提交创建一个分支。 |

-## 配置 TiDB Cloud Branching 应用程序

+## 配置 TiDB Cloud Branching 应用

-要配置 [TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用程序的行为,你可以在仓库的根目录中添加一个 `tidbcloud.yml` 文件,然后根据以下说明将所需的配置添加到该文件中。

+要配置 [TiDB Cloud Branching](https://github.com/apps/tidb-cloud-branching) 应用的行为,你可以在仓库根目录下添加一个 `tidbcloud.yml` 文件,并根据以下说明将所需配置添加到该文件中。

### branch.blockList

-**类型:** 字符串数组。**默认值:** `[]`。

+**Type:** string 数组。**Default:** `[]`。

-指定禁止 TiDB Cloud Branching 应用程序使用的 GitHub 分支,即使它们在 `allowList` 中。

+指定禁止 TiDB Cloud Branching 应用的 GitHub 分支,即使它们在 `allowList` 中。

```yaml

github:

@@ -83,9 +83,9 @@ github:

### branch.allowList

-**类型:** 字符串数组。**默认值:** `[.*]`。

+**type:** string 数组。**Default:** `[.*]`。

-指定允许 TiDB Cloud Branching 应用程序使用的 GitHub 分支。

+指定允许 TiDB Cloud Branching 应用的 GitHub 分支。

```yaml

github:

@@ -96,12 +96,12 @@ github:

### branch.mode

-**类型:** 字符串。**默认值:** `reset`。

+**Type:** string。**Default:** `reset`。

-指定 TiDB Cloud Branching 应用程序如何处理分支更新:

+指定 TiDB Cloud Branching 应用如何处理分支更新:

-- 如果设置为 `reset`,TiDB Cloud Branching 应用程序将使用最新数据更新现有分支。

-- 如果设置为 `reserve`,TiDB Cloud Branching 应用程序将为你的最新提交创建一个新分支。

+- 如果设置为 `reset`,TiDB Cloud Branching 应用会用最新数据更新已有分支。

+- 如果设置为 `reserve`,TiDB Cloud Branching 应用会为你的最新提交创建一个新分支。

```yaml

github:

@@ -111,9 +111,9 @@ github:

### branch.autoDestroy

-**类型:** 布尔值。**默认值:** `true`。

+**Type:** boolean。**Default:** `true`。

-如果设置为 `false`,当拉取请求被关闭或合并时,TiDB Cloud Branching 应用程序将不会删除 TiDB Cloud Serverless 分支。

+如果设置为 `false`,当拉取请求关闭或合并时,TiDB Cloud Branching 应用不会删除 TiDB Cloud Serverless 分支。

```yaml

github:

@@ -121,17 +121,17 @@ github:

autoDestroy: true

```

-## 创建分支 CI 工作流

+## 创建基于分支的 CI 工作流

-使用分支的最佳实践之一是创建分支 CI 工作流。通过该工作流,你可以在合并拉取请求之前使用 TiDB Cloud Serverless 分支而不是生产集群来测试你的代码。你可以在[这里](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)找到一个实际示例。

+使用分支的最佳实践之一是创建基于分支的 CI 工作流。通过该工作流,你可以在合并拉取请求之前,使用 TiDB Cloud Serverless 分支而不是生产集群来测试你的代码。你可以在 [这里](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example) 查看在线演示。

-以下是创建工作流的主要步骤:

+创建该工作流的主要步骤如下:

-1. [将 TiDB Cloud Serverless 分支功能与你的 GitHub 仓库集成](#将-tidb-cloud-serverless-分支功能与-github-仓库集成)。

+1. [将 TiDB Cloud Serverless 分支与 GitHub 仓库集成](#integrate-branching-with-your-github-repository)。

2. 获取分支连接信息。

- 你可以使用 [wait-for-tidbcloud-branch](https://github.com/tidbcloud/wait-for-tidbcloud-branch) action 来等待 TiDB Cloud Serverless 分支就绪并获取分支的连接信息。

+ 你可以使用 [wait-for-tidbcloud-branch](https://github.com/tidbcloud/wait-for-tidbcloud-branch) action 等待 TiDB Cloud Serverless 分支就绪,并获取分支的连接信息。

示例用法:

@@ -151,20 +151,20 @@ github:

echo "The user is ${{ steps.wait-for-branch.outputs.user }}"

echo "The password is ${{ steps.wait-for-branch.outputs.password }}"

```

-

+

- `token`:GitHub 会自动创建一个 [GITHUB_TOKEN](https://docs.github.com/en/actions/security-guides/automatic-token-authentication) 密钥。你可以直接使用它。

- `public-key` 和 `private-key`:TiDB Cloud [API 密钥](https://docs.pingcap.com/tidbcloud/api/v1beta#section/Authentication/API-Key-Management)。

3. 修改你的测试代码。

- 修改你的测试代码以接受来自 GitHub Actions 的连接信息。例如,你可以通过环境变量接受连接信息,如[实际示例](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)所示。

+ 修改你的测试代码,使其能够从 GitHub Actions 接收连接信息。例如,你可以通过环境变量接收连接信息,具体可参考 [在线演示](https://github.com/shiyuhang0/tidbcloud-branch-gorm-example)。

-## 下一步

+## 后续操作

-通过以下示例了解如何使用分支 GitHub 集成:

+你可以通过以下示例,了解如何使用分支 GitHub 集成:

- [branching-gorm-example](https://github.com/tidbcloud/branching-gorm-example)

- [branching-django-example](https://github.com/tidbcloud/branching-django-example)

- [branching-rails-example](https://github.com/tidbcloud/branching-rails-example)

-你也可以在不使用分支 GitHub 集成的情况下构建分支 CI/CD 工作流。例如,你可以使用 [`setup-tidbcloud-cli`](https://github.com/tidbcloud/setup-tidbcloud-cli) 和 GitHub Actions 来自定义你的 CI/CD 工作流。

+你也可以在不使用分支 GitHub 集成的情况下,构建自己的分支 CI/CD 工作流。例如,你可以使用 [`setup-tidbcloud-cli`](https://github.com/tidbcloud/setup-tidbcloud-cli) 和 GitHub Actions 自定义你的 CI/CD 工作流。

\ No newline at end of file

diff --git a/tidb-cloud/branch-manage.md b/tidb-cloud/branch-manage.md

index d75218741b0d3..ef1ea030aa389 100644

--- a/tidb-cloud/branch-manage.md

+++ b/tidb-cloud/branch-manage.md

@@ -5,95 +5,95 @@ summary: 了解如何管理 TiDB Cloud Serverless 分支。

# 管理 TiDB Cloud Serverless 分支

-本文档介绍如何使用 [TiDB Cloud 控制台](https://tidbcloud.com) 管理 TiDB Cloud Serverless 分支。如需使用 TiDB Cloud CLI 进行管理,请参阅 [`ticloud branch`](/tidb-cloud/ticloud-branch-create.md)。

+本文档介绍如何使用 [TiDB Cloud 控制台](https://tidbcloud.com) 管理 TiDB Cloud Serverless 分支。若需使用 TiDB Cloud CLI 进行管理,请参见 [`ticloud branch`](/tidb-cloud/ticloud-branch-create.md)。

## 所需权限

-- 要[创建分支](#创建分支)或[连接到分支](#连接到分支),你必须具有组织的 `Organization Owner` 角色或目标项目的 `Project Owner` 角色。

-- 要[查看项目中集群的分支](#查看分支),你必须属于该项目。

+- 若要[创建分支](#create-a-branch)或[连接到分支](#connect-to-a-branch),你必须是组织的 `Organization Owner` 角色或目标项目的 `Project Owner` 角色。

+- 若要[查看项目中集群的分支](#create-a-branch),你必须属于该项目。

-有关权限的更多信息,请参阅[用户角色](/tidb-cloud/manage-user-access.md#user-roles)。

+关于权限的更多信息,请参见 [用户角色](/tidb-cloud/manage-user-access.md#user-roles)。

## 创建分支

-> **注意:**

+> **Note:**

>

-> 你只能为 2023 年 7 月 5 日之后创建的 TiDB Cloud Serverless 集群创建分支。更多限制请参阅[限制和配额](/tidb-cloud/branch-overview.md#limitations-and-quotas)。

+> 你只能为 2023 年 7 月 5 日之后创建的 TiDB Cloud Serverless 集群创建分支。更多限制请参见 [限制与配额](/tidb-cloud/branch-overview.md#limitations-and-quotas)。

要创建分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在**分支**页面的右上角,点击**创建分支**。此时会显示一个对话框。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在 **Branches** 页面右上角,点击 **Create Branch**。此时会弹出对话框。

- 或者,要从现有父分支创建分支,找到目标父分支所在的行,然后在**操作**列中点击 **...** > **创建分支**。

+ 或者,也可以从已有的父分支创建分支,找到目标父分支所在行,然后在 **Action** 列点击 **...** > **Create Branch**。

-4. 在**创建分支**对话框中,配置以下选项:

+4. 在 **Create Branch** 对话框中,配置以下选项:

- - **名称**:输入分支的名称。

- - **父分支**:选择原始集群或现有分支。`main` 代表当前集群。

- - **包含数据截至**:选择以下其中一项:

- - **当前时间点**:从当前状态创建分支。

- - **指定日期和时间**:从指定时间创建分支。

+ - **Name**:输入分支名称。

+ - **Parent branch**:选择原始集群或已有分支。`main` 代表当前集群。

+ - **Include data up to**:选择以下之一:

+ - **Current point in time**:从当前状态创建分支。

+ - **Specific date and time**:从指定时间点创建分支。

-5. 点击**创建**。

+5. 点击 **Create**。

-根据集群中的数据大小,分支创建将在几分钟内完成。

+根据你集群中的数据量,分支创建将在几分钟内完成。

## 查看分支

要查看集群的分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

- 集群的分支列表将显示在右侧窗格中。

+ 集群的分支列表会显示在右侧面板。

## 连接到分支

要连接到分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要连接的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**连接**。此时会显示连接信息对话框。

-5. 点击**生成密码**或**重置密码**以创建或重置 root 密码。

-6. 使用连接信息连接到分支。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Connect**。此时会弹出连接信息对话框。

+5. 点击 **Generate Password** 或 **Reset Password** 以创建或重置 root 密码。

+6. 使用连接信息连接到该分支。

-或者,你也可以从集群概览页面获取连接字符串:

+另外,你也可以在集群概览页面获取连接字符串:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 点击右上角的**连接**。

-3. 在`分支`下拉列表中选择要连接的分支。

-4. 点击**生成密码**或**重置密码**以创建或重置 root 密码。

-5. 使用连接信息连接到分支。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在右上角点击 **Connect**。

+3. 在 `Branch` 下拉列表中选择你要连接的分支。

+4. 点击 **Generate Password** 或 **Reset Password** 以创建或重置 root 密码。

+5. 使用连接信息连接到该分支。

## 删除分支

要删除分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要删除的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**删除**。

-5. 确认删除。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Delete**。

+5. 确认删除操作。

## 重置分支

重置分支会将其与父分支的最新数据同步。

-> **注意:**

+> **Note:**

>

-> 此操作不可逆。在重置分支之前,请确保已备份任何重要数据。

+> 此操作不可逆。在重置分支前,请确保你已备份所有重要数据。

要重置分支,请执行以下步骤:

-1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,导航到项目的[**集群**](https://tidbcloud.com/project/clusters)页面,然后点击目标 TiDB Cloud Serverless 集群的名称以进入其概览页面。

-2. 在左侧导航栏中点击**分支**。

-3. 在要重置的目标分支所在行中,点击**操作**列中的 **...**。

-4. 在下拉列表中点击**重置**。

-5. 确认重置。

+1. 在 [TiDB Cloud 控制台](https://tidbcloud.com/)中,进入你项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,然后点击目标 TiDB Cloud Serverless 集群的名称,进入其概览页面。

+2. 在左侧导航栏点击 **Branches**。

+3. 在目标分支所在行的 **Action** 列点击 **...**。

+4. 在下拉列表中点击 **Reset**。

+5. 确认重置操作。

-## 下一步

+## 后续操作

-- [将 TiDB Cloud Serverless 分支集成到 GitHub CI/CD 流程中](/tidb-cloud/branch-github-integration.md)

+- [将 TiDB Cloud Serverless 分支集成到你的 GitHub CI/CD 流水线](/tidb-cloud/branch-github-integration.md)

\ No newline at end of file

diff --git a/tidb-cloud/branch-overview.md b/tidb-cloud/branch-overview.md

index 82e012823b6ef..407f747db3717 100644

--- a/tidb-cloud/branch-overview.md

+++ b/tidb-cloud/branch-overview.md

@@ -1,53 +1,53 @@

---

-title: TiDB Cloud Serverless 分支(Beta)概述

+title: TiDB Cloud Serverless Branching (Beta) Overview

summary: 了解 TiDB Cloud Serverless 分支的概念。

---

# TiDB Cloud Serverless 分支(Beta)概述

-TiDB Cloud 允许你为 TiDB Cloud Serverless 集群创建分支。集群的分支是一个独立的实例,包含从原始集群分叉的数据副本。它提供了一个隔离的环境,让你可以自由实验而不用担心影响原始集群。

+TiDB Cloud 允许你为 TiDB Cloud Serverless 集群创建分支。集群的分支是一个独立的实例,包含从原始集群分叉出来的数据副本。它提供了一个隔离的环境,使你可以自由地进行实验,而无需担心影响原始集群。

-通过 TiDB Cloud Serverless 分支,开发人员可以并行工作,快速迭代新功能,在不影响生产数据库的情况下排查问题,并在需要时轻松回滚更改。此功能简化了开发和部署过程,同时确保生产数据库具有高度的稳定性和可靠性。

+通过 TiDB Cloud Serverless 分支,开发者可以并行工作,快速迭代新功能,排查问题而不影响生产数据库,并且在需要时可以轻松回滚更改。该功能简化了开发和部署流程,同时确保生产数据库的高稳定性和可靠性。

## 实现方式

-创建集群的分支时,分支中的数据会在特定时间点从原始集群或其父分支分叉。这意味着之后在父分支或子分支中所做的更改不会相互同步。

+当为集群创建分支时,分支中的数据会在某一特定时间点与原始集群或其父分支的数据分叉。这意味着之后在父集群或分支中所做的更改将不会相互同步。

-为确保快速且无缝的分支创建,TiDB Cloud Serverless 使用写时复制技术在原始集群及其分支之间共享数据。此过程通常在几分钟内完成,用户无法察觉,确保不会影响原始集群的性能。

+为了确保分支创建的快速与无缝,TiDB Cloud Serverless 采用了写时复制(copy-on-write)技术,在原始集群与其分支之间共享数据。该过程通常在几分钟内完成,对用户来说几乎无感知,并且不会影响原始集群的性能。

## 使用场景

-你可以轻松快速地创建分支以获得隔离的数据环境。在以下场景中,当多个开发人员或团队需要独立工作、测试更改、修复错误、尝试新功能或推出更新而不影响生产数据库时,分支特别有用。

+你可以轻松快速地创建分支,以获得隔离的数据环境。在以下场景中,分支非常有用,适用于多个开发者或团队需要独立工作、测试更改、修复 bug、尝试新功能或发布更新而不影响生产数据库的情况。

-- 功能开发:开发人员可以在隔离环境中开发新功能,而不会影响生产数据库。每个功能都可以有自己的分支,允许快速迭代和实验,而不会影响其他正在进行的工作。

+- 功能开发:开发者可以在隔离环境中开发新功能,而不会影响生产数据库。每个功能都可以有自己的分支,实现快速迭代和实验,而不会影响其他正在进行的工作。

-- 错误修复:开发人员可以创建专门用于修复特定错误的分支,测试修复方案,然后在验证后合并回去,而不会给生产数据库带来新的问题。

+- Bug 修复:开发者可以为修复特定 bug 创建专用分支,测试修复效果,并在验证后合并回去,而不会给生产数据库引入新的问题。

-- 实验:在开发新功能或进行更改时,开发人员可以创建分支来尝试不同的方法或配置。这使他们能够比较各种选项,收集数据,并在更改合并到生产数据库之前做出明智的决定。

+- 实验:在开发新功能或进行更改时,开发者可以创建分支,尝试不同的方法或配置。这样可以对比多种方案,收集数据,并在更改合并到生产数据库前做出明智决策。

-- 性能优化:有时会进行数据库更改以提高性能。通过分支,开发人员可以在隔离环境中实验和微调各种配置、索引或算法,以找到最有效的解决方案。

+- 性能优化:有时会对数据库进行更改以提升性能。通过分支,开发者可以在隔离环境中实验和微调各种配置、索引或算法,从而找到最优方案。

-- 测试和暂存:团队可以创建用于测试和暂存的分支。它为质量保证、用户验收测试或暂存定制提供了一个受控环境,然后再将更改合并到生产数据库中。

+- 测试与预发布:团队可以为测试和预发布目的创建分支。它为质量保证、用户验收测试或上线前的定制化提供了受控环境。

-- 并行开发:不同的团队或开发人员可以同时处理不同的项目。每个项目都可以有自己的分支,实现独立开发和实验,同时仍然能够将更改合并回生产数据库。

+- 并行开发:不同团队或开发者可以同时进行独立项目开发。每个项目都可以有自己的分支,实现独立开发和实验,同时仍可将更改合并回生产数据库。

-## 限制和配额

+## 限制与配额

-目前,TiDB Cloud Serverless 分支处于 beta 阶段,免费使用。

+目前,TiDB Cloud Serverless 分支处于 beta 阶段,免费提供。

-- 对于 TiDB Cloud 中的每个组织,默认情况下你最多可以在所有集群中创建五个 TiDB Cloud Serverless 分支。集群的分支将在与集群相同的区域中创建,你不能为受限集群或大于 100 GiB 的集群创建分支。

+- 对于 TiDB Cloud 中的每个组织,默认情况下你最多可以在所有集群中创建 5 个 TiDB Cloud Serverless 分支。集群的分支会被创建在与集群相同的区域,且无法为受限集群或大于 100 GiB 的集群创建分支。

-- 对于免费集群的每个分支,允许 10 GiB 存储空间。对于可扩展集群的每个分支,允许 100 GiB 存储空间。一旦达到存储限制,此分支上的读写操作将被限制,直到你减少存储空间。

+- 免费集群的每个分支允许使用 10 GiB 存储空间。可扩展集群的每个分支允许使用 100 GiB 存储空间。当存储空间达到上限时,该分支的读写操作将被限制,直到你减少存储空间为止。

-- 如果你的集群有带 TiFlash 副本的表,这些副本在你创建新分支后将暂时不可用,因为 TiFlash 需要重建副本数据。

+- 如果你的集群包含 TiFlash 副本表,在你创建新分支后,这些副本在新分支中会暂时不可用,因为 TiFlash 需要重新构建副本数据。

-- 当从特定时间点[创建分支](/tidb-cloud/branch-manage.md#create-a-branch)时:

+- 当你从某一特定时间点[创建分支](/tidb-cloud/branch-manage.md#create-a-branch)时:

- - 对于免费集群的分支,你可以选择过去 24 小时内的任何时间。

- - 对于可扩展集群的分支,你可以选择过去 14 天内的任何时间。

+ - 免费集群的分支可以选择最近 24 小时内的任意时间点。

+ - 可扩展集群的分支可以选择最近 14 天内的任意时间点。

如果你需要更多配额,请[联系 TiDB Cloud 支持](/tidb-cloud/tidb-cloud-support.md)。

-## 下一步

+## 后续操作

- [了解如何管理分支](/tidb-cloud/branch-manage.md)

diff --git a/tidb-cloud/built-in-monitoring.md b/tidb-cloud/built-in-monitoring.md

index 1cbfacf7cfaef..f47ee0810ade5 100644

--- a/tidb-cloud/built-in-monitoring.md

+++ b/tidb-cloud/built-in-monitoring.md

@@ -1,129 +1,129 @@

---

title: TiDB Cloud 内置指标

-summary: 了解如何查看 TiDB Cloud 内置指标并理解这些指标的含义。

+summary: 了解如何查看 TiDB Cloud 内置指标及这些指标的含义。

---

# TiDB Cloud 内置指标

-TiDB Cloud 在指标页面上收集和显示集群的一整套标准指标。通过查看这些指标,你可以轻松识别性能问题并确定当前的数据库部署是否满足你的需求。

+TiDB Cloud 会在 **Metrics** 页面收集并展示你的集群的全套标准指标。通过查看这些指标,你可以轻松识别性能问题,并判断当前的数据库部署是否满足你的需求。

-## 查看指标页面

+## 查看 Metrics 页面

-要在**指标**页面上查看指标,请执行以下步骤:

+要在 **Metrics** 页面查看指标,请按照以下步骤操作:

-1. 在项目的[**集群**](https://tidbcloud.com/project/clusters)页面上,点击目标集群的名称进入其概览页面。

+1. 在你的项目的 [**Clusters**](https://tidbcloud.com/project/clusters) 页面,点击目标集群的名称,进入其概览页面。

- > **提示:**

+ > **Tip:**

>

- > 你可以使用左上角的组合框在组织、项目和集群之间切换。

+ > 你可以使用左上角的下拉框在组织、项目和集群之间切换。

-2. 在左侧导航栏中,点击**监控** > **指标**。

+2. 在左侧导航栏,点击 **Monitoring** > **Metrics**。

## 指标保留策略

-对于 TiDB Cloud Dedicated 集群和 TiDB Cloud Serverless 集群,指标数据保留 7 天。

+对于 TiDB Cloud Dedicated 集群和 TiDB Cloud Serverless 集群,指标数据会保留 7 天。